本文主要是介绍DLinear:Are Transformers Effective for Time Series Forecasting?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、要解决的问题:

(1)虽然采用位置编码和使用标记在Transformer中嵌入子序列有助于保留一些排序信息,但置换不变自注意机制的性质不可避免地导致时间信息丢失。

+我们不是对时间点感兴趣,而是对时间点之间的变化感兴趣

➡️Transformer对长时间序列预测还有效果吗

(2)iterated multi-step (IMS) forecasting:基于Transformer的长序列预测,因为执行的都是自回归策略(一个点一个点预测),导致会有显著的误差累积效应

二、提出

LTSF-Linear

(1)基于direct multi-step多步预测策略(DMS,一次直接预测多个时间点)

三、模型

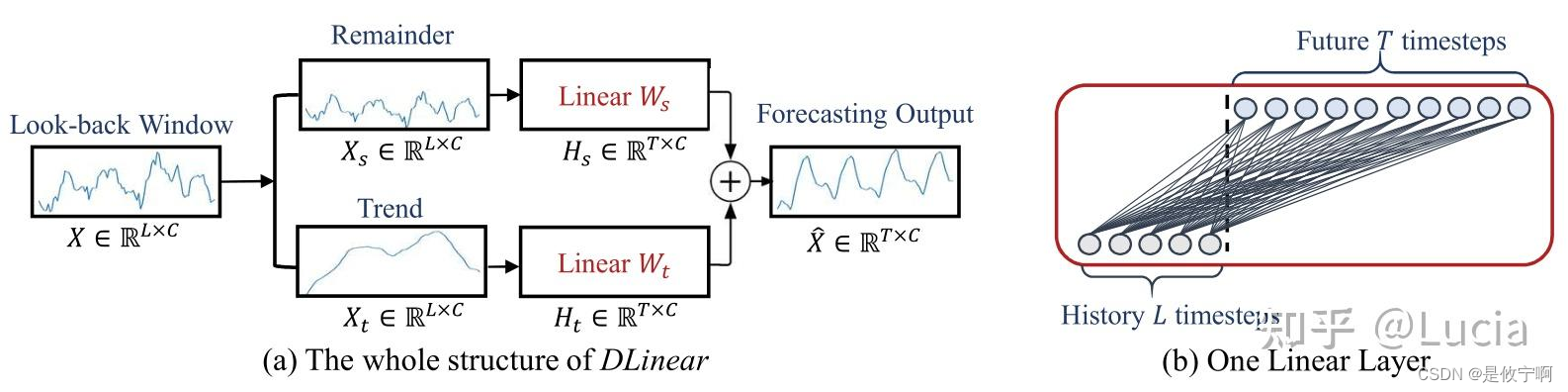

DLlinear是Autoformer和具有线性层的FEDformer中使用的分解方案的组合。它首先通过移动平均核和残差(季节性)分量将原始数据输入分解为趋势分量。然后,将两个一层线性层应用于每个分量,并将这两个特征相加以获得最终预测。通过显式处理趋势,当数据中有明显的趋势时,DLlinear增强了普通线性的性能。

当数据集中存在分布偏移时,为了提高LTSF线性的性能,NLlinear首先用序列的最后一个值减去输入。然后,输入经过线性层,在进行最终预测之前,将减去的部分加回来。NLlinear中的减法和加法是输入序列的简单归一化。

这篇关于DLinear:Are Transformers Effective for Time Series Forecasting?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![[论文笔记]LLM.int8(): 8-bit Matrix Multiplication for Transformers at Scale](https://img-blog.csdnimg.cn/img_convert/172ed0ed26123345e1773ba0e0505cb3.png)