本文主要是介绍智能座舱“试水”多模态交互,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一直以来,在智能汽车的舱内感知交互部分,汽车制造商的目标是打造一个对驾驶员及乘客有深刻理解、能够满足驾驶相关需求和非驾驶相关需求的个人助理。

从早期的语音交互,到驾驶员注意力监控、疲劳预警再到手势交互,这样的多模态交互系统与驾驶员辅助系统一起形成合力,帮助提升行车安全以及舱内的体验。

在高工智能汽车研究院看来,再加上AR HUD、生命体征监测、智能触控面板等其他舱内技术,结合多模态人机交互,意味着智能座舱进入真正的智能2.0时代。

这其中,基于语音、触觉、手势、视线追踪等多模交互技术已经进入新车前装量产的标配序列。同时,过去多家供应商提供离散功能的模式也被彻底打破。

高工智能汽车研究院监测数据显示,2020年国内市场新车7英寸及以上中控多媒体系统搭载率已经突破80%,4G联网搭载率已经接近50%,语音识别搭载率超过60%,1.0时代的数字座舱已经完成阶段性的前装覆盖。

一、

这一次,中国企业没有落后。

6月30日,搭载地平线征程汽车智能芯片及Halo车载智能交互方案的广汽传祺GS4 PLUS正式上市。背后是集成疲劳提醒、语音识别、视线检测、手势交互、表情识别等主动人机交互技术的量产落地。

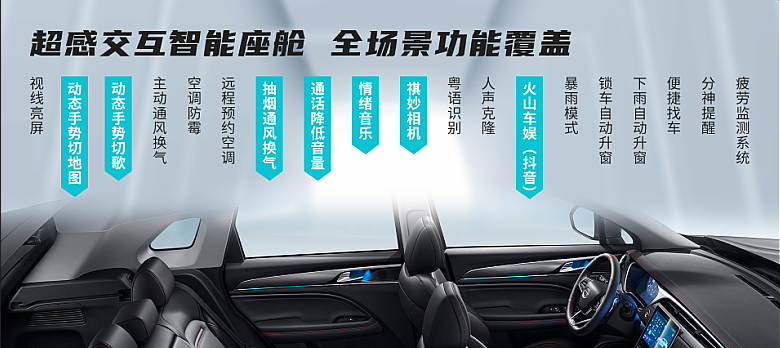

在广汽,上述多模态人机交互技术结合ADiGO 4.0智驾互联生态系统,被命名为“超感交互智能座舱”,背后的合作伙伴包括华为、腾讯、科大讯飞、地平线、苏州智华、商汤、德赛西威以及马瑞利等供应商。

同时,“超感交互智能座舱”基于G-OS操作系统、多屏联动、大屏娱乐系统、HUD抬头显示系统、空调和座椅全域控制等功能模块,实现全场景、全过程的沉浸式智能交互体验。

从目前公开信息来看,这套系统并没有搭载基于时下高端车型采用的座舱域控制器电子架构,但已经基本上构建了未来智能座舱人机交互的下一个阶段的功能部署。

同时,这套系统的供应商组合,也再次验证了在量产系统中,如何实现人机界面组件(尤其是软件部分)模块化、高性价比的另一种实现方式,这降低对仪表、信息娱乐控制等传统硬件的复杂性要求。

在高工智能汽车研究院看来,接下来几年时间,座舱的电子架构部署将呈现多元化的市场格局。其中,整车智能中央域控制器、高度集成化的座舱域控制器架构、传统分布式ECU+智能交互控制器等模式都会并存。

尤其是10万级别车型,未来的智能化竞争日趋激烈。而不断增加的ADAS和智能座舱功能,在车企考虑成本的前提下,技术路线会更加偏向务实的策略。

同时,规模化量产,意味着背后的供应商需要能力更强的成本控制实力。

近日,Stellantis(PSA和FCA合并后)公司宣布与富士康联手成立了一家名为Mobile Drive的合资企业,联手开发智能座舱系统。除了背靠富士康的硬件成本控制能力,还有软件方面的功能交付,涉及语音、导航以及更多的车载应用功能。

“目前公司的汽车业务收入主要来自传统显示屏、机械和塑料部件,但我们将扩展到系统和模块层面。”富士康为此还打造了一个“开放电动汽车联盟”(MIH),目标是制定行业标准,并开发硬件和软件的“套件”,帮助汽车制造商削减新车的开发时间和成本。

而其中的关键部分,则是零部件的模块化,并集成为软硬件子系统。这种模式,意味着未来汽车智能化系统的模块化组装,就像智能手机一样,这可能会让供应商更有能力协同工作。

二、

“汽车驾驶舱正在发生变化。随着更多的显示器、摄像头、传感器和人工智能功能的加入,它变得越来越复杂。此外,车内和车外的界限越来越模糊,无缝的交互体验正在成为趋势,”大陆集团北美人机界面主管Jens Brandt表示。

在这个过程中,智能座舱的交互模式,也开始逐步从过去用户被动接受车机端提供的特定内容服务转向更多主动交互场景的部署。

以长安汽车UNI系列推出的首款车型UNI-T为例,搭载了与地平线(基于征程2芯片)联合开发的智能驾驶舱NPU计算平台,全方位实现车内场景化感知,并基于感知结果为用户提供更精准的智能推荐以及智能车控等服务。

例如,中控屏处于熄屏状态时,驾驶者注视屏幕1秒,屏幕即会自动亮起;乘员接听电话时,系统自动降低多媒体音量,保证通话清晰;识别到副驾乘员抽烟时,根据车速适度打开车窗并开启车内空气净化。

这意味着,座舱芯片的算力需要进行大幅提升。同时,针对座舱人机交互的特定需求,尤其是涉及到眼球跟踪、多模语音交互、多音区检测等视觉、语音和多融合算法的高效处理支持,也在重塑智能座舱异构计算的全新平台架构。

相对而言,类似恩智浦、TI、瑞萨以及高通这样的芯片公司,则更多“负责”多屏交互、底层系统稳定、虚拟化环境安全部署、支持导航、数字多媒体、云端互联等显示、联网类功能的落地。

去年,新的Cerence Drive 2.0发布,彻底改进了语音人工智能平台和Cerence云服务,日本丰田将率先量产搭载这一服务。还有新的Cerence Look,结合了在线数据库和视线跟踪摄像头,将汽车的语音助手变成实时导游。

全新的Cerence Look功能,已经搭载于梅赛德斯-奔驰最新一代MBUX上,驾驶员不需要使用特定的唤醒词,而是使用环境重建和传感器数据来确定车辆的位置,并确定驾驶员提出问题时正在看什么。

这是未来基于人机多模态交互的典型解决方案,涉及自然语言处理、手势识别和眼球追踪功能。此外,还有从现阶段相对成熟的双音区交互技术发展为四音区、六音区交互技术,可以让每个位置的乘客通过语音或其他交互方式控制各自的交互设备。

更进一步,就是基于情感化体验的智能主动式服务,也是语音交互的重要方向。通过多模态感知,基于用户行为、历史使用习惯、用车场景和时间等情况主动推送应用服务。

随着智能驾驶与座舱交互的融合度越来越高,还需要底层硬件能力的加持。比如,地平线已经推出的面向整车智能的征程5中央计算芯片,基于征程5的Halo5.0方案也即将发布,目标是集成自动驾驶和智能交互。

这篇关于智能座舱“试水”多模态交互的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!