本文主要是介绍DL学习笔记【22】增强学习(Reinforcement Learning),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

据说了解增强学习首先要了解马尔可夫性

马尔可夫性

在已知目前状态 (现在)的条件下,它未来的演变(将来)不依赖于它以往的演变 (过去 )

马尔可夫过程按照其状态和时间参数是否连续或者离散分为三种:

- 时间和状态都离散的叫做马尔科夫链

- 时间和状态都是连续的叫做马尔科夫过程

- 时间连续,状态离散的叫做连续时间的马尔科夫链。

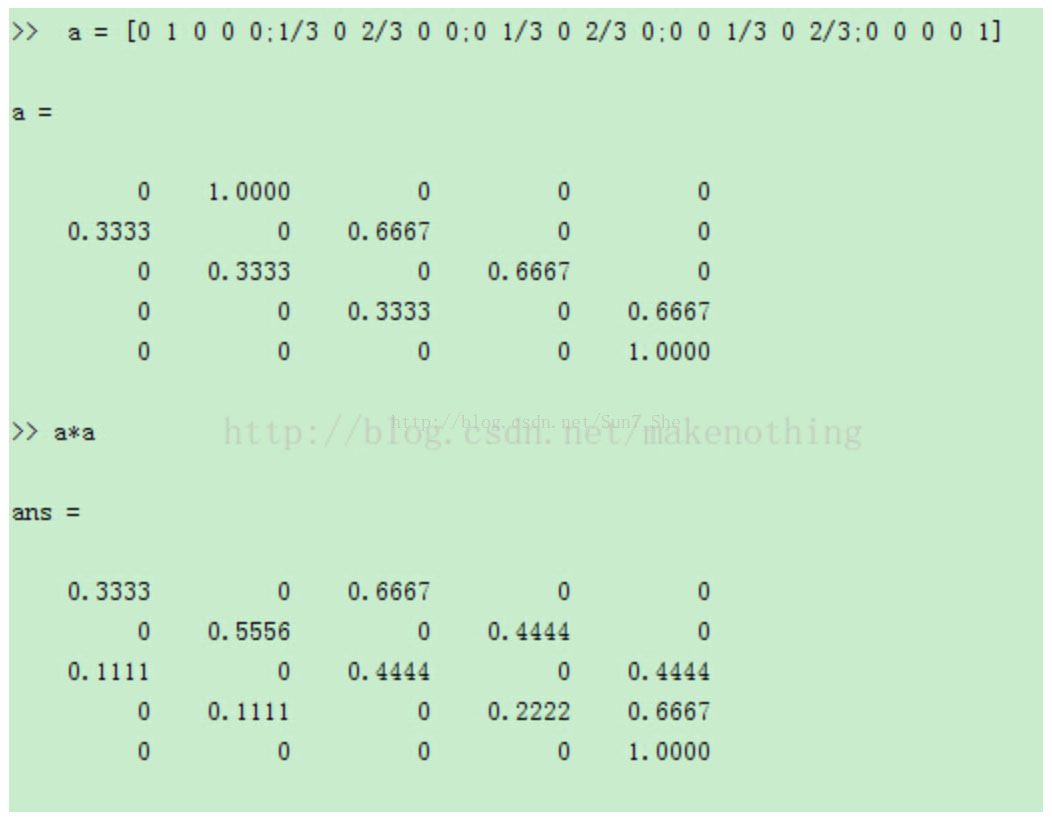

N步转移概率矩阵:

P(n)=P(n-1)P(1)=P(n-2)P(1)P(1)=......=P(1)^n

从一个状态经过n步到达其他状态的概率可以表示为矩阵形式,例如:

隐马尔可夫模型

三个骰子,分别为4面6面8面,根据1~8序列(可见状态),可以推测出使用的骰子序列(隐含序列)。

- 直接相乘 —求产生序列的最大概率

- 破解骰子序列,从第一个开始算,找最大概率的,然后算第二个,依次向后(这是向前算法),根据最后一个状态,依次推出前边的(这是向后算法)—用于计算产生这个序列的所有可能情况的概率和

- 维特比算法 —用于计算产生可见状态的最有可能的隐含状态序列

- Baum-Welch 算法 —太复杂,没看

增强学习

下边两个教程很棒,先记录一下,自己的理解之后会补上。

epsilon greed

http://blog.csdn.net/zjq2008wd/article/details/52860654

Q算法

http://blog.csdn.net/zjq2008wd/article/details/52767692

神经网络和增强学习

http://www.cnblogs.com/Leo_wl/p/5852010.html

这篇关于DL学习笔记【22】增强学习(Reinforcement Learning)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!