本文主要是介绍Nous Hermes 2:超越Mixtral 8x7B的MOE模型新高度,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

引言

随着人工智能技术的迅猛发展,开源大模型在近几年成为了AI领域的热点。最近,Nous Research公司发布了其基于Mixtral 8x7B开发的新型大模型——Nous Hermes 2,这一模型在多项基准测试中超越了Mixtral 8x7B Instruct,标志着MOE(Mixture of Experts,专家混合模型)技术的新突破。

-

Huggingface模型下载:https://huggingface.co/NousResearch

-

AI快站模型免费加速下载:https://aifasthub.com/models/NousResearch

MOE模型的技术优势

MOE模型,即“专家混合模型”,是一种将多个不同的模型组合在一起,使它们在处理特定任务时能够相互补充并提高整体性能的方法。这种方法的优势在于它能有效地整合不同模型的专业知识,从而提高处理复杂任务的能力。Nous Hermes 2正是基于此技术构建,通过融合多个“专家”模型,使得整体性能得到显著提升。

Nous Hermes 2的核心特性

Nous Hermes 2是在Mixtral 8x7B的基础上通过进一步微调而成。这个模型通过SFT(Supervised Fine-Tuning,有监督微调)和DPO(Distributed Pseudo Output,分布式伪输出)两种方法得到优化,分别发布了两个版本:Nous Hermes 2 Mixtral 8x7B SFT和Nous Hermes 2 Mixtral 8x7B DPO。这两个版本都展示了在多个基准测试中的卓越性能。

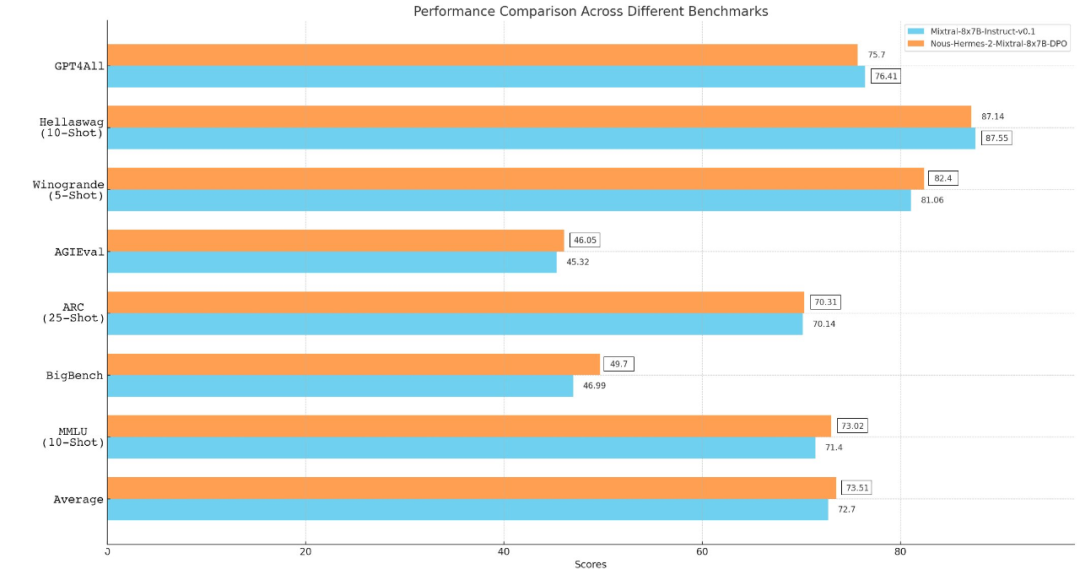

Nous Hermes 2的性能评测

Nous Hermes 2在多个评测标准上均展示出了其卓越的性能。在GPT4All、AGI-Eval以及BigBench推理测试中,Nous Hermes 2均取得了高于Mixtral Instruct的成绩。特别是在GPT4All测试中,Nous Hermes 2的平均成绩达到了75.7%,在AGI-Eval的平均成绩为46.05%,而在BigBench的平均成绩为49.7%。

-

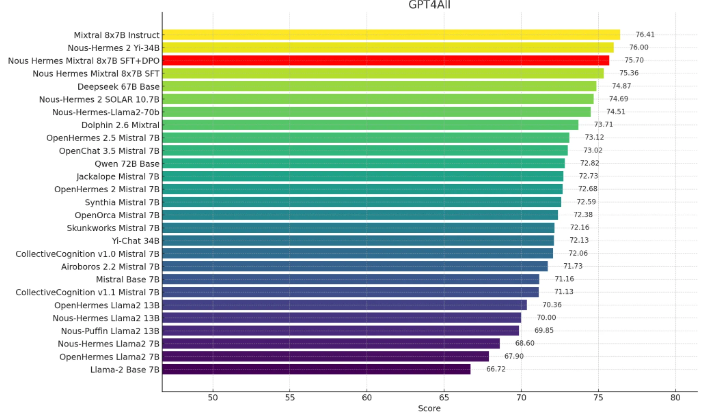

在GPT4All中,Nous-Hermes Mixtral 8x7B(SFT+DPO)拿下了75.7分,位列榜单第三。

-

在AGIEval的排行中,Nous-Hermes Mixtral 8x7B(SFT+DPO)拿下了46.05的成绩。

-

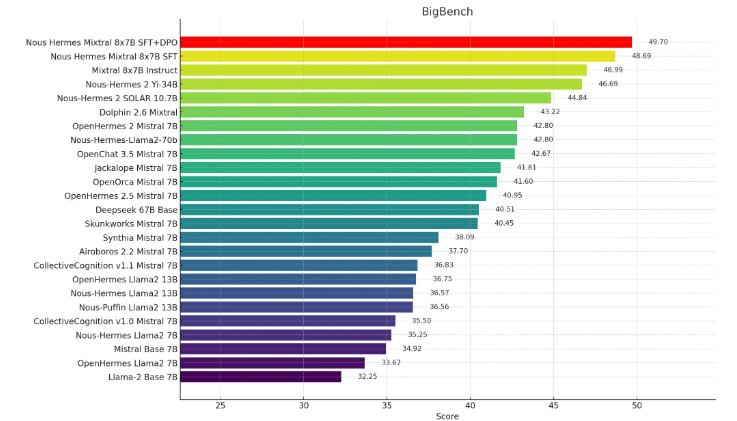

此外,在BigBench Reasoning Test中,Nous-Hermes 2 Mixtral 8x7B(SFT+DPO)霸榜第一。

Nous Hermes 2与其他主流模型的比较

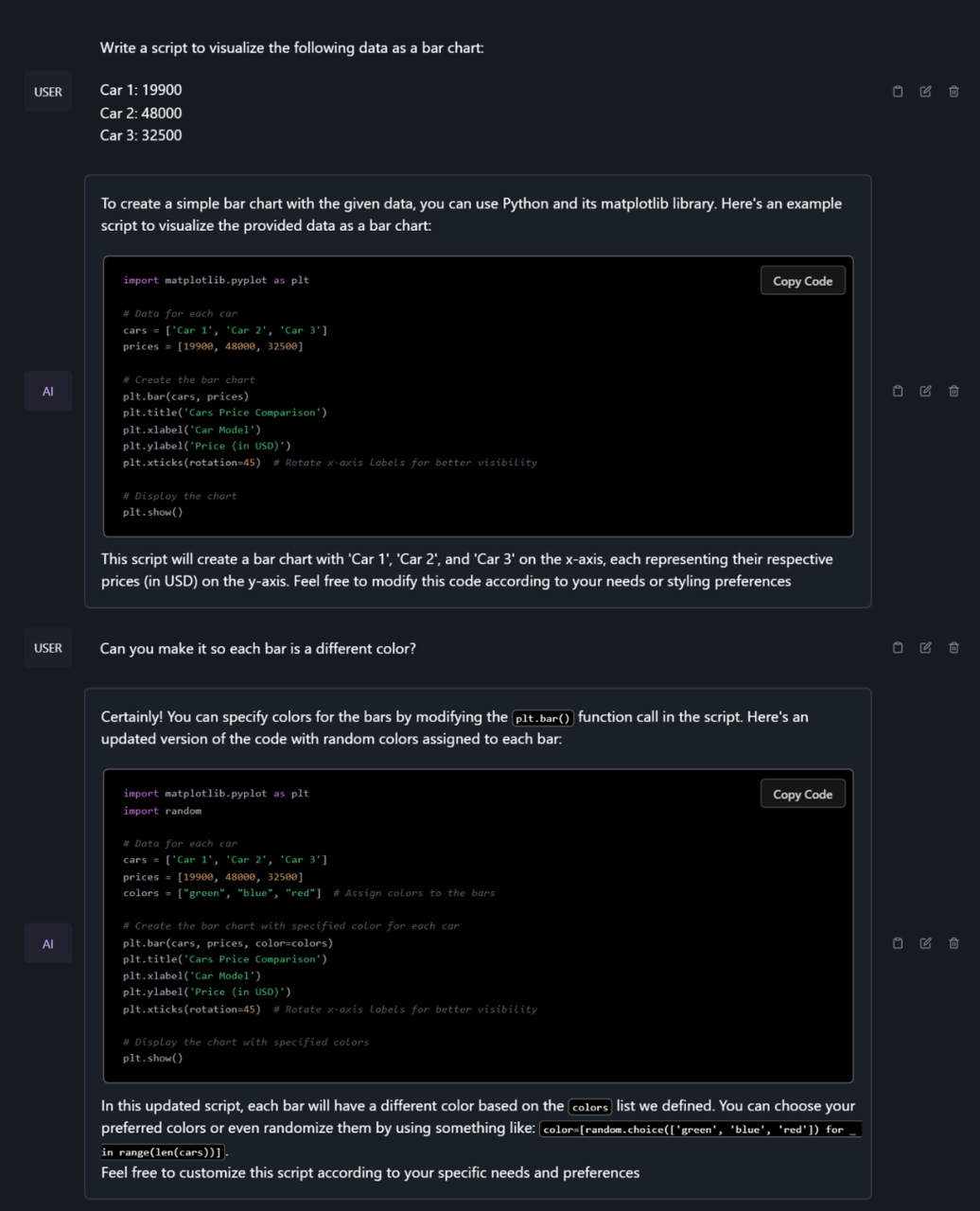

Nous Hermes 2与其他主流的大模型如GPT-3.5 Turbo、Claude-2.1、Gemini Pro等相比,在多个方面展现了更为出色的性能。尤其在处理语言理解、推理以及代码编写等任务时,Nous Hermes 2的性能更是领先。

-

为数据可视化编写代码

-

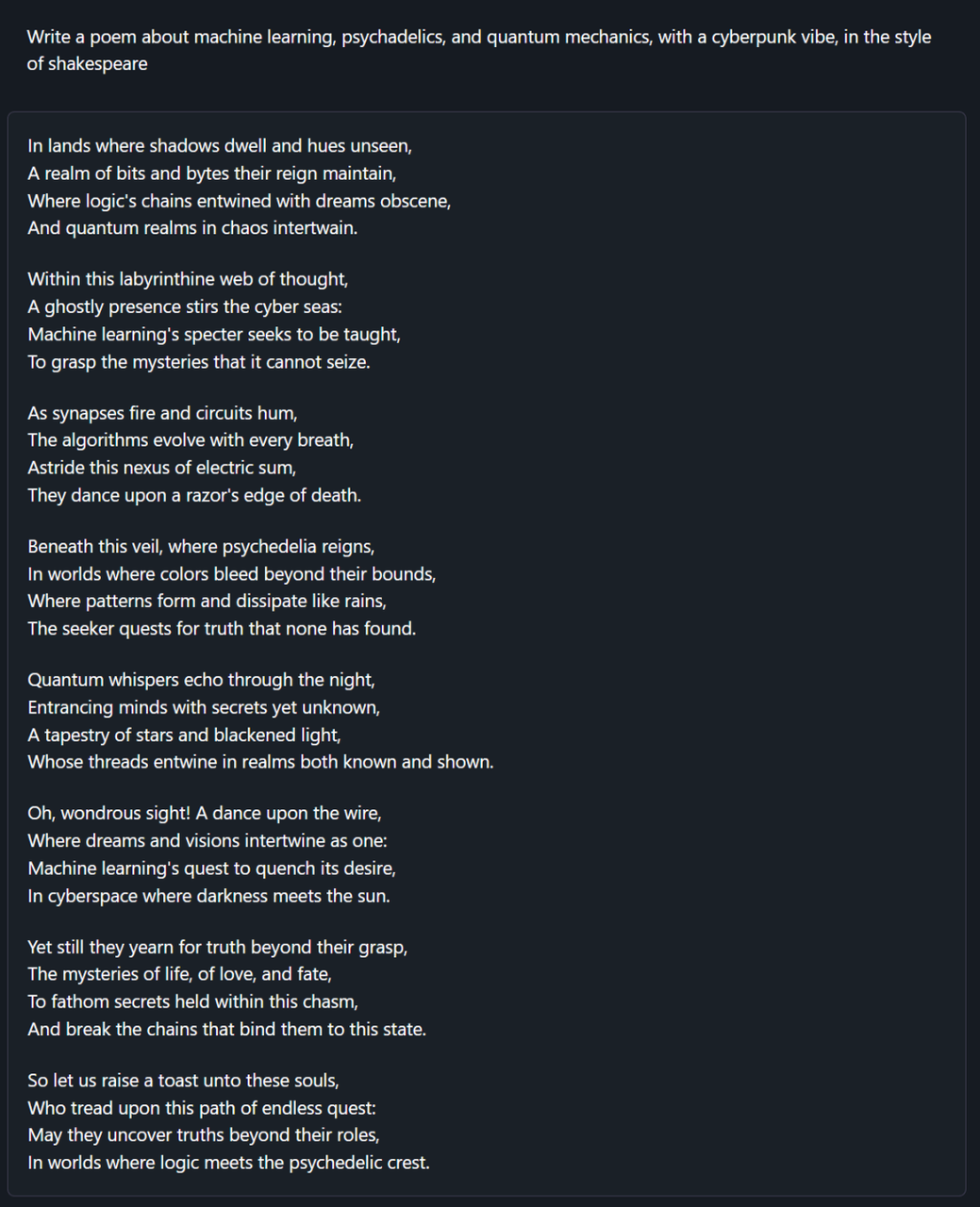

写赛博朋克迷幻诗

-

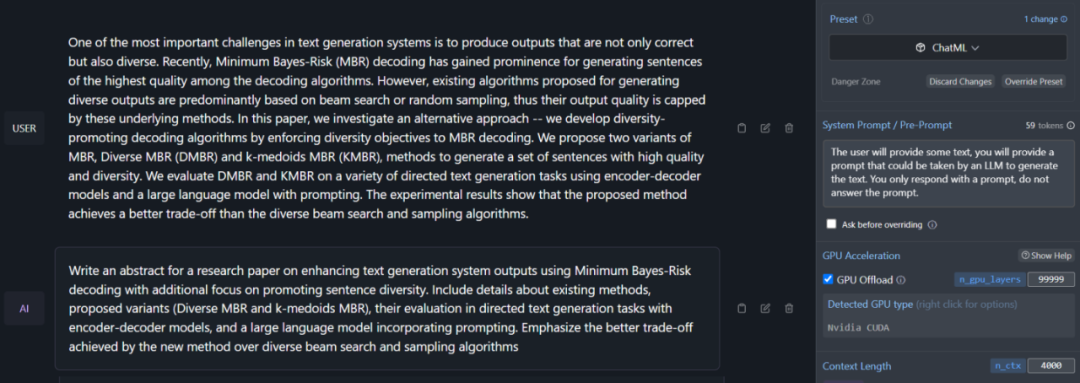

根据输入文本创建提示

结论

Nous Hermes 2的发布,不仅标志着MOE模型技术的一次重大进步,也展现了开源大模型在人工智能领域的潜力。这一成就的取得,为未来AI技术的发展提供了新的方向,并为广大研究者和开发者提供了更多的可能性。

模型下载

Huggingface模型下载

https://huggingface.co/NousResearch

AI快站模型免费加速下载

https://aifasthub.com/models/NousResearch

这篇关于Nous Hermes 2:超越Mixtral 8x7B的MOE模型新高度的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!