本文主要是介绍Maxwell数据同步(增量),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

1. Maxwell简介

1.1 Maxwell概述

Maxwell 是由美国Zendesk公司开源,用Java编写的MySQL变更数据抓取软件。它会实时监控Mysql数据库的数据变更操作(包括insert、update、delete),并将变更数据以 JSON 格式发送给 Kafka、Kinesi等流数据处理平台。官网地址:http://maxwells-daemon.io/

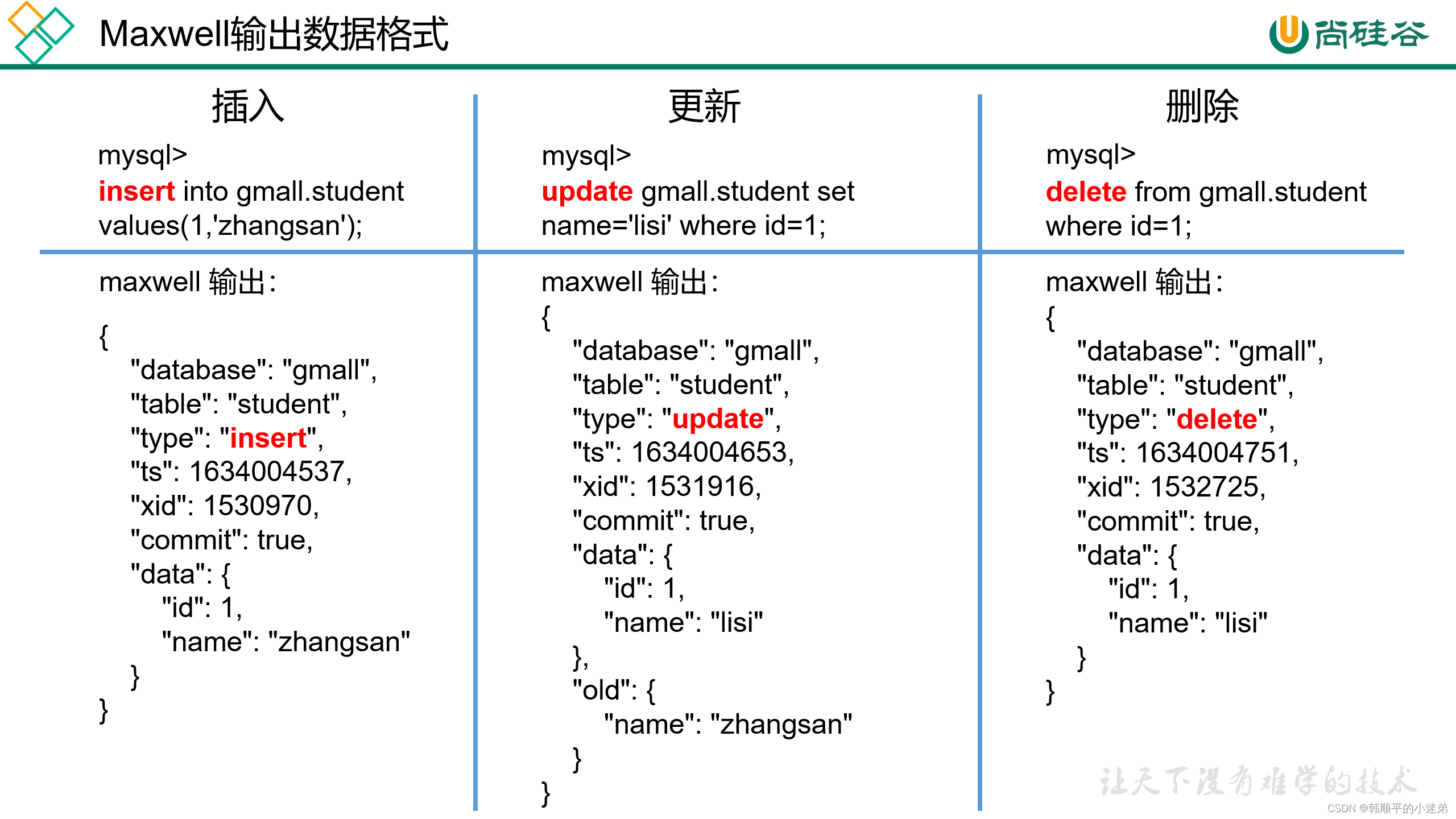

1.2 Maxwell输出数据格式

注:Maxwell输出的json字段说明:

| 字段 | 解释 |

|---|---|

| database | 操作的数据库 |

| table | 操作的数据库表 |

type | 数据变更类型 |

ts | 数据变更的时间 |

| xid | 事务id |

| commit | 事务提交标志 |

data | 对于insert类型,表示插入的数据;对于update类型,标识修改之后的数据;对于delete类型,表示删除的数据 |

old | 对于update类型,表示修改之前的数据,只包含变更字段 |

2. Maxwell原理

Maxwell的工作原理是实时读取Mysql数据库的二进制日志(Binlog),从中获取变更数据,再将变更数据以JSON格式发送至Kafka等流处理平台。

2.1 Mysql 二进制日志

二进制(Binlog)是Mysql服务端非常重要的一种日志,它会保存Mysql数据库的所有数据变更记录。Binlog的主要作用包括主从复制和数据恢复。Maxwell的工作原理和主从复制原理紧密相关。

2.2 Mysql 主从复制

Mysql的主从复制,就是用来建立一个和主数据库完全一样的数据库环境,这个数据库成为从数据库。

1) 主从复制的应用场景如下:

(1)做数据库的热备:主数据库服务器故障后,可切换到从数据库继续工作。

(2)读写分离:主数据库只负责业务数据的写入操作,而多个从数据库只负责业务数据的查询工作,在多读写少场景下,可以提高数据库工作效率。

2) 主从复制的工作原理如下:

(1)Master主库将数据变更记录,写到二进制日志(binary log)中

(2)Slave从库向mysql master发送dump协议,将master主库的binary log events拷贝到它的中继日志(relay log)

(3)Slave从库读取并回放中继日志中的事件,将改变的数据同步到自己的数据库。

2.3 Maxwell原理

Maxwell就是将自己伪装成slave,并遵循Mysql主从复制的协议,从master同步改变的数据并装换为JSON格式发送给 Kafka、Kinesi等流数据处理平台

3. Maxwell部署

3.1 安装Maxwell

1)下载安装包:

(1)地址:https://github.com/zendesk/maxwell/releases/download/v1.29.2/maxwell-1.29.2.tar.gz

注:Maxwell-1.30.0及以上版本不再支持JDK1.8

(2)将安装包上传到hadoop102节点的/opt/software目录

注:此处使用教学版安装包,教学版对原版进行了改造,增加了自定义Maxwell输出数据中ts时间戳的参数,生产环境请使用原版。

2) 将安装包解压至/opt/module

[atguigu@hadoop102 maxwell]$ tar -zxvf maxwell-1.29.2.tar.gz -C /opt/module/

3)修改名称

[atguigu@hadoop102 module]$ mv maxwell-1.29.2/ maxwell

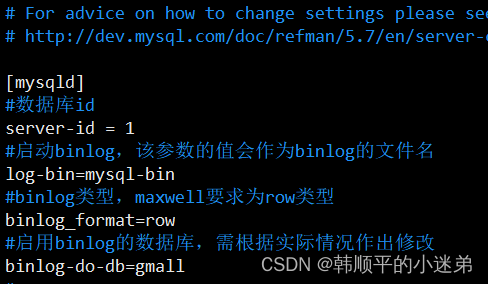

3.2 配置 Mysql(mysql5.7版本)

3.2.1 启用 Mysql Binlog

Mysql服务器的binlog默认是未开启的,如需进行同步,需要先进行开启。

1)修改Mysql配置文件/etc/my.cnf

2)添加以下配置

[mysqld]

#数据库id

server-id = 1

#启动binlog,该参数的值会作为binlog的文件名

log-bin=mysql-bin

#binlog类型,maxwell要求为row类型

binlog_format=row

#启用binlog的数据库,需根据实际情况作出修改

binlog-do-db=gmall

注:MySQL Binlog模式:

Row-based:基于行,Binlog会记录每次写操作后被操作行记录的变化。

优点:保持数据的绝对一致性。 缺点:占用较大空间。

Maxwell要求Binlog采用Row-based模式。

3)重启Mysql服务

[atguigu@hadoop102 ~]$ sudo systemctl restart mysqld

3.2.2 创建Maxwell所需数据库和用户

Maxwell需要在Mysql中存储其运行过程中所需的数据,包括binlog同步的断点位置(Maxwell支持断点续传)等等,故需要在MySQL为Maxwell创建数据库及用户。

1)创建数据库

msyql> CREATE DATABASE maxwell;

2)调整Mysql数据库密码级别

mysql> set global validate_password_policy=0;

mysql> set global validate_password_length=4;

3)创建Maxwell用户并赋予其必要权限

mysql> CREATE USER 'maxwell'@'%' IDENTIFIED BY 'maxwell';

mysql> GRANT ALL ON maxwell.* TO 'maxwell'@'%';

mysql> GRANT SELECT, REPLICATION CLIENT, REPLICATION SLAVE ON *.* TO 'maxwell'@'%';

注:sql代码解释

mysql> CREATE USER 'maxwell'@'%' IDENTIFIED BY 'maxwell';

创建了一个名为 maxwell的用户,并允许该用户从任何主机 连接到MySQL数据库。用户的密码被设置为 maxwell。

mysql> GRANT ALL ON maxwell.* TO 'maxwell'@'%';

授予了用户 maxwell 对名为 maxwell 的数据库的所有权限。这包括了数据库中所有表的查询、插入、更新、删除等操作权限。

mysql> GRANT SELECT, REPLICATION CLIENT, REPLICATION SLAVE ON *.* TO 'maxwell'@'%';

这行代码授予了用户 maxwell 对所有数据库的一些特定权限:

- SELECT: 允许用户执行查询操作。

- REPLICATION CLIENT: 允许用户监视MySQL复制的状态。

- REPLICATION SLAVE: 允许用户作为复制从服务器连接到主服务器。

3.3 配置Maxwell

1)修改Maxwell配置文件名称

[atguigu@hadoop102 maxwell]$ cd /opt/module/maxwell

[atguigu@hadoop102 maxwell]$ cp config.properties.example config.properties2)修改Maxwell配置文件

[atguigu@hadoop102 maxwell]$ vim config.properties

配置文件内容如下:

#Maxwell数据发送目的地,可选配置有stdout|file|kafka|kinesis|pubsub|sqs|rabbitmq|redis

producer=kafka

#目标Kafka集群地址

kafka.bootstrap.servers=hadoop102:9092,hadoop103:9092

#目标Kafka topic,可静态配置,例如:maxwell,也可动态配置,例如:%{database}_%{table}

kafka_topic=topic_db#MySQL相关配置

host=hadoop102

user=maxwell

password=maxwell

jdbc_options=useSSL=false&serverTimezone=Asia/Shanghai4. Maxwell使用

本案例使用maxwell把mysql中gmall数据库的数据同步到kafka集群的topic_db topic。数据库gmall在Mysql配置文件/etc/my.cnf中指定,如下图所示:

4.1 启动kafka集群

Maxwell发送数据的目的地为kafka集群,则需要先确保kafka集群为启动状态,数据将发往kafka集群的topic_db topic

4.2 Maxwell启停脚本mxw.sh

status_maxwell(){result=`ps -ef | grep com.zendesk.maxwell.Maxwell | grep -v grep | wc -l`return $result

}

start_maxwell(){status_maxwellif [[ $? -lt 1 ]]; thenecho "启动Maxwell"$MAXWELL_HOME/bin/maxwell --config $MAXWELL_HOME/config.properties --daemonelseecho "Maxwell正在运行"fi

}

stop_maxwell(){status_maxwellif [[ $? -gt 0 ]]; thenecho "停止Maxwell"ps -ef | grep com.zendesk.maxwell.Maxwell | grep -v grep | awk '{print $2}' | xargs kill -9elseecho "Maxwell未在运行"fi

}

case $1 instart )start_maxwell;;stop )stop_maxwell;;restart )stop_maxwellstart_maxwell;;

esac1)mxw.sh start:启动Maxwell

2)mxw.sh stop:停止Maxwell

3)mxw.sh restart:重启Maxwell

4.3 增量数据同步

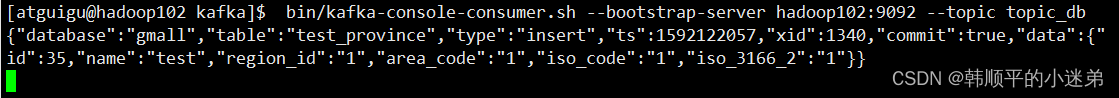

1)启动Kafka消费者

[atguigu@hadoop102 kafka]$ bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic maxwell

- 使用

mxw.sh start启动Maxwell

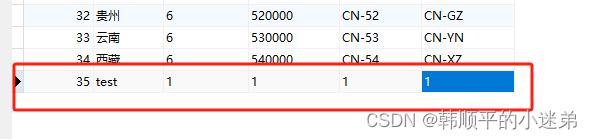

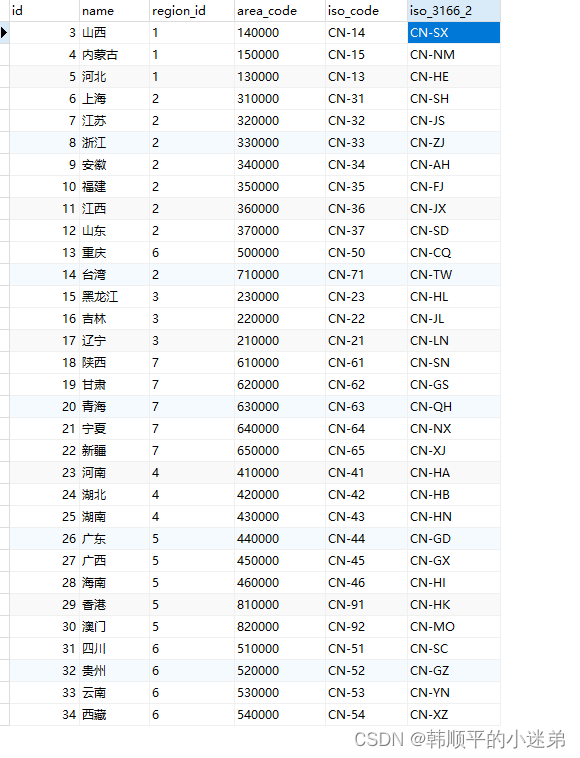

3)手动在gmall数据库的test_province表中添加一条数据,如下图所示:

4)观察Kafka消费者

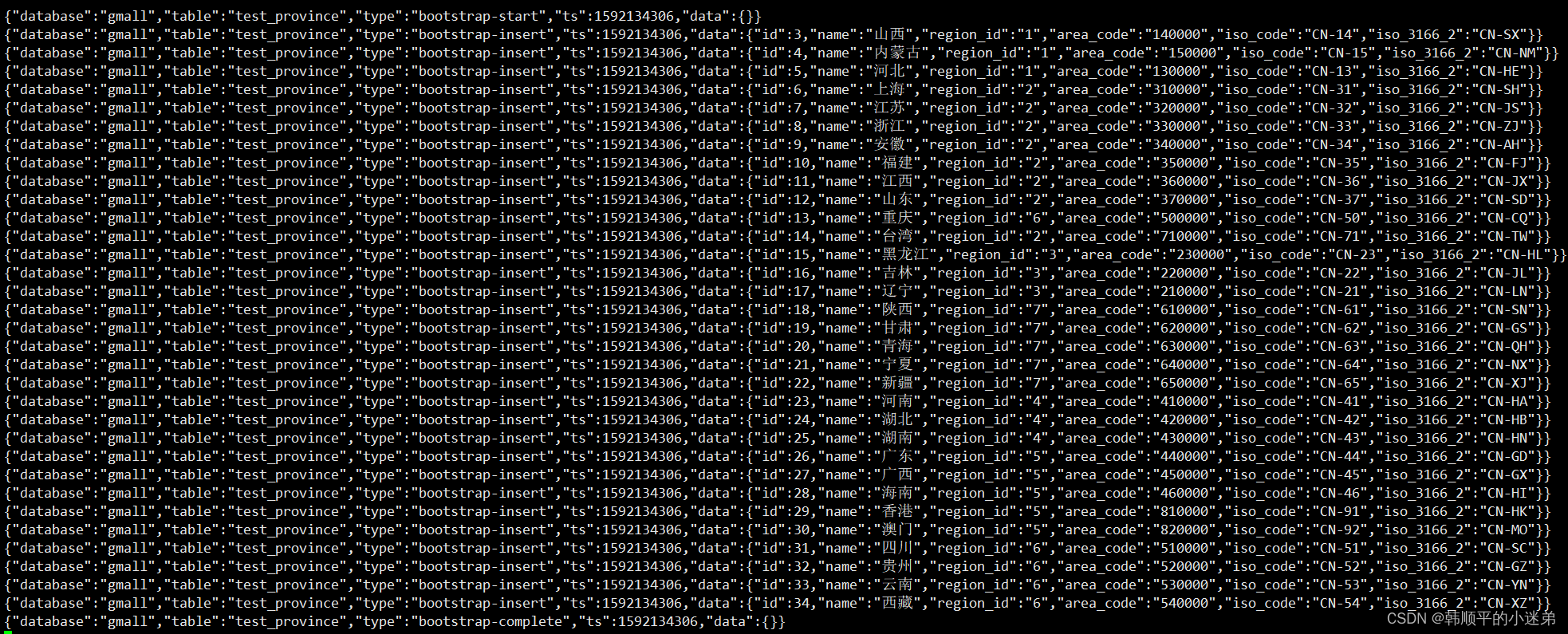

4.4 历史数据全量同步

上一节,我们已经实现了使用Maxwell实时增量同步MySQL变更数据的功能。但有时只有增量数据是不够的,我们可能需要使用到MySQL数据库中从历史至今的一个完整的数据集。这就需要我们在进行增量同步之前,先进行一次历史数据的全量同步。这样就能保证得到一个完整的数据集。

0)启动Maxwell: mxw.sh start

[atguigu@hadoop102 bin]$ mxw.sh start

1)Maxwell提供了bootstrap功能来进行历史数据的全量同步,命令如下:

[atguigu@hadoop102 maxwell]$ /opt/module/maxwell/bin/maxwell-bootstrap --database gmall --table test_province --config /opt/module/maxwell/config.properties

效果展示:

mysql:

kafka集群的topic_db 主题消费者消费数据如下

这篇关于Maxwell数据同步(增量)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!