本文主要是介绍OpenCv 九点标定不准确的问题,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

1,物理条件

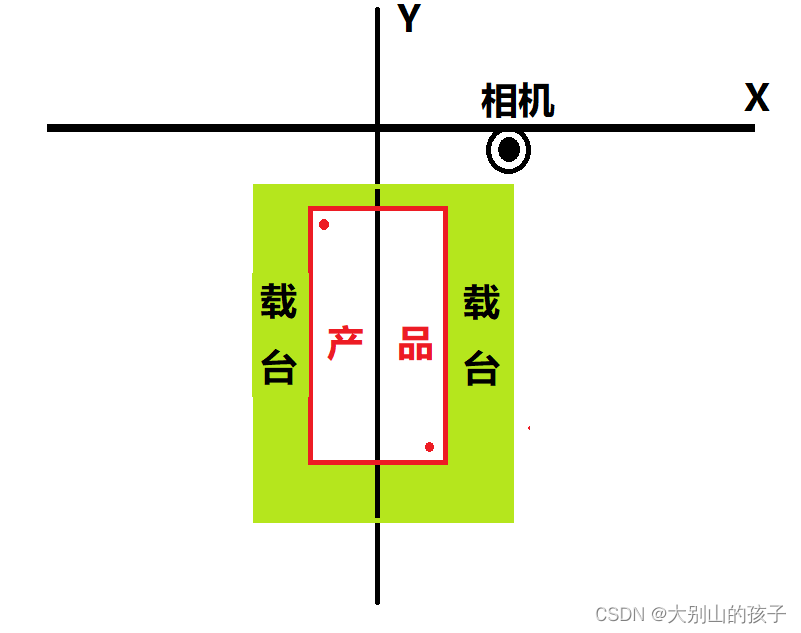

如图所示,X Y 为分离轴,相机固定在X轴上,载台固定在Y轴上,产品放在载台上,产品对角上有mark点,用相机识别mark点,获取mark点的像素坐标和轴的xy坐标,数据如下:

std::vector<cv::Point2f> camera;std::vector<cv::Point2f> robot;camera.push_back(cv::Point2f(153.5 , 781.5));camera.push_back(cv::Point2f(580.5 , 783.5));camera.push_back(cv::Point2f(1006.5 , 784.5));camera.push_back(cv::Point2f(153.5 , 436.5));camera.push_back(cv::Point2f(581.5 , 435.5 ));camera.push_back(cv::Point2f(1008.5 , 438.5));camera.push_back(cv::Point2f(154.5 , 90.5));camera.push_back(cv::Point2f(581.5 , 89.5));camera.push_back(cv::Point2f(1008.5 , 91.5));robot.push_back(cv::Point2f(552348 , 541607));robot.push_back(cv::Point2f(555548 , 541607));robot.push_back(cv::Point2f(558748 , 541607));robot.push_back(cv::Point2f(552348 , 544207));robot.push_back(cv::Point2f(555548 , 544207));robot.push_back(cv::Point2f(558748 , 544207));robot.push_back(cv::Point2f( 552348 , 546807));robot.push_back(cv::Point2f( 555548 , 546807 ));robot.push_back(cv::Point2f(558748 , 546807));用Opencv放射变换计算出两个坐标对应的矩阵关系M

cv::Mat matrix = cv::estimateAffinePartial2D(camera,robot);A = matrix.ptr<double>(0)[0];B = matrix.ptr<double>(0)[1];C = matrix.ptr<double>(0)[2];D = matrix.ptr<double>(1)[0];E = matrix.ptr<double>(1)[1];F = matrix.ptr<double>(1)[2];那么连个坐标系之间的映射关系如下:

QPair<float, float> MainWindow::getRobotPosition(float x, float y)

{QPair<float,float> pair;pair.first = (A*x) + B* y + C;pair.second = (D*x) + E* y + F;return pair;

}为了验证M是否正确,我们常用的做法是将camera集合里面的坐标带入到公式中 计算出机械坐标,然后跟实际的机械坐标相减,看看差值的范围

qDebug()<<"["<<getRobotPosition(153.5 , 781.5).first - robot.at(0).x<< " , "<<getRobotPosition(153.5 , 781.5).second - robot.at(0).y<<"]";qDebug()<<"["<<getRobotPosition(580.5 , 783.5).first - robot.at(1).x<< " , "<<getRobotPosition(580.5 , 783.5).second - robot.at(1).y<<"]";;qDebug()<<"["<<getRobotPosition(1006.5 , 784.5).first - robot.at(2).x<< " , "<<getRobotPosition(1006.5 , 784.5).second - robot.at(2).y<<"]";;qDebug()<<"["<<getRobotPosition(153.5 , 436.5).first - robot.at(3).x<< " , "<<getRobotPosition(153.5 , 436.5).second - robot.at(3).y<<"]";;qDebug()<<"["<<getRobotPosition(581.5 , 435.5 ).first - robot.at(4).x<< " , "<<getRobotPosition(581.5 , 435.5 ).second - robot.at(4).y<<"]";;qDebug()<<"["<<getRobotPosition(1008.5 , 438.5).first - robot.at(5).x<< " , "<<getRobotPosition(1008.5 , 438.5).second - robot.at(5).y<<"]";;qDebug()<<"["<<getRobotPosition(154.5 , 90.5).first - robot.at(6).x<< " , "<<getRobotPosition(154.5 , 90.5).second - robot.at(6).y<<"]";;qDebug()<<"["<<getRobotPosition(581.5 , 89.5).first - robot.at(7).x<< " , "<<getRobotPosition(581.5 , 89.5).second - robot.at(7).y<<"]";;qDebug()<<"["<<getRobotPosition(1008.5 , 91.5).first - robot.at(8).x<< " , "<<getRobotPosition(1008.5 , 91.5).second - robot.at(8).y<<"]";;到这地方发现,偏差极其的大,大到完全无法接受

[ 5075.56 , 6283.69 ]

[ 2555.38 , 3149.38 ]

[ 26.25 , 20.9375 ]

[ 2540.69 , 3146.31 ]

[ 0 , 0 ]

[ -2512.88 , -3132.69 ]

[ 0 , 0 ]

[ -2542.25 , -3138.94 ]

[ -5062.44 , -6273.19 ]到这里我一直怀疑是不是 获取Mark点中心坐标的时候计算错了?但仔细检查了后发现没有,于是想到用Halcon验证一下:

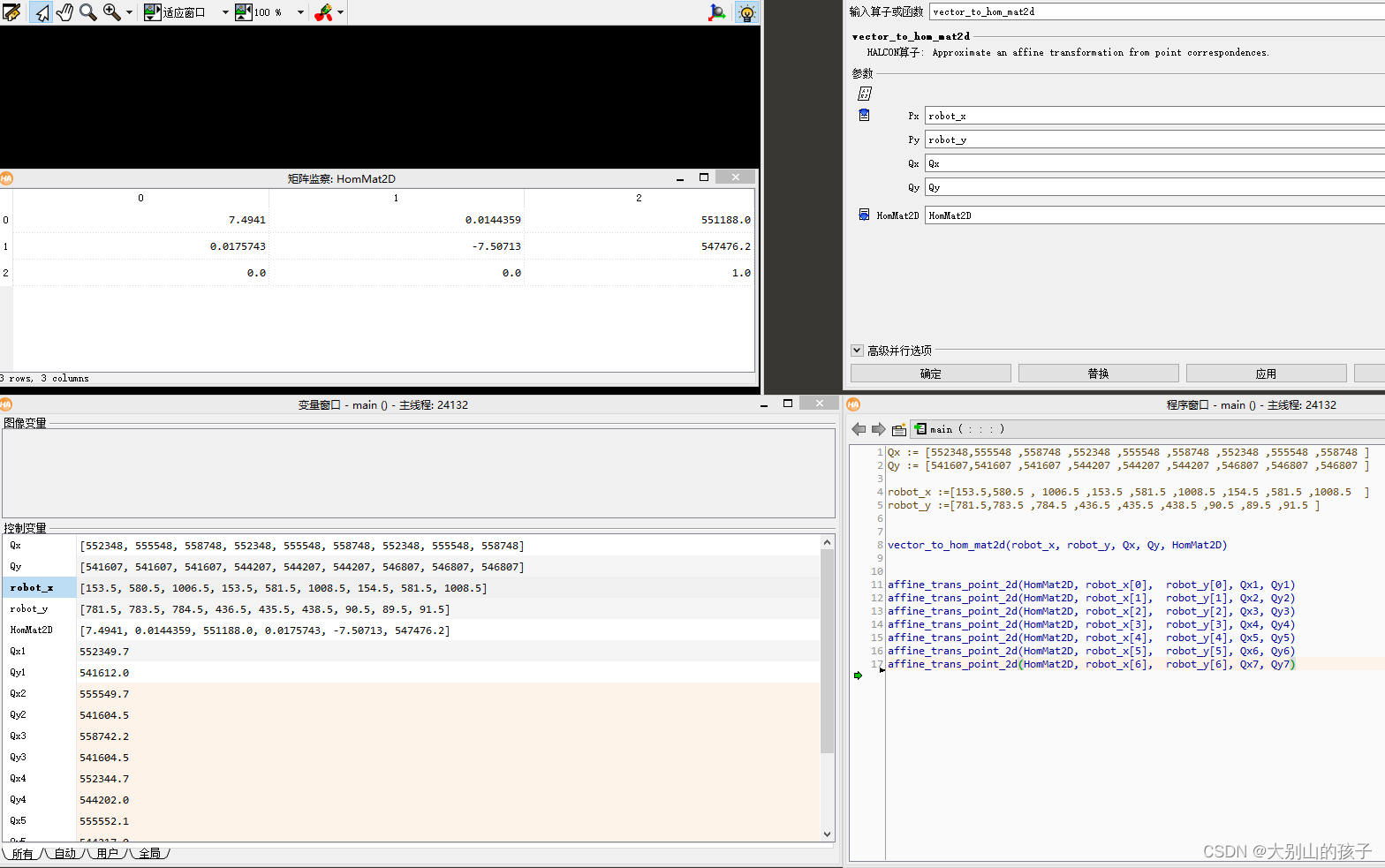

发现算出的矩阵M和Opencv算出来的完全不一样,带入M 计算差值:

[ 1.625 , 5.0625 ]

[ 1.625 , -2.4375 ]

[ -5.875 , -2.4375 ]

[ -3.375 , -4.9375 ]

[ 4.125 , 10.0625 ]

[ 4.125 , -4.9375 ]

[ -0.875 , -7.5 ]

[ -0.875 , 7.5625 ]

[ -0.875 , 0 ]最大偏差在10个脉冲之类(我一个脉冲 1um)完全可以接受。

不知道这是为什么

这篇关于OpenCv 九点标定不准确的问题的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!