本文主要是介绍【论文阅读】clDice - a Novel Topology-Preserving Loss Function for Tubular Structure Segmentation,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

【论文阅读】clDice - a Novel Topology-Preserving Loss Function for Tubular Structure Segmentation

2022年2月18日

(本文仅作为本人学习中的记录,如有错误欢迎批评指正。)

文章目录

- 【论文阅读】clDice - a Novel Topology-Preserving Loss Function for Tubular Structure Segmentation

- 一、概述

- 二、任务背景

- 三、方法介绍

- 1、整体框架

- 2、clDice计算过程

- 3、soft-clDice和模型训练

- 四、实验结果

- 五、总结

一、概述

先上论文链接:clDice - a Novel Topology-Preserving Loss Function for Tubular Structure Segmentation.

对文章结构做一个整体的梳理:

- Purpose:提高管状结构分割结果的拓扑连通性。

- Methods:提出了clDice作为拓扑相似性测度,并提出soft-clDice作为损失函数,其原理为计算分割结果与骨架的相交占比。为了将soft-clDice用以模型训练,使用soft skeleton的方法得到软骨架,再计算clDice,这样就可以实现Loss函数的可微。

- Results:实验在视网膜数据集、道路数据集、神经元数据集等数据集上进行了验证,soft-clDice具有良好的效果。

- Conclusion:提出的soft-clDice对于血管、道路、组织等连续管状结构的分割具有良好的效果,提高了分割结果的拓扑连通性。

二、任务背景

管状和曲线结构的分割是许多领域的一个基本问题,例如临床和生物应用(从显微镜、光声或放射学图像分割血管和神经元)、遥感应用(从卫星图像分割道路网络)和工业质量控制等等。在上述领域中,拓扑上精确的分割是保证下游任务无差错的必要条件,如计算血流动力学、路线规划、阿尔茨海默病预测或中风建模。

为了评估管状结构中的分割效果,传统的基于体积的性能指标(如Dice)是次优的。在像网络拓扑提取这样的任务中,保证拓扑结构的完整性具有更大的价值。

为此,作者提出了两个问题:1、在保证网络拓扑结构保持不变的情况下,对于管状结构和曲线结构的分割算法,什么是一个很好的像素衡量标准? 2、是否能用这个标准作为神经网络的损失函数?

三、方法介绍

1、整体框架

作者提出的方法如下图所示:

(1)首先对原图使用分割网络得到粗略分割概率图;

(2)再分别对实际结果(Actual Mask)和预测结果(Predicted Mask)提取软骨架;

(3)最后根据Soft-clDice的计算公式计算soft-clDice,与soft-Dice结合得到损失函数,进行模型训练。

2、clDice计算过程

其中clDice的计算过程如下:

设 V L V_L VL为真实结果, V P V_P VP为预测结果, S L S_L SL为从真实结果中提取的骨架, S P S_P SP为从预测结果中提取的骨架。那么可以定义拓扑准确性为 T p r e c ( S P , V L ) Tprec(S_P, V_L) Tprec(SP,VL),拓扑敏感度为 T s e n s ( S L , V P ) Tsens(S_L, V_P) Tsens(SL,VP),其计算方式为:

当FP增多时, T p r e c Tprec Tprec对应下降;当FN增多时, T s e n s Tsens Tsens对应下降。由此可见, T p r e c Tprec Tprec对应了拓扑学上的Precision,而 T s e n s Tsens Tsens则对应了拓扑学上的Sensitivity。

最后定义 c l D i c e clDice clDice为 T p r e c Tprec Tprec和 T s e n s Tsens Tsens的F1-score:

3、soft-clDice和模型训练

为了将clDice用以模型训练的Loss函数,文章提出了soft-clDice和soft-skeletonize。

文章使用最小和最大过滤器用作形态膨胀和侵蚀的灰度替代,提出了“软骨架化”(soft-skeletonize)。soft-skeletonize中涉及的迭代过程如下图所示。计算中涉及的超参数k表示迭代次数,并且必须大于或等于观察到的最大半径。

soft-skeletonize算法和soft-clDice的计算过程如下图所示,总体来说先腐蚀(minpool)再膨胀(maxpool),再用原骨架减去该结果,如此不断迭代k次得到软化骨架,然后再根据公式计算soft-clDice。

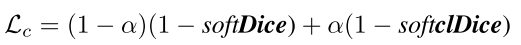

最后将soft-Dice和soft-clDice的加权和作为Loss函数:

四、实验结果

文章分别使用5个公共数据集来验证clDice和soft-clDice作为度量和目标函数的效果。在2D中,使用了DRIVE视网膜数据集、马萨诸塞州道路数据集和CREMI神经元数据集进行评估。在3D中,使用具有附加高斯噪声项的合成血管数据集和脑血管多通道容积扫描的Vessap数据集进行了评估。实验的可视化结果如下图所示:

五、总结

文章介绍了一种用于管状结构分割的拓扑保持相似性度量clDice,并在损失函数中使用clDice的可微版本soft-clDice来训练2D和3D神经网络。文章使用clDice以及其他基于体积、拓扑和图形的度量来测试分割质量,实验发现在soft-clDice上进行训练可以获得更精确的连通性信息、更好的图相似性、更好的Euler特征以及更好的Dice和准确性。除此之外,clDice可以应用到其他基于深度学习的分割任务中,如生物医学成像中的神经元分割、工业质量控制中的裂纹检测或遥感分割等任务。

这篇关于【论文阅读】clDice - a Novel Topology-Preserving Loss Function for Tubular Structure Segmentation的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!