本文主要是介绍【神经网络基础】第二课--浅层神经网络,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

课程来源:吴恩达 深度学习课程 《神经网络基础》

笔记整理:王小草

时间:2018年5月15日

1.神经网络概览

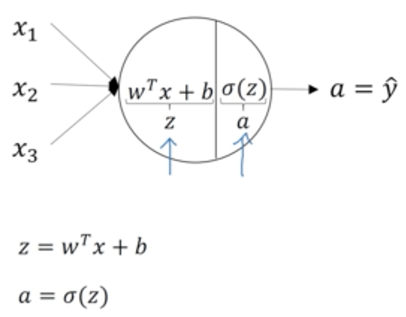

回顾逻辑回归的结构:

圆圈节点内的计算如下,先计算线性z,再过一个sigmoid函数得到a,然后计算损失函数,进行梯度下降法求最优参数。

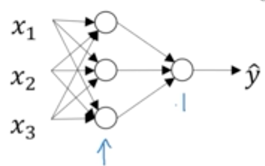

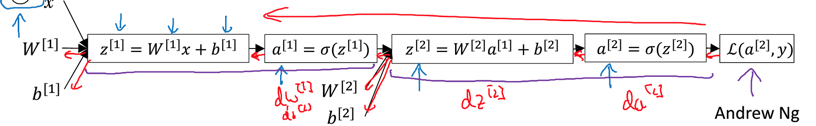

推广到神经网络,每个圆圈节点都代表以上z,a两步计算(第一层用1表示,第而层用2表示)

相当于如下计算过程:

同样使用反向传播可以计算出梯度,并寻找最优参数

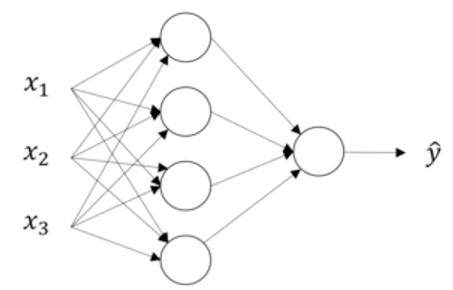

2.神经网络表示

以上神经网络,第一层是输入层,第二层是隐藏层,第三层是输出层。因此这是一个两层的神经网络(一般我们不算输入层)。

输入层:

用a[i]表示第i层的计算结果,也就是第i+1层的输入。因此输入层传递给隐藏层的数据,就是输入x本身,即a[0] = x

隐藏层:

第一个隐藏层的计算结果用a[1]表示,由于隐藏层中有4个节点(神经元),每个节点的计算结果可以用a1j表示:

即a[1]可以表示成:

输出层:

输出层表示为a[2],即为最终的输出y^

3.神经网络输出

神经网络到底最后会计算出什么鬼?

每个神经元的计算如下:

隐藏层计算:

那么整个神经网络其实就是在重复以上过程的叠加。首先看隐藏层的四个节点,每个节点都先计算z,a:

这篇关于【神经网络基础】第二课--浅层神经网络的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!