本文主要是介绍测试训练好的siamese网络,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

在这篇博客中https://blog.csdn.net/sinat_33486980/article/details/91440461 新训练了单分支的siamese网络。

参考了论文:Online Multi-Object Tracking with Historical Appearance Matching and Scene Adaptive Detection Filtering

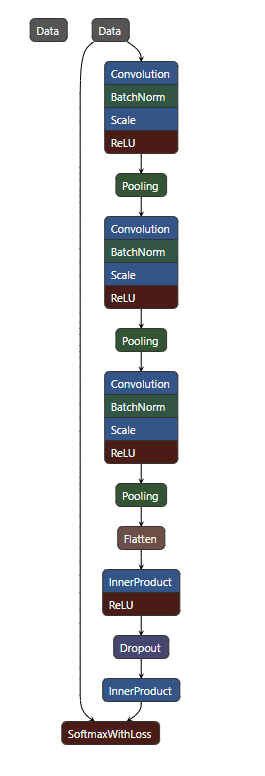

结构做了调整,防止过拟合,加入了batchnorm层,网络结构如下:

训练了100000次,最终的train loss 和testloss分别为:

生成的模型为:

目的:

在vs中调用训练好的siamese模型来判断任意两张图像是否相似,输出两个人是同一个人的概率。下面是几张测试用的图片(同一缩放为128x64x3):

man1 man2 man3 man4

第一步:设置vs2013中的模型路径

然后在vs2013里面测试这个网络区分相同图片和不同图片的能力,修改加载网络函数中的网络模型文件路径和delpoy文件路径

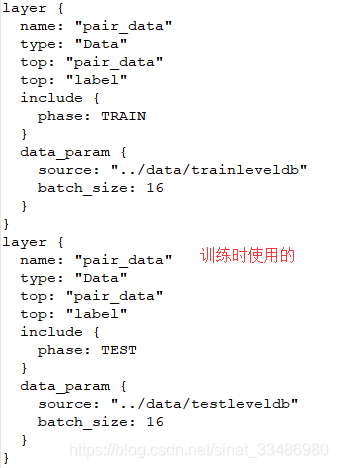

这里的deploy文件是将网络定义文件做修改,要在vs中使用模型,输入的是读取的图像Mat格式,也就是“MemoryData”类型,而在训练的prototxt文件中的数据层是“Data”类型,输入数据是lmdb或者leveldb。因此这里首先要修改数据层:

上图,左边是训练时使用的数据层,右边是现在测试时的deploy文件中的数据层。这里的channels是6,而不是3,是因为这个网络结构采用的是单分支的孪生网络,输入是两张图像的堆叠(3+3=6)。

然后删掉卷积层和全连接层的权重和偏置项参数,将网络最后的softmaxWithLoss改成softmax,因为我想输出两张图像是否相似的概率。

修改前的输出层

修改后的输出层:

第二步:处理输入数据

接下来就是很重要的部分了,就是对输入数据进行处理。

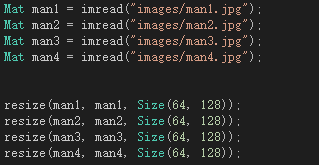

首先加载这四张图片,缩放到64宽,128高的大小。

然后就是重点:将两张图片合并成一张6通道的图片

然后调用特征提取函数:

特征提取函数中设置要提取的网络层的名字,我这里要输出概率值,因此输出softmax层,这一层的名字叫loss

这里需要注意,softmax输出的是两个值:[负例的概率,正例的概率],我的正例指的是两张图片相似,所以只输出第二项的值就可以了:

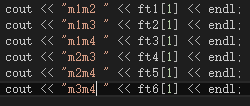

最后输出这四张图片两两相似的概率:

再来看一下要对比的4张图片:

man1和man2相似度为0.999846,是同一个人,判断正确

man3和man4相似度为0.997171,是同一个人,判断正确,而且这两个人身体的朝向都是不一样的

其他的都是相似度很低的,因为不是同一张图片。

总结

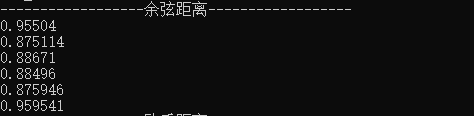

这个孪生网络模型才759k,我用的其他的reid模型都是几M甚至更大,而且这个网络判断是否是同一目标的能力还挺强,速度还快(![]() ),可以考虑换掉提取单张图片特征向量再计算向量余弦距离,构建相似度矩阵的方法,而直接用siamese网络生成相似度矩阵,简化步骤,加快速度。(实际测试时,还是很有问题,因为虽然计算一次相似度耗时降低了很多,但是计算次数增加了更多,比如:有6个跟踪框,5个检测框,用原来的方法,只需要调用网络提取5个检测框的特征,计算与6个跟踪框的历史特征(已经保存,可直接读取)的余弦距离。但是用siamese的方法直接计算相似度,需要两两配对,调用网络计算6*5=30次,每增加一个框,就增加好几次的循环,如果框再多时,会达到上百ms,特别慢。)

),可以考虑换掉提取单张图片特征向量再计算向量余弦距离,构建相似度矩阵的方法,而直接用siamese网络生成相似度矩阵,简化步骤,加快速度。(实际测试时,还是很有问题,因为虽然计算一次相似度耗时降低了很多,但是计算次数增加了更多,比如:有6个跟踪框,5个检测框,用原来的方法,只需要调用网络提取5个检测框的特征,计算与6个跟踪框的历史特征(已经保存,可直接读取)的余弦距离。但是用siamese的方法直接计算相似度,需要两两配对,调用网络计算6*5=30次,每增加一个框,就增加好几次的循环,如果框再多时,会达到上百ms,特别慢。)

另外两个网络的效果:

1、DeepSort中用到的cosinMetric外观特征提取网络

网络前向推理一次耗时:![]()

特征向量长度:128

模型大小:11.4M

2、MOTDT中用到的part_reid外观特征提取网络

网络前向推理一次耗时:![]() ,虽然看起来比上面那个耗时少,但是在实际使用中耗时会多1ms左右。

,虽然看起来比上面那个耗时少,但是在实际使用中耗时会多1ms左右。

特征向量长度512

模型大小:15.9M

这篇关于测试训练好的siamese网络的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!