本文主要是介绍论文笔记:Self-critical Sequence Training for Image Captioning,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文链接:Self-critical Sequence Training for Image Captioning

引言

现在image caption主要存在的问题有:

-

exposure bias:模型训练的时候用的是叫“Teacher-Forcing”的方式:输入RNN的上一时刻的单词是来自训练集的ground-truth单词。而在测试的时候依赖的是自己生成的单词,一旦生成得不好就会导致误差的积累,导致后面的单词也生成得不好。

-

模型训练的时候用的是cross entropy loss,而evaluate的时候却用的是BLEU、ROUGE、METEOR、CIDEr等metrics,存在不对应的问题。

由于生成单词的操作是不可微的,无法通过反向传播来直接优化这些metrics,因此很多工作开始使用强化学习来解决这些问题。

但强化学习在计算期望梯度时的方差会很大,通常来说是不稳定的。又有些研究通过引入一个baseline来进行bias correction。还有一些方法比如Actor-Critic,训练了一个critic网络来估算生成单词的value。

而本文的方法则没有直接去估算reward,而是使用了自己在测试时生成的句子作为baseline。sample时,那些比baseline好的句子就会获得正的权重,差的句子就会被抑制。具体做法会在后面展开。

Caption Models

本文分别使用了两个caption model作为基础,分别是

- FC model [3, 4]。就是以cross entropy loss训练的image caption模型,公式基本跟show and tell里的公式一样。

- Attention Model(Att2in)。本文对原模型的结构进行了一些修改,只把attention feature输入到LSTM的cell node,并且发现使用ADAM方法优化的时候,这种结构的表现优于其他结构。

FC models

公式就不打了,只需要知道LSTM最后输出的是每个单词的分数 s t s_t st,再通过softmax得到下一个单词的概率分布为 w t w_t wt。

训练目标是最小化cross entropy loss(XE):

L ( θ ) = − ∑ t = 1 T l o g ( p θ ( w t ∗ ∣ w 1 ∗ , . . . , w t − 1 ∗ ) ) L(\theta) = - \sum^T_{t=1} log(p_\theta(w^*_t | w^*_1,...,w^*_{t-1})) L(θ)=−∑t=1Tlog(pθ(wt∗∣w1∗,...,wt−1∗))

θ \theta θ是模型的参数, w 1 ∗ , . . . , w t − 1 ∗ w^*_1,...,w^*_{t-1} w1∗,...,wt−1∗是训练集中的语句, s t s_t st、 p θ p_\theta pθ在后面Reinforcement Learning部分会被用到。

Attention Model(Att2in)

公式基本跟FC Model的一样,只不过在cell node的公式里加了个attention项,其他部分以及loss function也跟上面一样的。

Reinforcement Learning

把序列问题看作是一个RL的问题:

- Agent: LSTM

- Environment: words and image features

- Action: prediction of the next word(模型的参数 θ \theta θ定义了一个policy p θ p_\theta pθ,也就是上面的 p θ p_\theta pθ,从而导致了这个action)

- State: cells and hidden states of the LSTM, attenion weights etc

- Reward: CIDEr score r

训练目标是最小化负的期望

L ( θ ) = − E w s ∼ p θ [ r ( w s ) ] L(\theta) = -\mathbb{E}_{w^s\sim p_\theta} [r(w^s)] L(θ)=−Ews∼pθ[r(ws)]

= − ∑ r ( w s ) p θ ( w s ) = -\sum r(w^s)p_\theta (w^s) =−∑r(ws)pθ(ws)

w s = ( w 1 s , . . . , w T s ) w^s=(w^s_1,...,w^s_T) ws=(w1s,...,wTs)是生成的句子。

实际上, w s w^s ws可以依据 p θ p_\theta pθ的概率来进行single sample(而不是选择概率最大的那一个), L ( θ ) L(\theta) L(θ)可以近似为:

L ( θ ) ≈ − r ( w s ) , w s ∼ p θ L(\theta) \approx -r(w^s), w^s \sim p_\theta L(θ)≈−r(ws),ws∼pθ

L关于 θ \theta θ的梯度为:

∇ θ L ( θ ) = − E w s ∼ p θ [ r ( w s ) ∇ θ log p θ ( w s ) ] \nabla_\theta L(\theta) = -\mathbb{E}_{w_s\sim p_\theta}[r(w^s)\nabla_\theta \log p_\theta(w^s) ] ∇θL(θ)=−Ews∼pθ[r(ws)∇θlogpθ(ws)]

推导过程:

再引入一个baseline来减少方差:

∇ θ L ( θ ) = − E w s ∼ p θ [ ( r ( w s ) − b ) ∇ θ log p θ ( w s ) ] \nabla_\theta L(\theta) = -\mathbb{E}_{w_s\sim p_\theta}[(r(w^s) - b)\nabla_\theta \log p_\theta(w^s) ] ∇θL(θ)=−Ews∼pθ[(r(ws)−b)∇θlogpθ(ws)]

baseline可以是任意函数,只要它不依赖action w s w^s ws,引入它并不会改变梯度的值,证明如下:

实际上 L ( θ ) L(\theta) L(θ)可以被近似为:

∇ θ L ( θ ) ≈ − ( r ( w s ) − b ) ∇ θ log p θ ( w s ) \nabla_\theta L(\theta) \approx -(r(w^s) - b)\nabla_\theta \log p_\theta(w^s) ∇θL(θ)≈−(r(ws)−b)∇θlogpθ(ws)

应用链式法则,梯度可以表示为:

∇ θ L ( θ ) = ∑ t = 1 T ∂ L ( θ ) ∂ s t ∂ s t ∂ θ \nabla_\theta L(\theta) = \sum_{t=1}^T \frac{\partial L(\theta) }{\partial s_t } \frac{\partial s_t }{\partial \theta} ∇θL(θ)=t=1∑T∂st∂L(θ)∂θ∂st

根据Reinforcement learning neural turing machines: //我在原文并没有找到为什么可以这样近似,但在SEQUENCE LEVEL TRAINING WITH RECURRENT NEURAL NETWORKS里面有解释

∂ L ( θ ) ∂ s t ≈ ( r ( w s ) − b ) ( p θ ( w t ∣ h t ) − 1 w t s ) \frac{\partial L(\theta)}{\partial s_t} \approx (r(w^s) - b)(p_\theta(w_t|h_t) - 1_{w_t^s}) ∂st∂L(θ)≈(r(ws)−b)(pθ(wt∣ht)−1wts)

1 w t s 1_{w_t^s} 1wts是词的one-hot向量表示。

Self-Critical sequence training(SCST)

SCST阶段的训练过程如图所示:

SCST的思想就是用当前模型在测试阶段生成的词的reward作为baseline,梯度就变成了:

∂ L ( θ ) ∂ s t ≈ ( r ( w s ) − r ( w ^ ) ) ( p θ ( w t ∣ h t ) − 1 w t s ) \frac{\partial L(\theta)}{\partial s_t} \approx (r(w^s) - r(\hat w))(p_\theta(w_t|h_t) - 1_{w_t^s}) ∂st∂L(θ)≈(r(ws)−r(w^))(pθ(wt∣ht)−1wts)

其中 r ( w ^ ) = a r g m a x w t p ( w t ∣ h t ) r(\hat w)=arg max_{w_t}p(w_t|h_t) r(w^)=argmaxwtp(wt∣ht),就是在测试阶段使用greedy decoding取概率最大的词来生成句子;

而 r ( w s ) r(w^s) r(ws)是通过根据概率来随机sample词,如果当前概率最大的词的概率为60%,那就有60%的概率选到它,而不是像greedy decoding一样100%选概率最大的。

公式的意思就是:对于如果当前sample到的词比测试阶段生成的词好,那么在这次词的维度上,整个式子的值就是负的(因为后面那一项一定为负),这样梯度就会上升,从而提高这个词的分数 s t s_t st;而对于其他词,后面那一项为正,梯度就会下降,从而降低其他词的分数。

Experiments

训练阶段,作者使用了curriculum learning的方法:先对最后一个词使用CIDEr的目标进行训练,前面的词则使用XE进行训练,然后逐步开始提高比例,对最后两个词、三个词用CIDEr进行训练。但最后发现在MSCOCO数据集上,这种训练方法没有提高模型的performance。

作者也对其他的metrics进行优化,但是发现只有优化CIDEr才能提高其他metrics的得分。

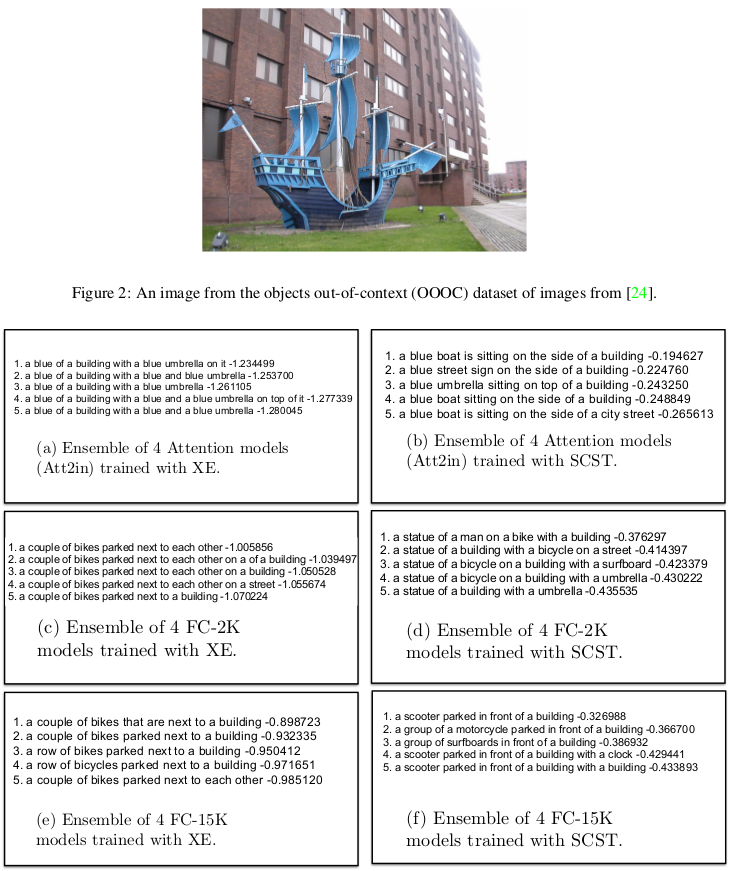

有意思的是,文章还对一些objects ut-of-context(OOOC)的图片进行实验,发现使用了SCST优化的Att2in模型能准确地描述图片。

但至于为什么模型有这样的能力,文章没有进行探讨。

Supplementary Material

几个有意思的点:

- 跟SEQUENCE LEVEL TRAINING WITH RECURRENT NEURAL NETWORKS的发现一样,作者发现使用RL加beam search训练的模型只比RL加greedy decoding训练的模型有少量的提升。

- 在优化CIDEr的时候要把EOS tag当成单词,不然的话生成的句子会含有大量的"with a"

"and a"这样没有意义但是能在CIDEr标准里面拿高分的单词。在CIDEr-D里面引入了截断和基于长度的惩罚,实际上就是本文所优化的(为什么不直接优化CIDEr-D呢?)

本文链接:http://blog.csdn.net/sinat_26253653/article/details/78458894

参考:用Reinforcement Learning来做image captioning

这篇关于论文笔记:Self-critical Sequence Training for Image Captioning的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!