本文主要是介绍YOLOv5结合BiFPN,如何替换YOLOv5的Neck实现更强的检测能力?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、BiFPN是什么?

1、什么是BiFPN

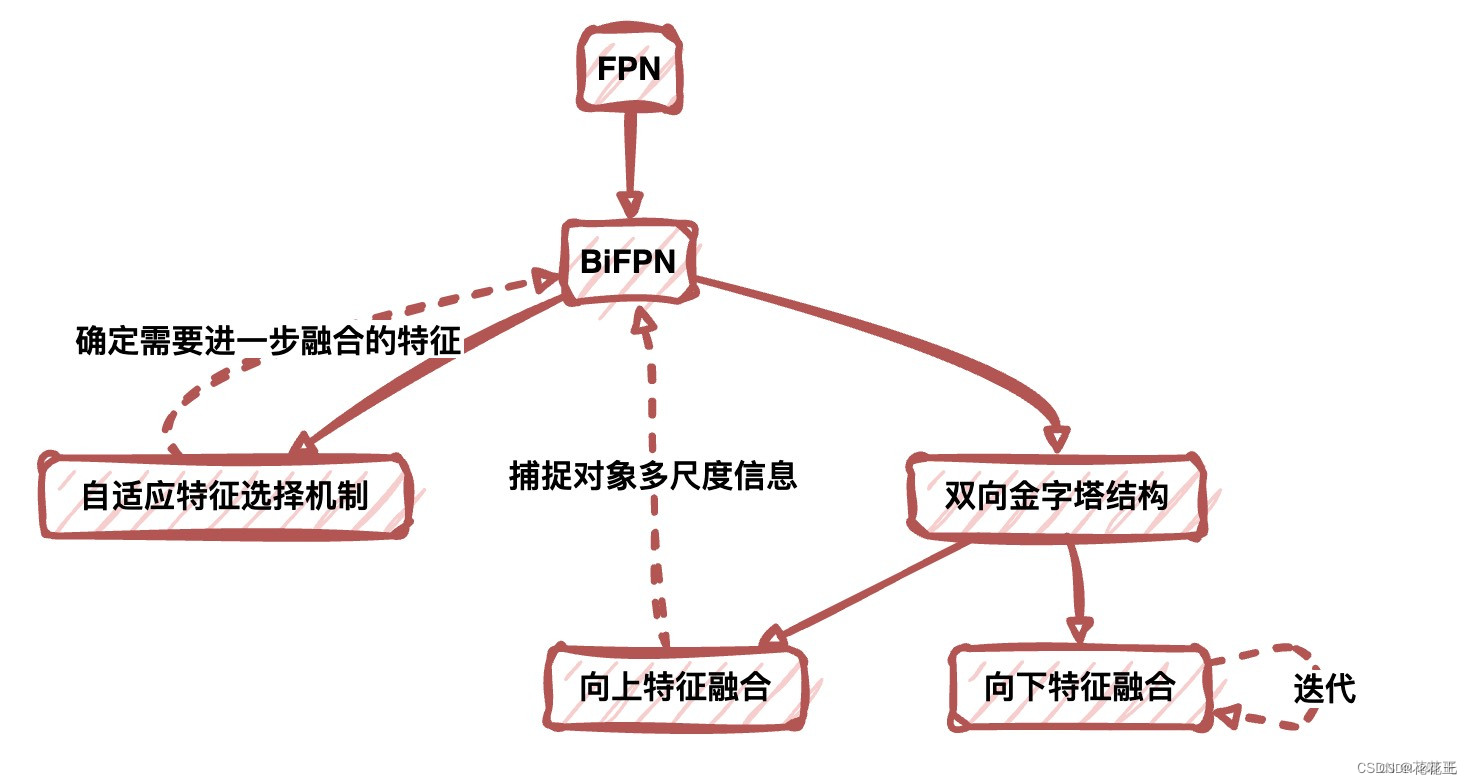

BiFPN是一种基于特征金字塔网络(FPN)和双向特征金字塔网络(BiFPN)的对象检测神经网络结构,它被用于提高目标检测的准确度和速度。在目标检测领域,FPN用于将不同分辨率的特征图进行融合,以便更好地捕捉对象的不同尺度和细节。然而,FPN只是在单向上进行融合,可能会导致低分辨率的特征图被忽略或过度压缩。因此,BiFPN被引入,以便更好地保留低分辨率特征图的细节信息。

BiFPN采用了双向金字塔结构,可以同时进行向上和向下的特征融合。通过不断地迭代,BiFPN可以有效地提高特征图的质量,并捕捉对象的多尺度信息。BiFPN中使用的自适应特征选择机制可以自动确定哪些特征需要进一步融合,哪些不需要。

2、BiFPN的优势

BiFPN相较于其他结构有以下优势:

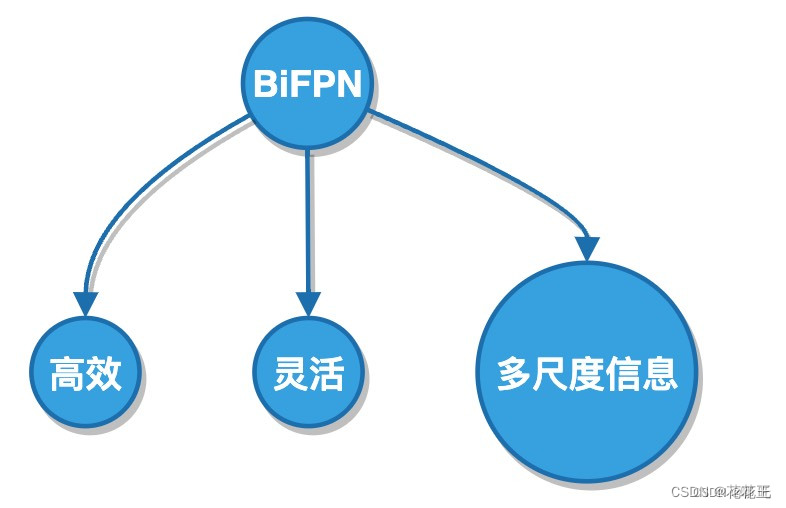

高效:BiFPN不仅可以提高目标检测的准确度,还可以在不增加过多计算成本的情况下提高速度。

灵活:BiFPN能够适应不同的输入分辨率和目标大小,可用于各种不同的目标检测任务。

多尺度信息:BiFPN可以捕捉到多尺度的对象信息,并保留低分辨率特征图的细节信息。

二、为什么要用BiFPN替换YOLOv5的Neck?

1、YOLOv5原有的Neck存在的问题

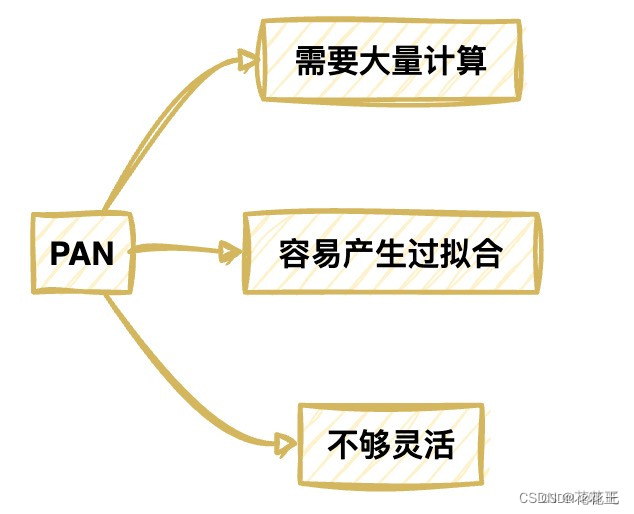

在YOLOv5的网络结构中,Neck部分主要由三个部分构成,即SPP、PAN和CSP。其中,PAN是整个Neck部分中最重要的一个部分,它可以将来自不同特征层的信息融合在一起,从而提高检测精度。

但是,PAN也存在一些问题,具体如下:

需要大量计算:由于PAN需要对不同特征层的信息进行融合,所以需要进行大量的计算。这不仅会增加训练和推理的时间成本,还会增加模型的计算复杂度,降低了模型的效率。

容易产生过拟合:由于PAN会将来自不同特征层的信息融合在一起,因此很容易产生过拟合的情况。当模型的训练数据不足或者训练数据中存在噪声时,就容易产生过拟合,从而导致检测结果不准确。

不够灵活:PAN是基于金字塔结构的,因此对输入分辨率和目标大小比较敏感,不够灵活。这意味着当输入分辨率和目标大小发生变化时,PAN需要重新训练,从而降低了模型的适用性。

2、BiFPN的适用场景

目标检测算法中的Neck(也称为特征融合层)是连接主干网络与检测头的关键组件。它能够将来自不同层级的特征图融合成更加丰富的特征,提供更全面的信息给检测头,从而提高目标检测算法的准确率。然而,传统的Neck存在一些问题,如融合不充分、计算量大等。针对这些问题,BiFPN成为了目标检测领域的一种热门的Neck结构,下面将对BiFPN的适用场景进行详细介绍。

(1)高效地利用不同分辨率的特征图

目标检测算法中,不同层级的特征图通常具有不同的分辨率,这些特征图提供了不同尺度的信息。在传统的Neck结构中,常常只选择其中一个分辨率的特征图作为输入,丢弃其他的特征图,这样会造成信息的损失。而BiFPN通过对不同分辨率的特征图进行多层级的融合,可以充分地利用不同分辨率的特征图提供的信息。另外,BiFPN通过自适应的权重调整机制,可以自动学习到每个特征图对最终的检测结果的重要性,从而更加精确地融合特征图。

(2)提高模型对特征细节的感知能力

在目标检测算法中,对于一些小目标或者遮挡严重的目标,需要模型有更强的特征细节感知能力才能进行准确的检测。而传统的Neck结构由于缺乏多层级的信息融合机制,常常无法充分地利用不同层级的特征图提供的信息,导致对目标细节的感知能力较弱。BiFPN通过对不同层级的特征图进行多次的信息融合,可以增强模型对特征细节的感知能力,从而提高检测算法的准确率。

(3)可以适用于不同的网络架构

BiFPN作为一种通用的特征融合结构,可以应用于不同的目标检测网络架构中。例如,它可以作为骨干网络EfficientNet的Neck结构,用于目标检测任务。另外,它也可以作为YOLOv5的Neck结构,提高YOLOv5在目标检测任务上的性能。

除此之外,BiFPN还可以与其他网络结构相结合,以满足不同的应用需求。例如,在一些特定的目标检测任务中,我们可能需要更深、更复杂的网络结构来提高检测性能,而这种情况下,我们可以将BiFPN与其他特征提取网络结构相结合,以构建更加强大的目标检测网络。

三、如何在YOLOv5中实现BiFPN

1、下载并替换BiFPN代码

首先,需要从GitHub上下载EfficientDet-Pytorch代码库,该库是一个基于PyTorch的EfficientDet实现,其中包含了BiFPN的实现。我们可以在该代码库中找到effdet文件夹,并将其中的bifpn.py文件拷贝到YOLOv5代码库的models文件夹中,用于替换原有的Neck实现。

2、修改配置文件

接下来,需要修改YOLOv5的配置文件,将Neck配置修改为BiFPN。

具体步骤如下:

打开YOLOv5的配置文件,通常为yolov5s.yaml,可以在YOLOv5代码库的models文件夹中找到该文件;

找到Neck配置,通常为如下代码段:

YOLOv5 neck

neck:

FPN or PAN, None for YOLOv3

type: FPN

in_channels: [256, 512, 1024]

out_channels: 256

将type字段的值修改为BiFPN,并将in_channels和out_channels字段的值根据实际需要进行调整,通常情况下可以保持默认值不变;

保存配置文件。

3、遇到的问题及解决方法

在实现BiFPN时,可能会遇到以下问题:

(1)缺少依赖包

如果在执行上述代码时出现缺少依赖包的错误,可以使用以下命令安装依赖包:

!pip install -r requirements.txt

(2)BiFPN的运行速度较慢

由于BiFPN比传统的Neck结构更加复杂,因此可能会导致模型的运行速度较慢。为了解决这个问题,我们可以使用以下方法:

使用GPU进行训练和推理

减少堆叠BiFPN的数量

调整epsilon值

四、BiFPN超参数调整

超参数是指在模型训练过程中需要手动设定的参数,如学习率、批大小等。在使用BiFPN时,需要对一些超参数进行调整以达到更好的效果。

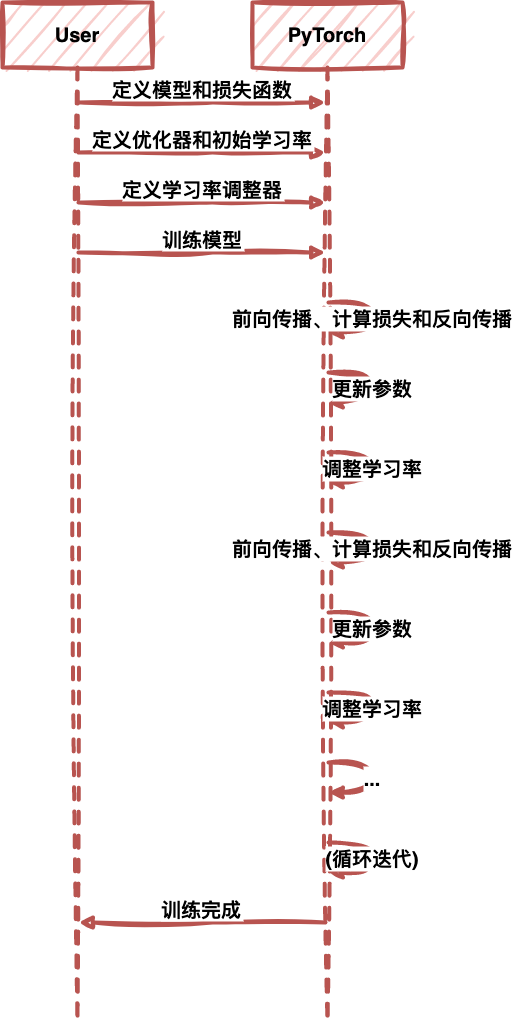

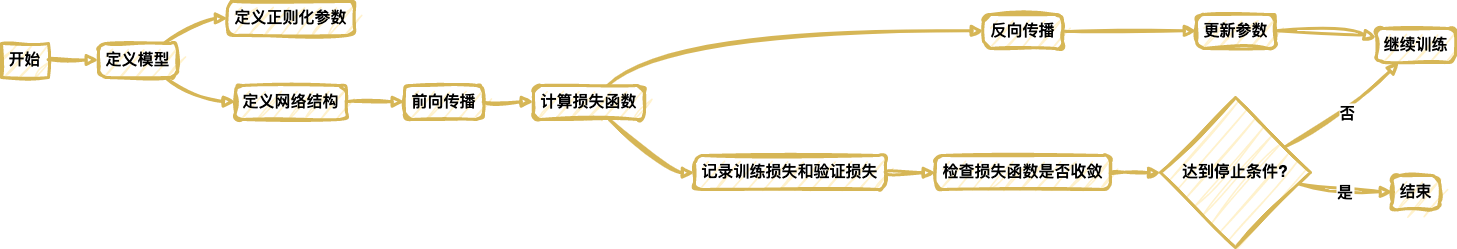

1、学习率

学习率是模型训练过程中最为重要的超参数之一,它决定了模型在每一次迭代中更新参数的速度。在使用BiFPN时,需要根据实际情况对学习率进行调整。一般来说,可以先设置一个较大的学习率,然后通过观察训练损失的变化来调整学习率的大小。如果损失没有下降,说明学习率太大,需要减小学习率;如果损失下降缓慢,说明学习率太小,需要增大学习率。

下面是使用PyTorch进行学习率调整的示例代码:

import torch.optim as optim

定义模型和损失函数

model = …

criterion = …

定义优化器和初始学习率

optimizer = optim.SGD(model.parameters(), lr=0.1)

定义学习率调整器,每30个epoch将学习率除以10

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=30, gamma=0.1)

训练模型

for epoch in range(num_epochs):

for batch_idx, (data, target) in enumerate(train_loader):

# 前向传播、计算损失和反向传播

…

# 更新参数optimizer.step()# 调整学习率scheduler.step()# 在验证集上测试模型,并记录损失和准确率

...

这里使用了optim.lr_scheduler.StepLR调整学习率,该调整器每隔一定步数将学习率乘以一个指定的因子(这里是0.1),从而实现学习率的下降。step_size参数指定了学习率下降的步数,这里是每30个epoch下降一次。如果损失没有下降,可以考虑将gamma参数设为一个更小的值,以减缓学习率的下降速度。如果损失下降缓慢,可以将gamma参数设为一个更大的值,以加速学习率的下降速度。

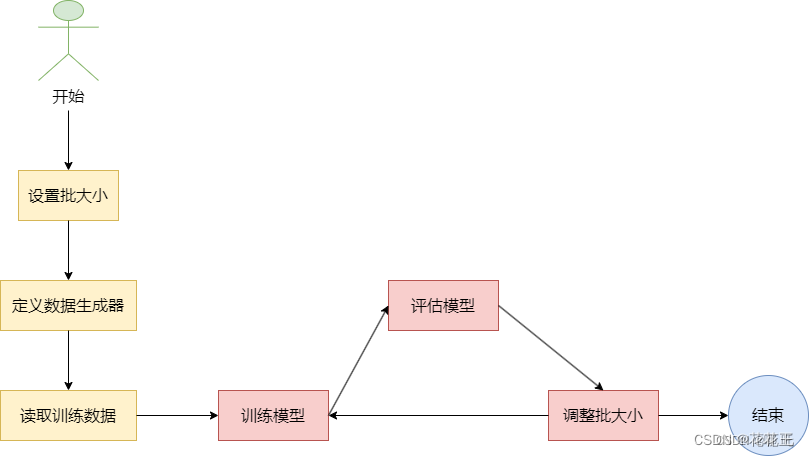

2、批大小

批大小是指在每一次模型训练中使用的样本数。批大小的设置通常需要平衡内存限制和训练效果。在使用BiFPN时,需要根据GPU内存大小和模型复杂度来确定合适的批大小。一般来说,批大小可以设置为32或64。

这里是一个示例代码,用于在训练过程中设置批大小为64:

定义训练批次大小

batch_size = 64

创建训练数据生成器

train_datagen = ImageDataGenerator(

rescale=1./255,

shear_range=0.2,

zoom_range=0.2,

horizontal_flip=True)

train_generator = train_datagen.flow_from_directory(

train_dir,

target_size=(img_width, img_height),

batch_size=batch_size,

class_mode=‘binary’)

在上述代码中,我们使用ImageDataGenerator从训练数据目录中读取图像数据,并将每个批次的大小设置为64。注意,批大小需要根据训练数据的数量和GPU内存大小来设置,以达到最佳的训练效果。

3、正则化参数

正则化是防止模型过拟合的一种常用技术,通过在损失函数中引入正则项来约束模型的复杂度。在使用BiFPN时,需要根据实际情况调整正则化参数的大小。一般来说,可以先将正则化参数设为较小的值,然后通过观察训练损失和验证损失的变化来调整正则化参数的大小。

这里是一个使用PyTorch实现L2正则化的示例代码:

import torch.nn as nn

class Model(nn.Module):

def init(self, regularization=0.001):

super(Model, self).init()

self.regularization = regularization

self.fc1 = nn.Linear(10, 5)

self.fc2 = nn.Linear(5, 1)

def forward(self, x):x = self.fc1(x)x = nn.functional.relu(x)x = self.fc2(x)return xdef loss(self, y_pred, y_true):l2_regularization = 0.for param in self.parameters():l2_regularization += torch.norm(param, 2)return nn.functional.mse_loss(y_pred, y_true) + self.regularization * l2_regularization

在这个示例中,我们使用L2正则化对模型的权重进行约束。在模型的构造函数中,我们定义了一个名为regularization的参数,它控制了正则化的强度。在forward方法中,我们使用了PyTorch提供的nn.functional.relu函数作为激活函数,并使用nn.Linear定义了两个全连接层。在loss方法中,我们首先计算了所有参数的L2范数之和,并将其乘以正则化参数,然后将其添加到均方误差损失中,得到最终的损失函数。

要使用这个模型进行训练,我们可以使用以下代码:

import torch.optim as optim

model = Model(regularization=0.001)

optimizer = optim.Adam(model.parameters(), lr=0.001)

for epoch in range(num_epochs):

for x, y in data_loader:

y_pred = model(x)

loss = model.loss(y_pred, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

在这个示例中,我们使用Adam优化器对模型进行训练。在每一个训练迭代中,我们首先通过调用模型的loss方法计算出损失,然后使用优化器的zero_grad方法清除梯度,并调用backward方法计算梯度,最后使用step方法更新模型的参数。

这篇关于YOLOv5结合BiFPN,如何替换YOLOv5的Neck实现更强的检测能力?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!