本文主要是介绍【pytorch】mmdetection 做eval / test时弹出OOM(Out of Memory / CUDA out of memory)的解决过程记录,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

问题描述:

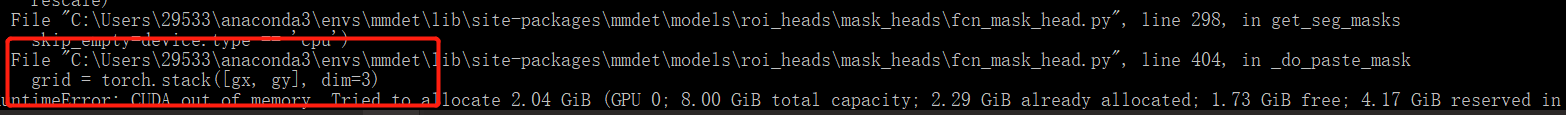

在用cascade RCNN进行训练的过程中,是不会发生OOM的,但是在做eval的时候(数据没有shuffle),每次做到第6批次数据的时候就会出现OOM如下图所示:

解决思路总结:

解决思路1: 调低batch_size

解决思路2:每次训练完清空cuda缓存

解决思路3:降低做预测时模型筛选出的预测框的数量

解决思路4:做eval时,把预测框的处理程序放在cpu和内存中

解决思路1:调低batch_size

调低batch_size到1的时候并不能解决这个问题,只会在训练的时候,显存占用稍微低一些。

结果:

还是解决不了问题

做训练的时候会发现一个问题,随着训练过程的进行,训练占用的显存越来越多。

分析:

因此想,会不会在昨晚训练之后清空一下cuda的缓存,做eval就不会超出显存OOM了? 下一个解决该问题的思路是在,清空cuda缓存上。

解决思路2:每次训练完清空cuda的缓存

清空cuda缓存可以用torch.cuda.empty_cache(),但是该代码加在哪里,也是一个问题。

可以看到报错提示红框的部分,中文翻译过来就是“训练完一个epoch之后要做的事情”:

pytorch有hook机制,并且mmdetection封装了许多API,在调用函数建立模型的时候方便,但是需要寻找对应代码去修改比较麻烦。

找"after_train_epoch"函数比较麻烦,但是要找到调用它的这行代码比较简单。于是在它调用eval函数(after_train_epoch)之前,使用torch.cuda.empty_cache(),如下图。

该epoch_base_runner.py是在前一张图中红框错误提示的位置找到的。

结果:

训练过程中内存增加的问题解决了,但是做eval的时候还是会出现OOM。后面看了一些文章,有文章提到:

如果做eval预测框过多,那么可能会发生OOM

解决思路3:降低做预测时筛选出的预测框数量

于是我在模型配置文件中降低了做eval时,模型把预测框筛选出来的数量。

把max_per_img的数量从1000调低到500

结果:

问题是解决了,但是在训练更大的模型的时候,内存也是够的,但只是做eval的时候会发生问题。

分析:

在训练更大的模型时,为了获得训练结果数据,每个epoch,都需要做eval,但是再进一步调低max_per_img的数量,可能会导致模型性能下降。

解决思路4:把做eval的预测框处理放在CPU和内存里

相较于前三种解决方法,第四种解决思路是从另外一个方向去入手。把从下图看,内存溢出的位置是在pytorch做数据处理的部分,所以想,如果把该部分数据放到CPU处理,处理完再放回GPU做数据的return,究竟能不能解决问题?

红框中相应路径的文件对应代码运行时OOM。

也有可能是这样的路径,按照实际你显示的错误为准:

也有可能是这样的路径,按照实际你显示的错误为准:

这个路径:“D:\mmdetection-2.20.0\mmdet\models\roi_heads\mask_heads\fcn_mask_head.py”

找到上图红框这个路径的这个文件,打开修改该部分如下图所示,注释的部分是原来文件中的代码:

结果:

顺利解决了问题,在做eval的过程中GPU显存没有溢出、没有大幅波动。但是处理大分辨率的图片时,速度会很慢。而且要注意内存、虚拟内存占用是否会大幅上升。如果内存不够,可以适当调大系统虚拟内存。

windows10 调大系统虚拟内存的步骤:

我硬盘够大,虚拟内存最大值调到了将近100GB

调完,按设置,按确定就可以了。

这篇关于【pytorch】mmdetection 做eval / test时弹出OOM(Out of Memory / CUDA out of memory)的解决过程记录的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!