本文主要是介绍WIN7 64 位旗舰版安装 CUDA 6.0 过程(显卡为NVIDIA GT 440),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

前言 本文是转载自网络!!!

本文讲解如何在VS 2010开发平台中搭建CUDA开发环境

当前配置:

系统:WIN7 64位

开发平台:VS 2010(zz用的 VS 2012 ,同样可运行)

显卡:英伟达G卡 (zz显卡型号为NVIDIA GT440)

CUDA版本:6.0

若配置不一样,请勿参阅本文。(注意:安装CUDA 8.0 以及 CUDA 7.5均失败,应该是显卡落后的原因。)

第一步

首先确定自己的GPU是否支持CUDA?支持CUDA哪个版本?

控制面板==>NVIDIA控制面板==>系统信息==>组件,找到NVIDIA.DLL,可查看GPU支持的CUDA版本。

下载 cuda6.0,CUDA 历史版本下载地址为 :

cuda历史各个版本下载链接

https://developer.nvidia.com/cuda-toolkit-archive

第二步

运行安装程序,弹出安装过程中转文件路径设定框:

这个路径随便填无所谓,安装完后就会自动删除的,我就直接设置为默认的。

第三步

等待系统帮你检测当前平台是否适合搭建CUDA:

第四步

检测完毕后,正式进入CUDA安装界面:

同意并继续

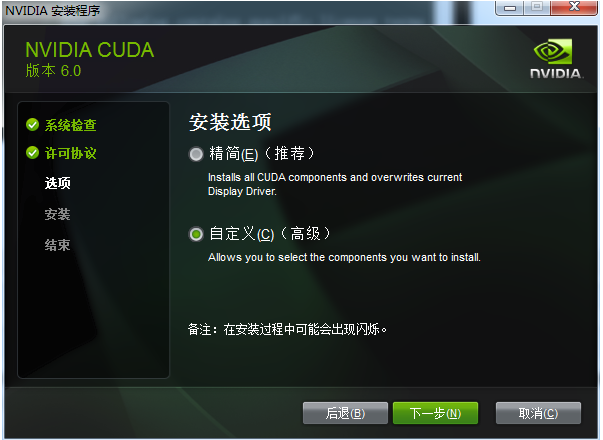

第五步

然后选择安装模式:

为了完全安装所有功能,选择自定义模式安装。

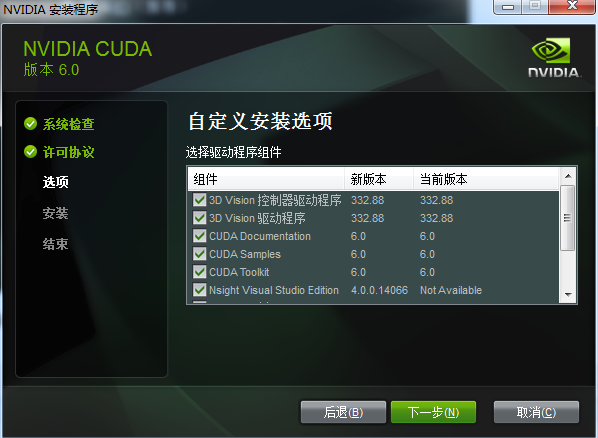

第六步

接下来勾选要安装的组件:

全部勾上

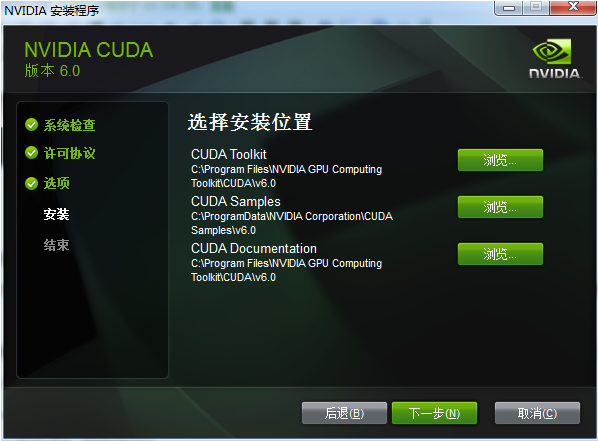

第七步

接下来要设置三个安装路径:

这三个路径安装的是什么在日后的文章中将会解释,目前先不理会,直接安装到默认路径。点击下一步之后开始正式安装。

第八步

安装完毕后,可以看到系统中多了CUDA_PATH和CUDA_PATH_V6_0两个环境变量,接下来,还要在系统中添加以下几个环境变量:(注意:可能路径不一致,以自己安装的为准)

CUDA_SDK_PATH = C:\ProgramData\NVIDIA Corporation\CUDA Samples\v6.0

CUDA_LIB_PATH = %CUDA_PATH%\lib\x64

CUDA_BIN_PATH = %CUDA_PATH%\bin

CUDA_SDK_BIN_PATH = %CUDA_SDK_PATH%\bin\x64

CUDA_SDK_LIB_PATH = %CUDA_SDK_PATH%\common\lib\x64

然后,在系统变量 PATH 的末尾添加:

;%CUDA_LIB_PATH%;%CUDA_BIN_PATH%;%CUDA_SDK_LIB_PATH%;%CUDA_SDK_BIN_PATH%;

第九步

重新启动计算机以使环境变量生效

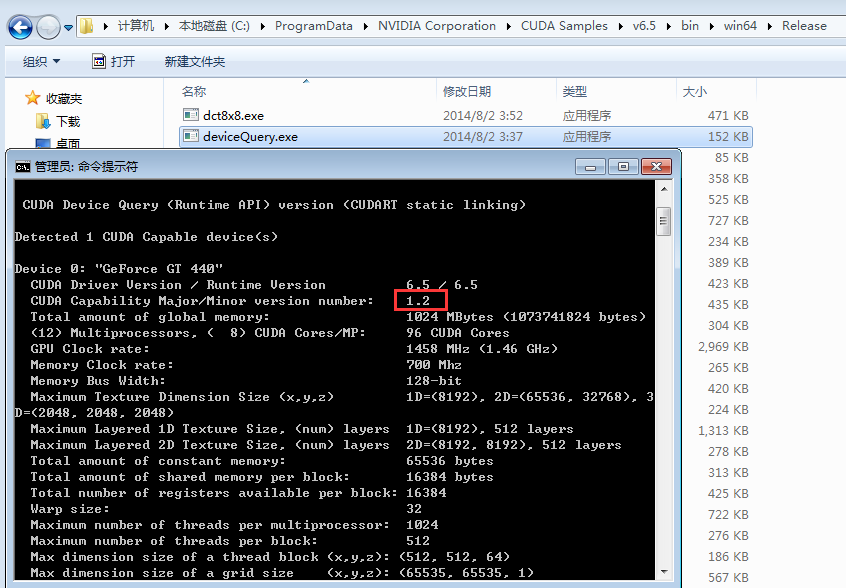

下面先找到deviceQuery.exe文件,路径一般为:C:\ProgramData\NVIDIA Corporation\CUDA Samples\v6.5\bin\win64\Release 。 直接拖到 cmd 窗口运行,如下图:

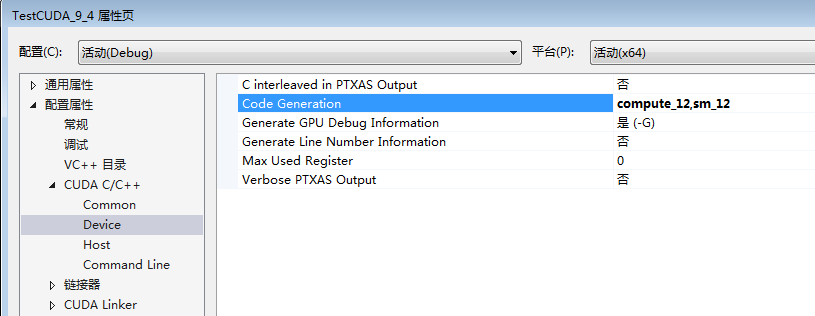

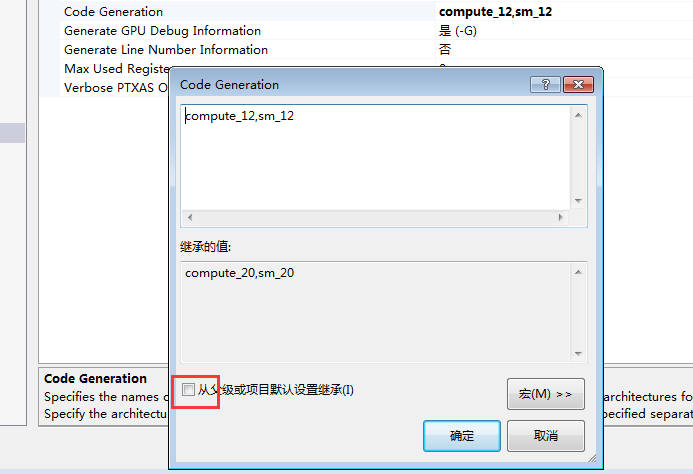

这里要注意:红框内的计算能力对我们是有用的,需要在 VS 里进行设置,具体过程如下:

1. 右键工程 --> 属性 , 找到 CUDA C/C++ --> Device

2. 点击 编辑 ,如下图,不勾选红框内选项。 我的GPU计算能力为 1.2 ,所以设置为 compute_12, sm_12 ,根据你的GPU计算 能力进行设置。

有两种方法可进行CUDA与VS间的配置,下面先说第一种简单的方法:

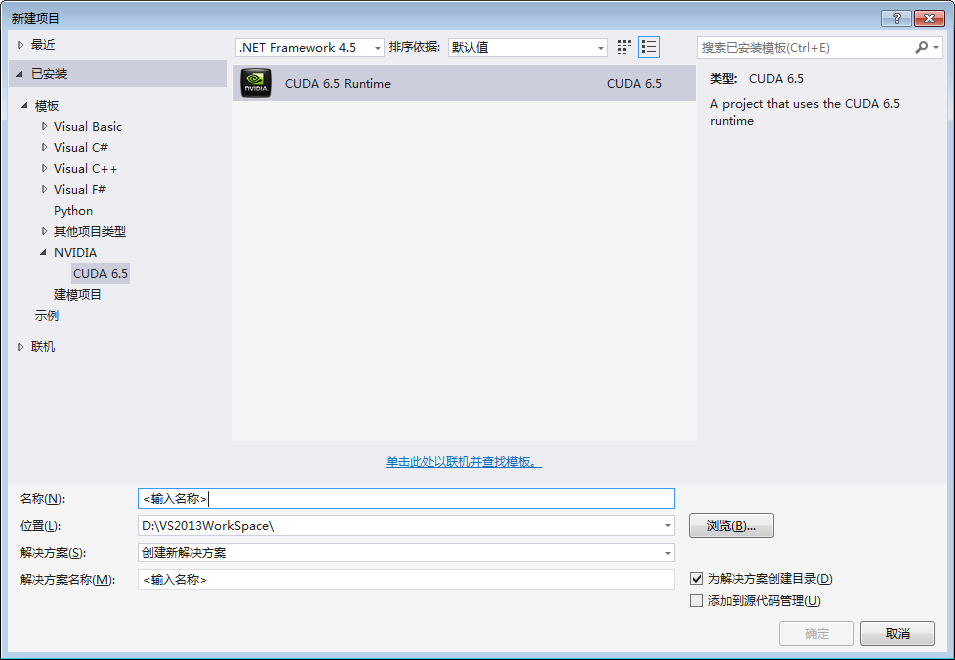

第十步

打开VS,文件 -> 新建 -> 项目。选择CUDA项目,如下图

VS会自动为你配置好环境,并且会自动创建一个 kernel.cu 例子文件。

第二种方法如下,有点麻烦:

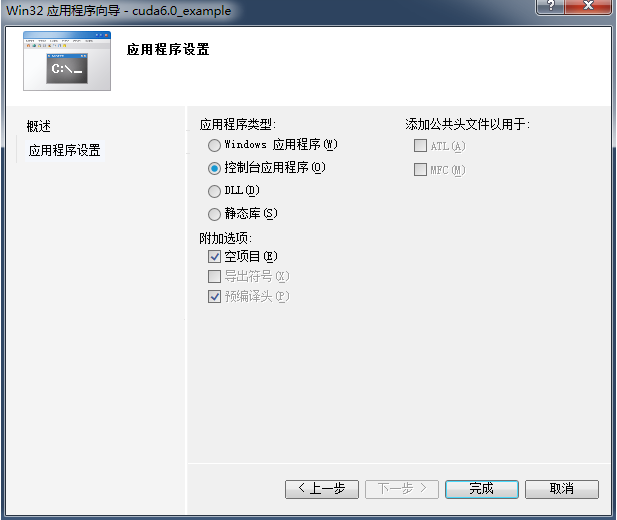

第十步

打开VS2010并建立一个空的win32控制台项目:(VS 2012 同样可以这样配置)

附加选项那里请把“空项目”打钩:

第十一步

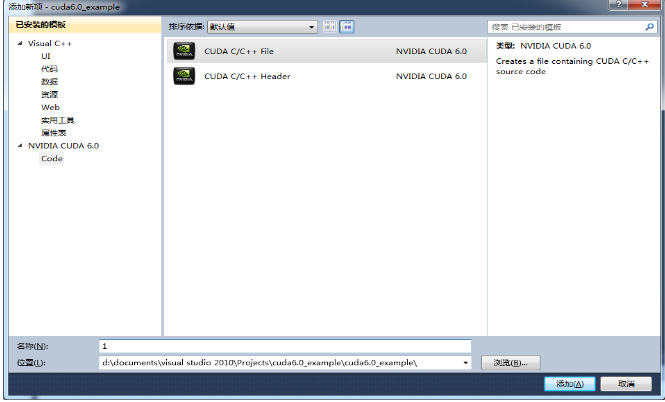

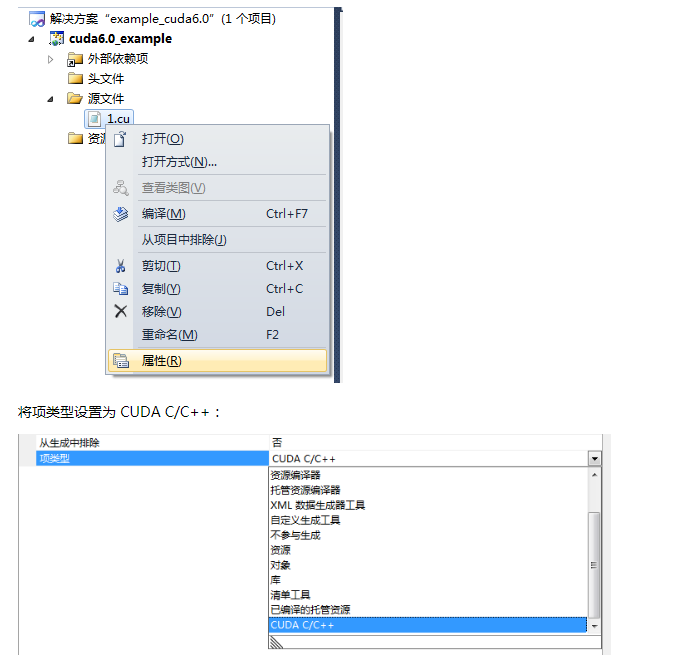

右键源文件 -> 添加 -> 新建项

在打开的对话框中选择新建一个CUDA格式的源文件 (如果你只是要调用 CUDA 库编写程序而不需要自行调用核函数分配块,线程的话也可以就建立 .cpp 的源文件):

第十二步

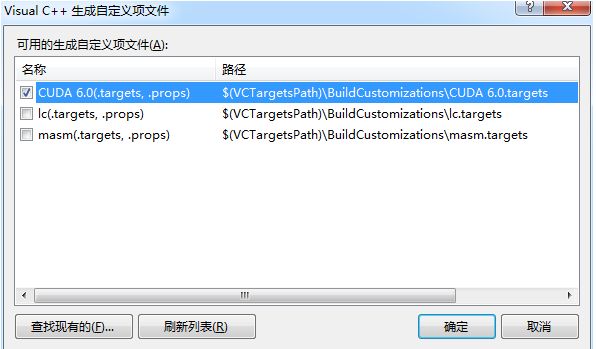

右键工程 -> 生成自定义

在弹出的对话框中勾选“CUDA 6.0 *****"选项:

第十三步

右键项目 -> 属性 -> 配置属性 -> VC++目录,添加以下两个包含目录:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v6.0\include

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v6.0\common\inc

再添加以下两个库目录:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v6.0\lib\x64

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v6.0\common\lib\x64

第十四步

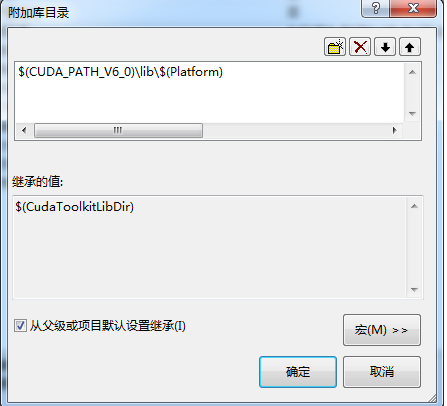

右键项目 -> 属性 -> 配置属性 ->连接器 -> 常规 -> 附加库目录,添加以下目录:

$(CUDA_PATH_V6_0)\lib\$(Platform)

如下图所示:

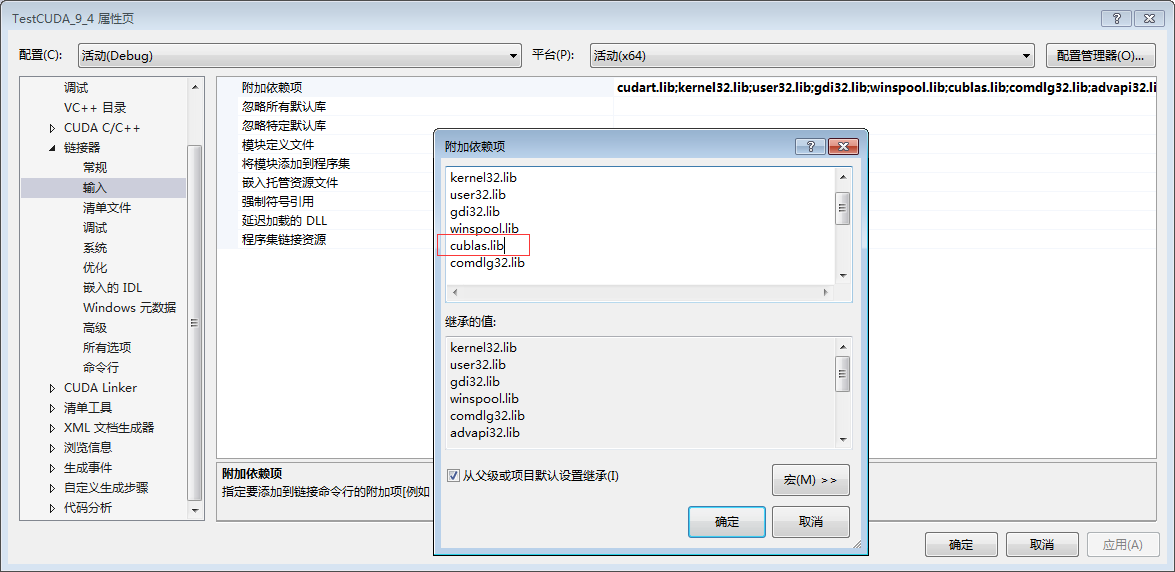

第十五步

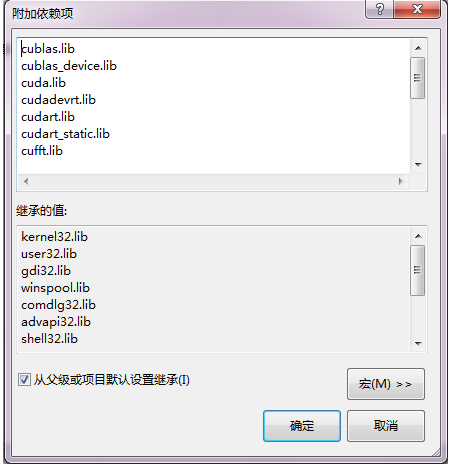

右键项目 -> 属性 -> 配置属性 ->连接器 -> 输入 -> 附加依赖项,添加以下库:

cublas.lib

cublas_device.lib

cuda.lib

cudadevrt.lib

cudart.lib

cudart_static.lib

cufft.lib

cufftw.lib

curand.lib

cusparse.lib

nppc.lib

nppi.lib

npps.lib

nvblas.lib (32位系统请勿附加此库!)

nvcuvenc.lib

nvcuvid.lib

OpenCL.lib

如下图所示:

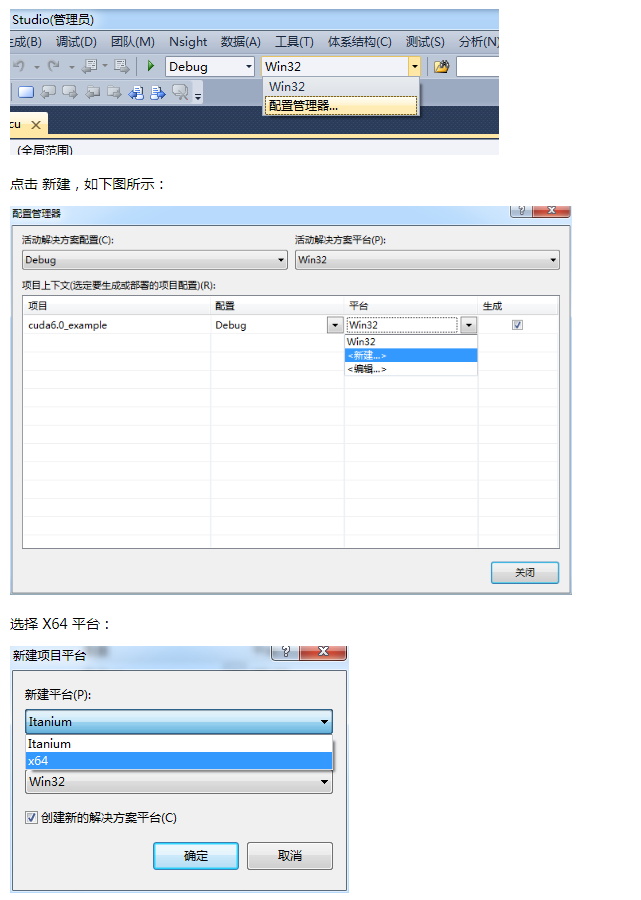

第十六步

右键项目 -> 属性,如下图所示:

第十七步

打开配置管理器,如下图所示:

好了,至此平台已经完全搭建完毕,可用以下代码进行测试:

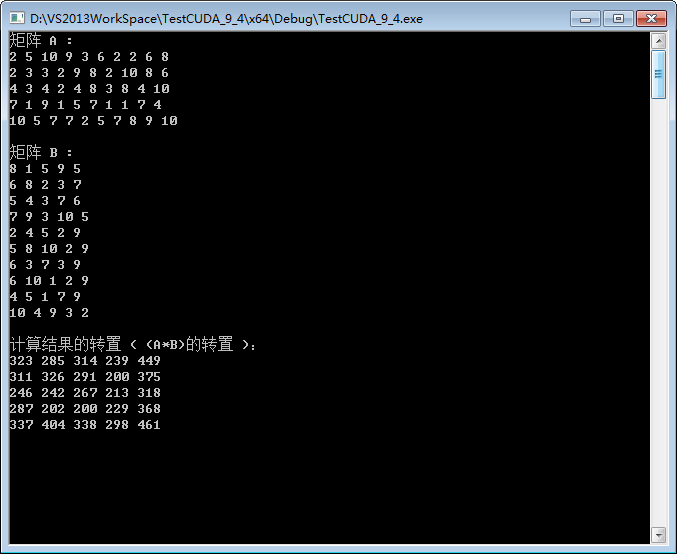

// CUDA runtime 库 + CUBLAS 库 #include "cuda_runtime.h" #include "cublas_v2.h" #include <time.h> #include <iostream> using namespace std; // 定义测试矩阵的维度 int const M = 5; int const N = 10; int main() { // 定义状态变量 cublasStatus_t status; // 在 内存 中为将要计算的矩阵开辟空间 float *h_A = (float*)malloc (N*M*sizeof(float)); float *h_B = (float*)malloc (N*M*sizeof(float)); // 在 内存 中为将要存放运算结果的矩阵开辟空间 float *h_C = (float*)malloc (M*M*sizeof(float)); // 为待运算矩阵的元素赋予 0-10 范围内的随机数 for (int i=0; i<N*M; i++) { h_A[i] = (float)(rand()%10+1); h_B[i] = (float)(rand()%10+1); } // 打印待测试的矩阵 cout << "矩阵 A :" << endl; for (int i=0; i<N*M; i++){ cout << h_A[i] << " "; if ((i+1)%N == 0) cout << endl; } cout << endl; cout << "矩阵 B :" << endl; for (int i=0; i<N*M; i++){ cout << h_B[i] << " "; if ((i+1)%M == 0) cout << endl; } cout << endl; /* ** GPU 计算矩阵相乘 */ // 创建并初始化 CUBLAS 库对象 cublasHandle_t handle; status = cublasCreate(&handle); if (status != CUBLAS_STATUS_SUCCESS) { if (status == CUBLAS_STATUS_NOT_INITIALIZED) { cout << "CUBLAS 对象实例化出错" << endl; } getchar (); return EXIT_FAILURE; } float *d_A, *d_B, *d_C; // 在 显存 中为将要计算的矩阵开辟空间 cudaMalloc ( (void**)&d_A, // 指向开辟的空间的指针 N*M * sizeof(float) // 需要开辟空间的字节数 ); cudaMalloc ( (void**)&d_B, N*M * sizeof(float) ); // 在 显存 中为将要存放运算结果的矩阵开辟空间 cudaMalloc ( (void**)&d_C, M*M * sizeof(float) ); // 将矩阵数据传递进 显存 中已经开辟好了的空间 cublasSetVector ( N*M, // 要存入显存的元素个数 sizeof(float), // 每个元素大小 h_A, // 主机端起始地址 1, // 连续元素之间的存储间隔 d_A, // GPU 端起始地址 1 // 连续元素之间的存储间隔 ); cublasSetVector ( N*M, sizeof(float), h_B, 1, d_B, 1 ); // 同步函数cudaThreadSynchronize();// 传递进矩阵相乘函数中的参数,具体含义请参考函数手册。float a=1; float b=0;// 矩阵相乘。该函数必然将数组解析成列优先数组cublasSgemm (handle, // blas 库对象 CUBLAS_OP_T, // 矩阵 A 属性参数CUBLAS_OP_T, // 矩阵 B 属性参数M, // A, C 的行数 M, // B, C 的列数N, // A 的列数和 B 的行数&a, // 运算式的 α 值d_A, // A 在显存中的地址N, // ldad_B, // B 在显存中的地址M, // ldb&b, // 运算式的 β 值d_C, // C 在显存中的地址(结果矩阵)M // ldc);// 同步函数cudaThreadSynchronize();// 从 显存 中取出运算结果至 内存中去cublasGetVector (M*M, // 要取出元素的个数sizeof(float), // 每个元素大小d_C, // GPU 端起始地址1, // 连续元素之间的存储间隔h_C, // 主机端起始地址1 // 连续元素之间的存储间隔);// 打印运算结果cout << "计算结果的转置 ( (A*B)的转置 ):" << endl;for (int i=0;i<M*M; i++){cout << h_C[i] << " ";if ((i+1)%M == 0) cout << endl;}// 清理掉使用过的内存free (h_A);free (h_B);free (h_C);cudaFree (d_A);cudaFree (d_B);cudaFree (d_C);// 释放 CUBLAS 库对象cublasDestroy (handle);getchar();return 0;}

运行结果

PS: 矩阵元素是随机生成的

小结

不论什么开发环境的搭建,都应该确保自己电脑的硬件配置,软件版本和参考文档的一致,这样才能确保最短的时间内完成搭建,进入到具体的开发环节。

注意:版本问题也要注意,硬件可能不支持 CUDA 最新版本!!

!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!

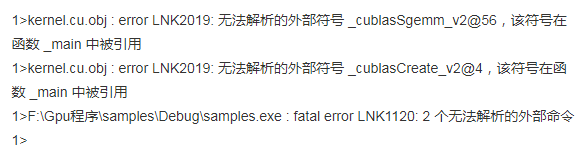

下面是一些常见的错误及解决办法

一、错误如下图:

解决办法:没有链接cublas.lib库,如下图,在附加依赖项中添加 cublas.lib 库即可。

二、 其他错误如:计算结果不正确、编译通过但允许错误等,请参考 第九步 中 compute_20, sm_20的设置。

其他错误后续更新中......................

这篇关于WIN7 64 位旗舰版安装 CUDA 6.0 过程(显卡为NVIDIA GT 440)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!