本文主要是介绍[论文阅读]AdvMIL: Adversarial multiple instance learning for the survival analysis on whole-slide images,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

AdvMIL: Adversarial multiple instance learning for the survival analysis on whole-slide images

- 论文信息

- 摘要

- 引言

- 2. 相关工作

- 2.1. WSI的生存分析

- 2.2. 对抗性时间到事件分析

- 3. 方法

- 3.1. 准备工作

- 3.2. 对抗性多实例学习

- 3.3. k折交叉半监督学习

- 4. 实验和结果

- 4.1. 实验设置

- 4.2. 结果和分析

- 4.3. 消融研究和分析

- 4.4. 鲁棒性分析

- 4.5. 案例研究与分析

- 5. 讨论

- 6. 结论

- 总结

论文信息

这是MIA期刊(SCI 一区)在2023年10月份接收的关于生存分析的文章,主要讲述的是将对抗学习应用于MIL中,从而实现对生存分析的预测。论文题目为AdvMIL: Adversarial multiple instance learning for the survival analysis on whole-slide images

论文地址为:https://www.sciencedirect.com/science/article/pii/S1361841523002803

论文代码地址为:https://github.com/liupei101/AdvMIL

摘要

组织学全视野数字切片图像(WSIs)的生存分析是估计患者预后的最重要手段之一。尽管已经为像素非常大(gigapiexl)的WSIs开发了许多弱监督深度学习模型,但它们的潜力通常受到经典生存分析规则和半监督学习要求的限制。因此,这些模型只为患者提供完全确定的时间到事件点估计,他们只能从目前小规模的标记WSI数据中学习。为了解决这些问题,我们提出了一种新颖的对抗性多实例学习 (AdvMIL) 框架。该框架基于对抗性时间到事件建模,并集成了多实例学习 (MIL),这对于 WSI 表示学习来说是非常必要的。这是一个即插即用的方法,因此大多数现有的基于 MIL 的端到端方法可以通过应用该框架轻松升级,从而提高生存分布估计和半监督学习的能力。我们广泛的实验表明,AdvMIL 不仅可以以相对较低的计算成本将性能提升引入主流 WSI 生存分析方法,还可以使这些方法能够通过半监督学习有效地利用未标记的数据。此外,据观察,AdvMIL 可以帮助提高模型对补丁遮挡和两个代表性图像噪声的鲁棒性。所提出的 AdvMIL 框架可以通过其新颖的对抗性 MIL 范式促进计算病理学中生存分析的研究。

引言

生存分析,也称为时间到事件分析,是分析事件时间数据的主要统计方法之一(Cox, 1975; Kalbfleisch and Prentice, 2011)。医学领域通常采用它来分析临床材料并帮助医生了解疾病预后(Wulczyn et al., 2021)。组织学全视野数字切片图像 (WSI) 是这些材料之一。它是通过用高端显微镜扫描组织载玻片(毫米级)产生的。与其他人口统计和基因组学等材料相比,数字化WSIs可以在大像素分辨率(Zarella et al.,2018)上呈现独特的分层视图,例如组织表型、肿瘤微环境和细胞形态。这些丰富多样的微观信息可以为肿瘤疾病的预后提供有价值的线索(Yu et al., 2016; Chen et al., 2022b),有助于改善患者管理和疾病结果(Nir et al., 2018; Kather et al., 2019; Skerede et al., 2020)。

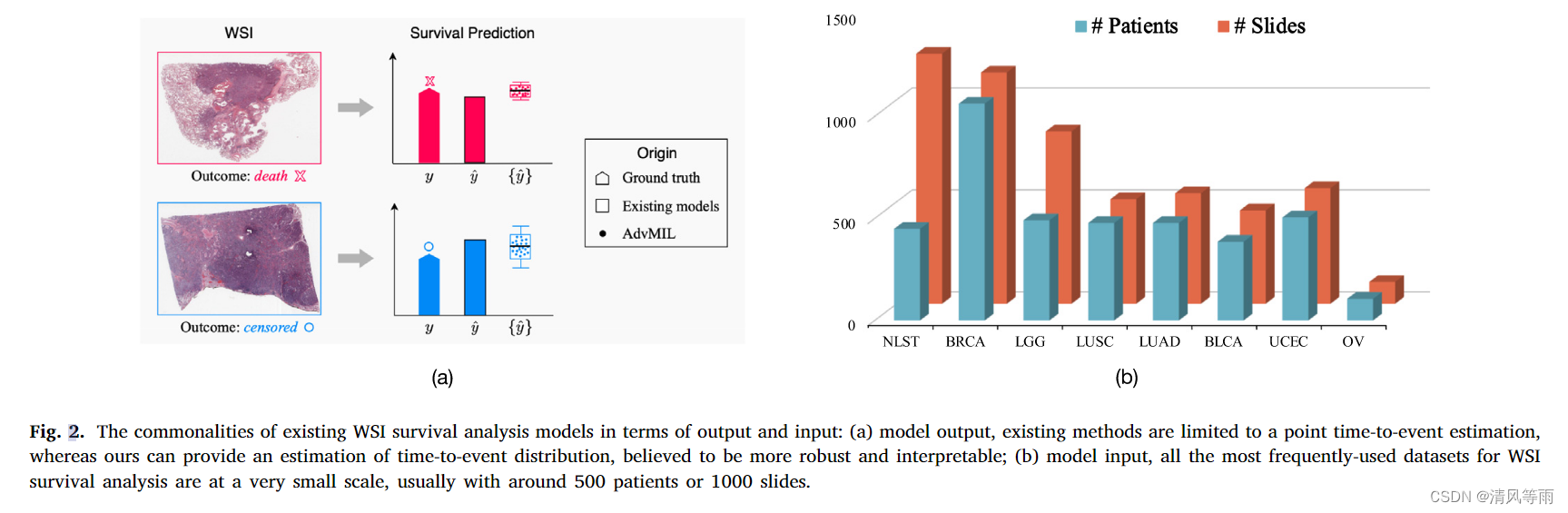

与常规自然图像不同,组织学WSIs通常具有极高的分辨率,例如40,000 × 40,000像素。这对WSI的分析和建模,特别是对WSI的全局表示学习提出了很大的挑战。为了应对这些挑战,许多方法遵循弱监督框架,分为三个阶段:(i) WSI切片(称为实例),(ii)实例级特征提取,(iii)实例级表示学习(Chen et al.,2022a;Ghaffari Laleh et al.,2022)。在过程中,该框架通过构建实例相关性、学习实例级嵌入和聚合实例级嵌入来获得全局表示,如图1所示。它通常被描述为嵌入级多实例学习(MIL) (Ilseet al.,2018;Carbonneau et al.,2018)。根据实例相关性的结构,主流的MIL生存分析方法大致可以分为三类: 基于聚类的(Yao et al.,2020;Shao et al.,2021),基于图的(Li et al.,2018;Chen et al., 2021)和基于序列的(Huang et al.,2021;Shen et al.,2022;Liu et al.,2023)。虽然千兆像素wsi的生存分析方法有很多种,但这些方法通常受到经典生存分析规则的限制,这些规则包括一定的关于风险函数的生存假设(Cox, 1975;Kalbfleisch and Prentice, 2011;Liu et al.,2021)和离散时域的似然估计Zadeh and Schmid(2021)。这导致了它们的点生存估计。然而,与图2(a)中所示的分布估计的输出相比,点估计的输出代表了一个完全确定的结果,被认为缺乏预测鲁棒性和可解释性(Lakshminarayanan et al.,2017;Kendall and Gal, 2017;Nazarovs et al.,2022;Linmans et al.,2023)。此外,在输入方面,所有这些方法都使用切片级标签训练自己的网络,遵循全监督学习设置。这意味着他们的训练需要足够的标记数据,以使模型很好地推广到看不见的样本。然而,在目前可公开获得的WSI数据集中,患者数量通常限制在500左右,如图2(b)所示。相比之下,深度学习的标准数据集,如ImageNet (Deng et al.,2009)通常包含超过10,000个样本。这一事实表明,目前基于wsi的生存分析仍然处于一个小数据体系中,这被认为对深度学习模型的泛化能力有不利影响(Chapelle et al.,2009;Zhou, 2021;Marini et al.,2021)。

生成对抗网络(GAN) (Goodfellow et al.,2014a)提供了缓解这些问题的方法。一方面,GAN是一种生成模型,能够通过隐式采样估计复杂数据分布,自然适合预测分布建模。另一方面,GAN的生成器-鉴别器结构可以将假(或未标记)样本作为输入,正好满足半监督学习的需要(Goodfellow, 2016)。这样,基于gan的模型就不局限于特定的点估计和全监督学习;相反,它们提供了稳健的分布估计,值得注意的是,它们从未标记的数据中学习以增强其泛化能力(Springenberg, 2015;Salimans et al.,2016;Miyato et al., 2018;Li et al.,2021)。

在过去的几年里,GAN引起了极大的关注,并激发了许多有趣的应用,而不仅仅是图像生成(Gui et al.,2021)。生存分析就是其中之一。首先将其与条件GAN (cGAN) (Mirza和Osindero, 2014)相结合,称为对抗性时间到事件模型,以便开发用于分析临床表格数据的一般无假设生存模型(Chapfuwa等人,2018,2020)。随后,将该通用模型成功地扩展到卷积神经网络中,用于CT图像的时间到事件分析(Uemura et al., 2021)。这些模型已显示出良好的结果,特别是其预测精度和鲁棒性的优势。我们强烈期待GAN进一步应用于计算病理学的生存分析,因为目前对WSI数据的生存分析仍然面临着上述传统建模范式的问题,即经典的生存分析规则和全监督学习。

在这项研究中,我们提出了一种新的框架,用于对大像素整张数字切片片图像进行生存分析,称为对抗多实例学习(AdvMIL)。该框架不再依赖于时间到事件建模的经典范式; 相反,它基于对抗性时间到事件建模,并集成了对WSI表示学习非常必要的多实例学习。因此,大多数现有的嵌入级MIL网络可以很容易地集成到AdvMIL框架中,从而在不引入额外技术的情况下获得生存分布估计和半监督学习的能力。在三个公开可用的WSI数据集上的结果验证了AdvMIL通常可以以相对较低的计算成本带来主流MIL网络的性能改进;最重要的是,它可以使当前的模型通过半监督学习有效地利用未标记的WSI数据。

这项工作的主要贡献如下。

- 我们提出了一个对抗多实例学习(AdvMIL)框架,用于对大像素整张数字切片图像进行生存分析。大多数现有的基于mil的WSI生存分析方法都可以通过应用该框架进行升级,从而获得生存分布估计和半监督学习的能力。据我们所知,提出的AdvMIL是第一个在计算病理学中采用GAN进行生存分析的细胞。

- 通过AdvMIL的两个关键组件:生成器中的MIL编码器和鉴别器中的区域级实例投影(RLIP)融合网络,我们演示了如何将GAN与MIL范式结合起来对大像素wsi进行生存分析。

- 我们进一步探讨了如何用我们的AdvMIL框架以半监督的方式训练现有的WSI模型。此外,我们提出了𝑘-fold训练策略,使半监督学习更有效。

- 通过对来自三个公开数据集的3101个wsi进行大量实验,我们验证了AdvMIL在预测性能、半监督学习和模型鲁棒性方面的有效性。实证结果表明,AdvMIL可以通过其对抗性MIL范式促进计算病理学中生存分析的发展。

2. 相关工作

2.1. WSI的生存分析

从数字化的大像素wsi预测事件时间是近年来一个活跃的研究课题。本文回顾了一些具有代表性的研究成果,重点介绍了它们的网络和生存损失函数。

(1)多实例学习网络

为了从大像素wsi中学习全局表示,MIL(见图1)被广泛应用于端到端深度学习模型中(Ghaffari Laleh et al.,2022)。这些模型通常为不同的补丁相关性使用不同的主干,例如,用于聚类的全连接网络,用于图的图卷积网络(Kipf和Welling, 2016),以及基于序列的Attention-MIL (Ilse et al.,2018)或Transformers (Vaswani et al.,2017; Dosovitskiy et al.,2020)。从统一的角度来看,这些网络首先沿着补丁相关性转移补丁(实例)特征,学习非局部补丁级嵌入,然后通过将这些嵌入池化为全局特征向量来提取WSI表示。

(2)生存损失函数

大多数模型对风险函数(Kalbfleisch and Prentice, 2011)进行生存分析。Cox比例风险(Cox, 1975)和加速失效时间(Wei, 1992)是其中最经典的两个假设。基于这两个假设的损失函数由于其简单性和可解释性,在WSI生存建模中非常流行。此外,Chen等人(2021,2022a)和Liu等人(2023)采用基于极大似然估计的生存损失函数进行WSI分析,该函数在表格数据上具有良好的校准和判别能力(Zadeh and Schmid, 2021)。它需要生存时间的预离散化,尽管它是无假设的。这些函数是从一类判别模型中派生出来的,通常会导致限制-时间到事件的点估计。

2.2. 对抗性时间到事件分析

(1)生成对抗网络

GAN是一种强大的生成模型(Goodfellow et al.,2014a),具有广泛的视觉应用(Gui et al.,2021),例如图像生成、去噪和编辑。此外,它也被广泛研究用于执行半监督学习(Springenberg, 2015; Carmon et al.,2019)或增强深度学习网络的鲁棒性(Goodfellow et al.,2014b;Miyato et al.,2018)。继GAN之后,首先提出了条件GAN (cGAN) (Mirza and Osindero, 2014),通过合并条件标签来提高图像生成的质量。基于cGAN,已经做出了许多努力来更好地利用条件标签,例如投影鉴别器(Miyato和Koyama, 2018),最初是为常规自然图像的一般应用而开发的。作为cGAN的代表工作,投影鉴别器在输入的最终嵌入上投影一个条件向量。

(2)基于条件GAN的时间到事件建模

由于cGAN可以捕获复杂的数据分布(Goodfellow et al.,2014a),因此在DATE (Chapfuwa et al.,2018)中首次看到了这一点。与cGAN一样,DATE也使用了一个生成器-鉴别器架构。具体来说,表示为𝐺的生成器估计时间到事件的条件分布 t ^ = G ( x , N ^ ) ∼ P t ∣ x , ( 1 ) \hat{t}=G(x,\hat{\mathcal{N}})\sim P_{t|x},\quad\quad\quad\quad(1) t^=G(x,N^)∼Pt∣x,(1)其中x表示一个条件输入, N \mathcal{N} N表示一个噪音输入。D表示为鉴别器,用于识别真实输入 ( x , t ) (x,t) (x,t)或者虚假输入 ( x , t ^ ) (x, \hat{t}) (x,t^),其中t是时间到时间w.r.t. 𝑥.的标签。这种对抗性生成方式使DATE能够通过从𝐺隐式采样来估计时间到事件的分布,而不是通过学习和优化先验分布的参数。

DATE是一种一般的无假设时间事件分析模型,最初应用于临床表格数据。在DATE的框架下,pix2surv (Uemura et al.,2021)进一步利用卷积网络对CT图像进行了开发。基于表格数据和CT图像的时间到事件建模研究得益于生成建模范式,并显示出更好的预测准确性和鲁棒性。然而,在病理性WSIs上,它仍然是开放的。此外,如何进行半监督学习以及半监督学习对生存分析是否有效,在DATE和pix2surv中都没有进行研究。

在第3节中,我们展示了如何将对抗性时间到事件建模的框架推广到MIL,以便在大像素wsi上执行生存预测任务。

3. 方法

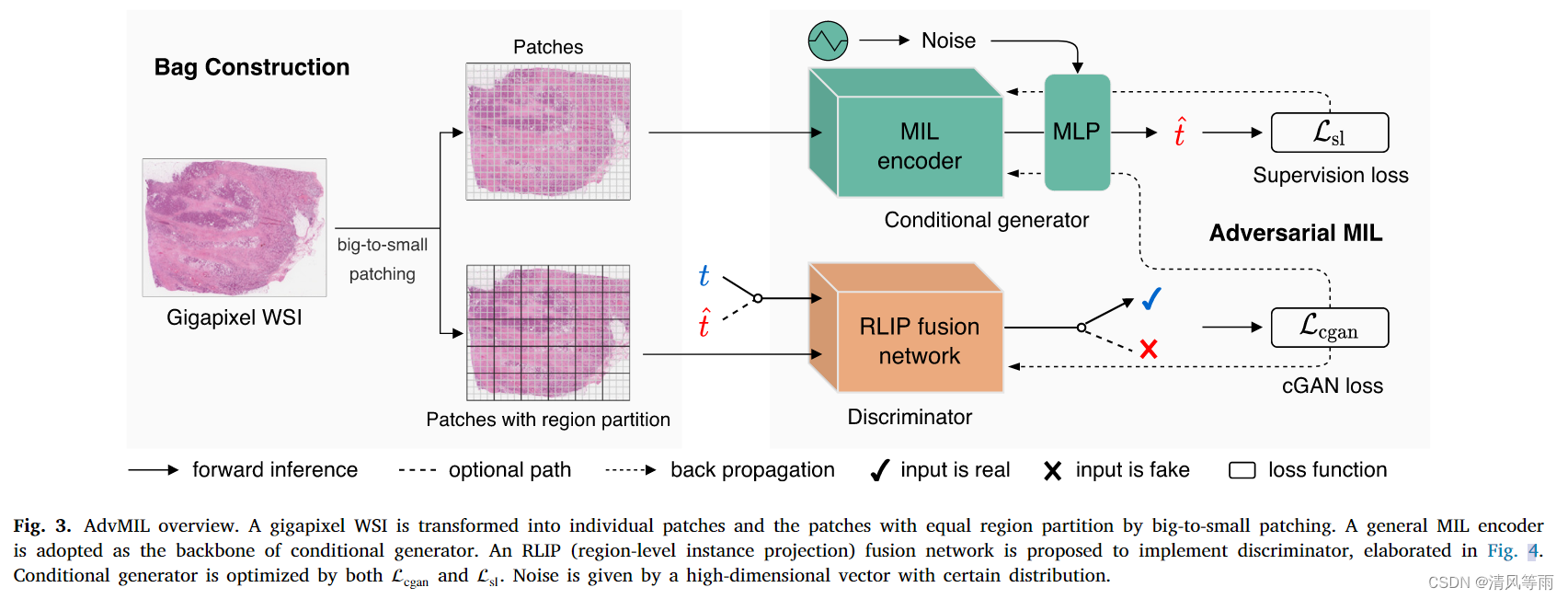

我们在图3中展示了我们的对抗多实例学习(AdvMIL)框架。简而言之,AdvMIL通过两个核心将对抗时间到事件建模推广到MIL:生成器中的MIL编码器和判别器中的区域级实例投影(RLIP)融合网络。在本节结束时,我们描述了AdvMIL的半监督学习,以及𝑘-fold训练策略。

3.1. 准备工作

(1) wsi包的构建

如图3所示,我们在包结构中准备了两种类型的patch: (i)没有任何特殊结构的单个patch用于我们的生成器,(ii)具有相等区域划分的patch用于我们的鉴别器。这两种类型只是在组织补丁的方式上有所不同。

具体来说,我们设计了一个从大到小的连续切片方案。该方案不仅可以获得上述两种类型的patch,还可以在后台对部分patch进行过滤,从而节省计算成本。也就是说,对于一个WSI,我们首先将其放大倍数固定为𝑓× (20×是典型设置),并将其切割成大区域,每个区域的大小为 η a × η a \eta a \times\eta a ηa×ηa像素。同时,一些背景区域被丢弃。然后,我们进一步将每个大区域分割成 η 2 \eta^2 η2个小补丁(patches)(设 s = η 2 s=\eta^2 s=η2),每个小块的大小为 a × a a\times a a×a像素。最后,我们对所有补丁应用特征提取器,得到一个补丁特征包。

在上述预处理步骤之后,我们用一个公式来表示来自一个患者的补丁特征的最终包,其为: X ∈ R m × c : { x j ∈ R c } j = 1 j = m , ( 2 ) X\in\mathbb{R}^{m\times c}:\left\{x_j\in\mathbb{R}^c\right\}_{j=1}^{j=m},\quad\quad\quad(2) X∈Rm×c:{xj∈Rc}j=1j=m,(2)其中m是X的实例(补丁)数量,c是实例特征的维数, x j x_j xj是第j个实例特征。一方面,这个给定的X可以作为我们生成器的单个补丁特征。另一方面,它也可以看作是我们鉴别器的带有区域划分的patch特征,表示为 X r ∈ R m × c : { x τ ∈ R s × c } τ = r 1 τ = r m s , ( 3 ) X_r\in\mathbb{R}^{m\times c}:\left\{x_\tau\in\mathbb{R}^{s\times c}\right\}_{\tau=r_1}^{\tau=r_{\frac ms}},\quad\quad\quad(3) Xr∈Rm×c:{xτ∈Rs×c}τ=r1τ=rsm,(3)其中 { r 1 , r 2 , … , r m s \{ r_1, r_2, \dots, r_{\frac ms} {r1,r2,…,rsm表示X中的第m/s个区域, τ \tau τ是一个区域符号, X τ X_\tau Xτ表示区域 τ \tau τ中的实例特征。请注意,不同患者的𝑚可能是不同的。当𝑓= 20时,其常用值通常大于1000。

(2)符号约定

我们将生存数据表示为 D = { ( X i , t i , δ i ) } i = 1 i = N \mathcal{D}=\{(X_i, t_i, \delta_i)\}_{i=1}^{i=N} D={(Xi,ti,δi)}i=1i=N,其中 X i , τ i , δ i X_i, \tau_i, \delta_i Xi,τi,δi分别表示包的特征、后续时间和第i个患者的检查状态。对于没有进行检查(即有事件发生)的患者,我们用 D e = { ( X i , t i ) ∣ δ i = 0 f o r i = 1 , 2 , ⋯ , N } \mathcal{D}_e=\{(X_i, t_i)| \delta_i = 0 for i = 1, 2, \cdots, N\} De={(Xi,ti)∣δi=0fori=1,2,⋯,N}表示。类似地,对其他经过检查(即没有事件发生)的患者数据记为 D n e = { ( X i , t i ) ∣ δ i = 1 f o r i = 1 , 2 , ⋯ , N } \mathcal{D}_{ne}=\{(X_i, t_i)| \delta_i = 1 for i = 1, 2, \cdots, N\} Dne={(Xi,ti)∣δi=1fori=1,2,⋯,N}。对于 δ i = 1 \delta_i = 1 δi=1的第i个患者,我们只知道其真的时间到事件的时间严格晚于 t i t_i ti。

3.2. 对抗性多实例学习

接下来,我们以多实例学习的形式提出我们的AdvMIL框架。

(1)生成器

为了使我们的框架适应MIL并与现有的WSI生存分析网络兼容,我们实现了一个具有通用MIL编码器和MLP(多层感知器)层的新生成器。采用该编码器提取全局包表示。它可以是输出包级特征向量的任何嵌入级MIL网络,例如,基于聚类的、基于图的或基于序列的。MLP层用于处理包级向量和噪声输入,产生时间到事件的估计。

对于给定的X(来自一位患者的包),我们将其时间到事件估计表示为 t ^ = G ( X , N ) , N ∼ P n = U ( 0 , 1 ) , ( 4 ) \hat{t}=G(X,\mathcal{N}),\quad\mathcal{N}\sim P_n=\mathbf{U}(0,1),\quad\quad\quad(4) t^=G(X,N),N∼Pn=U(0,1),(4)其中 N \mathcal{N} N是一个表示均匀分布的噪声的变量, G表示一个生成器。通过这种方式,G通过从 N \mathcal{N} N采样隐式地估计时间到事件的分布。预计G的分布输出与给定X上的时间到事件的实际条件分布相匹配,即 P t ∣ X P_{t|X} Pt∣X。根据最小条件下概率论中的噪声外包引理(Kallenberg, 2002),可以保证𝐺的存在性(Zhou et al., 2022),即, ∃ G , s . t . t ^ = G ( X , N ) ∼ P t ∣ X . ( 5 ) \exists G,s.t.\hat{t}=G(X,\mathcal{N})\sim P_{t|X}.\quad\quad\quad(5) ∃G,s.t.t^=G(X,N)∼Pt∣X.(5)由于 N \mathcal{N} N为自变量,可将式(5)进一步写成其联合分布形式: ( X , G ( X , N ) ) ∼ P ( X , t ) . ( 6 ) (X, G(X, \mathcal{N}))\sim P_{(X,t)}.\quad\quad\quad(6) (X,G(X,N))∼P(X,t).(6)G可以通过优化cGAN (Mirza and Osindero, 2014)来确定,其中X作为G的条件输入。

(2)鉴别器

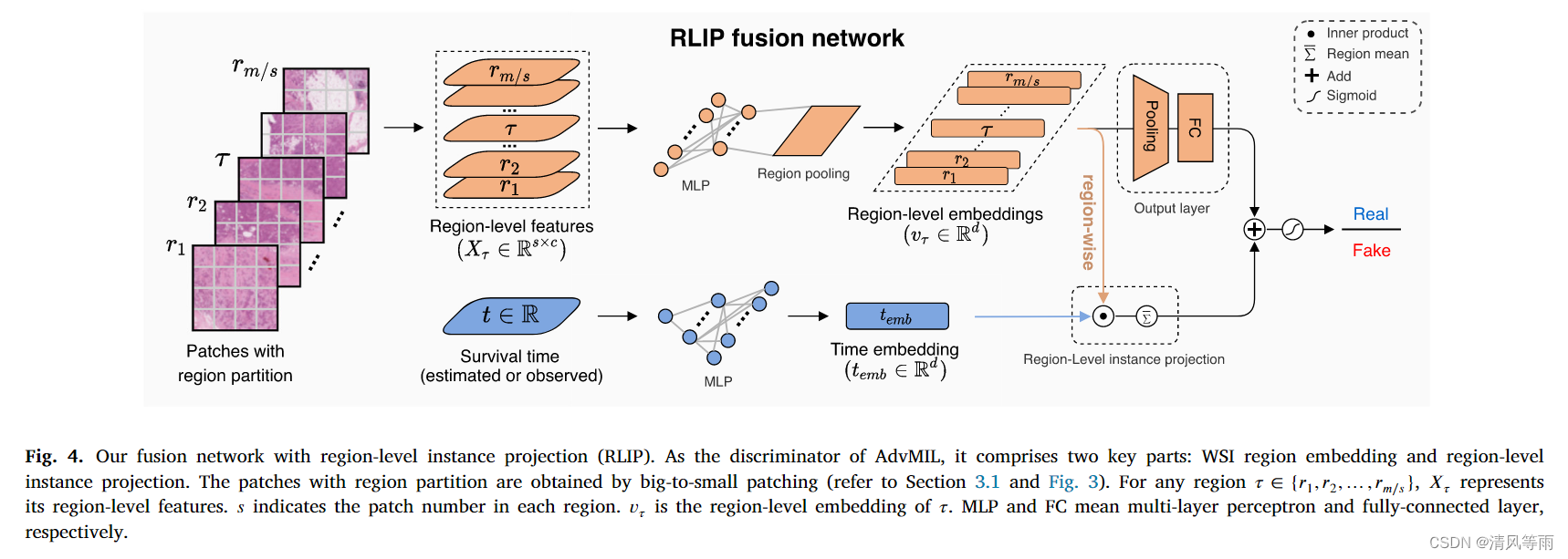

表示为D的鉴别器旨在区分从G中采样的假对 ( X , t ^ ) (X, \hat{t}) (X,t^)和从真实数据分布中采样的真实对 ( X , t ) (X,t) (X,t)。然而,现有的判别器无法直接实现这一目的,因为D需要有效地处理给定的X与一个极大的矩阵和时间t与单个真实值的融合。为了解决这个问题,我们提出了一种具有区域级实例投影(RLIP)的新型融合网络,如图4所示。它可以处理大矩阵和标量值的融合,灵感来自投影鉴别器(Miyato和Koyama, 2018)。而且,我们对D的实现不会给现有主流MIL模型带来太多额外的计算成本。

我们的RLIP融合网络在图4中有诠释。在一个大到小的切片之后(在第3.1节中有描述,并且在图3中有展示),区域部分的实例特征, { X τ ∈ R s × c } τ = r 1 τ = r m s \{X_\tau \in \mathbb{R}^{s\times c}\}_{\tau = r_1}^{\tau=r_{\frac ms}} {Xτ∈Rs×c}τ=r1τ=rsm, 将会在每个区域类池化形成区域级嵌入特征 X e m b : { v τ ∈ R d } τ = r 1 τ = r m s X_{emb}: \{v_\tau \in \mathbb{R}^d\}_{\tau = r_1}^{\tau=r_{\frac ms}} Xemb:{vτ∈Rd}τ=r1τ=rsm。这是由一个区域嵌入层 ϕ : R s × c → R d \phi:\mathbb{R}^{s\times c}\to\mathbb{R}^d ϕ:Rs×c→Rd实现的。随后,利用MLP φ : R → R d \varphi:\mathbb{R}\to\mathbb{R}^d φ:R→Rd从生存时间 t ∈ R t\in\mathbb{R} t∈R计算时间嵌入 t e m b ∈ R d t_{emb}\in \mathbb{R}^d temb∈Rd。这次的嵌入和区域级嵌入通过区域内积和均值运算进行融合,表示为 y f u s i o n = 1 m / s ∑ υ τ ∈ X e m b υ τ ⋅ t e m b , ( 7 ) y_{fusion}=\frac{1}{\boldsymbol{m}/s}\sum_{\upsilon_{\tau}\in X_{emb}}\upsilon_{\tau}\cdot t_{emb},\quad\quad\quad(7) yfusion=m/s1υτ∈Xemb∑υτ⋅temb,(7)其中 y f u s i o n ∈ R y_{fusion} \in\mathbb{R} yfusion∈R。然后,将区域级嵌入馈送到输出层以产生标量输出 y r e g i o n = ψ ( gcd ( X e m b ) ) ∈ R y_{region}=\psi(\gcd(X_{emb}))\in\mathbb{R} yregion=ψ(gcd(Xemb))∈R,其中 g a p ( ⋅ ) gap(\cdot) gap(⋅)和 ψ ( c d o t ) \psi(cdot) ψ(cdot)分别表示一个全局注意力池化函数和一个全连接层。因此最终D的输出为 y D = s i g m o i d ( y f u s i o n + y r e g i o n ) y_D = sigmoid(y_{fusion} + y_{region}) yD=sigmoid(yfusion+yregion)。

(3)网络训练

如图3所示,我们使用两个损失函数,cGAN损失和监督损失来优化我们的网络。cGAN损失是一般的对抗性损失(Goodfellow et al.,2014a),涉及D和G,写为 L c g a n = min G max D E ( X , t ) ∼ P D e log D ( X , t ) + E X ∼ P X , N ∼ P n log [ 1 − D ( X , G ( X , N ) ) ] , (8) \begin{aligned} \mathcal{L}_{\mathrm{cgan}}& =\operatorname*{min}_{G}\operatorname*{max}_{D}\mathbb{E}_{(X,t)\sim P_{D_{e}}}\log D(X,t) +\mathbb{E}_{X\sim P_{X},\mathcal{N}\sim P_{n}}\log\big[1-D(X,G(X,\mathcal{N}))\big], \quad\quad\quad\text{(8)}\end{aligned} Lcgan=GminDmaxE(X,t)∼PDelogD(X,t)+EX∼PX,N∼Pnlog[1−D(X,G(X,N))],(8)其中D是经过优化的以准确识别真假对,G是通过生成时间到事件来欺骗D,以期望能更好地匹配实际的数据分布。注意 ( X , t ) (X, t) (X,t)是来自公式8的第一个式子 P D e P_{\mathcal{D}_e} PDe,而不是 P D P_D PD,因为只有事件发生的患者才有时间到事件的基本真值标签。

与大多数cGAN一样, L c g a n \mathcal{L}_{cgan} Lcgan的收敛性在理论上是有保证的(Zhou et al.,2022)。然而,在网络训练中,我们观察到当只使用 L c g a n \mathcal{L}_{cgan} Lcgan时,这种对抗网络很难被优化。这个问题在对抗性学习中仍然存在(Goodfellow, 2016;Gui et al.,2021)。为了缓解这种情况,我们还使用了辅助监督损失,该监督损失充分利用了事件时间标签(Chapfuwa et al.,2018;Uemura et al.,2021),以训练网络并加速其收敛。辅助损耗定义为 L s l = min G E ( X , t ) ∼ P D e , N ∼ P n ∣ G ( X , N ) − t ∣ + E ( X , t ) ∼ P D n e , N ∼ P n R e L U ( t − G ( X , N ) ) , (9) \begin{aligned}\mathcal{L}_{\mathrm{sl}}& =\operatorname*{min}_{G}\mathbb{E}_{(X,t)\sim P_{D_{e}},\mathcal{N}\sim P_{n}}\left|G(X,\mathcal{N})-t\right|+ \mathbb{E}_{(X,t)\sim P_{D_{ne}},\mathcal{N}\sim P_{n}}\mathrm{ReLU}\big(t-G(X,\mathcal{N})\big), \quad\quad\quad\text{(9)}\end{aligned} Lsl=GminE(X,t)∼PDe,N∼Pn∣G(X,N)−t∣+E(X,t)∼PDne,N∼PnReLU(t−G(X,N)),(9)其中 L s 1 \mathcal{L}_{s1} Ls1同时考虑了审查和未审查的患者。因此,它可以使G同时缩小其在 P D e P_{\mathcal{D}_e} PDe和 P D n e P_{\mathcal{D}_{ne}} PDne上的经验误差。与WSI生存分析中广泛采用的其他损失函数不同, L s 1 \mathcal{L}_{s1} Ls1不再依赖于任何危险函数假设或时间预离散化,因此我们的具有 L s 1 \mathcal{L}_{s1} Ls1的AdvMIL可以通过从G隐式采样来估计时间到事件的分布。

AdvMIL 的训练过程,如算法 1 所示,与普通 GAN 非常相似。具体来说,它也可以被视为 G 和 D之间的对抗性 min-max 游戏。AdvMIL 和 一般的 GAN 之间的主要区别在于 AdvMIL 训练将涉及审查的患者(例如 P D n e P_{\mathcal{D}_{ne}} PDne)和辅助监督损失(例如 L s 1 \mathcal{L}_{s1} Ls1)。

3.3. k折交叉半监督学习

在这里,我们展示了如何使用 AdvMIL 执行半监督学习以进行 WSI 生存分析,然后介绍我们的 k折半监督训练策略。

我们将标记数据(表示为 D 1 \mathcal{D}_1 D1)和未标记数据(表示为 D u 1 \mathcal{D}_{u1} Du1)输入AdvMIL进行半监督学习。具体来说,对于 D u 1 \mathcal{D}_{u1} Du1中未标记的样本,由于没有标签,他们只会使用等式(8)中的第二项,例如, minmax G D E X ∼ P X , N ∼ P n log [ 1 − D ( X , G ( X , N ) ) ] \underset{G\quad D}{\operatorname*{minmax}}\mathbb{E}_{X\sim P_{X},\mathcal{N}\sim P_{n}}\log\left[1-D(X,G(X,\mathcal{N}))\right] GDminmaxEX∼PX,N∼Pnlog[1−D(X,G(X,N))]。即利用未标记的样本通过G推断时间到事件的估计,然后与这些估计进一步组合形成假对,用于优化对抗损失,以及优化G和D。

传统的半监督学习通常直接利用 D u 1 \mathcal{D}_{u1} Du1中的所有未标记样本进行小批量训练。然而,当训练数据中 D u 1 \mathcal{D}_{u1} Du1的比例非常高时,半监督训练将被那些未标记的样本所主导,而很少关注标记样本中有用的监督信号。这个问题可能会损害半监督训练的效率,特别是在小数据体系中,例如WSI数据;这是因为一个小的数据体系意味着更少的标记样本和更弱的监督信号。

为了减少上述问题的影响,我们提出了一种新的k折半监督训练策略,如算法2所示。它将未标记的数据 D u 1 \mathcal{D}_{u1} Du1拆分为k折,其大小相同, D u 1 0 \mathcal{D}_{u1}^0 Du10, D u 1 1 \mathcal{D}_{u1}^1 Du11, ⋯ \cdots ⋯, D u 1 k − 1 \mathcal{D}_{u1}^{k-1} Du1k−1。在训练的第T步,只选择 D u 1 α \mathcal{D}_{u1}^\alpha Du1α和标记数据 D 1 \mathcal{D}_1 D1作为训练样本,其中, α = ( T m o d k ) \alpha =(T mod k) α=(Tmodk)。我们可以看到,当k=1时,这种k折半监督训练策略正好退化为传统的半监督训练。

4. 实验和结果

4.1. 实验设置

(1)数据集描述

本研究中使用了三个公开可用的WSI数据集。它们是National Lung Screening Trial(NLST)((National Lung Screening Trial Research Team,2011),BReast CAncer(BRCA)和Low-Grade Glioma(LGG),其中BRCA和LGG都来自癌症基因组图谱(TCGA) (kando et al.,2013)。我们的数据集选择标准主要考虑:(i)可用患者的数量,(ii)是否在以前的出版物中被采用,(iii)图像质量。最后,我们从1911例患者中收集了3101例wsi,没有任何主观数据整理。三个数据集的总体生存曲线如图5所示,数据集详细情况如表1所示。

(2)选择的基准

选择ABMIL (Ilse et al.,2018)、DeepAttnMISL (Yao et al.,2020)、PatchGCN (Chen et al.,2021)和ESAT (Shen et al.,2022)这四种方法作为我们的基线,因为(i)它们来源于三个主流类别(例如,聚类、图和序列)用于端到端WSI建模;(ii)它们是每个类别中最具代表性的。我们用 M \mathcal{M} M表示一个基线模型,它可以是ABMIL、DeepAttnMISL、PatchGCN和ESAT中的一个。为了验证AdvMIL在四条基线上的有效性,我们比较了三种不同的模型,如下:

- M o r i g i n \mathcal{M}_{origin} Morigin,它遵循 M \mathcal{M} M的实现,具有原始的MIL编码器和生存损失函数。

- M b a s e \mathcal{M}_{base} Mbase,它采用原来的MIL编码器 M \mathcal{M} M,由式(9)定义的新的 L s 1 \mathcal{L}_{s1} Ls1。

- M \mathcal{M} M+ AdvMIL,它采用了一种新的AdvMIL方案,该方案采用了原MIL编码器 M \mathcal{M} M的鉴别器和生成器,并特别利用了两种新的 L s 1 \mathcal{L}_{s1} Ls1和 L g a n \mathcal{L}_{gan} Lgan进行对抗学习。

(3) 补充细节

包建设。 每个WSI的放大倍数设置为20×(例如,f=20)。对于从大到小的补丁,我们将每个区域的补丁号设置为16( s = η 2 = 16 s=\eta^2 = 16 s=η2=16),补丁大小设置为256 × 256像素(例如a=256),以便很好地平衡计算效率和微观细节。此外,在CLAM (Lu et al.,2021)之后,应用于补丁的特征提取器(𝑐=1024)是官方截断的ResNet-50模型(He et al.,2016),在ImageNet上进行预训练(Deng et al., 2009)。

生成器。 对于基于序列的模型和基于聚类的模型,我们经验地将MIL编码器的输出维数设置为384,对于基于图的模型设置为128(因为训练密集和大图是有效的)。生成器G末尾的MLP只包含两个层。在每一层中,当加入随机噪声 N \mathcal{N} N时,将其维数设置为与输入相同。为了简单起见,我们使用二进制代码来表示是否将随机噪声添加到MLP层中。代码0和1分别表示对MLP的对应层不添加随机噪声和添加随机噪声。因此,对于对抗学习,在我们的两层MLP中,所有可能的噪声添加设置为0-1,1-0和1-1。例如,1-0表示将噪声添加到第一层,而不添加到第二层,以此类推。

鉴别器。 对于RLIP融合网络D,我们使用MLP和平均池化层来实现区域嵌入层。该方法可以将具有任意数量补丁的区域特征转换为单个区域级特征向量,即能够在各种补丁区域设置下工作(即使这些区域具有不同的补丁数量)。此属性表明区域分区可以灵活且可扩展。 X e m b X_{emb} Xemb和 t e m b t_{emb} tembi的特征维度是d=128。实现 R → R 128 \mathbb{R}\to \mathbb{R}^{128} R→R128的时间嵌入层是一个两层的MLP。全连接层 ψ \psi ψ为 R 128 → R \mathbb{R}^{128}\to \mathbb{R} R128→R

网络训练。 生成器G由 L c g a n \mathcal{L}_{cgan} Lcgan第二项的简化版本更新,如下所示: L c g a n ( G ) = max G E X ∼ P X , N ∼ P n D ( X , G ( X , N ) ) . ( 10 ) \mathcal{L}_{\mathrm{cgan}}(G)=\max_{G}\mathbb{E}_{X\sim P_{X},\mathcal{N}\sim P_{n}}D\big(X,G(X,\mathcal{N})\big).\quad\quad\quad(10) Lcgan(G)=GmaxEX∼PX,N∼PnD(X,G(X,N)).(10)它通常有助于训练对抗性网络(Salimans等人,2016)。完整的训练超参数设置如表2所示。如果验证损失在10个epoch内没有减少,𝐺的学习率将衰减0.5倍。此外,所有这些超参数在三个使用的WSI数据集上始终保持不变。更多的实验细节可以在我们公开的源代码中看到。

(4)评估指标

我们报告了生存分析中常用的指标(Harrell et al., 1984),一致性指数(C-Index)。它衡量的是模型对风险的辨别或排序能力,就像分类评价中的AUC一样。我们还评估了根据真实标签估计的平均绝对误差(MAE),如Eq.(9)所计算。在评估期间,对于任何患者,我们通过从生成器随机采样30次来获得其 t ^ \hat{t} t^(因为在千兆像素wsi上推断一次相对耗时)。给定有限的采样时间,我们使用 t ^ \hat{t} t^的中位数作为性能评估的最终估计,因为它通常比平均值对异常值更健壮。

此外,我们使用5折交叉验证(CV)来评估每个模型。在训练中,随机抽取训练集中20%的样本组成一个验证集,用于早期停止和模型选择。我们的数据分割是在患者层面进行的。所有实验均在2 × NVIDIA v100 (32G) GPU的工作站上进行。

4.2. 结果和分析

(1)整体性能

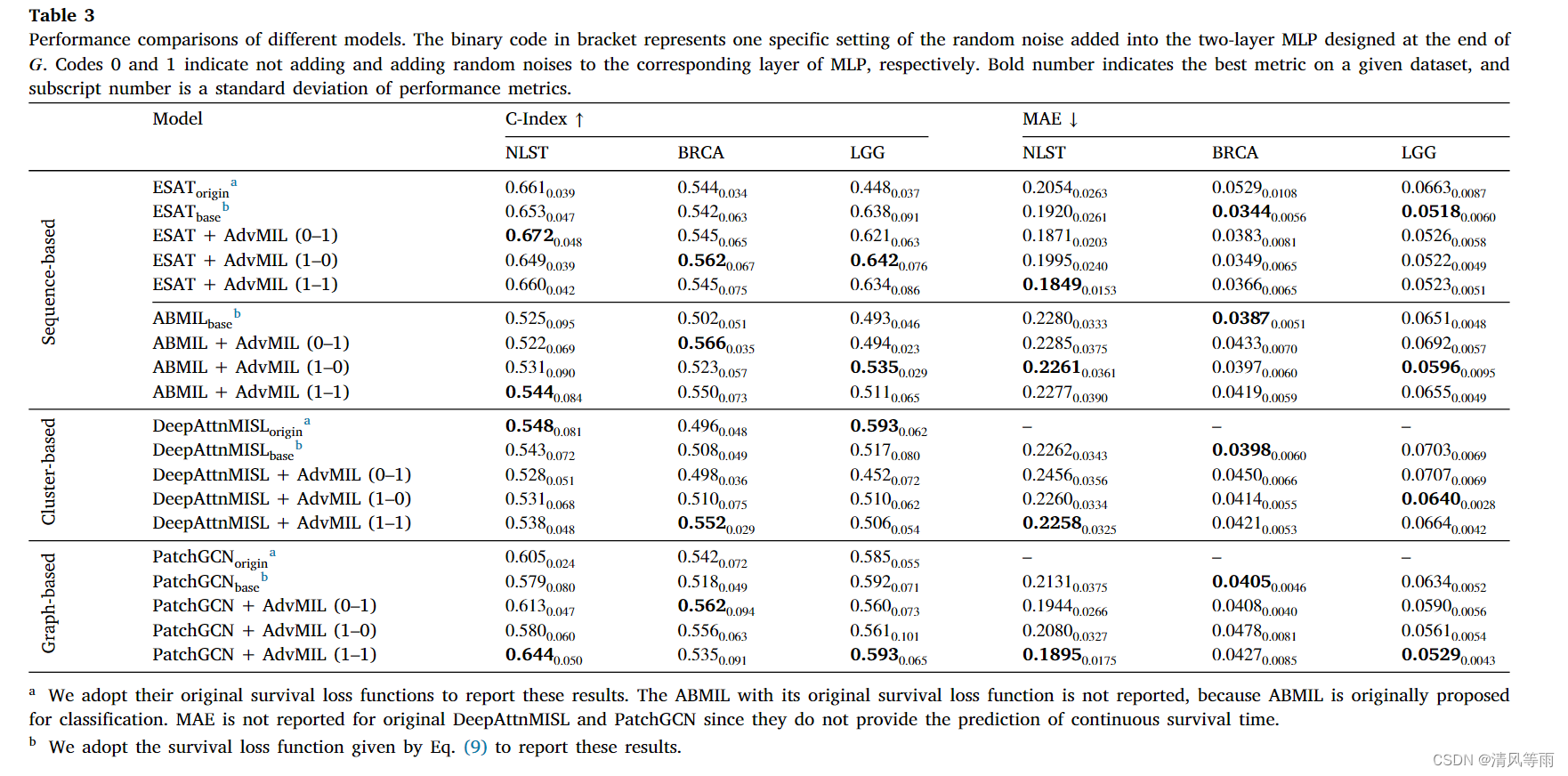

基于序列的带有AdvMIL的ESAT。 我们首先将AdvMIL应用于基于序列的ESAT并测试其性能,因为ESAT是建立在Transformer之上的(Vaswani等人,2017),Transformer在各种应用中都取得了显著的成功。与 E S A T b a s e {ESAT}_{base} ESATbase相比,结合ESAT和AdvMIL的模型还通过对抗损失 L c g a n \mathcal{L}_cgan Lcgan算法进行了优化。

如表3所示,我们可以看到(1)ESAT + AdvMIL在C-Index和MAE上往往都能获得比原始ESAT更好的性能,在LGG上的改进是明显的;(2)结合ESAT和AdvMIL的模型在NLST、BRCA和LGG上的C-Index分别提高了2.91%、3.69%和0.63%,优于ESATbase模型;(3)将AdvMIL应用于ESAT使NLST上的MAE降低了3.70%,而在其他两个数据集上的MAE则略微提高了+1%左右。这些观察结果表明,与基于序列的ESAT相比,AdvMIL具有竞争优势,尤其是在C-Index方面。直观地说,通过对抗性学习 L c g a n \mathcal{L}_cgan Lcgan可以帮助优化G,然后使G对被噪声 N \mathcal{N} N扩展和平滑的输入空间变得更加鲁棒(Miyato et al., 2018)。此外,观察到噪声设置也会影响模型的性能。这意味着适当的噪声设置(对抗性训练的重点(Goodfellow et al., 2014b))可能有助于实现更好的性能。关于这一点的更多讨论可以在4.3节中看到。

其他带有AdvMIL的主流MIL网络。 我们测试了AdvMIL对其他主流MIL网络(具有不同主干)的适应性,实验结果如表3所示。从这些结果可以看出:(1)除了BRCA上的MAE外,ABMIL + AdvMIL在C-Index和MAE方面几乎总是优于 A B M I L b a s e {ABMIL}_{base} ABMILbase;(2) DeepAttnMISL + AdvMIL在BRCA上的C-Index明显优于其两个基线,而在NLST和LGG上表现较差;(3)将AdvMIL应用于PatchGCN后,大多数情况下组合模型与 P a t c h G C N o r i g i n {PatchGCN}_{origin} PatchGCNorigin和 P a t c h G C N b a s e {PatchGCN}_{base} PatchGCNbase相当甚至更好。

表3的实证结果表明,AdvMIL通常有助于提高主流MIL网络的性能。此外,通过比较四种具有代表性的MIL网络的结果,我们注意到ESAT + AdvMIL在三个数据集上实现了最佳的整体性能。

值得注意的是,MAE对 t ^ \hat{t} t^的值比CIndex更敏感,因为C-Index衡量的是估计排序的质量,它只考虑测量中的相对误差。考虑到从𝐺中提取有限的估计值进行评估,那么 t ^ \hat{t} t^的最终的估计可能更有可能偏离分布的期望,即 E N ∼ P n P ( t ∣ X , N ) \mathbb{E}_{\mathcal{N}\sim P_n}P(t|X,\mathcal{N}) EN∼PnP(t∣X,N),从而导致更差的MAEs,如表3所示。

(2) 计算开销分析

我们在模型大小和推理成本方面评估了鉴别器的计算效率,以验证所提出的鉴别器是否会给主流MIL网络带来大量的计算开销。具体来说,我们测量所有使用模型的可训练参数(# Params)的数量。此外,我们通过从NLST中随机选择一名患者来推断模型,评估模型中乘法累积操作(# mac)的理论数量。该患者的WSI袋中总共有3360个切片。使用Python工具包ptflops来计算# Params和# mac。

如表4所示,我们的鉴别器只额外增加了206.34K可训练参数和452.08M MACs,明显小于4个生成器。这些结果表明,在计算开销方面,将这种鉴别器引入现有主流MIL网络是可以接受的。

(3)k折半监督训练

我们进一步研究了在半监督学习中采用AdvMIL的潜力。这在对抗性生存分析的两个经典作品中都没有研究,即DATE (Chapfuwa et al.,2018)和pix2surv (Uemura et al.,2021)。为简单起见,我们分别用 D t r a i n \mathcal{D}_{train} Dtrain和 D t e s t \mathcal{D}_{test} Dtest表示训练集和测试集。为了进行这个实验,我们首先准备了未标记的数据。具体来说,我们从 D t r a i n \mathcal{D}_{train} Dtrain中随机选择一些样本并屏蔽它们的标签。这些选定的样本在训练中是不可用标签的,称为未标记数据,表示为 D u l \mathcal{D}_{ul} Dul。剩余的样本为标记数据,表示为 D 1 = D t r a i n D t r a i n \mathcal{D}_1=\frac{\mathcal{D}_{train}}{\mathcal{D}_{train}} D1=DtrainDtrain。他们的标签在训练中可用。我们将标记数据 D t r a i n D t r a i n \frac{\mathcal{D}_{train}}{\mathcal{D}_{train}} DtrainDtrain的比率设置为0.2、0.4、0.6、0.8和0.9。然后,我们测试和比较了半监督AdvMIL模型和全监督AdvMIL模型。(1)一方面,我们将 D 1 \mathcal{D}_1 D1和 D u l \mathcal{D}_{ul} Dul同时输入AdvMIL进行𝑘-fold半监督训练(参考算法2),并在 D u l \mathcal{D}_{ul} Dul和 D t e s t \mathcal{D}_{test} Dtest上测试半监督AdvMIL模型的性能。(II)另一方面,我们只将 D l \mathcal{D}_{l} Dl输入AdvMIL进行全监督训练,作为比较的基线。我们还在 D u l \mathcal{D}_{ul} Dul和 D t e s t \mathcal{D}_{test} Dtest上测试了全监督AdvMIL模型的性能。除训练数据外,其他设置保持不变。本实验采用的是ESAT + AdvMIL网络,因为它可以在三个数据集上获得最佳的综合性能(见表3)。

我们计算了半监督AdvMIL模型比全监督AdvMIL模型的性能改进。然后,我们在2D平面的纵轴上显示此改进,在横轴上显示 D l \mathcal{D}_{l} Dl的大小。总分为15分。 D u l \mathcal{D}_{ul} Dul和 D t e s t \mathcal{D}_{test} Dtest结果分别如图6和图7所示。完整的数值结果见表5。

从这些结果中,我们可以看到(1)在 D u l \mathcal{D}_{ul} Dul上,C-Index的改善通常是积极的(15分中的10分),并且随着 D l \mathcal{D}_{l} Dl的增大,C-Index的改善会越来越大(Pearson Corr. = 0.62);(2)在 D t e s t \mathcal{D}_{test} Dtest中,C-Index的改善在少数情况下为正(15分中有5分),同时与 D l \mathcal{D}_{l} Dl的大小呈弱正相关(Pearson Corr = 0.15)。这些发现意味着AdvMIL可以有效地预测训练中使用的未标记数据,而在预测训练中未使用的数据时往往会失去其有效性。即,AdvMIL可以有效地利用半监督学习中未标记的wsi,并且在这些未标记的数据上通常获得更好的性能;而以往的WSI生存分析研究对这方面的关注不够。此外,增加标记训练数据集的规模有助于扩大未标记数据的C-Index改进 D u l \mathcal{D}_{ul} Dul。

此外,从表5中,我们经验地发现,我们的𝑘-fold策略(k> 1)往往比传统的没有折叠分割的策略取得更好的结果(例如,𝑘= 1),特别是当标注数据数量较少时,即 D t r a i n D t r a i n \frac{\mathcal{D}_{train}}{\mathcal{D}_{train}} DtrainDtrain为0.2,0.4或0.6时。这些结果证实了我们的𝑘-fold半监督训练策略的有效性。

有许多研究表明,GAN是半监督学习的一种有前途和有效的手段(Springenberg, 2015;Salimans et al.,2016;Miyato et al., 2018;Li et al., 2021;Gui et al., 2021)。我们的实验也验证了这一点,即使是在WSI生存分析领域的一个小数据体系(在我们的任务中只有大约500名患者)。

4.3. 消融研究和分析

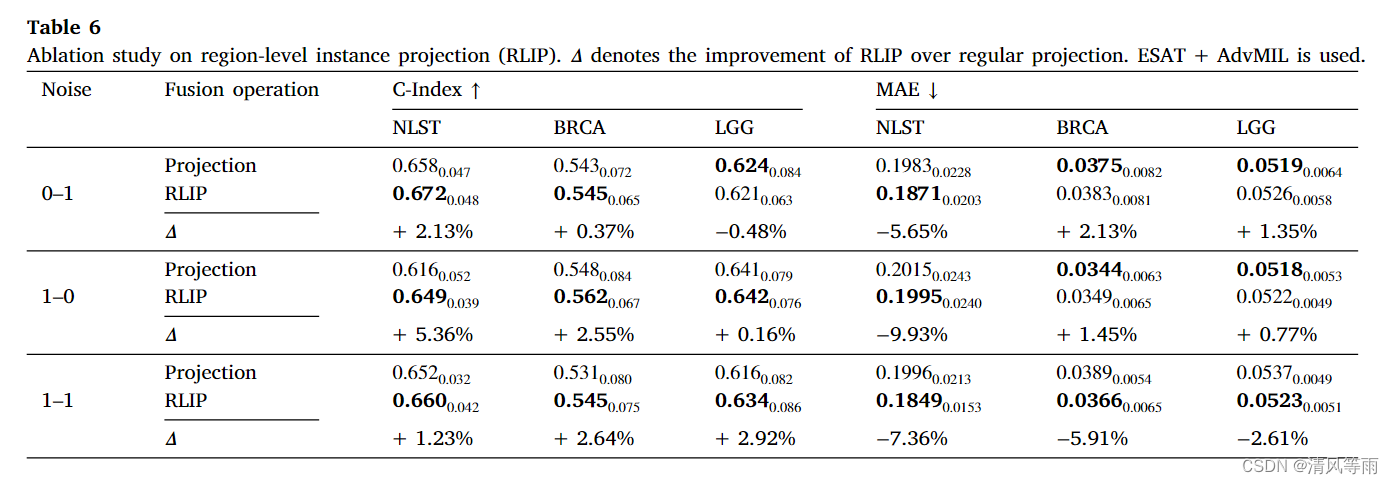

(1)区域级实例投影研究

我们验证了D中提出的用于特征融合的区域级实例投影(RLIP)策略,并将其与常规策略(wsi级投影)进行比较。该规则策略直接将条件向量投影到WSI的全局特征上。它跳过了从patch到region和region到WSI的平滑过渡(用于RLIP)。请注意,投影对WSI和生存时间进行了简单而直接的融合,这是以前的模型中没有出现的策略。它只是用作比较的基线。

从表6的结果可以总结出:(1)在三个数据集上,RLIP几乎总是获得C-Index上升(最高为+5.36%);(2)大多数情况下,RLIP对MAEs的影响幅度较大(2.61% ~ 9.93%),少数情况下,RLIP对MAEs的影响幅度不超过2.13%;(3)当噪声 N \mathcal{N} N为1-1时,RLIP在3个数据集上的CIndex和MAE都完全超过了Projection。这些实证结果证明了我们的区域级策略的有效性,并建议早期的特征融合,即,与直接的wsi级预测相比,区域级预测可能更有可能更好地包含条件信息,并有助于对抗性多实例学习。

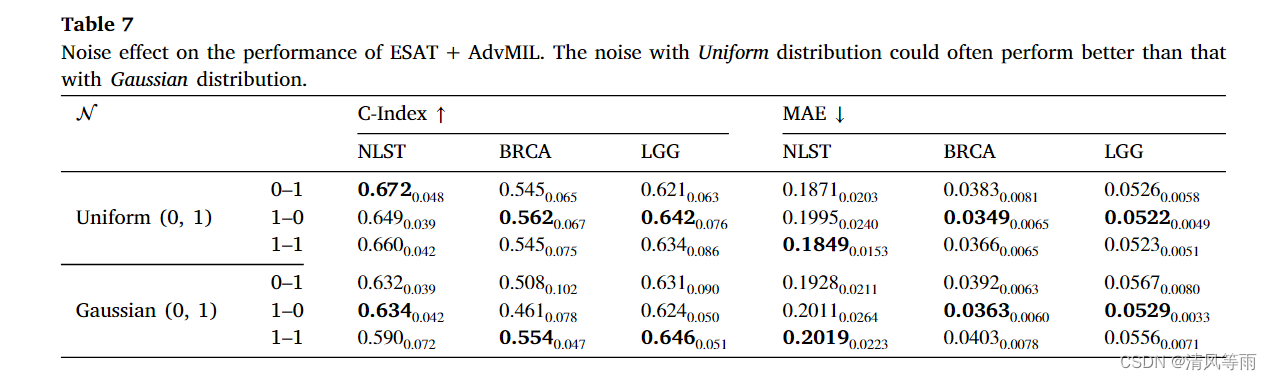

(2)噪声类型研究

我们进一步测试了噪声类型对模型性能的影响。测试了两种广泛使用的分布,均匀分布和高斯分布。从表7的结果可以看出,均匀分布往往可以获得更好的性能。特别是在MAE方面,均匀分布总是比高斯分布有明显的优势。一个可能的原因是,当从高斯分布中抽样 N \mathcal{N} N时,通过隐式抽样对时间到事件分布的估计将更加集中,因此往往会扩大预测的偏差。

此外,如第4.2节所述,我们认为噪声与条件输入一起用于预测,可能是影响模型性能的关键因素。一些技术,如对抗性训练(Goodfellow et al., 2014;Goodfellow, 2016)可能是验证这一论点的有希望的手段。我们把它留在未来的工作中,因为对抗性训练是另一个研究课题,它不是本文的重点。

4.4. 鲁棒性分析

为了验证基于AdvMIL模型的鲁棒性,我们在三个使用过的WSI数据集上进行了实验。接下来,我们将展示如何为鲁棒性分析设置实验,然后给出实验结果和发现。

具体来说,我们根据以下观察结果评估了模型对补丁级变换的鲁棒性,包括图像遮挡、高斯模糊和HED(苏木精-伊红- dab)颜色空间扰动。(I)通过直接将整个十亿像素WSI转换为各种视图来评估模型的鲁棒性确实具有挑战性,而不像对大多数具有常见尺寸的自然图像进行直接操作。(II)前人已经将斑块遮挡作为实验场景(Naseer et al., 2021;Chen et al., 2022c)研究流行计算机视觉模型的鲁棒性。(III)高斯模糊是自然图像模拟失焦伪像的经典变换,也广泛用于组织学wsi (Tellez et al., 2019;Cheng等人,2021)。(IV) HED颜色扰动是专门为H&E图像设计的(Tellez等人,2018),以模拟在计算病理学中经常采用的颜色变化程序(Tellez等人,2019),可能更适合我们的应用。

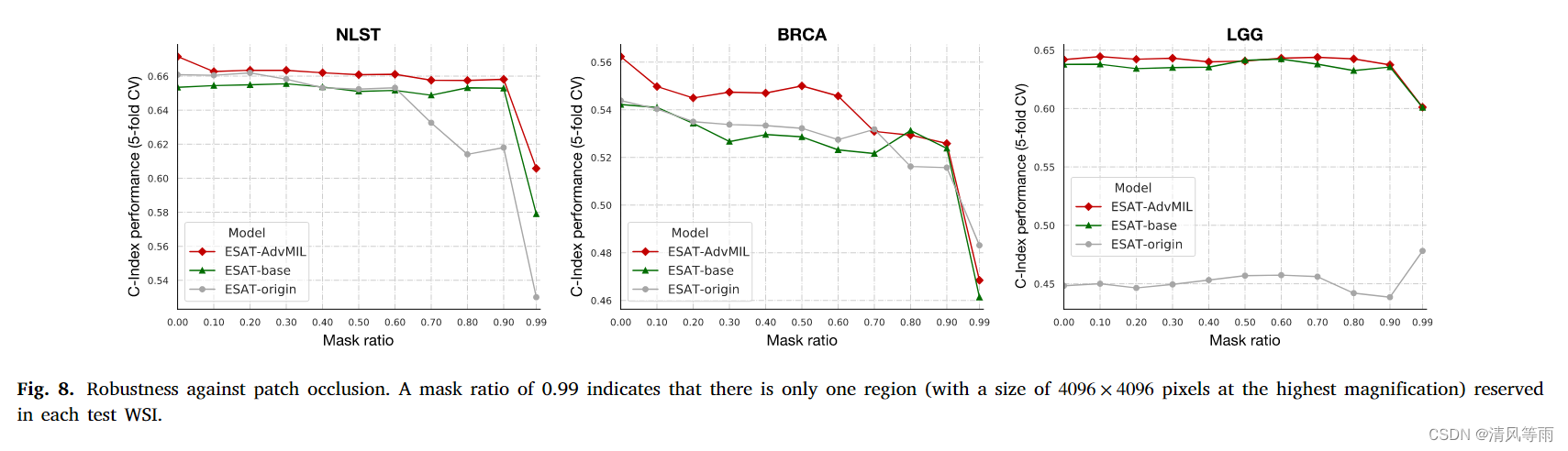

(1)对补丁遮挡的鲁棒性

我们随机屏蔽每个WSI(在测试集中)的补丁,根据不同的掩码比率。掩模比为0.99表示在每个测试WSI中只保留一个区域(最高放大倍率为4096 × 4096像素)。采用之前在完整训练数据上进行拟合的模型进行测试。C-Index在5折上的平均值报告,如图8所示。

从图8中,我们可以观察到基于advmil的模型在三个数据集的不同遮挡水平上几乎总是优于两个基线。此外,当掩码比大于0.5时,ESAT + AdvMIL在NLST和LGG上比 E S A T o r i g i n {ESAT}_{origin} ESATorigin和 E S A T b a s e {ESAT}_{base} ESATbase具有更稳定的C-Index性能。这些实验结果表明,我们的对抗性生存分析模型通常比传统的wsi模型对闭塞的鲁棒性更强。换句话说,传统WSI生存分析模型的遮挡鲁棒性可以通过我们的对抗性MIL方案进一步增强。

此外,我们有趣地看到,即使掩码比为0.99,即在每个测试WSI中只保留一个区域,基于advmil的模型(C-Index≈0.6)在NLST和LGG上仍然取得了一些有意义的结果。这种现象背后的潜在原因可能有三个方面:(i)组织学wsi固有的信息丰度和稀疏性(Zarella et al., 2018);(ii)基于transformer的模型的内在鲁棒性,Naseer等人(2021)和Laleh等人(2022)证明了这一点;(iii)我们的AdvMIL进一步提高了鲁棒性,从基于AdvMIL的ESAT相对于非对抗性 E S A T b a s e {ESAT}_{base} ESATbase的改进来看。

(2)对图像噪声的鲁棒性

我们将两种具有代表性的噪声应用于patch图像,即高斯模糊(Gau. blur)和HED颜色变化(HED var.)。其中的一些例子如图9所示。同样地,这些训练好的模型被用于对有噪声的patch图像进行测试。我们选择每个数据集中的第一个折叠进行实验,因为在我们使用的3101亿像素wsi中有大量的补丁图像(近1000万张256 × 256像素的图像)需要处理。

从表8所示的实验结果中,我们可以清楚地看到,在应用图像噪声后,基于advmil的模型总是在三个数据集上获得最好的C-Index。此外,在本实验中,我们还看到基于advmil的模型的性能更加稳定。例如,ESAT + AdvMIL在NLST、BRCA和LGG上的C-Index变化最大,分别为0.004、0.03和0.02;ESATbase模型的误差分别为0.012、0.055和0.028,明显大于基于advmil的模型。 E S A T o r i g i n {ESAT}_{origin} ESATorigin除了在LGG上的无意义结果(C-Index≤0.5)外,也显示了类似的结果。最显著的是,在BRCA上,应用高斯模糊和HED颜色变化后, E S A T b a s e {ESAT}_{base} ESATbase的C-Index分别降低0.055和0.044;而ESAT + AdvMIL仍然保持优势,没有下降。

这些经验观察表明,与传统模型相比,对抗MIL模型在鲁棒性方面具有潜在优势。对此的一个明确而直观的解释是对抗性学习的机制,即对抗性损失可以帮助优化生成器,并使生成器对由噪声扩展和平滑的输入空间变得更加鲁棒,从而在嘈杂环境中比非对抗性生成器具有更好的性能,如Miyato等人(2018)所述。

4.5. 案例研究与分析

我们从NLST的测试集中随机选择3例未审查的患者( δ = 0 \delta = 0 δ=0,有事件发生)和3例审查的患者( δ = 1 \delta = 1 δ=1,没有事件发生)。我们在图10中展示了他们的 E S A T b a s e {ESAT}_{base} ESATbase和ESAT + AdvMIL对事件的时间估计,以及他们最后的跟踪时间。

从这些结果中,我们可以看到:(1)AdvMIL使ESAT能够为一个患者提供多个时间到事件的估计,而原始ESAT只能给出一个完全确定的结果;(2) AdvMIL给出的分布估计往往覆盖了ESAT给出的单点估计;(3)分布估计的中位数往往比点估计更接近真实值。然而,我们无法定量地评估分布覆盖率的好坏,因为时间到事件分布的真实情况是未知的。

5. 讨论

组织学wsi包含丰富的微环境线索,对疾病预后至关重要。准确评估基于wsi的预后有助于改善患者管理和疾病结局。虽然已经开发了许多端到端弱监督模型来估计wsi患者的预后,但它们的潜力通常受到生存分析和全监督学习的经典范式的限制。受对抗性时间到事件模型的启发,我们提出了一种新的对抗性MIL框架来利用它们的潜力。该框架可以为计算病理学的生存分析带来新的活力和活力,使现有的MIL网络能够以相对较低的计算成本估计更鲁棒的时间到事件分布,并通过半监督训练从未标记的WSI数据中学习。

我们强调,本研究站在GAN的肩膀上(Goodfellow et al., 2014a;Mirza和Osindero, 2014)和DATE (Chapfuwa et al.,2018),并首次展示了如何将它们推广到MIL,这对于WSI表示学习非常必要。最后但并非最不重要的是,除了AdvMIL的技术贡献外,本研究还想强调其对计算病理学社区的实际贡献(例如,半监督应用)。

本研究的主要局限性包括分布估计的覆盖优度无法定量评估,因为无法获得患者生存分布的基本真值。此外,在我们的实验中也存在一些约束:(1)由于在十亿像素的图像上进行一次推断相对耗时,所以我们采用有限的采样时间来返回分布估计;(2)我们的数据集仅限于三种癌症类型,没有涵盖更多的品种和临床比较。

6. 结论

本文提出了一种新的框架——对抗多实例学习(AdvMIL),用于千兆像素wsi的生存分析。该框架主要通过两个核心将对抗时间到事件建模推广到MIL,即生成器中的MIL编码器和鉴别器中的区域级实例投影融合网络。它是一个即插即用的框架;也就是说,它可以轻松有效地应用于大多数端到端MIL模型。在三个WSI数据集上的大量实验表明,AdvMIL框架通常可以以较低的计算成本提高现有主流MIL模型的性能。最重要的是,AdvMIL可以帮助这些现有模型实现更有效的时间到事件分布估计,并通过半监督学习有效地从未标记的wsi中学习。此外,AdvMIL还可以帮助提高模型对斑块遮挡和两种代表性图像噪声的鲁棒性。

总结

本文主要讲述的其实是对于癌症预后的生存分析的相关内容,而不是对于WSI的分类。从整体上面看,大致是差不多的,但总感觉不是任务不是一样的,结果不能有代表性。至于其中的不足,作者也在讨论中有说到,最大的创新性感觉是将GAN应用于生存分析之中。因此,感觉对于其他任务,也可以试试GAN。

更多论文阅读,可以扫码关注微信公众号:

这篇关于[论文阅读]AdvMIL: Adversarial multiple instance learning for the survival analysis on whole-slide images的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

![[论文笔记]LLM.int8(): 8-bit Matrix Multiplication for Transformers at Scale](https://img-blog.csdnimg.cn/img_convert/172ed0ed26123345e1773ba0e0505cb3.png)