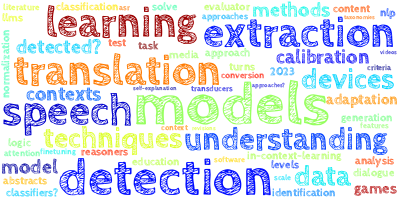

本文主要是介绍【AI视野·今日NLP 自然语言处理论文速览 第四十一期】Tue, 26 Sep 2023,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

AI视野·今日CS.NLP 自然语言处理论文速览

Tue, 26 Sep 2023

Totally 75 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| Physics of Language Models: Part 3.1, Knowledge Storage and Extraction Authors Zeyuan Allen Zhu, Yuanzhi Li 大型语言模型可以存储广泛的世界知识,通常可以通过问答来提取,例如亚伯拉罕·林肯的生日是哪一天。 |

| OmniEvent: A Comprehensive, Fair, and Easy-to-Use Toolkit for Event Understanding Authors Hao Peng, Xiaozhi Wang, Feng Yao, Zimu Wang, Chuzhao Zhu, Kaisheng Zeng, Lei Hou, Juanzi Li 事件理解旨在理解文本中事件的内容和关系,涵盖事件检测、事件论元提取和事件关系提取等多种复杂的信息提取任务。为了方便相关研究和应用,我们提出了一个事件理解工具包OmniEvent,它具有三个需求: 1 全面。 OmniEvent 支持所有事件理解任务的主流建模范式以及 15 个广泛使用的英文和中文数据集的处理。 2 公平。 OmniEvent 仔细处理了 Peng 等人报告的不显眼的评估陷阱。 2023,确保不同模型之间的公平比较。 3 使用方便。 OmniEvent 旨在供具有不同需求的用户轻松使用。我们提供现成的模型,可以直接部署为 Web 服务。模块化框架还使用户能够使用 OmniEvent 轻松实施和评估新的事件理解模型。 |

| Urdu Poetry Generated by Using Deep Learning Techniques Authors Muhammad Shoaib Farooq, Ali Abbas 这项研究提供了使用不同深度学习技术和算法生成的乌尔都语诗歌。数据是通过 Rekhta 网站收集的,包含 1341 个文本文件和几对对联。诗歌数据不来自任何特定流派或诗人。相反,它是一本混合乌尔都语诗歌和加查尔语的合集。使用了不同的深度学习技术,例如应用的模型长短期记忆网络 LSTM 和门控循环单元 GRU。自然语言处理 NLP 可用于机器学习来理解、分析和生成人类可以使用和理解的语言。在使用不同技术为不同语言生成诗歌方面已经做了很多工作。不同的研究人员对数据的收集和使用也有所不同。该项目的主要目的是提供一个完全使用数据而不是采样数据来生成乌尔都语诗歌的模型。此外,这可能会生成纯乌尔都语的诗歌,而不是像基纸中那样的罗马乌尔都语诗歌。 |

| Only 5\% Attention Is All You Need: Efficient Long-range Document-level Neural Machine Translation Authors Zihan Liu, Zewei Sun, Shanbo Cheng, Shujian Huang, Mingxuan Wang 事实证明,文档级神经机器翻译 DocNMT 通过引入文档级上下文信息对于处理话语现象至关重要。最重要的方向之一是将整个文档直接输入到标准的 Transformer 模型中。在这种情况下,由于注意力模块的二次复杂度,效率成为一个关键问题。现有的研究要么集中在编码器部分,要么无法部署在序列到序列生成任务(例如机器翻译 MT)上,要么会遭受性能显着下降。在这项工作中,我们通过引入基于轻量级注意力的额外选择层来保持翻译性能,同时获得 20 倍的速度提升,该选择层选择要关注的一小部分标记。它利用原始注意力来保证性能和降维以加速推理。 |

| Towards End-User Development for IoT: A Case Study on Semantic Parsing of Cooking Recipes for Programming Kitchen Devices Authors Filippos Ventirozos, Sarah Clinch, Riza Batista Navarro 对用户生成的教学文本进行语义解析,使最终用户能够对物联网进行编程,是一个尚未充分开发的领域。在这项研究中,我们提供了一个独特的带注释的语料库,旨在支持将烹饪食谱指令转换为厨房中物联网设备的机器可理解的命令。这些命令中的每一个都是一个元组,捕获涉及厨房设备的指令的语义,包括“什么”、“在哪里”、“为什么”和“如何”。基于这个语料库,我们开发了基于机器学习的序列标记方法,即条件随机场 CRF 和神经网络模型,以便解析食谱指令并从中提取我们感兴趣的元组。 |

| Examining Temporal Bias in Abusive Language Detection Authors Mali Jin, Yida Mu, Diana Maynard, Kalina Bontcheva 网上使用辱骂性语言已成为一个日益普遍的问题,对个人和社会都造成损害,其影响范围从心理伤害到升级到现实生活中的暴力甚至死亡。机器学习模型已经被开发用来自动检测辱骂性语言,但这些模型可能会受到时间偏差的影响,即主题、语言使用或社会规范随着时间的推移而变化的现象。本研究旨在调查各种语言的滥用语言检测中时间偏差的性质和影响,并探索缓解方法。我们评估模型在不同时期的滥用数据集上的性能。我们的结果表明,时间偏差是滥用语言检测的一个重大挑战,根据历史数据训练的模型显示,随着时间的推移,性能显着下降。我们还从历时的角度对这些滥用数据集进行了广泛的语言分析,旨在探讨语言演变和性能下降的原因。 |

| Reproducing Whisper-Style Training Using an Open-Source Toolkit and Publicly Available Data Authors Yifan Peng, Jinchuan Tian, Brian Yan, Dan Berrebbi, Xuankai Chang, Xinjian Li, Jiatong Shi, Siddhant Arora, William Chen, Roshan Sharma, Wangyou Zhang, Yui Sudo, Muhammad Shakeel, Jee weon Jung, Soumi Maiti, Shinji Watanabe 在大量数据上预训练语音模型取得了显着的成功。 OpenAI Whisper 是一种多语言多任务模型,经过 68 万小时的监督语音数据训练。即使在零样本设置中,它也可以很好地推广到各种语音识别和翻译基准。然而,开发此类模型从数据收集到训练的完整流程并不公开,这使得研究人员很难进一步提高其性能并解决与训练相关的问题,例如效率、稳健性、公平性和偏差。这项工作提出了一种开放 Whisper 风格的语音模型 OWSM,它使用开源工具包和公开可用的数据重现 Whisper 风格的训练。 OWSM 甚至支持更多的翻译方向,可以更高效地训练。 |

| PRiSM: Enhancing Low-Resource Document-Level Relation Extraction with Relation-Aware Score Calibration Authors Minseok Choi, Hyesu Lim, Jaegul Choo 文档级关系提取DocRE旨在提取文档中所有实体对的关系。 DocRE 的一个关键挑战是注释此类数据的成本,这需要大量的人力。因此,我们研究了低资源环境中 DocRE 的情况,发现在低数据上训练的现有模型高估了 NA 无关系标签,导致性能有限。在这项工作中,我们从校准的角度来解决这个问题,并提出了 PRiSM,它学习根据关系语义信息来调整 logits。我们在三个 DocRE 数据集上评估我们的方法,并证明将现有模型与 PRiSM 集成可将性能提高多达 26.38 F1 分数,而当使用大约 3 个数据进行训练时,校准误差下降多达 36 倍。 |

| Fast-HuBERT: An Efficient Training Framework for Self-Supervised Speech Representation Learning Authors Guanrou Yang, Ziyang Ma, Zhisheng Zheng, Yakun Song, Zhikang Niu, Xie Chen 近年来,用于语音处理任务的自监督学习 SSL 方法取得了重大进展。各种基于语音的 SSL 模型已经被开发出来,并且在包括语音识别在内的一系列下游任务中表现出了良好的性能。然而,现有的基于语音的 SSL 模型在计算成本方面面临着共同的困境,这可能会阻碍其潜在的应用和深入的学术研究。为了解决这个问题,我们首先分析了HuBERT预训练期间不同模块的计算成本,然后引入了一系列效率优化,在本文中将其命名为Fast HuBERT。所提出的 Fast HuBERT 可以在 Librispeech 960h 基准上使用 8 个 V100 GPU 在 1.1 天内进行训练,而不会降低性能,与原始实现相比,速度提高了 5.2 倍。 |

| Can LLM-Generated Misinformation Be Detected? Authors Canyu Chen, Kai Shu 大型语言模型法学硕士的出现产生了变革性的影响。然而,ChatGPT 等法学硕士可能被利用来生成错误信息,这对在线安全和公众信任构成了严重担忧。一个基本的研究问题是LLM生成的错误信息是否会比人类书面的错误信息造成更大的危害,我们建议从检测难度的角度来解决这个问题。我们首先建立一个 LLM 生成的错误信息的分类法。然后,我们对法学硕士生成错误信息的潜在现实方法进行分类和验证。然后,通过广泛的实证调查,我们发现,与具有相同语义的人类书面错误信息相比,LLM 生成的错误信息更难被人类和检测器检测到,这表明它可能具有更多的欺骗性风格,并可能造成更大的伤害。 |

| Text Classification: A Perspective of Deep Learning Methods Authors Zhongwei Wan 近年来,随着互联网信息的快速发展,复杂的文本和文档的数量呈指数级增长,这需要对深度学习方法有更深入的了解,以便利用深度学习技术对文本进行准确的分类,从而深度学习方法在文本分类中变得越来越重要。文本分类是一类任务,可根据内容和主题自动将一组文档分类为多个预定义类别。因此,文本分类的主要目标是使用户能够从文本资源中提取信息,并将检索、分类和机器学习技术等过程结合在一起,以对不同的类别进行分类。深度学习的许多新技术已经在自然语言处理方面取得了优异的成果。这些学习算法的成功取决于它们理解复杂模型和数据中非线性关系的能力。然而,找到正确的文本分类结构、架构和技术对研究人员来说是一个挑战。本文介绍了基于深度学习的文本分类算法,包括文本分类任务所需的重要步骤,如特征提取、特征约简以及评估策略和方法。 |

| Does the "most sinfully decadent cake ever" taste good? Answering Yes/No Questions from Figurative Contexts Authors Geetanjali Rakshit, Jeffrey Flanigan 比喻语言在自然语言中很常见,虽然使交流令人难忘且富有创造性,但可能难以理解。在这项工作中,我们研究了问答 QA 模型在比喻文本上的稳健性。是的,没有问题,尤其是对大型语言模型的比喻语言理解能力的有用探索。我们提出了 FigurativeQA,这是一组从餐厅和产品评论领域提取的 1000 个是非问题,包含比喻和非比喻背景。我们证明,与非比喻性上下文相比,最先进的基于 BERT 的 QA 模型在回答比喻性上下文中的问题时,平均性能下降高达 15 个百分点。虽然像 GPT 3 和 ChatGPT 这样的模型更擅长处理比喻文本,但我们表明,通过自动将比喻上下文简化为其非比喻文字对应物,可以实现进一步的性能提升。我们发现最好的整体模型是 ChatGPT,其思维链提示生成非比喻上下文。 |

| Arabic Sentiment Analysis with Noisy Deep Explainable Model Authors Md. Atabuzzaman, Md Shajalal, Maksuda Bilkis Baby, Alexander Boden 情感分析 SA 是许多现实世界应用程序不可或缺的任务。与阿拉伯语、孟加拉语等资源有限的语言相比,SA的研究大多针对英语、汉语等资源丰富的语言。此外,利用先进的人工智能人工智能方法进行阿拉伯语情绪分析方法的任何预测背后的原因就像黑匣子一样很难理解。本文通过在双向长短期记忆 BiLSTM 和卷积神经网络 CNN BiLSTM 模型上引入噪声层来克服过拟合问题,提出了一种可解释的阿拉伯语情感分类框架。所提出的框架可以通过训练本地代理可解释模型来解释特定的预测,以理解为什么会预测特定的积极或消极情绪。我们在公共基准阿拉伯语 SA 数据集上进行了实验。结果得出的结论是,添加噪声层可以通过减少过度拟合来提高阿拉伯语情感分析的性能,并且我们的方法优于一些已知的最先进方法。 |

| Multiple Relations Classification using Imbalanced Predictions Adaptation Authors Sakher Khalil Alqaaidi, Elika Bozorgi, Krzysztof J. Kochut 关系分类任务为一对主客体实体分配正确的语义关系,该任务在各种文本挖掘应用中发挥着至关重要的作用,例如生物医学文本中的知识图谱构建和实体交互发现。当前的关系分类模型采用额外的过程来识别单个句子中的多个关系。此外,他们忽视了不平衡的预测模式。该模式源于一些有效关系的存在,这些关系需要在相对较大的预定义关系集中进行正向标记。我们提出了一种多重关系分类模型,通过定制的输出架构和利用额外的输入特征来解决这些问题。我们的研究结果表明,即使在适度的训练设计上,处理不平衡的预测也会带来显着的改进。结果证明了在关系分类中常用的基准数据集上的优越性能。 |

| Skill Check: Some Considerations on the Evaluation of Gamemastering Models for Role-playing Games Authors Santiago G ngora, Luis Chiruzzo, Gonzalo M ndez, Pablo Gerv s 在角色扮演游戏中,游戏大师 GM 是负责游戏的玩家,他必须设计玩家面临的挑战并讲述他们行动的结果。在这项工作中,我们从交互式讲故事和自然语言处理的角度讨论了对 GM 建模的一些挑战。 |

| ALLURE: A Systematic Protocol for Auditing and Improving LLM-based Evaluation of Text using Iterative In-Context-Learning Authors Hosein Hasanbeig, Hiteshi Sharma, Leo Betthauser, Felipe Vieira Frujeri, Ida Momennejad 从对论文进行评分到总结医学文档,大型语言模型法学硕士越来越多地用于评估人类和人工智能生成的文本。然而,尽管法学硕士具有广泛的实用性,但它们表现出独特的失败模式,需要对其文本评估能力进行彻底的审核和改进。在这里,我们介绍 ALLURE,一种审计大型语言模型理解和推理错误的系统方法。 ALLURE 涉及将法学硕士生成的评估与带注释的数据进行比较,并迭代地将显着偏差的实例合并到评估器中,从而利用上下文学习 ICL 来增强和改进法学硕士对文本的稳健评估。通过这个迭代过程,我们的目标是改进评估器 LLM 的性能,最终减少评估过程中对人类注释器的依赖。 |

| Embers of Autoregression: Understanding Large Language Models Through the Problem They are Trained to Solve Authors R. Thomas McCoy, Shunyu Yao, Dan Friedman, Matthew Hardy, Thomas L. Griffiths 大型语言模型法学硕士的广泛采用使得认识其优势和局限性变得非常重要。我们认为,为了对这些系统有一个整体的理解,我们需要考虑这样一个问题:它们被训练来解决互联网文本的下一个单词预测问题。通过认识到这项任务所施加的压力,我们可以预测法学硕士将采取的策略,从而使我们能够推断出他们何时会成功或失败。这种我们称之为目的论的方法使我们确定了三个因素,我们假设这些因素将影响 LLM 的准确性:要执行的任务的概率、目标输出的概率以及所提供输入的概率。我们预测,即使在概率不重要的确定性环境中,当这些概率较高时,法学硕士也会比概率较低时获得更高的准确率。为了测试我们的预测,我们在 11 项任务上评估了两个 LLM GPT 3.5 和 GPT 4,并且我们发现了强有力的证据,表明 LLM 会以我们假设的方式受到概率的影响。在许多情况下,实验揭示了令人惊讶的故障模式。例如,当输出是高概率单词序列时,GPT 4 解码简单密码的准确度为 51,但当输出为低概率单词序列时,准确度仅为 13。这些结果表明,人工智能从业者在低概率情况下使用法学硕士时应谨慎。 |

| MentalLLaMA: Interpretable Mental Health Analysis on Social Media with Large Language Models Authors Kailai Yang, Tianlin Zhang, Ziyan Kuang, Qianqian Xie, Sophia Ananiadou 随着网络技术的发展,社交媒体文本正在成为自动心理健康分析的丰富来源。由于传统的判别方法存在可解释性低的问题,最近大型语言模型已被探索用于社交媒体上的可解释心理健康分析,旨在提供详细的解释和预测。结果表明,ChatGPT 可以为其正确分类生成接近人类的解释。然而,LLM 在零样本少量样本的方式下仍然取得了不令人满意的分类性能。特定领域的微调是一种有效的解决方案,但面临 2 个挑战 1 缺乏高质量的训练数据。 2 没有发布用于可解释心理健康分析的开源法学硕士,以降低微调成本。为了缓解这些问题,我们在社交媒体上构建了第一个多任务、多源可解释的心理健康指导 IMHI 数据集,包含 105K 数据样本。原始社交媒体数据是从 10 个现有来源收集的,涵盖 8 项心理健康分析任务。我们使用专家编写的少量提示和收集的标签来提示 ChatGPT 并从其响应中获取解释。为了确保解释的可靠性,我们对生成数据的正确性、一致性和质量进行严格的自动和人工评估。基于 IMHI 数据集和 LLaMA2 基础模型,我们训练 MentalLLaMA,这是第一个开源 LLM 系列,用于可解释的心理健康分析,具有指令跟踪功能。我们还使用 10 个测试集在 IMHI 评估基准上评估 MentalLLaMA 的性能,检查其预测的正确性和解释的质量。 |

| Keeping in Time: Adding Temporal Context to Sentiment Analysis Models Authors Dean Ninalga 本文提出了 LongEval CLEF 2023 实验室任务 2 LongEval 分类的最先进解决方案。此任务的目标是在更短和更长的时间段内提高和保持情感分析模型的性能。我们的框架将带日期前缀的文本输入提供给预先训练的语言模型,其中时间戳包含在文本中。我们在相应文本的时间上下文上显示日期前缀样本更好的条件模型输出。此外,我们通过对未标记数据进行自标记来训练学生模型,进一步提高性能。我们使用一种新颖的增强策略来增强自标记过程,该策略利用了样本的日期前缀格式。我们展示了 LongEval 分类评估集相对于非增强自标记的具体性能提升。 |

| Substituting Data Annotation with Balanced Updates and Collective Loss in Multi-label Text Classification Authors Muberra Ozmen, Joseph Cotnareanu, Mark Coates 多标签文本分类MLTC是为给定文本分配多个标签的任务,具有广泛的应用领域。大多数现有方法需要大量带注释的数据来学习分类器和/或对标签空间结构的一组明确定义的约束,例如随着标签数量的增加而提供的层次关系可能很复杂。在本文中,我们研究了无注释和稀缺注释设置中的 MLTC 问题,其中可用监督信号的大小与标签数量呈线性关系。我们的方法遵循三个步骤,1 使用预先训练的语言模型通过自然语言推理将输入文本映射到一组初步标签似然,2 通过标签描述计算签名标签依赖图,3 通过消息传递更新初步标签似然标签依赖图,由集体损失函数驱动,该函数注入预期标签频率和预测的平均多标签基数的信息。 |

| Hierarchical attention interpretation: an interpretable speech-level transformer for bi-modal depression detection Authors Qingkun Deng, Saturnino Luz, Sofia de la Fuente Garcia 抑郁症是一种常见的精神障碍。通过机器学习启用的使用语音的自动抑郁症检测工具有助于早期筛查抑郁症。本文解决了可能阻碍此类工具的临床实施的两个限制,这些限制是由段级标记和缺乏模型可解释性引起的噪音。我们提出了一种双模态语音级别转换器,以避免分段级别标签,并引入分层解释方法来提供语音级别和句子级别解释,基于从所有注意层导出的梯度加权注意图来跟踪输入特征之间的交互。我们表明,与 p 0.732、r 0.808、F1 0.768 相比,所提出的模型优于在分段级别 p 0.854、r 0.947、F1 0.947 学习的模型。对于模型解释,我们使用一个真实的阳性样本,显示给定语音中的哪些句子与抑郁症检测最相关,以及这些句子中的哪些文本标记和梅尔频谱图区域与抑郁症检测最相关。 |

| Grounding Description-Driven Dialogue State Trackers with Knowledge-Seeking Turns Authors Alexandru Coca, Bo Hsiang Tseng, Jinghong Chen, Weizhe Lin, Weixuan Zhang, Tisha Anders, Bill Byrne 模式引导的对话状态跟踪器无需进一步训练即可推广到新领域,但它们对模式的书写风格很敏感。使用人类或合成模式释义来增强训练集可以提高模型对这些变化的鲁棒性,但可能成本高昂或难以控制。我们建议通过将状态跟踪模型建立在从对话语料库和模式收集的知识搜索轮次中来规避这些问题。 |

| Resolving References in Visually-Grounded Dialogue via Text Generation Authors Bram Willemsen, Livia Qian, Gabriel Skantze 视觉语言模型 VLM 已被证明在基于简单文本查询的图像检索方面非常有效,但基于会话输入的文本图像检索仍然是一个挑战。因此,如果我们想在基于视觉的对话中使用 VLM 进行参考解析,则需要增强这些模型的话语处理能力。为了解决这个问题,我们建议对因果大语言模型 LLM 进行微调,以生成明确的描述,总结在参考文献的语言上下文中发现的共指信息。然后,我们使用预训练的 VLM 根据生成的描述(零样本)来识别所指对象。我们在手动注释的视觉基础对话数据集上评估我们的方法,并获得平均超过我们比较的基线性能的结果。 |

| A Chat About Boring Problems: Studying GPT-based text normalization Authors Yang Zhang, Travis M. Bartley, Mariana Graterol Fuenmayor, Vitaly Lavrukhin, Evelina Bakhturina, Boris Ginsburg 文本规范化(将文本从书面形式转换为口头形式)传统上被认为是语言模型的一项格式错误的任务。在这项工作中,我们提出了不同的观点。我们凭经验展示了大型语言模型 LLM 在少数场景中进行文本规范化的能力。将自我一致性推理与语言通知提示工程相结合,我们发现基于 LLM 的文本规范化的错误率比顶级规范化系统低 40 左右。此外,在错误分析中,我们注意到文本规范化任务的传统设计中的关键局限性。我们创建了一种新的文本标准化错误分类法,并将其应用于 GPT 3.5 Turbo 和 GPT 4.0 的结果。 |

| Exploring Large Language Models' Cognitive Moral Development through Defining Issues Test Authors Kumar Tanmay, Aditi Khandelwal, Utkarsh Agarwal, Monojit Choudhury 大型语言模型的发展引起了研究人员的广泛兴趣,以了解其固有的推理和解决问题的能力。尽管正在进行大量研究来阐明这些能力,但在理解这些模型的道德发展和判断方面仍然存在相当大的差距。当前将这些模型的道德推理能力作为分类任务进行评估的方法由于过度简化而存在许多不准确之处。在这项研究中,我们通过连接人类心理学和人工智能这两个不同的领域建立了心理联系。 |

| Lexical Squad@Multimodal Hate Speech Event Detection 2023: Multimodal Hate Speech Detection using Fused Ensemble Approach Authors Mohammad Kashif, Mohammad Zohair, Saquib Ali 随着社交媒体发帖表达观点、情感和意识形态的使用激增,社交媒体作为在全球范围内传达观点和观点的快速媒介已经发生了重大转变。与此同时,两个实体之间出现的大量冲突引发了一系列包含宣传、仇恨言论和轻率观点的社交媒体内容。因此,监控社交媒体帖子的问题正在迅速上升,吸引了那些愿意解决此类问题的人的主要关注。其中之一就是仇恨言论检测。为了缓解这个问题,我们提出了新颖的集成学习方法来检测仇恨言论,通过将文本嵌入图像分类为两个标签,即仇恨言论和无仇恨言论。我们整合了最先进的模型,包括 InceptionV3、BERT 和 XLNet。我们提出的集成模型取得了令人鼓舞的结果,准确度和 F 1 分数分别为 75.21 和 74.96。我们还对文本嵌入图像进行了实证评估,以详细说明模型的预测和分类能力。 |

| My Science Tutor (MyST) -- A Large Corpus of Children's Conversational Speech Authors Sameer S. Pradhan, Ronald A. Cole, Wayne H. Ward 本文介绍了 MyST 语料库,该语料库是作为 My Science Tutor 项目的一部分而开发的,该项目是最大的儿童对话语音集合之一,包含约 400 小时的内容,涵盖约 230K 条话语,涵盖约 10,500 个虚拟导师会话,其中约 1,300 个第三、第四和第五个会话年级学生。迄今为止,已转录了 100K 条语句。 |

| BAMBOO: A Comprehensive Benchmark for Evaluating Long Text Modeling Capacities of Large Language Models Authors Zican Dong, Tianyi Tang, Junyi Li, Wayne Xin Zhao, Ji Rong Wen 大型语言模型法学硕士在正常长度的 NLP 任务上取得了显着的熟练程度。最近,多项研究致力于扩展上下文长度并增强法学硕士的长文本建模能力。为了全面评估LLM的长上下文能力,我们提出了BAMBOO,一个多任务长上下文基准。 BAMBOO的设计遵循综合容量评估、避免数据污染、准确自动评估、不同长度等级四个原则。它由来自 5 个不同长文本理解任务(即问答、幻觉检测、文本排序、语言建模和代码补全)的 10 个数据集组成,涵盖了法学硕士的核心能力和各个领域。我们在BAMBOO上对五个长上下文模型进行了实验,并进一步讨论了长文本的四个关键研究问题。我们还定性分析了当前的长上下文模型,并指出了增强长文本建模能力的未来方向。 |

| LLMs as Counterfactual Explanation Modules: Can ChatGPT Explain Black-box Text Classifiers? Authors Amrita Bhattacharjee, Raha Moraffah, Joshua Garland, Huan Liu 大型语言模型 LLM 越来越多地用于文本生成之外的任务,包括数据标记、信息提取等复杂任务。随着最近为理解 LLM 功能的全部范围而进行的研究工作的激增,在这项工作中,我们研究了法学硕士作为反事实解释模块的作用,解释黑盒文本分类器的决策。受因果思维的启发,我们提出了一个使用LLM以原则性方式生成事后、模型不可知的反事实解释的管道,通过i利用LLM的文本理解能力来识别和提取潜在特征,ii利用扰动和生成能力相同的法学硕士通过扰乱从提取的潜在特征导出的输入特征来生成反事实解释。我们在一套最先进的法学硕士(包括 ChatGPT 和 LLaMA 2)上评估了我们框架的三个变体,具有不同程度的特异性。我们通过各种文本分类基准评估了生成的反事实解释的有效性和质量。我们的结果显示这些模型在不同设置下的不同性能,基于完整两步特征提取的变体在大多数情况下优于其他模型。 |

| Enhancing Zero-Shot Chain-of-Thought Reasoning in Large Language Models through Logic Authors Xufeng Zhao, Mengdi Li, Wenhao Lu, Cornelius Weber, Jae Hee Lee, Kun Chu, Stefan Wermter 大型语言模型的最新进展展示了它们在各个领域的卓越通用性。然而,他们的推理能力仍有很大的提升空间,尤其是在面对需要多步推理的场景时。尽管大型语言模型拥有广泛的知识,但它们的行为,特别是在推理方面,往往无法有效地利用这些知识来建立连贯的思维范式。生成语言模型有时会出现幻觉,因为它们的推理过程不受逻辑原则的约束。为了提高大型语言模型的零镜头思维链推理能力,我们提出了逻辑思维链LogiCoT,这是一种神经符号框架,利用符号逻辑的原理来相应地验证和修改推理过程。 |

| From Text to Source: Results in Detecting Large Language Model-Generated Content Authors Wissam Antoun, Beno t Sagot, Djam Seddah 大型语言模型法学硕士以其生成类人文本的能力而闻名,其广泛使用引起了人们对错误信息和道德影响的担忧。解决这些问题需要开发强大的方法来检测和归属法学硕士生成的文本。本文研究了跨模型检测,评估经过训练以区分源 LLM 生成的文本和人类编写的文本的分类器是否也可以在无需进一步训练的情况下检测来自目标 LLM 的文本。该研究全面探讨了各种 LLM 规模和系列,并评估了会话微调技术对分类器泛化的影响。该研究还深入研究了模型归因,包括源模型识别、模型族分类和模型大小分类。我们的结果揭示了几个关键发现,即分类器有效性和模型大小之间存在明显的反比关系,较大的法学硕士更难以检测,特别是当分类器接受较小模型的数据训练时。对来自类似规模的 LLM 的数据进行训练可以提高较大模型的检测性能,但在处理较小模型时可能会导致性能下降。此外,模型归因实验在识别源模型和模型族方面显示出有希望的结果,突出显示了法学硕士生成文本中的可检测签名。 |

| GlotScript: A Resource and Tool for Low Resource Writing System Identification Authors Amir Hossein Kargaran, Fran ois Yvon, Hinrich Sch tze 我们推出 GlotScript,一种用于低资源书写系统识别的开放资源和工具。 GlotScript R 是一种资源,为 7,000 多种语言提供经过验证的书写系统。它是通过聚合现有书写系统资源的信息来编译的。 GlotScript T 是一种书写系统识别工具,涵盖所有 161 个 Unicode 15.0 脚本。对于输入文本,它返回其脚本分布,其中脚本由 ISO 15924 代码标识。我们还介绍了 GlotScript 的两个用例。首先,我们演示 GlotScript 支持清理多语言语料库,例如 mC4 和 OSCAR。其次,我们使用 GlotScript 分析了多种语言模型(例如 GPT 4)的标记化,并提供了有关每种语言模型对低资源脚本和语言的覆盖范围的见解。我们希望 GlotScript 将成为 NLP 社区中低资源语言工作的有用资源。 |

| Spanish Resource Grammar version 2023 Authors Olga Zamaraeva, Carlos G mez Rodr guez 我们推出最新版本的西班牙语资源语法 SRG。新的 SRG 使用最新版本的 Freeling 形态分析器和标记器,并附有手动验证的树库和记录的问题列表。我们还展示了学习者语料库的一小部分的语法覆盖率和过度生成,这是关于 SRG 的全新研究路线。该语法可用于语言研究,例如句法理论的经验驱动发展,以及计算机辅助语言学习等自然语言处理应用。 |

| Calibrating LLM-Based Evaluator Authors Yuxuan Liu, Tianchi Yang, Shaohan Huang, Zihan Zhang, Haizhen Huang, Furu Wei, Weiwei Deng, Feng Sun, Qi Zhang 大型语言模型法学硕士在语言建模和突发能力方面的最新进展使它们成为有前途的自然语言生成质量的免费参考评估器,以及人类评估的有力替代方案。然而,由于托管和调整的闭源或高计算需求的阻碍,缺乏进一步校准现成的基于 LLM 的评估器以实现更好的人类对齐的实践。在这项工作中,我们提出了 AutoCalibrate,这是一种多阶段、无梯度的方法,可以根据人类偏好自动校准和调整基于 LLM 的评估器。我们没有明确地模拟人类偏好,而是首先将它们隐式地包含在一组人类标签中。然后,由语言模型本身起草一组初始评分标准,利用不同的少数镜头示例的上下文学习。为了进一步校准这套标准,我们选择了表现最好的人,并通过自我完善重新起草。我们对多个文本质量评估数据集的实验表明,通过校准,与专家评估的相关性有了显着改善。 |

| OATS: Opinion Aspect Target Sentiment Quadruple Extraction Dataset for Aspect-Based Sentiment Analysis Authors Siva Uday Sampreeth Chebolu, Franck Dernoncourt, Nedim Lipka, Thamar Solorio 基于方面的情感分析 ABSA 深入了解文本内容中特定元素的情感。它的目的是分析用户生成的评论,以确定a被评论的目标实体,b它所属的高级方面,c用于表达意见的情感词,以及d针对目标和方面表达的情感。虽然各种基准数据集促进了 ABSA 的进步,但它们通常面临领域限制和数据粒度挑战。为了解决这些问题,我们引入了 OATS 数据集,它包含三个新领域,由 20,000 个句子级四元组和 13,000 个评论级元组组成。我们的举措旨在弥合特定的观察到的差距,即对餐馆和笔记本电脑等熟悉领域的反复关注、复杂的四重提取任务的有限数据,以及对句子和评论级别情绪之间的协同作用的偶尔监督。此外,为了阐明 OATS 的潜力并阐明 OATS 可以解决的各种 ABSA 子任务,我们进行了域和跨域实验,建立了初始基线。 |

| A Survey of Document-Level Information Extraction Authors Hanwen Zheng, Sijia Wang, Lifu Huang 文档级信息提取IE是自然语言处理NLP中的一项关键任务。本文对近期文档级 IE 文献进行了系统回顾。此外,我们使用当前最先进的算法进行彻底的错误分析,并确定其局限性以及文档级 IE 任务的剩余挑战。根据我们的发现,标签噪声、实体共指解析和缺乏推理会严重影响文档级 IE 的性能。 |

| ChEDDAR: Student-ChatGPT Dialogue in EFL Writing Education Authors Jieun Han, Haneul Yoo, Junho Myung, Minsun Kim, Tak Yeon Lee, So Yeon Ahn, Alice Oh 生成式人工智能在教育中的整合正在扩大,但对学生与人工智能系统之间大规模、现实世界交互的实证分析仍然有限。在这项研究中,我们提出了 ChEDDAR、ChatGPT EFL 学习者对话数据集作为修改一篇论文,该数据集是从一个学期的纵向实验中收集的,涉及 212 名参加英语作为外语 EFL 写作课程的大学生。学生们被要求通过与 ChatGPT 的对话来修改他们的论文。 ChEDDAR 包括对话日志、话语级别论文编辑历史、自我评价满意度和学生意图,以及记录学生目标和整体体验的会话级别前后调查。我们根据学生的意图和满意度来分析学生对生成式人工智能的使用模式和看法。作为基础步骤,我们为教育背景下面向任务的对话系统中的两个关键任务建立了基线结果:意图检测和满意度估计。最后,我们建议进一步研究,以完善生成式人工智能与教育环境的整合,概述利用 ChEDDAR 的潜在场景。 |

| User Simulation with Large Language Models for Evaluating Task-Oriented Dialogue Authors Sam Davidson, Salvatore Romeo, Raphael Shu, James Gung, Arshit Gupta, Saab Mansour, Yi Zhang 开发新的面向任务的对话 TOD 系统的主要障碍之一是需要在开发过程的多个阶段和迭代进行人工评估。为了实现 TOD 的自动化评估,我们提出了一种使用最近开发的大型预训练语言模型 LLM 构建的新型用户模拟器。为了相对于之前的相关工作增加我们系统的语言多样性,我们没有在现有的 TOD 数据集上微调我们的系统使用的 LLM,而是在上下文学习中使用 LLM 来提示 LLM 生成稳健且语言多样化的输出模拟人类对话者行为的目标。与之前的工作不同,之前的工作寻求最大化目标成功率 GSR 作为模拟器性能的主要指标,我们的目标是实现一个与人类与 TOD 系统交互中观察到的 GSR 类似的系统。使用这种方法,我们当前的模拟器能够有效地与多个 TOD 系统进行交互,尤其是在单一意图的对话目标上,同时相对于以前依赖微调模型的模拟器生成词汇和句法上多样化的输出。 |

| NJUNLP's Participation for the WMT2023 Quality Estimation Shared Task Authors Xiang Geng, Zhejian Lai, Yu Zhang, Shimin Tao, Hao Yang, Jiajun Chen, Shujian Huang 我们介绍 NJUNLP 团队向 WMT 2023 质量估算 QE 共享任务提交的内容。我们的团队提交了对所有两个子任务的英语德语语言对的预测,即句子和单词级别质量预测以及细粒度错误跨度检测。 |

| Hindi to English: Transformer-Based Neural Machine Translation Authors Kavit Gangar, Hardik Ruparel, Shreyas Lele 机器翻译 MT 是自然语言处理 NLP 中最重要的任务之一,涉及将文本从一种自然语言自动转换为另一种自然语言,同时保留其含义和流畅性。尽管机器翻译的研究已经持续了几十年,但将深度学习技术集成到自然语言处理中的新方法已经导致翻译质量的显着提高。在本文中,我们通过训练 Transformer 模型开发了神经机器翻译 NMT 系统,将文本从印度语印地语翻译成英语。印地语是一种低资源语言,使得神经网络很难理解该语言,从而导致神经机器翻译器的发展缓慢。因此,为了解决这一差距,我们实施了反向翻译来增强训练数据,并为了创建词汇表,我们使用字节对编码 BPE 尝试了单词和子字级别的标记化,从而最终以 10 种不同的配置来训练 Transformer。 |

| A Practical Survey on Zero-shot Prompt Design for In-context Learning Authors Yinheng Li 大型语言模型 LLM 的显着进步带来了自然语言处理 NLP 任务的显着改进。本文对情境学习技术进行了全面回顾,重点关注不同类型的提示,包括离散、连续、少样本和零样本,以及它们对法学硕士表现的影响。我们探索各种提示设计方法,例如手动设计、优化算法和评估方法,以优化跨不同任务的法学硕士表现。我们的评论涵盖了即时工程的关键研究,讨论了它们的方法和对该领域的贡献。鉴于缺乏单一最佳提示以及考虑多个指标的重要性,我们还深入研究了评估提示性能所面临的挑战。 |

| Large Language Models and Control Mechanisms Improve Text Readability of Biomedical Abstracts Authors Zihao Li, Samuel Belkadi, Nicolo Micheletti, Lifeng Han, Matthew Shardlow, Goran Nenadic 生物医学文献经常使用复杂的语言和难以理解的专业术语。这就是为什么简化在提高公共卫生素养方面发挥着重要作用。应用自然语言处理 NLP 模型来自动执行此类任务,可以让非专业读者快速、直接地访问。在这项工作中,我们研究了最先进的大型语言模型法学硕士在生物医学摘要简化任务上的能力,使用公开可用的数据集对生物医学摘要 textbf PLABA 进行简单语言适应。应用的方法包括在 1 个编码器解码器模型 T5、SciFive 和 BART 上进行域微调和基于提示的学习 PBL,2 仅解码器 GPT 模型(来自 OpenAI 和 BioGPT 的 GPT 3.5 和 GPT 4),以及 3 基于 BART 模型的控制令牌机制。我们使用了一系列自动评估指标,包括 BLEU、ROUGE、SARI 和 BERTscore,并且还进行了人工评估。带有控制代币的 BART Large BART L w CT 机制报告了最高的 SARI 分数 46.54,T5 基础报告了最高的 BERTscore 72.62。在人类评估中,BART L w CT 比 T5 Base 取得了更好的简单性得分 2.9 vs. 2.2,而 T5 Base 取得了比 BART L w CT 更好的意义保留得分 3.1 vs. 2.6。我们还通过示例对系统输出进行了分类,希望这能为该任务的未来研究提供一些启示。 |

| Effective Distillation of Table-based Reasoning Ability from LLMs Authors Bohao Yang, Chen Tang, Kun Zhao, Chenghao Xiao, Chenghua Lin 大型语言模型法学硕士在广泛的自然语言处理任务中表现出了卓越的性能。然而,它们巨大的参数大小和对计算资源的高要求给它们的实际部署带来了挑战。最近的研究表明,法学硕士的特定能力(例如数值推理)可以通过蒸馏转移到更小的模型中。一些研究探讨了利用法学硕士执行基于表格的推理的潜力。然而,在我们的工作之前,还没有对专门为表格到文本生成任务量身定制的较小模型中专门的表格推理技能的前景进行过调查。在本文中,我们提出了一种新颖的基于表的推理蒸馏,目的是将 LLM 蒸馏为专门为基于表的推理任务设计的定制的较小模型。实验结果表明,使用蒸馏数据进行微调的 2.2 亿参数模型 Flan T5 基础,不仅比传统微调基线取得了显着改进,而且在科学表到文本生成数据集 SciGen 上超越了 gpt 3.5 Turbo 等特定 LLM。 |

| BenLLMEval: A Comprehensive Evaluation into the Potentials and Pitfalls of Large Language Models on Bengali NLP Authors Mohsinul Kabir, Mohammed Saidul Islam, Md Tahmid Rahman Laskar, Mir Tafseer Nayeem, M Saiful Bari, Enamul Hoque 大型语言模型法学硕士因其在语言生成和其他语言特定任务方面令人印象深刻的技能而成为自然语言处理 NLP 领域最重要的突破之一。尽管法学硕士已在各种任务中进行了评估,大部分是英语,但尚未对孟加拉语、孟加拉语等资源不足的语言进行彻底的评估。在本文中,我们评估了资源匮乏的孟加拉语的法学硕士的表现。我们选择各种重要且多样化的 Bangla NLP 任务,例如抽象摘要、问答、释义、自然语言推理、文本分类和情感分析,使用 ChatGPT、LLaMA 2 和 Claude 2 进行零样本评估,并将性能与状态进行比较艺术微调模型。 |

| Large Language Models Are Also Good Prototypical Commonsense Reasoners Authors Chenin Li, Qianglong Chen, Yin Zhang, Yifei Zhang, Hongxiang Yao 常识推理是大型语言模型的关键技能,但它在需要这种能力的特定任务中提出了持续的挑战。传统的微调方法可能是资源密集型的,并且可能会损害模型的泛化能力。此外,GPT 3.5 和 Claude 等最先进的语言模型主要可通过 API 调用访问,这使得微调模型具有挑战性。为了应对这些挑战,我们从定制任务的大型模型的输出中汲取灵感,并从多个角度半自动地开发了一组新颖的提示,包括任务相关性、支持性证据生成,例如思想和知识链,多样化的路径解码来帮助模型。 ProtoQA 数据集上的实验结果表明,通过更好设计的提示,我们可以在 ProtoQA 排行榜上实现新的最先进 SOTA,与之前相比,最大答案 1 分数提高 8,最大错误 1 分数提高 4 突破 50 SOTA模型并在StrategyQA和CommonsenseQA2.0上分别实现了3和1的改进。此外,通过生成的思想链和知识链,我们可以提高模型的可解释性,同时超越之前的 SOTA 模型。 |

| Cardiovascular Disease Risk Prediction via Social Media Authors Al Zadid Sultan Bin Habib, Md Asif Bin Syed, Md Tanvirul Islam, Donald A. Adjeroh 研究人员利用 Twitter 和情绪分析来预测心血管疾病 CVD 的风险。通过仔细研究推文中传达的情绪,我们引入了一种新颖的 CVD 相关关键词词典。我们收集了来自美国十八个州(包括阿巴拉契亚地区)的推文。我们采用 VADER 模型进行情绪分析,将用户归类为潜在的 CVD 风险人群。机器学习 ML 模型用于评估个人 CVD 风险,随后应用于包含人口统计信息的 CDC 数据集以进行比较。我们考虑了各种性能评估指标,包括测试准确率、精确率、召回率、F1 分数、Mathew 相关系数 MCC 和 Cohen s Kappa CK 分数。我们的研究结果表明,分析推文的情感内容优于单独人口统计数据的预测能力,从而能够识别具有罹患心血管疾病潜在风险的个人。 |

| SPICED: News Similarity Detection Dataset with Multiple Topics and Complexity Levels Authors Elena Shushkevich, Long Mai, Manuel V. Loureiro, Steven Derby, Tri Kurniawan Wijaya 如今,随着新闻媒体的激增,为了增强用户体验,使用智能系统来检测新闻文章中的冗余信息变得尤为普遍。然而,新闻的异质性可能会导致这些系统中出现虚假的结果。简单的启发式方法,例如一对新闻是否都与政治有关,可以提供强大但具有欺骗性的下游性能。将新闻相似性数据集分割成主题,迫使这些模型学习如何区分更狭窄领域下的显着特征,从而改善了这些模型的训练。然而,这需要存在特定于主题的数据集,而目前缺乏这种数据集。在本文中,我们提出了一个新的类似新闻数据集 SPICED,其中包括犯罪法、文化娱乐、灾难事故、经济商业、政治冲突、科学技术和体育七个主题。此外,我们提出了四种不同的生成新闻对的方法,这些方法用于创建专门为新闻相似性检测任务设计的数据集。 |

| MiChao-HuaFen 1.0: A Specialized Pre-trained Corpus Dataset for Domain-specific Large Models Authors Yidong Liu, Conghui He, Conghui He, Wei Li, FuKai Shang, Jun Wang, Yao Li, Rui Xu 随着深度学习技术的进步,GPT 4 等通用大型模型已经在各个领域展示了卓越的功能。尽管如此,医疗保健、法律和金融等领域仍然需要高质量、特定领域的产出。本文首先评估了现有的专业领域大型模型并讨论了它们的局限性。为了满足某些领域的特定需求,我们推出了米巢话分1.0预训练语料数据集,专为新闻和政府部门量身定制。该数据集源自 2022 年公开的互联网数据,经过多轮清理和处理,以确保高质量和可靠的来源,并提供一致和稳定的更新。 |

| Weakly Supervised Reasoning by Neuro-Symbolic Approaches Authors Xianggen Liu, Zhengdong Lu, Lili Mou 深度学习极大地提高了各种自然语言处理 NLP 任务的性能。然而,大多数深度学习模型都是黑盒机制,缺乏明确的解释。在本章中,我们将介绍 NLP 的神经符号方法的最新进展,该方法结合了不同的人工智能流派,即符号主义和联结主义。一般来说,我们会为 NLP 任务设计一个具有符号潜在结构的神经系统,并应用强化学习或其松弛在下游任务中执行弱监督推理。我们的框架已成功应用于各种任务,包括表查询推理、句法结构推理、信息提取推理和规则推理。 |

| Machine Learning Technique Based Fake News Detection Authors Biplob Kumar Sutradhar, Md. Zonaid, Nushrat Jahan Ria, Sheak Rashed Haider Noori 虚假新闻受到公众和学术界的关注。此类虚假信息有能力影响公众的看法,使邪恶团体有机会影响选举等公共事件的结果。任何人都可以为了个人利益或给某人带来麻烦而分享有关任何人或任何事物的虚假新闻或事实。此外,信息根据其共享的世界地区的不同而有所不同。因此,在本文中,我们利用收集的数据集中的 1876 条新闻数据训练了一个模型来分类假新闻和真新闻。我们按照自然语言处理方法对数据进行了预处理,以获得干净且经过过滤的文本。我们的研究采用 3 种流行的机器学习随机梯度下降、朴素贝叶斯、逻辑回归和 2 种深度学习长短期记忆、ASGD 权重下降 LSTM 或 AWD LSTM 算法。 |

| Personality Profiling: How informative are social media profiles in predicting personal information? Authors Joshua Watt, Jonathan Tuke, Lewis Mitchell 性格分析已被公司用于有针对性的广告、政治活动和疫苗活动。然而,此类模型的准确性和多功能性仍然相对未知。因此,我们的目标是探索人们的在线数字足迹在多大程度上可以用来描述他们的迈尔斯·布里格斯性格类型。我们分析并比较了逻辑回归、朴素贝叶斯、支持向量机 SVM 和随机森林四种模型的结果。我们发现 SVM 模型在预测某人的完整人格类型方面达到了 20.95 的最佳准确度。然而,逻辑回归模型的性能仅稍差一些,并且训练和执行预测的速度要快得多。我们发现许多标记数据集在社交媒体上呈现出严重的个人特征类别不平衡,包括我们自己。因此,我们强调在报告这些数据集上的模型性能时需要仔细考虑,并比较多种解决类别不平衡问题的方法。此外,我们开发了一个统计框架来评估模型中不同特征集的重要性。我们发现 Intuitive Sensory p 0.032 和 Thinking Feeling p 0.019 模型中的某些特征比其他特征提供更多信息。 |

| Applying BioBERT to Extract Germline Gene-Disease Associations for Building a Knowledge Graph from the Biomedical Literature Authors Armando D. Diaz Gonzalez, Songhui Yue, Sean T. Hayes, Kevin S. Hughes 已发表的生物医学信息已经并将继续快速增加。自然语言处理 NLP 的最新进展引起了人们对基因和疾病等实体生物医学知识的自动化提取、标准化和表示的极大兴趣。我们的研究分析了在基因和疾病领域所做的大量工作的知识图谱构建中的种系摘要。本文提出了 SimpleGermKG,一种连接种系基因和疾病的自动知识图构建方法。为了提取基因和疾病,我们采用 BioBERT,这是一种在生物医学语料库上预先训练的 BERT 模型。我们提出了一种基于本体和基于规则的算法来标准化和消除医学术语的歧义。对于文章、基因和疾病之间的语义关系,我们实现了一种部分整体关系方法,将每个实体与其数据源连接起来,并在基于图形的知识表示中将它们可视化。最后,我们讨论知识图谱的应用、局限性和挑战,以启发生殖系语料库的未来研究。我们的知识图包含 297 个基因、130 种疾病和 46,747 个三元组。 |

| DeepSpeed-VisualChat: Multi-Round Multi-Image Interleave Chat via Multi-Modal Causal Attention Authors Zhewei Yao, Xiaoxia Wu, Conglong Li, Minjia Zhang, Heyang Qi, Olatunji Ruwase, Ammar Ahmad Awan, Samyam Rajbhandari, Yuxiong He 大多数现有的多模态模型由于无法熟练地管理多图像、多轮对话中的交错图像和文本输入而受到阻碍,在培训和数据可访问性的资源分配方面面临着巨大的限制,影响了它们在不同交互领域的适应性和可扩展性。为了解决这个问题,我们提出了 DeepSpeed VisualChat 框架,旨在通过整合多模式功能来优化大型语言模型法学硕士,重点是提高大型视觉和语言模型在处理交错输入方面的熟练程度。我们的框架值得注意的是 1 对多轮和多图像对话的开源支持,2 引入了创新的多模式因果注意机制,3 在现有数据集上利用数据混合技术来确保多轮、多图像对话中的无缝交互。 |

| Towards General-Purpose Text-Instruction-Guided Voice Conversion Authors Chun Yi Kuan, Chen An Li, Tsu Yuan Hsu, Tse Yang Lin, Ho Lam Chung, Kai Wei Chang, Shuo yiin Chang, Hung yi Lee 本文介绍了一种新颖的语音转换 VC 模型,该模型由文本指令引导,例如用低沉的语气缓慢地发音或用欢快的孩子气的声音说话。与依赖参考话语来确定转换后语音的属性的传统方法不同,我们的模型为语音转换增加了多功能性和特异性。所提出的 VC 模型是一种神经编解码器语言模型,它处理离散代码序列,产生转换后的语音的代码序列。它利用文本指令作为风格提示来修改给定语音的韵律和情感信息。以前的方法通常依赖于使用单独的编码器(如韵律和内容编码器)来处理源语音的不同方面,与此相反,我们的模型以端到端的方式处理语音的各种信息。 |

| Autonomous Vehicles an overview on system, cyber security, risks, issues, and a way forward Authors Md Aminul Islam 1 , Sarah Alqahtani, 2 1 Oxford Brookes University, UK, 2 Oxford Brookes University, UK 本章探讨自动驾驶汽车的复杂领域,分析其基本组件和操作特征。讨论的初始阶段是阐明这些汽车的内部机制,包括传感器、人工智能识别系统、控制机制的关键参与,以及它们在物联网框架内与基于云的服务器的集成。它深入研究了自动驾驶汽车的实际实施,强调它们在预测交通模式和改变交通动态方面的应用。本文还探讨了机器人流程自动化 RPA 的主题,通过任务自动化说明自动驾驶汽车对不同业务的影响。这项调查的主要焦点在于网络安全领域,特别是在自动驾驶汽车的背景下。将进行全面分析,探索各种风险管理解决方案,旨在保护这些车辆免受道德、环境、法律、专业和社会等方面的潜在威胁,并对其社会影响提供全面的视角。应对挑战的战略计划并提出有效穿越自动驾驶汽车系统、网络安全、危险和其他问题的复杂地形的战略计划,是了解自动驾驶汽车复杂领域及其对当代社会影响的一些资源,支持 |

| On the Relation between Internal Language Model and Sequence Discriminative Training for Neural Transducers Authors Zijian Yang, Wei Zhou, Ralf Schl ter, Hermann Ney 内部语言模型 ILM 减法已被广泛应用于提高 RNN Transducer 与外部语言模型 LM 融合的性能,用于语音识别。在这项工作中,我们从理论和实证角度证明序列判别训练与 ILM 减法具有很强的相关性。理论上,我们推导出最大互信息 MMI 训练的全局最优与 ILM 减法具有相似的公式。根据经验,我们表明 ILM 减法和序列判别训练在 Librispeech 上的各种实验中实现了相似的性能,包括 MMI 和最小贝叶斯风险 MBR 标准,以及完整和有限上下文的神经传感器和 LM。经过序列判别训练后,ILM 减法的好处也变得小很多。 |

| Wav2vec-based Detection and Severity Level Classification of Dysarthria from Speech Authors Farhad Javanmardi, Saska Tirronen, Manila Kodali, Sudarsana Reddy Kadiri, Paavo Alku 直接从声学语音信号自动检测构音障碍并对其严重程度进行分类可以用作医学诊断的工具。在这项工作中,研究了预训练的 wav2vec 2.0 模型作为特征提取器,以构建构音障碍语音的检测和严重程度分类系统。实验是在常用的UA语音数据库上进行的。在检测实验中,结果表明,使用 wav2vec 模型第一层的嵌入获得了最佳性能,与性能最佳的基线特征谱图相比,准确率绝对提高了 1.23。 |

| Analysis and Detection of Pathological Voice using Glottal Source Features Authors Sudarsana Reddy Kadiri, Paavo Alku 自动检测声音病理可以实现客观评估和早期干预诊断。本研究对声门源特征进行了系统分析,并研究了它们在语音病理检测中的有效性。使用准闭相QCP声门逆滤波方法估计的声门流、使用零频率滤波ZFF方法计算的近似声门源信号以及直接使用声学语音信号来提取声门源特征。此外,我们建议从 QCP 和 ZFF 计算的声门源波形中导出梅尔频率倒谱系数 MFCC,以有效捕获病态声音声门源频谱的变化。实验使用两个数据库进行:阿斯图里亚斯普林西比大学医院 HUPA 数据库和萨尔布吕肯语音障碍 SVD 数据库。特征分析表明,声门源包含区分正常声音和病态声音的信息。采用支持向量机SVM进行病理检测实验。从检测实验中可以看出,所研究的声门源特征所实现的性能与传统 MFCC 和感知线性预测 PLP 特征相当或更好。 |

| Connecting Speech Encoder and Large Language Model for ASR Authors Wenyi Yu, Changli Tang, Guangzhi Sun, Xianzhao Chen, Tian Tan, Wei Li, Lu Lu, Zejun Ma, Chao Zhang 大型语言模型 LLM 令人印象深刻的功能和多功能性引起了自动语音识别 ASR 越来越多的关注,一些开创性的研究试图通过将语音编码器与 LLM 连接来构建集成的 ASR 模型。本文对三种常用的连接器结构进行了比较研究,包括全连接层、多头交叉注意力和 Q Former。研究了 Whisper 模型系列的语音编码器以及具有不同模型尺寸的 Vicuna 模型系列的 LLM。在常用的 LibriSpeech、Common Voice 和 GigaSpeech 数据集上进行了实验,其中使用 Q Forms 的法学硕士比使用其他连接器结构的法学硕士表现出一致且显着的单词错误率 WER 降低。 Q 基于前人的 LLM 可以很好地推广到域外数据集,在 Eval2000 测试集上,在不使用 Switchboard 的任何域内训练数据的情况下,比 Whisper 基线 ASR 模型实现了 12 个相对 WER 减少。 |

| VidChapters-7M: Video Chapters at Scale Authors Antoine Yang, Arsha Nagrani, Ivan Laptev, Josef Sivic, Cordelia Schmid 将长视频分成章节使用户能够快速导航到他们感兴趣的信息。由于缺乏公开发布的数据集,这一重要主题尚未得到充分研究。为了解决这个问题,我们提出了 VidChapters 7M,这是一个包含 817K 个用户章节视频的数据集,总共包括 700 万个章节。 VidChapters 7M 是通过抓取用户注释的章节,以可扩展的方式从在线视频自动创建的,因此无需任何额外的手动注释。我们根据这些数据介绍以下三个任务。首先,视频章节生成任务包括对视频进行时间分段并为每个片段生成章节标题。为了进一步剖析这个问题,我们还定义了该任务的两个变体:给定真实边界的视频章节生成,这需要在给定带注释的视频片段的情况下生成章节标题;以及视频章节接地,这需要在给定带注释的标题的情况下对章节进行时间本地化。我们针对这三项任务对简单的基线和最先进的视频语言模型进行了基准测试。我们还表明,VidChapters 7M 上的预训练在零镜头和微调设置下都能很好地转移到密集视频字幕任务,很大程度上提高了 YouCook2 和 ViTT 基准的最新水平。最后,我们的实验表明,下游性能随着预训练数据集的大小而很好地扩展。 |

| TouchUp-G: Improving Feature Representation through Graph-Centric Finetuning Authors Jing Zhu, Xiang Song, Vassilis N. Ioannidis, Danai Koutra, Christos Faloutsos 我们如何增强从预训练模型 PM 获取的节点特征,以更好地适应下游图学习任务 图神经网络 GNN 已成为许多高影响力的现实世界图应用程序的最先进方法。对于特征丰富的图,普遍的做法是直接利用 PM 来生成特征,而不结合任何域适应技术。然而,这种做法并不是最优的,因为从 PM 中提取的节点特征与图无关,并且阻止 GNN 充分利用图结构和节点特征之间的潜在相关性,从而导致 GNN 性能下降。在这项工作中,我们寻求改进从 PM 获得的用于下游图任务的节点特征,并引入 TOUCHUP G,它有几个优点。它一般适用于任何下游图形任务,包括推荐系统中经常采用的链接预测 b 多模态能够改进任何模态的原始特征,例如原则上它与一个新的度量特征同质性密切相关,我们建议量化图结构和节点特征之间的潜在相关性,并且我们表明 TOUCHUP G 可以有效缩小图结构和节点特征之间的差异 |

| VoiceLDM: Text-to-Speech with Environmental Context Authors Yeonghyeon Lee, Inmo Yeon, Juhan Nam, Joon Son Chung 本文提出了 VoiceLDM,这是一种旨在生成音频的模型,它可以准确地遵循两种不同的自然语言文本提示:描述提示和内容提示。前者提供有关音频整体环境背景的信息,而后者则传达语言内容。为了实现这一目标,我们采用基于潜在扩散模型的文本到音频 TTA 模型,并扩展其功能以纳入额外的内容提示作为条件输入。通过利用预训练的对比语言音频预训练 CLAP 和 Whisper,VoiceLDM 可以在大量现实世界音频上进行训练,而无需手动注释或转录。此外,我们采用双分类器自由引导来进一步增强 VoiceLDM 的可控性。实验结果表明,VoiceLDM 能够生成与两种输入条件均吻合的可信音频,甚至超过了 AudioCaps 测试集上真实音频的语音清晰度。此外,我们还探索了 VoiceLDM 的文本转语音 TTS 和零镜头文本转音频功能,并表明它取得了有竞争力的结果。 |

| EvalLM: Interactive Evaluation of Large Language Model Prompts on User-Defined Criteria Authors Tae Soo Kim, Yoonjoo Lee, Jamin Shin, Young Ho Kim, Juho Kim 通过简单地编写提示,开发人员可以使用大型语言模型法学硕士构建新颖的生成应用程序原型。然而,为了将原型细化为产品,开发人员必须通过评估输出来诊断弱点来迭代修改提示。形成性访谈 N 8 显示,开发人员在评估特定上下文和主观标准时,在手动评估输出方面投入了大量精力。我们提出了 EvalLM,这是一个交互式系统,用于通过根据用户定义的标准评估多个输出来迭代地完善提示。通过用自然语言描述标准,用户可以使用系统基于 LLM 的评估器来概述提示的优点或失败之处,并根据评估器的反馈进行改进。一项比较研究 N 12 表明,与手动评估相比,EvalLM 帮助参与者制定更多样化的标准,检查两倍的输出,并以减少 59 次修改的方式达到满意的提示。 |

| The Study of Perceptual Training of Chinese Mandarin Tones for Monolingual Speakers of English Using Adaptive Computer Based Training Software Authors Yuke Wang |

| D-Separation for Causal Self-Explanation Authors Wei Liu, Jun Wang, Haozhao Wang, Ruixuan Li, Zhiying Deng, YuanKai Zhang, Yang Qiu 合理化是 NLP 模型的一个自我解释框架。传统工作通常使用最大互信息 MMI 标准来查找最能指示目标标签的基本原理。然而,该标准可能会受到与因果原理或目标标签相关的虚假特征的影响。我们没有试图纠正 MMI 标准的问题,而是提出了一种新的标准来揭示因果原理,称为最小条件依赖 MCD 标准,该标准基于我们的发现,即非因果特征和目标标签是分开的由因果原理。通过最小化输入的未选择部分与以所选候选理由为条件的目标标签之间的依赖性,必须选择标签的所有原因。在本研究中,我们采用了一种简单实用的依赖性测量方法,特别是 KL 散度,来验证我们提出的 MCD 标准。根据经验,我们证明,与之前最先进的基于 MMI 的方法相比,MCD 将 F1 分数提高了 13.7。 |

| Natural Language Processing for Requirements Formalization: How to Derive New Approaches? Authors Viju Sudhi, Libin Kutty, Robin Gr pler 尽可能自动化软件开发和测试过程是工业界和研究界长期以来的愿望。在此过程中,需求工程 RE 在其基础上的所有其他步骤中发挥着基础作用。基于模型的设计和测试方法已经被开发出来,以应对软件系统日益增长的复杂性和可变性。然而,根据以自然语言提供的大量功能需求来创建规范模型仍然需要付出巨大的努力。文献中已经提出了许多基于自然语言处理 NLP 的方法,主要使用句法属性来生成需求模型。 NLP 的最新进展表明,语义量也可以被识别并用于在需求形式化过程中提供更好的帮助。在这项工作中,我们提出并讨论了 NLP 领域的主要思想和最先进的方法,以指导读者如何根据其特定用例创建一套半自动化需求形式化的规则和方法和需求。我们详细讨论了两种不同的方法,并强调了规则集的迭代开发。需求模型以伪代码的形式以人类和机器可读的格式表示。所提出的方法在汽车和铁路领域的两个工业用例中进行了演示。它表明,使用当前预先训练的 NLP 模型需要更少的精力来创建一组规则,并且可以轻松适应特定的用例和领域。 |

| Towards Lexical Analysis of Dog Vocalizations via Online Videos Authors Yufei Wang, Chunhao Zhang, Jieyi Huang, Mengyue Wu, Kenny Zhu 破译动物语言的语义一直是一个巨大的挑战。这项研究通过将不同的声音类型与一致的语义相关联,对狗发声的语义进行了数据驱动的调查。我们首先提出一个新的柴犬声音数据集,以及位置和活动等上下文信息,这些信息是通过精心构建的管道从 YouTube 收集的。该框架也适用于其他动物物种。基于对狗发声与相应位置和活动之间的条件概率的分析,我们发现了先前对各种狗声音语义的启发式研究的支持证据。例如,咆哮可以表示互动。此外,我们的研究得出了新的见解,即现有的单词类型可以细分为更细粒度的子类型,并且柴犬的最小语义单位与单词相关。 |

| SCREWS: A Modular Framework for Reasoning with Revisions Authors Kumar Shridhar, Harsh Jhamtani, Hao Fang, Benjamin Van Durme, Jason Eisner, Patrick Xia 大型语言模型法学硕士可以根据反馈迭代地完善和修改其输出,从而提高其在各种任务上的准确性。我们观察到这些修订可能会引入错误,在这种情况下最好回滚到以前的结果。此外,修订通常是同质的,它们使用产生初始答案的相同推理方法,这可能无法纠正错误。为了实现这一领域的探索,我们提出了 SCREWS,这是一个用于推理和修订的模块化框架。它由三个主要模块组成:采样、条件重采样和选择,每个模块都包含可以根据任务手动选择的子模块。我们证明 SCREWS 不仅将以前的几种方法统一在一个通用框架下,而且还揭示了几种用于识别改进推理链的新颖策略。我们使用最先进的 LLM ChatGPT 和 GPT 4 在一组不同的推理任务上评估我们的框架,并为每个算术单词问题、多跳问答和代码调试发现有用的新推理策略。 |

| Using Large Language Models to Generate, Validate, and Apply User Intent Taxonomies Authors Chirag Shah, Ryen W. White, Reid Andersen, Georg Buscher, Scott Counts, Sarkar Snigdha Sarathi Das, Ali Montazer, Sathish Manivannan, Jennifer Neville, Xiaochuan Ni, Nagu Rangan, Tara Safavi, Siddharth Suri, Mengting Wan, Leijie Wang, Longqi Yang 日志数据可以揭示有关用户如何与网络搜索服务交互、他们想要什么以及他们的满意度的有价值的信息。然而,分析日志数据中的用户意图并不容易,特别是对于人工智能驱动的聊天等新形式的网络搜索。为了从日志数据中了解用户意图,我们需要一种方法来用有意义的类别来标记它们,以捕获它们的多样性和动态。现有方法依赖于手动或基于机器学习的标记,对于大型且不断变化的数据集来说,这些标记要么成本昂贵,要么不灵活。我们提出了一种使用大型语言模型 LLM 的新颖解决方案,它可以为用户意图生成丰富且相关的概念、描述和示例。然而,使用 LLM 生成用户意图分类法并将其应用于日志分析可能会出现问题,原因有两个,例如分类法未经外部验证,并且可能存在不良的反馈循环。为了克服这些问题,我们与人类专家和评估员一起提出了一种新的方法来验证法学硕士生成的分类法的质量。我们还提出了一个端到端管道,该管道使用法学硕士和人在循环中来生成、细化和使用标签来进行日志数据中的用户意图分析。我们的方法提供了一种可扩展且适应性强的方法,以最少的人力来分析网络规模日志数据中的用户意图。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com

这篇关于【AI视野·今日NLP 自然语言处理论文速览 第四十一期】Tue, 26 Sep 2023的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!