本文主要是介绍论文解读 MTL-NAS: Task-Agnostic Neural Architecture Search towards General-Purpose Multi-Task Learning,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

总结

此篇论文2020年发表于CVPR,可以说是多任务的神经网络结构搜索的经典之作。其侧重于寻找任务之间的相互关系,是一种任务无关的结构搜索方法。其特点大致如下:

- 使用基于单次梯度的搜索方法。

- 定义了基于节点的搜索空间。

- 提出使用熵最小化使模型收敛于某个结构。

方法总览

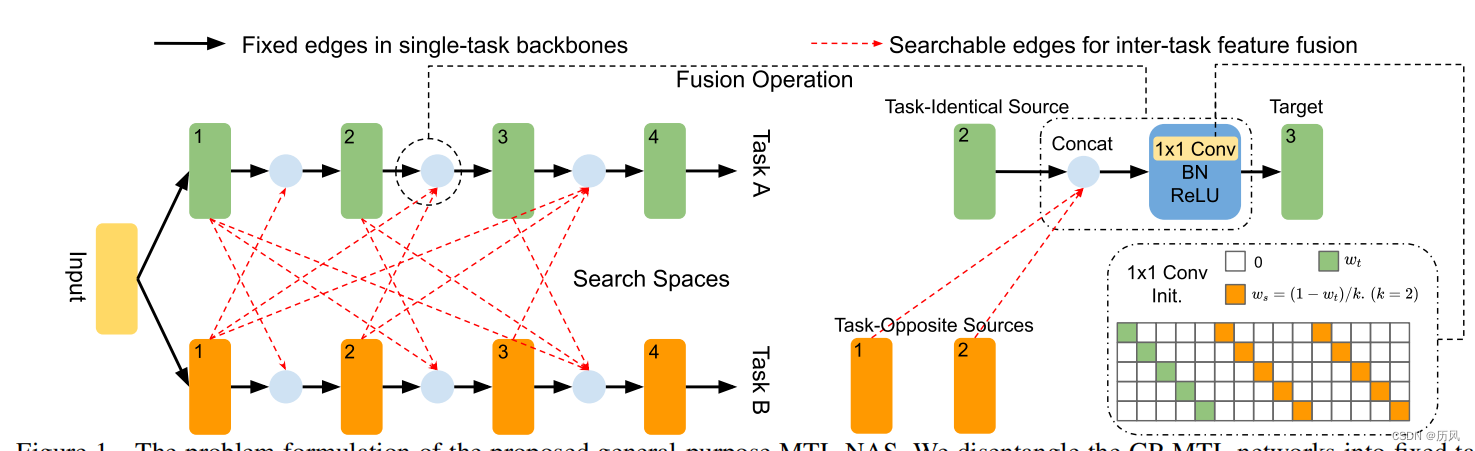

具体来说,多个固定的单任务网络分支开始,将每个中间层表示为一个节点,将相关的特征融合操作表示为一条边。因此,问题变成了寻找任务间节点对之间的最佳边,其中搜索空间对于任何任务集都是统一的。

搜索算法

提出了一种新颖的基于梯度的单次搜索算法。它缓解了搜索阶段和评估阶段之间的性能差距。通过对架构权重施加最小熵正则化来实现这一点。这使架构混合能够收敛到单个模型/架构,这将直接用于评估,而无需架构修剪或从头开始重新训练。

融合方法

其实是仿照NDDR,好多废话,tmd。

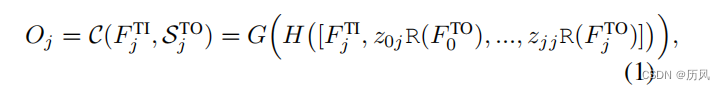

Z表示有没有这条边,R是对特征图的大小变换。我们想要融合只能是先把大小统一然后再用1*1来统一通道,所以这是一个意思。

训练

一旦上述迭代收敛,架构以及模型权重就可以直接用于评估,而无需从头开始(重新)

训练模型权重。这是因为所提出的最小熵正则化使搜索优化能够收敛到单个网络。减轻了 DARTS 中的客观偏差和SNAS 中的抽样方差。这是通过对架构权重α ij 进行统一、简单和有效(在消融部分验证)最小熵正则化来实现的。

实验

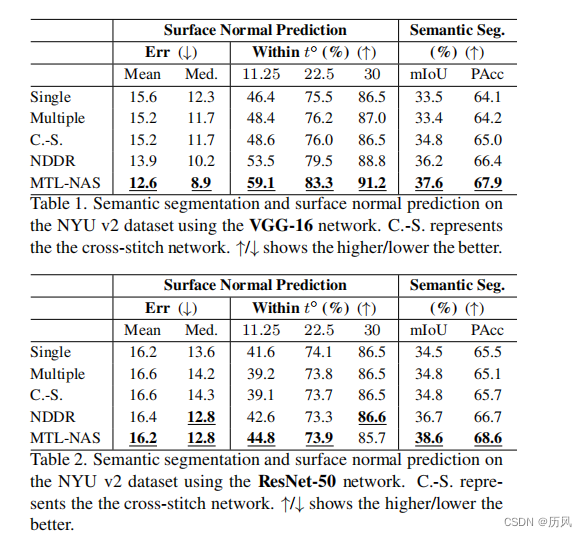

Single和Multiple这是因为本来就是一样的东西。因此指标几乎相同。

MTL-NAS的PACC很高,很难超越。

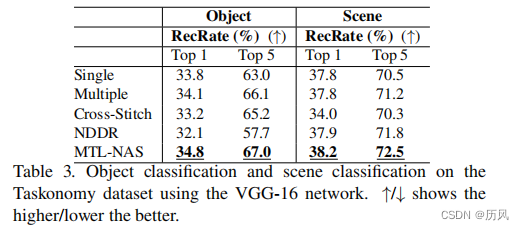

这是在另外一个数据集做的实验,据说比Imagenet大三倍,只能说有钱为所欲为。

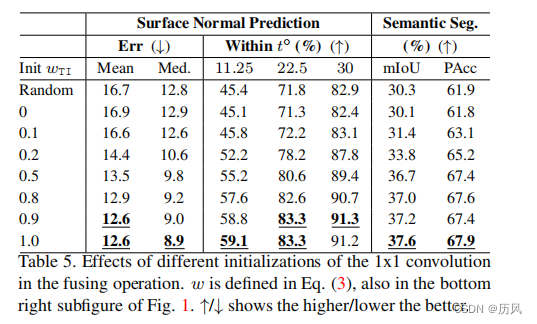

实验还评估了对1*1卷积初始化的影响,说明新加入的层的初始化很重要。

这篇关于论文解读 MTL-NAS: Task-Agnostic Neural Architecture Search towards General-Purpose Multi-Task Learning的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!