本文主要是介绍Python之天龙八部词云生成分析,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Python之天龙八部词云生成分析

今天接触到了一个中文分词神奇–结巴分词。做自然语言处理的同志们应该都接触过这个强大的分词神器。本人基于该分词神器以及word_cloud做了一个天龙八部词云分析。

直接上代码:

#coding:utf-8import jieba

from wordcloud import WordCloud f = open(u'天龙八部.txt','r').read()

s = {}

f = jieba.cut(f)

for w in f:if len(w) > 1:previous_count = s.get(w,0)s[w] = previous_count+1word = sorted(s.items(),key=lambda (word,count):count, reverse = True)

word = word[1:100]

#print word[:100]

wordcloud = WordCloud(font_path = 'MSYH.TTF').fit_words(word)

import matplotlib.pyplot as plt

plt.imshow(wordcloud)

plt.axis("off")

plt.show()

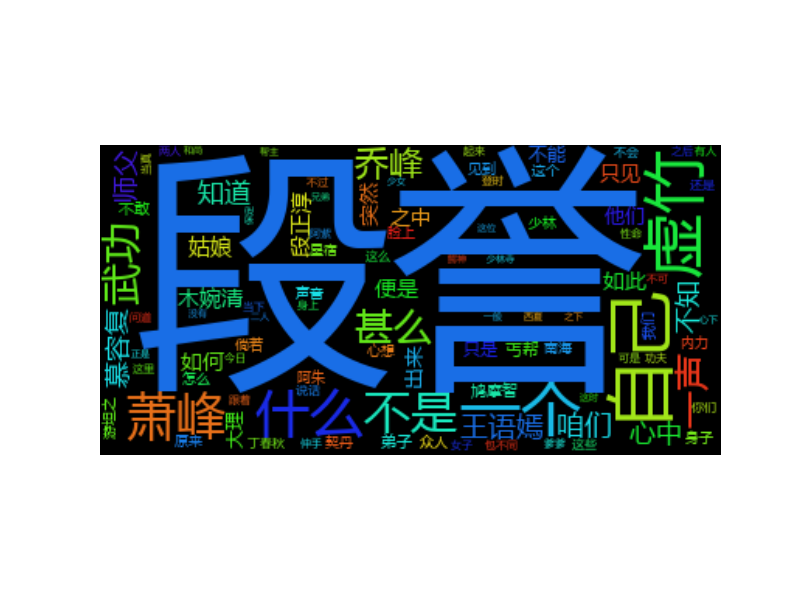

最终的结果是:

这篇关于Python之天龙八部词云生成分析的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!