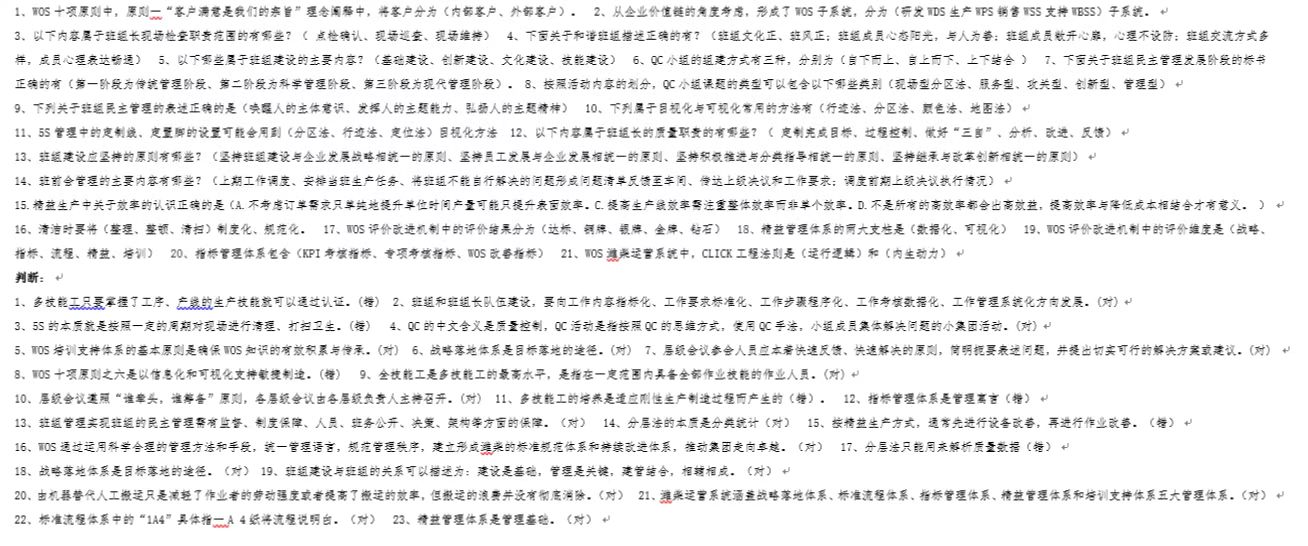

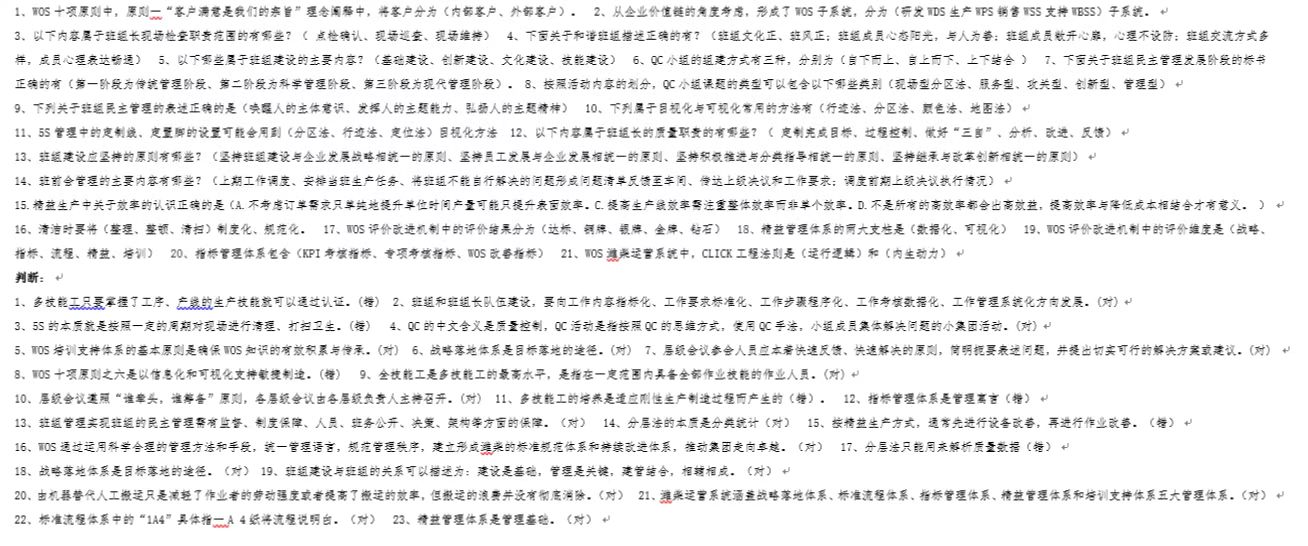

https://www.wenjuan.com/assess/exam/exam_result/619b366ffd631ed4d9b16cef?pid=619b366ffd631ed4d9b16cef&rid=6348ed16174d2392f88a2f76&from_source=answer

本文主要是介绍WOS,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

https://www.wenjuan.com/assess/exam/exam_result/619b366ffd631ed4d9b16cef?pid=619b366ffd631ed4d9b16cef&rid=6348ed16174d2392f88a2f76&from_source=answer

这篇关于WOS的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

原文地址:https://blog.csdn.net/HAIFEI666/article/details/127328741

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.chinasem.cn/article/318454。

如若内容造成侵权/违法违规/事实不符,请联系我们进行投诉反馈,一经查实,立即删除!我们的邮箱:23002807@qq.com