本文主要是介绍【AI视野·今日CV 计算机视觉论文速览 第264期】Tue, 10 Oct 2023,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

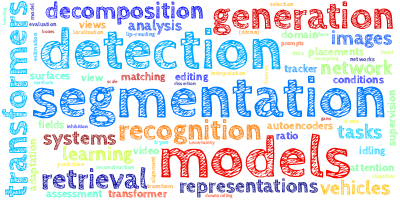

AI视野·今日CS.CV 计算机视觉论文速览

Tue, 10 Oct 2023 (showing first 100 of 188 entries)

Totally 100 papers

👉上期速览✈更多精彩请移步主页

Daily Computer Vision Papers

| FLATTEN: optical FLow-guided ATTENtion for consistent text-to-video editing Authors Yuren Cong, Mengmeng Xu, Christian Simon, Shoufa Chen, Jiawei Ren, Yanping Xie, Juan Manuel Perez Rua, Bodo Rosenhahn, Tao Xiang, Sen He 文本到视频编辑的目的是根据文本提示编辑源视频的视觉外观。此任务的一个主要挑战是确保编辑视频中的所有帧在视觉上一致。最近的作品通过将 U Net 中的 2D 空间注意力扩展到时空注意力,将高级文本图像扩散模型应用于此任务。尽管可以通过时空注意力添加时间上下文,但它可能会为每个补丁引入一些不相关的信息,从而导致编辑后的视频不一致。在本文中,我们首次将光流引入扩散模型 U Net 中的注意力模块中,以解决文本到视频编辑的不一致问题。我们的方法 FLATTEN 强制不同帧的同一流路径上的补丁在注意力模块中相互关注,从而提高编辑视频的视觉一致性。此外,我们的方法是免费培训的,可以无缝集成到任何基于扩散的文本到视频编辑方法中,并提高其视觉一致性。现有文本到视频编辑基准的实验结果表明,我们提出的方法实现了新的最先进的性能。 |

| SimPLR: A Simple and Plain Transformer for Object Detection and Segmentation Authors Duy Kien Nguyen, Martin R. Oswald, Cees G. M. Snoek 检测不同尺度图像中的物体的能力在现代物体检测器的设计中发挥了关键作用。尽管在使用 Transformer 去除手工组件方面取得了相当大的进展,但多尺度特征图仍然是其经验成功的关键因素,即使有像 Vision Transformer ViT 这样的简单主干。在本文中,我们表明这种对特征金字塔的依赖是不必要的,并且具有尺度感知注意力的基于变压器的检测器使得普通检测器 SimPLR 能够运行,其主干和检测头都在单尺度特征上运行。简单的架构允许 SimPLR 有效地利用自监督学习和 ViT 扩展方法的优势,与多规模同行相比,产生强大的性能。我们通过实验证明,当扩展到更大的主干时,SimPLR 表现出比端到端检测器 Mask2Former 和普通主干检测器 ViTDet 更好的性能,同时始终更快。 |

| Interpreting CLIP's Image Representation via Text-Based Decomposition Authors Yossi Gandelsman, Alexei A. Efros, Jacob Steinhardt 我们通过分析各个模型组件如何影响最终表示来研究 CLIP 图像编码器。我们将图像表示分解为各个图像块、模型层和注意力头的总和,并使用 CLIP 的文本表示来解释加数。在解释注意力头时,我们通过自动查找跨越其输出空间的文本表示来表征每个头的角色,这揭示了许多头的属性特定角色,例如位置或形状。接下来,通过解释图像块,我们发现了 CLIP 中出现的空间定位。最后,我们利用这种理解从 CLIP 中删除虚假特征并创建强大的零样本图像分割器。 |

| Controllable Chest X-Ray Report Generation from Longitudinal Representations Authors Francesco Dalla Serra, Chaoyang Wang, Fani Deligianni, Jeffrey Dalton, Alison Q O Neil 放射学报告是医学扫描内容的详细文字描述。每份报告都描述了相关临床发现的存在、缺失和位置,通常包括与同一患者之前的检查进行比较,以描述其演变过程。放射学报告是一个耗时的过程,扫描结果通常会延迟。加快报告速度的一种策略是集成自动化报告系统,但临床部署需要高精度和可解释性。以前的自动放射学报告方法通常不提供先前的研究作为输入,排除了某些类型扫描的临床准确性所需的比较,并且仅提供不可靠的解释方法。因此,利用现有的解剖标记视觉输入格式,我们引入了两个新颖的方面:1纵向表示学习,我们输入先前的扫描作为附加输入,提出一种将当前和先前的视觉信息对齐、连接和融合成联合纵向的方法。可以提供给多模式报告生成模型的表示 2 句子解剖学 dropout 可控性的训练策略,其中训练报告生成器模型以仅预测原始报告中与作为输入给出的解剖区域子集相对应的句子。 |

| Geom-Erasing: Geometry-Driven Removal of Implicit Concept in Diffusion Models Authors Zhili Liu, Kai Chen, Yifan Zhang, Jianhua Han, Lanqing Hong, Hang Xu, Zhenguo Li, Dit Yan Yeung, James Kwok 通过个性化数据集微调扩散模型是提高下游任务生成质量的公认方法,然而,由于特定下游任务中图像源和收集方法的限制,这种方法经常会无意中生成水印和二维码等意想不到的概念。现有的解决方案无法消除这些无意学习的隐含概念,这主要是由于依赖于模型识别它实际上无法辨别的概念的能力。在这项工作中,我们引入了 methodname,这是一种新颖的方法,它可以通过附加的可访问分类器或检测器模型将这些概念的几何信息编码到文本域中,成功地删除隐式概念。此外,我们提出了 textit Implicit Concept ,这是一种新颖的图像文本数据集,其中充满了三个隐式概念,即水印、QR 码和用于训练和评估的文本。实验结果表明,methodname不仅可以识别而且可以有效地消除隐含概念,与现有方法相比有显着改进。 |

| ViCor: Bridging Visual Understanding and Commonsense Reasoning with Large Language Models Authors Kaiwen Zhou, Kwonjoon Lee, Teruhisa Misu, Xin Eric Wang 在我们的工作中,我们探索了预训练的视觉和语言模型 VLM 以及用于视觉常识推理 VCR 的大型语言模型 LLM 的协同能力。我们将VCR问题分为视觉常识理解VCU和视觉常识推理VCI。对于涉及感知文字视觉内容的 VCU,预训练的 VLM 表现出强大的跨数据集泛化能力。另一方面,在 VCI 中,目标是推断图像内容之外的结论,VLM 面临困难。我们发现,VLM 向 LLM 提供感知结果图像说明的基线可以提高 VCI 的性能。然而,我们发现了 VLM 被动感知的挑战,它经常错过关键的上下文信息,导致 LLM 的推理不正确或不确定。为了缓解这个问题,我们建议采用一种协作方法,法学硕士在不确定自己的推理时,积极指导 VLM 集中精力并收集相关的视觉元素,以支持潜在的常识性推论。在我们名为 ViCor 的方法中,预先训练的 LLM 充当问题分类器来分析问题类别,VLM 指挥官根据问题分类以不同方式利用 VLM,视觉常识推理器来回答问题。 VLM 将执行视觉识别和理解。 |

| Domain-wise Invariant Learning for Panoptic Scene Graph Generation Authors Li Li, You Qin, Wei Ji, Yuxiao Zhou, Roger Zimmermann 全景场景图生成 PSG 涉及对象的检测及其对应关系谓词的预测。然而,有偏见的谓词注释的存在给 PSG 模型带来了重大挑战,因为它阻碍了它们在不同谓词之间建立清晰的决策边界的能力。这个问题严重阻碍了 PSG 模型的实际效用和现实世界的适用性。为了解决上述内在偏差,我们提出了一种新颖的框架,通过测量每个主题对象对域内的谓词预测风险来推断潜在有偏差的注释,并通过学习不变的谓词表示嵌入自适应地将有偏差的注释转移到一致的注释。 |

| A Real-time Method for Inserting Virtual Objects into Neural Radiance Fields Authors Keyang Ye, Hongzhi Wu, Xin Tong, Kun Zhou 我们提出了第一个将刚性虚拟对象插入神经辐射场的实时方法,该方法产生逼真的照明和阴影效果,并允许对对象进行交互式操作。通过利用 NeRF 中有关照明和几何的丰富信息,我们的方法克服了增强现实中对象插入的几个挑战。对于照明估计,我们产生准确、稳健和 3D 空间变化的入射照明,将 NeRF 的近场照明和环境照明相结合,以考虑 NeRF 未覆盖的光源。对于遮挡,我们使用 NeRF 集成的不透明贴图将渲染的虚拟对象与背景场景混合。对于阴影,通过预先计算的球面有符号距离场,我们查询虚拟对象周围任何点的可见性项,并将柔和、详细的阴影投射到 3D 表面上。 |

| Revisiting the Temporal Modeling in Spatio-Temporal Predictive Learning under A Unified View Authors Cheng Tan, Jue Wang, Zhangyang Gao, Siyuan Li, Lirong Wu, Jun Xia, Stan Z. Li 时空预测学习在自我监督学习中发挥着至关重要的作用,在各个领域都有广泛的应用。以前的时间建模方法分为两类:基于循环的方法和无循环的方法。前者在逐帧细致地处理时,忽略了短期时空信息冗余,导致效率低下。后者天真地按顺序堆叠帧,忽略了固有的时间依赖性。在本文中,我们重新研究了时空预测学习领域内的两种主要时间建模方法,提供了统一的视角。在此分析的基础上,我们引入了 USTEP Unified Spatio TEmporal Predictive Learning ,这是一个创新框架,通过集成微观时间和宏观时间尺度来协调基于循环的方法和自由循环的方法。 |

| Joint object detection and re-identification for 3D obstacle multi-camera systems Authors Irene Cort s, Jorge Beltr n, Arturo de la Escalera, Fernando Garc a 近年来,在不同原型中集成了包括摄像头和激光雷达系统在内的多种传感器的推动下,自动驾驶领域取得了显着的进步。然而,随着传感器数据的激增,迫切需要更复杂的信息处理技术。本研究论文介绍了对使用摄像头和激光雷达信息的物体检测网络的新颖修改,纳入了一个额外的分支,该分支设计用于重新识别同一车辆内相邻摄像头的物体,同时提高基线 3D 物体检测结果的质量。所提出的方法最初采用两步检测管道,采用对象检测网络,然后采用 3D 框估计器,该估计器对网络检测生成的过滤点云进行操作。 |

| Towards Lossless Dataset Distillation via Difficulty-Aligned Trajectory Matching Authors Ziyao Guo, Kai Wang, George Cazenavette, Hui Li, Kaipeng Zhang, Yang You 数据集蒸馏的最终目标是合成一个小型合成数据集,以便在此合成集上训练的模型与在完整的真实数据集上训练的模型表现得同样好。到目前为止,还没有一种数据集蒸馏方法能够达到这种完全无损的目标,部分原因是以前的方法只有在合成样本总数极小时才保持有效。由于如此少量的样本中只能包含如此多的信息,因此为了实现真正的损失数据集蒸馏,我们必须开发一种随着合成数据集大小的增长而保持有效的蒸馏方法。在这项工作中,我们提出了这样一种算法,并阐明了为什么现有方法无法生成更大、高质量的合成集。当前最先进的方法依赖于轨迹匹配或优化合成数据以诱导与真实数据类似的长期训练动态。我们凭经验发现,我们选择匹配的轨迹的训练阶段(即早期或晚期)极大地影响了蒸馏数据集的有效性。具体来说,教师网络学习简单模式的早期轨迹对于低基数合成集非常有效,因为分布必要信息的示例较少。相反,教师网络学习困难模式的后期轨迹为更大的合成集提供了更好的信号,因为现在有足够的样本来表示必要的复杂模式。根据我们的发现,我们建议将生成模式的难度与合成数据集的大小保持一致。在此过程中,我们成功地将基于轨迹匹配的方法扩展到更大的合成数据集,首次实现了无损数据集蒸馏。 |

| DANet: Enhancing Small Object Detection through an Efficient Deformable Attention Network Authors Md Sohag Mia, Abdullah Al Bary Voban, Abu Bakor Hayat Arnob, Abdu Naim, Md Kawsar Ahmed, Md Shariful Islam 高效、准确地检测制造环境中的小物体(例如缺陷和裂纹)对于确保产品质量和安全至关重要。为了解决这个问题,我们提出了一种综合策略,将 Faster R CNN 与尖端方法结合起来。通过将 Faster R CNN 与特征金字塔网络相结合,我们使模型能够有效地处理制造环境固有的多尺度特征。此外,使用变形网络来扭曲和符合缺陷的几何变化,即使是微小和复杂的特征也能精确检测。然后,我们在基础 ResNet50 网络的每个块中融入了一种称为“卷积块注意力模块”的注意力机制,以选择性地强调信息丰富的特征并抑制不太有用的特征。之后,我们合并了 RoI Align,取代了 RoI Pooling 以实现更精细的感兴趣区域对齐,最后集成 Focal Loss 有效地处理了类别不平衡,这对于罕见缺陷的发生至关重要。我们的模型在 NEU DET 和 Pascal VOC 数据集上的严格评估强调了其强大的性能和泛化能力。在 NEU DET 数据集上,我们的模型展示了对钢铁缺陷的深刻理解,在识别各种缺陷方面达到了最先进的准确性。 |

| Language Model Beats Diffusion -- Tokenizer is Key to Visual Generation Authors Lijun Yu, Jos Lezama, Nitesh B. Gundavarapu, Luca Versari, Kihyuk Sohn, David Minnen, Yong Cheng, Agrim Gupta, Xiuye Gu, Alexander G. Hauptmann, Boqing Gong, Ming Hsuan Yang, Irfan Essa, David A. Ross, Lu Jiang 虽然大型语言模型法学硕士是语言生成任务的主要模型,但它们在图像和视频生成方面的表现不如扩散模型。为了有效地使用 LLM 进行视觉生成,一个关键组件是视觉标记器,它将像素空间输入映射到适合 LLM 学习的离散标记。在本文中,我们介绍了 MAGVIT v2,这是一种视频标记器,旨在使用通用标记词汇为视频和图像生成简洁且富有表现力的标记。配备了这个新的分词器,我们证明 LLM 在标准图像和视频生成基准(包括 ImageNet 和 Kinetics)上优于扩散模型。 |

| HyperLips: Hyper Control Lips with High Resolution Decoder for Talking Face Generation Authors Yaosen Chen, Yu Yao, Zhiqiang Li, Wei Wang, Yanru Zhang, Han Yang, Xuming Wen 会说话的人脸生成在虚拟数字人领域具有广泛的潜在应用。然而,在确保唇形同步的同时渲染高保真面部视频仍然是现有音频驱动的说话面部生成方法的一个挑战。 |

| EdVAE: Mitigating Codebook Collapse with Evidential Discrete Variational Autoencoders Authors Gulcin Baykal, Melih Kandemir, Gozde Unal 码本崩溃是使用离散表示空间(例如矢量量化变分自编码器 VQ VAE)训练深度生成模型时的常见问题。我们观察到,替代设计的离散变分自动编码器 dVAE 也出现了同样的问题,其编码器直接学习码本嵌入上的分布来表示数据。我们假设使用 softmax 函数获得概率分布,通过将过度自信的概率分配给最佳匹配的码本元素,导致码本崩溃。在本文中,我们提出了一种新颖的方法,结合证据深度学习 EDL 而不是 softmax 来解决 dVAE 的码本崩溃问题。与 softmax 的使用相比,我们显然监控了获得码本嵌入的概率分布的重要性。 |

| Uni3DETR: Unified 3D Detection Transformer Authors Zhenyu Wang, Yali Li, Xi Chen, Hengshuang Zhao, Shengjin Wang 现有的基于点云的 3D 探测器是针对特定场景(室内或室外)而设计的。由于从不同环境中收集的点云中的对象分布和点密度存在显着差异,加上 3D 度量的复杂性,仍然缺乏能够适应不同场景的统一网络架构。在本文中,我们提出了 Uni3DETR,这是一种统一的 3D 检测器,可在同一框架内解决室内和室外 3D 检测问题。具体来说,我们采用具有点体素交互的检测变换器进行对象预测,它利用体素特征和点进行交叉注意,并且表现出抵抗数据差异的能力。然后,我们提出查询点的混合,它充分利用密集小范围室内场景的全局信息和大范围稀疏室外场景的局部信息。此外,我们提出的解耦 IoU 通过解开 xy 和 z 空间,提供了一个易于优化的本地化训练目标。大量实验验证 Uni3DETR 在室内和室外 3D 检测中始终表现出优异的性能。 |

| Combining recurrent and residual learning for deforestation monitoring using multitemporal SAR images Authors Carla Nascimento Neves, Raul Queiroz Feitosa, Mabel X. Ortega Adarme, Gilson Antonio Giraldi 亚马逊雨林面积广阔,比西欧面积大两倍,是地球上最大的森林,在全球气候调节中具有极其重要的作用。然而,利用该地区遥感数据进行森林砍伐检测提出了严峻的挑战,通常会受到一年中大部分时间遮蔽光学卫星数据的持续云层的阻碍。为了满足这一需求,本文提出了三种专为森林砍伐监测而设计的深度学习模型,利用 SAR 合成孔径雷达多时相数据,该数据独立于大气条件而移动。具体来说,该研究提出了三种新颖的循环全卷积网络架构,即 RRCNN 1、RRCNN 2 和 RRCNN 3,旨在提高森林砍伐检测的准确性。此外,本研究探索用多时态 SAR 序列取代双时态序列,其动机是假设森林砍伐迹象随着时间的推移在 SAR 图像中迅速消失。使用来自巴西雨林样本点的 Sentinel 1 多时相序列对拟议方法进行了全面评估。实验分析证实,分析观察期内的一系列 SAR 图像可以揭示在一对图像中无法检测到的森林砍伐点。值得注意的是,实验结果强调了多时相方法的优越性,在所有测试的网络架构中,F1 分数提高了约 5%。 |

| Climate-sensitive Urban Planning through Optimization of Tree Placements Authors Simon Schrodi, Ferdinand Briegel, Max Argus, Andreas Christen, Thomas Brox 气候变化正在增加许多极端天气事件的强度和频率,包括热浪,导致热不适和死亡率增加。虽然全球缓解行动无疑是必要的,但气候适应也是必要的,例如通过气候敏感的城市规划。最有前途的策略之一是利用城市树木在遮荫和冷却行人环境中的好处。我们的工作调查了此类树木最佳放置的挑战。物理模拟可以估计树木对人体热舒适度的辐射和热影响,但会导致高昂的计算成本。这排除了大面积树木放置的优化以及考虑较长时间尺度的影响。因此,我们采用神经网络来模拟逐点平均辐射温度,这是不同时间尺度下室外人类热舒适度的驱动因素,从日常变化到热浪事件的延长时间尺度,甚至几十年。为了优化树木的放置,我们在迭代局部搜索框架内利用树木固有的局部效应并进行定制调整。我们展示了我们的方法在广泛的研究领域和时间尺度上的有效性。 |

| Anchor-Intermediate Detector: Decoupling and Coupling Bounding Boxes for Accurate Object Detection Authors Yilong Lv, Min Li, Yujie He, Shaopeng Li, Zhuzhen He, Aitao Yang 基于锚的探测器不断被开发用于物体检测。然而,单独的锚框使得准确预测边界偏移变得困难。我们考虑使用多个边界框来获得预测框,而不是将每个边界框视为一个封闭的个体。为此,本文在推理中提出了textbf Box De Couple Couple BDC策略,不再丢弃重叠的框,而是解耦这些框的角点。然后,根据每个角点的得分,将角点点耦合以选择最准确的角点对。为了满足BDC策略,设计了一个简单但新颖的模型,名为textbf Anchor Intermediate Detector AID,它包含两个头部网络,即基于锚的头部和无锚的textbf角感知头部。角感知头能够对每个边界框的角进行评分,以促进角点之间的耦合。 MS COCO 上的大量实验表明,所提出的锚中间检测器在 MS COCO 测试开发数据集上的 sim 2.4 和 sim 1.2 AP 分别优于其基线 RetinaNet 和 GFL 方法,没有任何附加功能。 |

| ViTs are Everywhere: A Comprehensive Study Showcasing Vision Transformers in Different Domain Authors Md Sohag Mia, Abu Bakor Hayat Arnob, Abdu Naim , Abdullah Al Bary Voban, Md Shariful Islam Transformer 设计是自然语言处理任务的事实上的标准。自然语言处理中变压器设计的成功最近引起了计算机视觉领域研究人员的兴趣。与卷积神经网络 CNN 相比,Vision Transformers ViT 正在成为许多视觉问题的更流行和主导的解决方案。基于 Transformer 的模型在一系列视觉基准中优于其他类型的网络,例如卷积神经网络和循环神经网络。我们通过将各种视觉变换器模型划分为不同的工作并检查它们的优点和缺点来评估这项工作中的各种视觉变换器模型。 ViT 可以克服卷积神经网络 CNN 可能遇到的几个困难。本次调查的目的是展示 ViT 在 CV 中的首次使用。在第一阶段,我们对适合 ViT 的各种 CV 应用进行分类。图像分类、目标识别、图像分割、视频变换器、图像去噪和 NAS 都是 CV 应用。我们的下一步将是分析每个领域的最新技术并确定当前可用的模型。 |

| No Token Left Behind: Efficient Vision Transformer via Dynamic Token Idling Authors Xuwei Xu, Changlin Li, Yudong Chen, Xiaojun Chang, Jiajun Liu, Sen Wang Vision Transformers ViT 在计算机视觉任务中表现出了出色的性能,但其高计算复杂性阻碍了其在计算资源有限的环境中的部署。人们引入了各种令牌修剪技术,通过动态删除图像令牌来减轻 ViT 的高计算负担。然而,早期阶段的一些不良修剪可能会导致后续层中图像信息的永久丢失,从而阻碍模型性能。为了解决这个问题,我们提出了 IdleViT,一种基于动态令牌空闲的方法,可以在性能和效率之间实现良好的权衡。具体来说,在每一层中,IdleViT 选择图像令牌的子集参与计算,同时保持其余令牌空闲并直接将它们传递到该层的输出。通过允许在后续层中重新选择空闲令牌,IdleViT 减轻了早期阶段修剪不当的负面影响。此外,受归一化图切割的启发,我们在注意力图上设计了标记切割损失作为正则化,以提高 IdleViT 的标记选择能力。我们的方法简单而有效,并且可以扩展到金字塔 ViT,因为没有令牌被完全丢弃。对各种 ViT 架构的大量实验结果表明,仅微调 30 个 epoch 后,IdleViT 就可以将预训练 ViT 的复杂性降低多达 33 个周期,而在 ImageNet 上精度下降不超过 0.2 个周期。值得注意的是,当保持率为 0.5 时,IdleViT 的准确度比 DeiT S 上最先进的 EViT 高出 0.5,推理速度甚至更快。 |

| Plug n' Play: Channel Shuffle Module for Enhancing Tiny Vision Transformers Authors Xuwei Xu, Sen Wang, Yudong Chen, Jiajun Liu Vision Transformers ViT 在各种计算机视觉任务中表现出了卓越的性能。然而,高计算复杂度阻碍了 ViT 在内存和计算资源有限的设备上的适用性。尽管某些研究已经深入研究了卷积层与自注意力机制的融合以提高 ViT 的效率,但仅基于自注意力机制构建微小但有效的 ViT 仍然存在知识差距。此外,在大型但性能优异的 ViT 中减少特征通道的直接策略通常会导致性能显着下降,尽管效率有所提高。为了应对这些挑战,我们提出了一种新颖的通道洗牌模块来改进微小尺寸的 ViT,展示了纯自注意力模型在计算资源有限的环境中的潜力。受到 ShuffleNetV2 引用 ma2018shufflenet 中通道洗牌设计的启发,我们的模块扩展了小型 ViT 的特征通道,并将通道分为两组:textit attend 组和 textit Idle 组。自注意力计算专门用于指定的 textit 参与组,然后进行通道洗牌操作,以促进两个组之间的信息交换。通过将我们的模块合并到微型 ViT 中,我们可以获得卓越的性能,同时保持与普通模型相当的计算复杂性。 |

| ASM: Adaptive Sample Mining for In-The-Wild Facial Expression Recognition Authors Ziyang Zhang, Xiao Sun, Liuwei An, Meng Wang 考虑到面部表情类别之间的相似性、复合面部表情的存在以及注释者的主观性,面部表情识别 FER 数据集经常受到模糊性和噪声标签的影响。模糊表达式很难与带有噪声标签的表达式区分开来,这会损害 FER 模型的稳健性。此外,不同表情类别的识别难度各不相同,导致统一的方法对所有表情都是不公平的。在本文中,我们介绍了一种称为自适应样本挖掘 ASM 的新颖方法,可以动态解决每个表达式类别中的歧义和噪声。首先,自适应阈值学习模块为每个类别生成两个阈值,即干净阈值和噪声阈值。这些阈值基于每个训练时期的平均类别概率。接下来,样本挖掘模块通过将样本置信度与干净和噪声阈值进行比较,将数据集划分为干净、模糊和噪声三个子集。最后,Tri正则化模块对歧义子集采用相互学习策略以增强区分能力,并对噪声子集采用无监督学习策略以减轻噪声标签的影响。大量实验证明,我们的方法可以有效地挖掘歧义和噪声,并且在合成噪声和原始数据集上都优于 SOTA 方法。 |

| Adaptive Multi-head Contrastive Learning Authors Lei Wang, Piotr Koniusz, Tom Gedeon, Liang Zheng 在对比学习中,通过不同增强生成的原始图像的两个视图被视为正对,其相似度要求很高。此外,两个不同图像的两个视图被视为负对,并且鼓励它们的相似度较低。通常,由单个投影头给出的单个相似性度量分别用于评估正样本对和负样本对。然而,由于各种增强策略和不同的样本内相似性,同一图像的增强视图通常不相似。此外,由于样本间相似性,两个不同图像的增强视图可能比来自同一图像的增强视图更相似。因此,强制正对的高相似性和负对的低相似性可能并不总是可以实现,并且在某些对的情况下,强制这样做可能会损害性能。为了解决这个问题,我们建议使用多个投影头,每个投影头产生一组单独的特征。我们用于预训练的损失函数来自对给定观察的正样本的头部后验分布的最大似然估计的解决方案。损失包含正负对的相似性度量,每个对均由单独的自适应温度重新加权,该温度经过正则化以防止不良解决方案。我们的自适应多头对比学习 AMCL 可以应用于并通过实验改进几种流行的对比学习方法,例如 SimCLR、MoCo 和 Barlow Twins。 |

| Perceptual Artifacts Localization for Image Synthesis Tasks Authors Lingzhi Zhang, Zhengjie Xu, Connelly Barnes, Yuqian Zhou, Qing Liu, He Zhang, Sohrab Amirghodsi, Zhe Lin, Eli Shechtman, Jianbo Shi 深度生成模型的最新进展促进了跨各种任务创建照片般逼真的图像。然而,这些生成的图像通常在特定区域表现出感知伪影,需要手动校正。在这项研究中,我们对跨越不同图像合成工作的感知伪影定位 PAL 进行了全面的实证检验。我们引入了一个新颖的数据集,其中包含 10,168 个生成的图像,每个图像都在十个合成任务中用每像素感知伪影标签进行注释。在我们提出的数据集上训练的分割模型可以有效地定位一系列任务中的工件。此外,我们还展示了它使用最少的训练样本来适应以前未见过的模型的能力。我们进一步提出了一种创新的放大修复管道,可以无缝地纠正生成图像中的感知伪影。通过我们的实验分析,我们阐明了几种实际的下游应用,例如自动伪影校正、非参考图像质量评估和图像中的异常区域检测。 |

| WeatherDepth: Curriculum Contrastive Learning for Self-Supervised Depth Estimation under Adverse Weather Conditions Authors Jiyuan Wang, Chunyu Lin, Lang Nie, Shujun Huang, Yao Zhao, Xing Pan, Rui Ai 深度估计模型在清晰的场景中表现出了良好的性能,但由于光照变化、天气颗粒等原因,无法推广到恶劣的天气条件。在本文中,我们提出了 WeatherDepth,一种具有课程对比学习的自监督鲁棒深度估计模型,以解决复杂天气条件下性能下降。具体来说,我们首先提出了一种渐进式课程学习方案,包括三个简单到复杂的课程,逐步适应模型从清晰到相对不利,然后适应恶劣的天气场景。它鼓励模型逐渐掌握针对天气影响的有益深度线索,从而产生更平滑和更好的领域适应。同时,为了防止模型忘记以前的课程,我们将对比学习融入到不同的课程中。借鉴之前课程的参考知识,我们的策略在不同课程之间建立了深度一致性约束,以实现不同天气下稳健的深度估计。此外,为了减少人工干预并更好地适应不同的模型,我们设计了自适应课程调度器来自动搜索课程切换的最佳时机。 |

| Bi-directional Deformation for Parameterization of Neural Implicit Surfaces Authors Baixin Xu, Jiangbei Hu, Fei Hou, Kwan Yee Lin, Wayne Wu, Chen Qian, Ying He 神经渲染功能的不断增强增加了对能够直观编辑 3D 对象的新技术的需求,特别是当它们表示为神经隐式曲面时。在本文中,我们提出了一种新颖的神经算法,将神经隐式曲面参数化为简单的参数域,例如球体、立方体或多立方体,其中 3D 辐射场可以表示为 2D 场,从而促进可视化和各种编辑任务。从技术上讲,我们的方法计算 3D 对象与其所选参数域之间的双向变形,无需任何先验信息。我们采用 3D 对象零水平集上的点到参数域的前向映射,然后通过逆变形进行后向映射。为了确保地图是双射的,我们采用循环损失,同时优化两个变形的平滑度。此外,我们利用拉普拉斯正则器来有效控制角度畸变,并提供从一系列参数域中进行选择的灵活性来管理区域畸变。我们的框架专为兼容性而设计,与现有的神经渲染管道无缝集成,将多视图图像作为输入来重建 3D 几何并计算相应的纹理图。我们还引入了一种简单而有效的内在辐射分解技术,有助于视图独立的材质编辑和视图相关的着色编辑。我们的方法允许通过体积渲染立即渲染编辑后的纹理,而不需要网络重新训练。此外,我们的方法支持多个对象的共同参数化,并支持它们之间的纹理传输。我们证明了我们的方法在人头和人造物体图像上的有效性。 |

| Proposal-based Temporal Action Localization with Point-level Supervision Authors Yuan Yin, Yifei Huang, Ryosuke Furuta, Yoichi Sato 点级监督时间动作定位 PTAL 旨在识别和定位未经修剪的视频中的动作,其中在训练数据中仅注释每个动作实例中的单个点帧。在没有时间注释的情况下,大多数先前的工作采用多实例学习MIL框架,其中输入视频被分割成不重叠的短片段,并且对每个短片段独立地执行动作分类。我们认为,MIL 框架对于 PTAL 来说并不是最优的,因为它在包含有限时间信息的单独短片段上运行。因此,分类器只关注几个容易区分的片段,而不是在不遗漏任何相关片段的情况下发现整个动作实例。为了缓解这个问题,我们提出了一种新方法,通过生成和评估涉及更全面的时间信息的灵活持续时间的动作建议来定位动作。此外,我们引入了一种有效的聚类算法来有效地生成密集的伪标签,提供更强的监督,并引入细粒度的对比损失来进一步细化伪标签的质量。 |

| Semi-Supervised Object Detection with Uncurated Unlabeled Data for Remote Sensing Images Authors Nanqing Liu, Xun Xu, Yingjie Gao, Heng Chao Li 由于其劳动密集型性质,对遥感图像 RSI 进行注释提出了显着的挑战。半监督对象检测 SSOD 方法通过为未标记数据生成伪标签来解决这个问题,假设在未标记数据集中找到的所有类也都在标记数据中表示。然而,现实世界的情况引入了分布外 OOD 样本与未标记数据集中分布 ID 样本混合的可能性。在本文中,我们深入研究了直接对未整理的未标记数据进行 SSOD 的技术,这被称为开放集半监督对象检测 OSSOD。我们的方法首先采用分布数据中的标记来动态构建一个类特征库 CFB,该特征库捕获每个类的特定特征。随后,我们将预测对象边界框的特征与 CFB 中的相应条目进行比较,以计算 OOD 分数。我们根据CFB的统计特性设计了一个自适应阈值,使我们能够有效地过滤掉OOD样本。我们提出的方法的有效性通过对两个广泛使用的遥感目标检测数据集 DIOR 和 DOTA 的大量实验得到证实。 |

| Geometry-Guided Ray Augmentation for Neural Surface Reconstruction with Sparse Views Authors Jiawei Yao, Chen Wang, Tong Wu, Chuming Li 在本文中,我们提出了一种从稀疏多视图图像重建 3D 场景和对象的新方法。与以前利用额外信息(例如跨场景的深度或可概括特征)的方法不同,我们的方法利用多视图输入中嵌入的场景属性来创建精确的伪标签以进行优化,而无需任何事先训练。具体来说,我们引入了一种几何引导方法,通过利用球谐函数来预测新颖的辐射率,同时全面考虑场景中某个点的所有颜色观察结果,从而提高稀疏视图的表面重建精度。此外,我们的管道利用代理几何体并正确处理生成辐射伪标签时的遮挡,这是以前的图像扭曲方法无法避免的。我们的方法被称为光线增强 RayAug,无需事先训练即可在 DTU 和 Blender 数据集上取得优异的结果,证明了其在解决稀疏视图重建问题方面的有效性。 |

| Sentence-level Prompts Benefit Composed Image Retrieval Authors Yang Bai, Xinxing Xu, Yong Liu, Salman Khan, Fahad Khan, Wangmeng Zuo, Rick Siow Mong Goh, Chun Mei Feng 组合图像检索 CIR 是通过使用涉及参考图像和相关标题的查询来检索特定图像的任务。现有的CIR模型大多采用后期融合策略来结合视觉和语言特征。此外,还提出了几种方法来从参考图像生成伪词标记,并将其进一步集成到 CIR 的相关标题中。然而,当目标图像包含参考图像上的复杂变化(例如对象移除和属性修改)时,这些基于伪词的提示方法具有局限性。在这项工作中,我们证明学习相对标题 SPRC 的适当句子级提示足以实现有效的组合图像检索。我们建议利用预训练的 VL 模型(例如 BLIP 2)来生成句子级提示,而不是依赖基于伪词的提示。通过将学习到的句子级提示与相关标题连接起来,人们可以轻松地使用现有的基于文本的图像检索模型来增强 CIR 性能。此外,我们引入了图像文本对比损失和文本提示对齐损失来强制学习合适的句子级别提示。实验表明,我们提出的方法在 Fashion IQ 和 CIRR 数据集上的性能优于最先进的 CIR 方法。 |

| AdaFuse: Adaptive Medical Image Fusion Based on Spatial-Frequential Cross Attention Authors Xianming Gu, Lihui Wang, Zeyu Deng, Ying Cao, Xingyu Huang, Yue min Zhu 多模态医学图像融合对于精确的临床诊断和手术导航至关重要,因为它可以将多模态的互补信息合并到单个图像中。融合图像的质量取决于提取的单模态特征以及多模态信息的融合规则。现有的基于深度学习的融合方法只能充分利用各模态的语义特征,但无法区分各模态的有效低频和高频信息并自适应地进行融合。为了解决这个问题,我们提出了 AdaFuse,其中通过基于傅里叶变换的频率引导注意机制自适应地融合多模态图像信息。具体来说,我们提出了交叉注意融合CAF块,它通过交换键值和查询值自适应地融合空间和频率域中两种模态的特征,然后计算空间和频率特征之间的交叉注意分数,以进一步指导空间频率信息融合。 CAF 块增强了不同模态的高频特征,从而可以保留融合图像中的细节。此外,我们设计了一种由结构损失和内容损失组成的新颖损失函数,以保留低频和高频信息。对多个数据集进行的广泛比较实验表明,所提出的方法在视觉质量和定量指标方面均优于最先进的方法。消融实验还验证了所提出的损失和融合策略的有效性。 |

| Memory-Assisted Sub-Prototype Mining for Universal Domain Adaptation Authors Yuxiang Lai, Xinghong Liu, Tao Zhou, Yi Zhou 通用域适应旨在对齐类并减少源域和目标域的同一类别之间的特征差距。目标私有类别在适应过程中被设置为未知类,因为它不包含在源域中。然而,大多数现有方法忽略了类别内的类内结构,特别是在属于同一类别的样本之间存在显着概念转变的情况下。当概念转变较大的样本被迫放在一起时,可能会对适应性能产生负面影响。而且,从可解释性角度来看,将战斗机和民用飞机等具有显着差异的视觉特征归为同一类别也是不合理的。不幸的是,由于这种语义模糊性和注释成本,类别并不总是被详细分类,使得模型难以执行精确的适应。为了解决这些问题,我们提出了一种新颖的记忆辅助子原型挖掘 MemSPM 方法,当属于同一类别和挖掘子类的样本之间存在显着的概念转变时,该方法可以学习它们之间的差异。通过这样做,我们的模型学习了更合理的特征空间,增强了可迁移性并反映了注释为同一类别的样本之间的固有差异。我们评估了 MemSPM 方法在多种场景(包括 UniDA、OSDA 和 PDA)上的有效性。 |

| Towards Fair and Comprehensive Comparisons for Image-Based 3D Object Detection Authors Xinzhu Ma, Yongtao Wan, Yinmin Zhang, Zhiyi Xia, Yuan Meng, Zhihui Wang, Haojie Li, Wanli Ouyang 在这项工作中,我们构建了一个模块化设计的代码库,制定了强大的训练方法,设计了一个错误诊断工具箱,并讨论了当前基于图像的 3D 对象检测方法。特别是,与其他高度成熟的任务(例如 2D 对象检测)不同,基于图像的 3D 对象检测社区仍在不断发展,其中方法经常采用不同的训练配方和技巧,从而导致不公平的评估和比较。更糟糕的是,这些技巧可能会在性能上压倒他们提出的设计,甚至导致错误的结论。为了解决这个问题,我们构建了一个模块设计的代码库,并为社区制定了统一的培训标准。此外,我们还设计了一个错误诊断工具箱来测量检测模型的详细特征。使用这些工具,我们在不同的设置下深入分析当前的方法,并对一些开放性问题进行讨论,例如 KITTI 3D 和 nuScenes 数据集上结论的差异,这导致了这些数据集的不同主导方法。我们希望这项工作能够促进基于图像的 3D 对象检测的未来研究。 |

| Semantic-aware Temporal Channel-wise Attention for Cardiac Function Assessment Authors Guanqi Chen, Guanbin Li 心脏功能评估旨在根据超声心动图视频预测左心室射血分数 LVEF,这要求模型关注心动周期期间左心室的变化。如何从超声心动图视频中准确、自动地评估心脏功能是智能辅助医疗领域的一个有价值的课题。现有的基于视频的方法不太关注左心室区域,也不太关注运动引起的左心室变化。在这项工作中,我们提出了一种具有左心室分割任务的半监督辅助学习范例,这有助于左心室区域的表示学习。为了更好地模拟运动信息的重要性,我们引入了时间通道明智的注意力 TCA 模块来激发用于描述运动的通道。此外,我们通过将左心室的分割图作为输入来改进具有语义感知的TCA模块,以关注左心室的运动模式。最后,为了降低直接 LVEF 回归的难度,我们利用基于锚的分类和回归方法来预测 LVEF。 |

| GradientSurf: Gradient-Domain Neural Surface Reconstruction from RGB Video Authors Crane He Chen, Joerg Liebelt 本文提出了 GradientSurf,一种根据单目 RGB 视频进行实时表面重建的新颖算法。受泊松曲面重建的启发,该方法建立在曲面、体积和定向点云之间的紧密耦合之上,解决了梯度域的重建问题。与泊松曲面重建在扫描过程完成后通过求解线性系统来找到泊松方程的离线解不同,我们的方法通过神经网络增量地从部分扫描中找到在线解,其中泊松层被设计为监督局部和全局重建。现有方法在从 RGB 信号进行重建时遇到的主要挑战是重建表面缺乏细节。我们假设这是由于神经网络对学习低频几何特征的谱偏差造成的。为了解决这个问题,重建问题被转移到梯度域,其中零阶和一阶能量被最小化。零阶项惩罚表面的位置。一阶项惩罚重建隐函数的梯度与根据以自适应局部密度采样的定向点云制定的矢量场之间的差异。 |

| Efficient-VQGAN: Towards High-Resolution Image Generation with Efficient Vision Transformers Authors Shiyue Cao, Yueqin Yin, Lianghua Huang, Yu Liu, Xin Zhao, Deli Zhao, Kaiqi Huang 矢量量化图像建模在合成高质量图像方面显示出巨大的潜力。然而,由于自注意力过程的二次计算开销,生成高分辨率图像仍然是一项具有挑战性的任务。在本研究中,我们寻求探索一种更有效的两阶段框架来生成高分辨率图像,并在以下三个方面进行改进。 1 基于第一量化阶段具有可靠的局部属性的观察,我们采用基于局部注意力的量化模型,而不是以前方法中使用的全局注意力机制,从而获得更好的效率和重建质量。 2 我们强调图像生成过程中多粒度特征交互的重要性,并引入一种有效的注意力机制,该机制将整个图像内的全局注意力长期语义一致性与局部注意力细粒度细节相结合。这种方法可以实现更快的生成速度、更高的生成保真度和更高的分辨率。 3 我们提出了一种结合自编码训练和自回归生成策略的新一代管道,展示了更好的图像合成范例。 |

| CAMEL2: Enhancing weakly supervised learning for histopathology images by incorporating the significance ratio Authors Gang Xu, Shuhao Wang, Lingyu Zhao, Xiao Chen, Tongwei Wang, Lang Wang, Zhenwei Luo, Dahan Wang, Zewen Zhang, Aijun Liu, Wei Ba, Zhigang Song, Huaiyin Shi, Dingrong Zhong, Jianpeng Ma 组织病理学图像分析在癌症诊断中起着至关重要的作用。然而,训练临床适用的分割算法需要病理学家进行劳动密集型标记。相比之下,弱监督学习方法只需要图像级别的粗粒度标签,可以显着减少标记工作。不幸的是,虽然这些方法在载玻片水平预测方面表现相当不错,但它们定位癌变区域的能力(这对于许多临床应用至关重要)仍然不能令人满意。之前,我们提出了 CAMEL,它在像素级分割中取得了与完全监督基线相当的结果。然而,对于正 WSI,CAMEL 需要 1,280x1,280 图像级二进制注释。在这里,我们提出了 CAMEL2,通过引入阳性包的癌变比例阈值,它使我们能够更好地利用这些信息,从而使我们能够将图像级别设置从 1,280x1,280 放大到 5,120x5,120,同时保持准确性。 |

| Hierarchical Side-Tuning for Vision Transformers Authors Weifeng Lin, Ziheng Wu, Jiayu Chen, Wentao Yang, Mingxin Huang, Jun Huang, Lianwen Jin 微调预训练的 Vision Transformers ViT 在视觉识别领域始终表现出良好的性能。然而,使大型预训练模型适应各种任务提出了重大挑战。这一挑战源于每个模型需要经历独立且全面的微调过程,从而导致大量的计算和内存需求。虽然参数高效迁移学习 PETL 的最新进展已经证明,与使用较小的参数更新子集进行完全微调相比,它们能够实现卓越的性能,但它们往往会忽略密集的预测任务,例如对象检测和分割。在本文中,我们介绍了 Hierarchical Side Tuning HST ,这是一种新颖的 PETL 方法,可以有效地将 ViT 转移到各种下游任务。与专门微调输入空间或连接到骨干网的某些模块内的参数的现有方法不同,我们调整了一个轻量级且分层的侧网络 HSN,它利用从骨干网提取的中间激活并生成多尺度特征来进行预测。为了验证 HST,我们进行了涵盖各种视觉任务的广泛实验,包括分类、对象检测、实例分割和语义分割。值得注意的是,我们的方法在 VTAB 1k 上实现了最先进的平均 Top 1 精度 76.0,同时仅微调了 0.78M 参数。 |

| Lightweight Full-Convolutional Siamese Tracker Authors Li Yunfeng, Wang Bo, Li Ye, Liu Zhuoyan, Wu Xueyi 尽管单目标跟踪器已经取得了先进的性能,但其大规模的网络模型使其难以在资源有限的平台上应用。而且,现有的轻量级跟踪器在参数、性能、Flops和FPS方面仅达到2-3点之间的平衡。为了实现所有 4 点之间的平衡,本文提出了一种轻量级全卷积连体跟踪器,称为 lightFC。 LightFC采用新型高效互相关模块ECM和新型高效代表中心头ERH来增强卷积跟踪管道的非线性表达能力。 ECM 采用类似注意力模块的架构,融合像素级相关融合特征中的局部空间和通道特征,并通过反转激活块增强模型非线性。此外,ECM 还引入了跳过连接和重用搜索区域功能来提高其性能。 ERH合理引入重参数化技术和通道注意力来增强中心头的非线性表现力。综合实验表明,LightFC在性能、参数、Flops和FPS之间取得了很好的平衡。 LightFC 在 LaSOT 和 TNL2K 上的精度得分分别比 MixFormerV2 S 高出 3.7 和 6.5,同时使用的参数减少了 5 倍,Flops 减少了 4.6 倍。此外,LightFC 在 CPU 上的运行速度比 MixFormerV2 S 快 2 倍。 |

| Three-Stage Cascade Framework for Blurry Video Frame Interpolation Authors Pengcheng Lei, Zaoming Yan, Tingting Wang, Faming Fang, Guixu Zhang 模糊视频帧插值BVFI旨在从低帧率模糊视频生成高帧率清晰视频,是计算机视觉社区中一个具有挑战性但重要的课题。模糊视频不仅提供像清晰视频一样的空间和时间信息,而且还包含隐藏在每个模糊帧中的附加运动信息。然而,现有的 BVFI 方法通常无法充分利用所有有价值的信息,这最终会阻碍其性能。在本文中,我们提出了一个简单的端到端三阶段框架,以充分探索模糊视频中的有用信息。帧插值阶段设计了一个时间可变形网络,直接从模糊输入中采样有用信息,并以任意时间间隔合成中间帧。时间特征融合阶段通过双向循环可变形对齐网络探索每个目标帧的长期时间信息。去模糊阶段应用变压器授权的泰勒近似网络来递归地恢复高频细节。所提出的三阶段框架对每个模块都有明确的任务分配,并提供良好的可扩展性,各种实验结果证明了其有效性。我们在四个基准上评估我们的模型,包括 Adobe240 数据集、GoPro 数据集、YouTube240 数据集和 Sony 数据集。定量和定性结果表明我们的模型优于现有的 SOTA 方法。 |

| IPDreamer: Appearance-Controllable 3D Object Generation with Image Prompts Authors Bohan Zeng, Shanglin Li, Yutang Feng, Hong Li, Sicheng Gao, Jiaming Liu, Huaxia Li, Xu Tang, Jianzhuang Liu, Baochang Zhang 文本到 3D 生成的最新进展非常显着,DreamFusion 等方法利用基于大规模文本到图像扩散的模型来监督 3D 生成。这些方法,包括 ProlificDreamer 提出的变分分数蒸馏,可以合成详细且逼真的纹理网格。然而,这些方法生成的 3D 对象的外观通常是随机且不可控的,这对实现外观可控的 3D 对象提出了挑战。为了应对这一挑战,我们引入了 IPDreamer,这是一种新颖的方法,它结合了图像提示,为 3D 对象生成提供特定且全面的外观信息。 |

| SocialCircle: Learning the Angle-based Social Interaction Representation for Pedestrian Trajectory Prediction Authors Conghao Wong, Beihao Xia, Xinge You 在复杂场景中分析和预测行人和汽车等主体的轨迹在许多智能系统和应用中变得越来越重要。丰富多样的智能体之间社交互动行为的多样性和不确定性使得该任务比其他确定性计算机视觉任务更具挑战性。研究人员做了很多努力,通过不同的数学模型和网络结构来量化这些相互作用对未来轨迹的影响,但这个问题还没有得到很好的解决。受到海洋动物通过回声定位同伴在水下位置的启发,我们构建了一种新的基于角度的可训练社交表示,名为 SocialCircle,用于持续反映相对于目标代理的不同角度方向的社交互动背景。我们通过将所提出的 SocialCircle 与几个新发布的轨迹预测模型一起训练来验证其效果,实验表明,SocialCircle 不仅在数量上提高了预测性能,而且在质量上有助于在预测行人轨迹时更好地考虑社交互动: |

| Rotation Matters: Generalized Monocular 3D Object Detection for Various Camera Systems Authors SungHo Moon, JinWoo Bae, SungHoon Im 单目 3D 物体检测的研究正在积极研究中,其性能也在稳步提高。然而,当应用于与用于捕获训练数据集的系统不同的相机系统时,3D 对象检测性能会显着降低。例如,根据客车数据集训练的 3D 检测器大多数无法对安装在公共汽车上的摄像头回归准确的 3D 边界框。在本文中,我们进行了大量的实验来分析导致性能下降的因素。我们发现改变相机姿态,特别是相机相对于道路平面的方向会导致性能下降。此外,我们提出了一种通用的 3D 物体检测方法,可以普遍应用于各种相机系统。我们新设计了一个补偿模块,可以纠正估计的 3D 边界框位置和航向。所提出的模块可以应用于大多数最新的 3D 对象检测网络。它使 AP3D 分数 KITTI 中等程度增加,IoU 70 比基线高出约 6 到 10 倍,无需额外训练。 |

| C^2M-DoT: Cross-modal consistent multi-view medical report generation with domain transfer network Authors Ruizhi Wang, Xiangtao Wang, Jie Zhou, Thomas Lukasiewicz, Zhenghua Xu 在临床场景中,通常会同时生成多个不同视图的医学图像,并且这些图像具有很高的语义一致性。然而,大多数现有的医疗报告生成方法仅考虑单视图数据。医学图像丰富的多视图互信息有助于生成更准确的报告,然而,多视图模型在推理阶段对多视图数据的依赖严重限制了其在临床实践中的应用。此外,基于数字的词级优化忽略了报告和医学图像的语义,生成的报告往往无法达到良好的性能。因此,我们提出使用域传输网络 C 2M DoT 生成跨模式一致的多视图医疗报告。具体来说,i 采用基于语义的多视图对比学习医学报告生成框架,利用交叉视图信息来学习病变的语义表示 ii 进一步提出域转移网络,以确保多视图报告生成模型仍然能够实现良好的推理性能同时,在单视图输入iii下,使用跨模式一致性损失的优化有助于生成在语义上与医学图像一致的文本报告。对两个公共基准数据集的广泛实验研究表明,C 2M DoT 在所有指标上都远远优于最先进的基线。 |

| Infrared Small Target Detection Using Double-Weighted Multi-Granularity Patch Tensor Model With Tensor-Train Decomposition Authors Guiyu Zhang, Qunbo Lv, Zui Tao, Baoyu Zhu, Zheng Tan, Yuan Ma 红外小目标检测在遥感领域发挥着重要作用。因此,许多检测算法被提出,其中红外贴片张量IPT模型因其优异的性能成为主流工具。然而,大多数基于IPT的方法面临着巨大的挑战,例如张量低秩测量不准确以及对复杂场景的鲁棒性差,这将导致检测性能不佳。为了解决这些问题,本文提出了一种新颖的双加权多粒度红外贴片张量DWMGIPT模型。首先,为了捕获多种模式下张量的不同粒度信息,通过收集非重叠贴片和基于张量序列TT分解的张量增强,构建了多粒度红外贴片张量MGIPT模型。其次,为了更有效地探索张量的潜在结构,我们利用自动加权机制来平衡不同粒度信息的重要性。然后,采用引导核SK来先验提取局部结构,从而抑制强边缘和噪声等背景干扰。最后,提出了一种基于乘子ADMM交替方向法的高效优化算法来求解模型。在各种具有挑战性的场景中进行的大量实验表明,所提出的算法对噪声和不同场景具有鲁棒性。 |

| Anyview: Generalizable Indoor 3D Object Detection with Variable Frames Authors Zhenyu Wu, Xiuwei Xu, Ziwei Wang, Chong Xia, Linqing Zhao, Jiwen Lu, Haibin Yan 在本文中,我们提出了一种用于室内 3D 对象检测的新颖网络框架,以处理实际场景中的可变输入帧数。现有方法仅考虑单个检测器的固定输入数据帧,例如单目 RGB D 图像或从密集多视图 RGB D 图像重建的点云。而在机器人导航和操纵等实际应用场景中,3D探测器的原始输入是具有可变帧数的RGB D图像,而不是重建的场景点云。然而,以前的方法只能处理固定帧输入数据,并且对于可变帧输入性能较差。为了促进适合实际任务的 3D 对象检测方法,我们针对实际应用提出了一种名为 AnyView 的新型 3D 检测框架,该框架可以使用单个模型很好地泛化不同数量的输入帧。具体来说,我们提出了一个几何学习器来挖掘每个输入 RGB D 图像帧的局部几何特征,并通过设计的空间混合模块实现局部全局特征交互。同时,我们进一步利用动态令牌策略自适应调整每帧提取的特征数量,确保全局特征密度一致,并进一步增强融合后的泛化能力。 |

| A Critical Look at Classic Test-Time Adaptation Methods in Semantic Segmentation Authors Chang an Yi, Haotian Chen, Yifan Zhang 测试时间适应 TTA 旨在使最初在训练数据上训练的模型适应测试数据中潜在的分布变化。然而,大多数现有的 TTA 研究都集中在分类任务上,在语义分割的 TTA 探索中留下了显着的空白。这种对分类的明显强调可能会导致许多新手和工程师错误地认为为分类设计的经典 TTA 方法可以直接应用于分割。尽管如此,这一假设仍未得到证实,提出了一个悬而未决的问题。为了解决这个问题,我们进行了系统的实证研究,以揭示分段 TTA 的独特挑战,并确定经典的 TTA 策略是否可以有效地解决此任务。我们的综合结果得出了三个关键观察结果。首先,分类TTA中常用的经典批量归一化更新策略只能带来轻微的性能提升,在某些情况下甚至可能对结果产生不利影响。即使应用了批量重整化等先进的分布估计技术,问题仍然没有得到解决。其次,师生方案确实增强了在存在噪声伪标签的情况下分割 TTA 的训练稳定性。然而,与没有 TTA 的原始模型相比,它并不能直接带来性能提升。第三,分割TTA存在严重的长尾不平衡问题,这比分类TTA要复杂得多。 |

| Negative Object Presence Evaluation (NOPE) to Measure Object Hallucination in Vision-Language Models Authors Holy Lovenia, Wenliang Dai, Samuel Cahyawijaya, Ziwei Ji, Pascale Fung 物体幻觉对视觉语言 VL 模型提出了重大挑战,通常会导致对不存在的物体产生无意义或不忠实的响应。然而,由于缺乏评估 VL 模型中物体幻觉的通用测量方法,阻碍了我们的理解和缓解这一问题的能力。在这项工作中,我们提出了 NOPE 负对象存在评估,这是一种新颖的基准,旨在通过视觉问答 VQA 评估 VL 模型中的对象幻觉。我们提出了一种具有成本效益且可扩展的方法,利用大型语言模型为 NOPE 生成 29.5k 高质量的合成否定代词 NegP 数据。我们广泛研究了 10 个最先进的 VL 模型在辨别视觉问题中物体不存在方面的表现,其中真实答案表示为 NegP,例如 none 。此外,我们还在其他 9 个 VQA 数据集上评估了他们在视觉问题上的标准表现。通过我们的实验,我们证明没有任何 VL 模型能够免受物体幻觉的影响,因为所有模型在 NegP 上的准确率都低于 10。 |

| A Lightweight Video Anomaly Detection Model with Weak Supervision and Adaptive Instance Selection Authors Yang Wang, Jiaogen Zhou, Jihong Guan 视频异常检测是为了判断给定视频中是否存在异常事件、行为或物体,从而实现有效、智能的公共安全管理。由于视频异常标记既耗时又昂贵,大多数现有工作采用无监督或弱监督学习方法。本文重点关注弱监督视频异常检测,其中对训练视频是否包含任何异常进行标记,但没有关于异常位于哪些帧的信息。然而,弱标记数据的不确定性和大模型规模阻碍了现有方法在实际场景中的广泛部署,特别是边缘计算等资源限制情况。在本文中,我们开发了一种轻量级视频异常检测模型。一方面,我们提出了一种自适应实例选择策略,该策略根据模型的当前状态来选择置信实例,从而减轻弱标记数据的不确定性,从而提高模型的性能。另一方面,我们设计了一个轻量级的多级时间相关性注意模块和一个沙漏形的全连接层来构建模型,这可以将模型参数减少到现有方法的0.56。实时调频。 |

| Edge Computing-Enabled Road Condition Monitoring: System Development and Evaluation Authors Abdulateef Daud, Mark Amo Boateng, Neema Jakisa Owor, Armstrong Aboah, Yaw Adu Gyamfi 实时路面状况监测为公路机构提供了及时、准确的信息,可以构成路面维护和修复政策的基础。现有技术严重依赖手动数据处理,价格昂贵,因此难以扩展以进行频繁的网络级路面状况监测。此外,这些系统需要将大量数据包发送到云端,这需要大量存储空间,处理计算成本昂贵,并导致高延迟。当前的研究提出了一种解决方案,该解决方案利用广泛使用的经济实惠的微机电系统 MEMS 传感器、微控制器的边缘计算和互联网连接功能以及可部署的机器学习 ML 模型来设计可安装的物联网 IoT 设备在车辆车轴上传输实时路面状况数据 b 通过在发送到云服务器之前在设备上处理和分析路面状况传感器数据来减少延迟。在这项研究中,包括随机森林、LightGBM 和 XGBoost 在内的三种机器学习模型经过训练,可以预测每 0.1 英里路段的国际粗糙度指数 IRI。 XGBoost 的准确度最高,RMSE 和 MAPE 分别为 16.89in mi 和 20.3。就根据 MAP 21 标准根据行驶质量对路面路段 IRI 进行分类的能力而言,我们提出的设备在 I 70EB 上实现了 96.76 的平均准确度,在南普罗维登斯上实现了 63.15 的平均准确度。 |

| Understanding the Feature Norm for Out-of-Distribution Detection Authors Jaewoo Park, Jacky Chen Long Chai, Jaeho Yoon, Andrew Beng Jin Teoh 在分类数据集上训练的神经网络通常会对分布内 ID 样本的隐藏层特征表现出较高的向量范数,而对来自分布外 OOD 的未见实例产生相对较低的范数。尽管这种有趣的现象已在许多应用中得到利用,但其根本原因尚未得到彻底调查。在这项研究中,我们通过仔细检查神经网络中间层中隐藏的判别结构来揭开这一现象的神秘面纱。我们的分析得出以下发现 1 特征范数是隐藏在网络层中的分类器的置信值,特别是其最大 Logit。因此,特征范数以与分类器置信度相同的方式区分 OOD 和 ID。 2 特征范数与类别无关,因此它可以跨不同的判别模型检测 OOD 样本。 3 传统的特征范数无法捕捉隐藏层神经元的失活趋势,这可能导致ID样本被误识别为OOD实例。为了解决这个缺点,我们提出了一种新颖的负感知范数 NAN,它可以捕获隐藏层神经元的激活和失活趋势。 |

| GestSync: Determining who is speaking without a talking head Authors Sindhu B Hegde, Andrew Zisserman 在本文中,我们介绍了一种新的同步任务,即手势同步,确定一个人的手势是否与其语音相关。与唇形同步相比,手势同步更具挑战性,因为声音和身体运动之间的关系比声音和唇形之间的关系松散得多。我们为此任务引入了双编码器模型,并比较了包括 RGB 帧、关键点图像和关键点向量在内的多种输入表示,评估了它们的性能和优势。我们证明该模型可以单独使用自监督学习进行训练,并评估其在 LRS3 数据集上的性能。最后,我们演示了手势同步在音频视频同步方面的应用,以及在不看人脸的情况下确定人群中谁是发言者的应用。 |

| MSight: An Edge-Cloud Infrastructure-based Perception System for Connected Automated Vehicles Authors Rusheng Zhang, Depu Meng, Shengyin Shen, Zhengxia Zou, Houqiang Li, Henry X. Liu 随着车辆通信和网络技术的不断进步,基于基础设施的路边感知逐渐成为联网自动驾驶车辆 CAV 应用的关键工具。由于其位置较高,路边传感器(包括摄像头和激光雷达)通常可以享受畅通无阻的视野,并减少物体遮挡。这为它们提供了优于车载感知的明显优势,能够更稳健、更准确地检测道路物体。本文介绍了 MSight,这是一种专为 CAV 设计的尖端路边感知系统。 MSight 提供实时车辆检测、定位、跟踪和短期轨迹预测。评估强调了该系统以最小延迟维持车道级精度的能力,揭示了增强 CAV 安全性和效率的一系列潜在应用。 |

| Transforming Pixels into a Masterpiece: AI-Powered Art Restoration using a Novel Distributed Denoising CNN (DDCNN) Authors Sankar B., Mukil Saravanan, Kalaivanan Kumar, Siri Dubbaka 艺术修复对于保护文化遗产至关重要,但传统方法在忠实再现原创艺术品以及解决褪色、染色和损坏等问题方面存在局限性。我们提出了一种使用深度学习(特别是卷积神经网络 CNN)和计算机视觉技术来彻底改变艺术修复的创新方法。我们首先创建具有各种扭曲和退化水平的退化艺术图像的多样化数据集。该数据集训练分布式去噪 CNN DDCNN 以消除失真,同时保留复杂的细节。我们的方法适用于不同的扭曲类型和级别,使其适用于各种劣化的艺术品,包括绘画、草图和照片。大量实验证明了我们的方法与其他去噪 CNN 模型相比的效率和有效性。我们大幅减少了失真,将劣质艺术品转变成杰作。定量评估证实了我们的方法相对于传统技术的优越性,重塑了艺术修复领域并保护了文化遗产。 |

| Structure-Preserving Instance Segmentation via Skeleton-Aware Distance Transform Authors Zudi Lin, Donglai Wei, Aarush Gupta, Xingyu Liu, Deqing Sun, Hanspeter Pfister 具有复杂结构的对象对依赖边界或亲和图的现有实例分割方法提出了重大挑战,这些方法很容易受到接触像素周围小错误的影响,从而导致明显的连接变化。虽然距离变换 DT 使实例内部和边界更容易区分,但它往往会忽略宽度变化的实例的内部对象连接性并导致过度分割。为了解决这些挑战,我们提出了一种骨架感知距离变换 SDT,它结合了对象骨架在保持连通性方面的优点和 DT 在建模几何排列方面的优点,以表示具有任意结构的实例。 |

| Persis: A Persian Font Recognition Pipeline Using Convolutional Neural Networks Authors Mehrdad Mohammadian, Neda Maleki, Tobias Olsson, Fredrik Ahlgren 如果我们遇到适合设计工作的字体但不知道其名称,会发生什么情况视觉字体识别 VFR 系统用于识别图像中的字体。这些系统可以帮助图形设计师识别图像中使用的字体。 VFR 系统还有助于提高光学字符识别 OCR 系统的速度和准确性。在本文中,我们介绍了波斯语字体识别领域第一个公开可用的数据集,并采用卷积神经网络 CNN 来解决这个问题。结果表明,所提出的流程在我们的新数据集上获得了 78.0 top 1 的准确度,在 IDPL PFOD 数据集上获得了 89.1 的准确度,在 KAFD 数据集上获得了 94.5 的准确度。此外,我们提出的数据集的一个样本在整个管道中花费的平均时间对于 CPU 和 GPU 分别为 0.54 和 0.017 秒。 |

| SCANet: Scene Complexity Aware Network for Weakly-Supervised Video Moment Retrieval Authors Sunjae Yoon, Gwanhyeong Koo, Dahyun Kim, Chang D. Yoo 视频时刻检索旨在定位视频中与给定语言查询相对应的时刻。为了避免注释时间矩的昂贵成本,弱监督 VMR wsVMR 系统已被研究。对于此类系统,生成多个提案作为候选提案,然后选择最合适的提案是一种流行的方法。假设这些提案包含视频中许多可区分的场景作为候选。然而,wsVMR 系统的现有提案不考虑每个视频中不同数量的场景,其中提案是启发式确定的,与视频无关。我们认为检索系统应该能够应对每个视频中不同数量的场景所造成的复杂性。为此,我们提出了一种称为场景复杂性感知网络 SCANet 的检索系统的新颖概念,该系统测量每个视频中多个场景的场景复杂性,并生成响应每个视频中场景的可变复杂性的自适应建议。 |

| Boosting Facial Action Unit Detection Through Jointly Learning Facial Landmark Detection and Domain Separation and Reconstruction Authors Ziqiao Shang, Li Yu 近年来,如何将大量野外未标记的面部图像引入有监督的Facial Action Unit AU检测框架中已成为一个具有挑战性的问题。在本文中,我们提出了一种新的 AU 检测框架,其中引入多任务学习,通过共享同构面部提取模块的参数来共同学习 AU 域分离和重建以及面部标志检测。此外,我们提出了一种基于简单投影仪的对比学习和改进的对比损失的新特征对齐方案,该方案增加了四个额外的中间监督器来促进特征重建过程。 |

| Enhancing Cross-Dataset Performance of Distracted Driving Detection With Score-Softmax Classifier Authors Cong Duan, Zixuan Liu, Jiahao Xia, Minghai Zhang, Jiacai Liao, Libo Cao 深度神经网络可以实时监控车辆驾驶员,有助于及时预测分心、疲劳和潜在危险。该技术现已成为智能交通系统不可或缺的一部分。最近的研究暴露了由于数据样本有限而导致的过度拟合(通常称为快捷学习)导致的不可靠的跨数据集端到端驾驶员行为识别。在本文中,我们引入了 Score Softmax 分类器,它通过增强类间独立性和类内不确定性来解决这个问题。受人类评分模式的启发,我们设计了一个基于边际高斯分布的二维监督矩阵来训练分类器。高斯分布有助于放大类内不确定性,同时确保 Score Softmax 分类器学习准确的知识。此外,利用独立高斯分布随机变量的求和,我们引入了多通道信息融合方法。该策略有效解决了 Score Softmax 分类器的多信息融合挑战。同时,我们证实了迁移学习和多数据集组合的必要性。我们使用 SFD、AUCDD V1 和 100 Driver 数据集进行了跨数据集实验,证明 Score Softmax 在不修改模型架构的情况下提高了跨数据集性能。这为增强神经网络泛化提供了一种新方法。 |

| GMMFormer: Gaussian-Mixture-Model based Transformer for Efficient Partially Relevant Video Retrieval Authors Yuting Wang, Jinpeng Wang, Bin Chen, Ziyun Zeng, Shu Tao Xia 给定文本查询,部分相关视频检索 PRVR 寻求在数据库中查找包含相关时刻的未修剪视频。对于 PRVR,剪辑建模对于捕获文本和视频之间的部分关系至关重要。目前的PRVR方法采用基于扫描的剪辑构造来实现显式剪辑建模,信息冗余并且需要较大的存储开销。为了解决 PRVR 方法的效率问题,本文提出了 GMMFormer,一种基于 Trans textbf 模型的 textbf G aussian textbf Mixture textbf Model,它隐式地对剪辑表示进行建模。在帧交互过程中,我们结合高斯混合模型约束,将每个帧聚焦在其相邻帧上,而不是整个视频上。然后生成的表示将包含多尺度剪辑信息,实现隐式剪辑建模。此外,PRVR 方法忽略与同一视频相关的文本查询之间的语义差异,导致嵌入空间稀疏。我们提出了查询多样化损失来区分这些文本查询,使得嵌入空间更加密集并包含更多语义信息。 |

| Improving Discriminative Multi-Modal Learning with Large-Scale Pre-Trained Models Authors Chenzhuang Du, Yue Zhao, Chonghua Liao, Jiacheng You, Jie Fu, Hang Zhao 本文研究了如何更好地利用大规模预训练单模态模型来进一步增强判别性多模态学习。即使仅使用单模态数据进行微调,这些模型在某些任务中也可以优于以前的多模态模型。显然,将它们纳入多模式学习将显着提高绩效。然而,这些模型的多模态学习仍然存在单模态特征学习不足的问题,这削弱了所得多模态模型的泛化能力。虽然单独微调单模态模型然后聚合它们的预测很简单,但它不允许模态之间进行充分的适应,也会导致次优结果。为此,我们引入多模态低秩适应学习 MMLoRA 。通过冻结单模态微调模型的权重,向其添加额外的可训练秩分解矩阵,然后执行多模态联合训练,我们的方法增强了模态之间的适应性并提高了整体性能。 |

| HOD: A Benchmark Dataset for Harmful Object Detection Authors Eungyeom Ha, Heemook Kim, Sung Chul Hong, Dongbin Na 近年来,诸如图像和视频之类的多媒体数据已经在诸如社交网络服务SNS之类的各种在线服务上迅速传播。随着网络媒体服务的爆炸式增长,可能危害用户的图像内容数量也在呈指数级增长。因此,最近Facebook和Instagram等在线平台都采用了内容过滤系统,以防止有害内容的流行并降低对用户可能产生不利影响的风险。不幸的是,检测有害内容的计算机视觉研究尚未引起足够的重视。每个平台的用户在接触有害内容时仍然手动单击报告按钮来识别他们不喜欢的有害内容模式。然而,手动报告的问题是用户已经接触到有害内容。为了解决这些问题,我们这项工作的研究目标是开发用于在线服务的自动有害对象检测系统。我们提出了一个用于有害物体检测的新基准数据集。与大多数关注对象类别的一小部分的相关研究不同,我们的数据集涉及各种类别。具体来说,我们提出的数据集包含 6 个可能有害的类别的 10,000 多张图像,不仅包括正常情况,还包括难以检测的困难情况。此外,我们还进行了广泛的实验来评估我们提出的数据集的有效性。我们利用了最近提出的最先进的 SOTA 对象检测架构,并证明了我们提出的数据集对于实时有害对象检测任务非常有用。 |

| AANet: Aggregation and Alignment Network with Semi-hard Positive Sample Mining for Hierarchical Place Recognition Authors Feng Lu, Lijun Zhang, Shuting Dong, Baifan Chen, Chun Yuan 视觉位置识别VPR是机器人学的研究热点之一,它利用视觉信息来定位机器人。最近,由于精度和效率之间的权衡,分层两阶段 VPR 方法在该领域变得流行。这些方法在第一阶段使用全局特征检索前 k 个候选图像,然后在第二阶段通过匹配局部特征对候选图像重新排序。然而,它们通常需要额外的算法,例如重新排序时使用RANSAC进行几何一致性验证,比较耗时。在这里,我们提出了一种动态对齐局部特征 DALF 算法,用于在空间约束下对齐局部特征。它比需要几何一致性验证的方法明显更有效。我们提出了一个统一的网络,能够通过聚合模块提取全局特征以检索候选者,并通过 DALF 对齐模块对齐局部特征以进行重新排名。我们称这个网络为 AANet。同时,许多工作使用三元组中最简单的正样本进行弱监督训练,这限制了网络识别更困难的正对的能力。为了解决这个问题,我们提出了一种半硬正样本挖掘 ShPSM 策略来选择合适的硬正样本来训练更强大的 VPR 网络。对四个基准 VPR 数据集的大量实验表明,所提出的 AANet 可以以更少的时间消耗超越几种最先进的方法。 |

| ITRE: Low-light Image Enhancement Based on Illumination Transmission Ratio Estimation Authors Yu Wang, Yihong Wang, Tong Liu, Xiubao Sui, Qian Chen 噪声、伪影和过度曝光是低光图像增强领域的重大挑战。现有方法通常难以同时解决这些问题。在本文中,我们提出了一种基于 Retinex 的新颖方法,称为 ITRE,它可以抑制模型起源的噪声和伪影,防止整个增强过程中的过度曝光。具体来说,我们假设在相同颜色的像素内必须存在受弱光干扰最少的像素。首先,对RGB颜色空间上的像素进行聚类,找到整幅图像的照度透射比ITR矩阵,这决定了噪声不容易被过度放大。接下来,我们将图像的 ITR 视为初始照明传输图,以构建细化传输图的基础模型,从而防止伪影。此外,我们设计了一个过度曝光模块,该模块捕获像素过度曝光的基本特征并将其无缝集成到基本模型中。最后,当相同颜色像素的类间距离太小时,存在增强弱的可能性。为了解决这个问题,我们设计了一个 Robust Guard 模块来保障图像增强过程的稳健性。大量的实验证明了我们的方法在抑制噪声、防止伪影和同时控制曝光水平方面的有效性。 |

| LocoNeRF: A NeRF-based Approach for Local Structure from Motion for Precise Localization Authors Artem Nenashev, Mikhail Kurenkov, Andrei Potapov, Iana Zhura, Maksim Katerishich, Dzmitry Tsetserukou 视觉定位是移动机器人技术中的一项关键任务,研究人员正在不断开发新方法来提高其效率。在本文中,我们提出了一种使用来自运动 SfM 技术的结构来提高视觉定位准确性的新方法。我们强调了全局 SfM 的局限性(其存在高延迟)和局部 SfM 的挑战(需要大型图像数据库来进行精确重建)。为了解决这些问题,我们建议利用神经辐射场 NeRF(而不是图像数据库)来减少存储所需的空间。我们建议在先前查询位置周围采样参考图像可以带来进一步的改进。我们根据使用 LIDAR 和高级激光雷达里程计和实时 A LOAM 制图获得的地面实况评估了我们提出的方法的准确性,并在进行的实验中将其存储使用情况与本地 SfM 和 COLMAP 进行了比较。与地面实况相比,我们提出的方法实现了 0.068 米的精度,略低于最先进的方法 COLMAP,其精度为 0.022 米。然而,COLMAP 所需的数据库大小为 400 兆字节,而我们的 NeRF 模型的大小仅为 160 兆字节。 |

| Geometry Aware Field-to-field Transformations for 3D Semantic Segmentation Authors Dominik Hollidt, Clinton Wang, Polina Golland, Marc Pollefeys 我们提出了一种利用神经辐射场 NeRF 仅从 2D 监督执行 3D 语义分割的新颖方法。通过沿着表面点云提取特征,我们实现了场景的紧凑表示,该表示具有样本效率并且有利于 3D 推理。通过屏蔽自动编码以无监督的方式学习这个特征空间可以实现很少的镜头分割。 |

| UReader: Universal OCR-free Visually-situated Language Understanding with Multimodal Large Language Model Authors Jiabo Ye, Anwen Hu, Haiyang Xu, Qinghao Ye, Ming Yan, Guohai Xu, Chenliang Li, Junfeng Tian, Qi Qian, Ji Zhang, Qin Jin, Liang He, Xin Alex Lin, Fei Huang 文本在我们的视觉世界中无处不在,传递重要信息,例如文档、网站和日常照片。在这项工作中,我们提出了 UReader,这是基于多模态大语言模型 MLLM 的通用 OCR 免费视觉定位语言理解的首次探索。通过利用 MLLM 的浅层文本识别能力,我们只微调了 1.2 个参数,并且训练成本比之前遵循特定领域预训练和微调范例的工作低得多。具体来说,UReader 通过统一的指令格式对各种视觉语言理解任务进行了联合微调。为了增强视觉文本和语义理解,我们进一步应用了两个具有相同格式的辅助任务,即文本阅读和关键点生成任务。我们在 MLLM 的编码器解码器架构之前设计了一个形状自适应裁剪模块,以利用冻结的低分辨率视觉编码器来处理高分辨率图像。在没有下游微调的情况下,我们的单一模型在 10 个视觉定位语言理解任务中的 8 个中实现了最先进的 ocr 免费性能,涉及 5 个领域的文档、表格、图表、自然图像和网页屏幕截图。 |

| Bidirectional Knowledge Reconfiguration for Lightweight Point Cloud Analysis Authors Peipei Li, Xing Cui, Yibo Hu, Man Zhang, Ting Yao, Tao Mei 点云分析面临计算系统开销,限制了其在移动或边缘设备上的应用。直接使用小模型可能会导致性能显着下降,因为小模型很难同时充分捕获局部结构和全局形状信息,而这些信息是点云分析的重要线索。本文探讨了轻量级点云模型的特征蒸馏。为了缩小轻量级学生和繁重教师之间的语义差距,我们提出了双向知识重构 BKR,以将信息丰富的上下文知识从教师提取到学生。具体来说,开发了自上而下的知识重构和自下而上的知识重构,以分别从教师那里继承不同的局部结构信息和一致的全局形状知识。然而,由于大多数点云模型中的最远点采样,教师和学生之间的中间特征未对齐,从而降低了特征蒸馏性能。为了消除它,我们提出了一种基于最优传输的特征移动者距离FMD损失,它可以有效地测量无序点云特征之间的距离。 |

| Cross-domain Robust Deepfake Bias Expansion Network for Face Forgery Detection Authors Weihua Liu, Lin Li, Chaochao Lin, Said Boumaraf Deepfake 技术的快速发展引发了人们对人脸识别系统安全性的严重担忧。虽然现有方法利用 Deepfake 技术留下的线索进行人脸伪造检测,但恶意用户可能会故意操纵伪造的人脸来掩盖 Deepfake 线索的痕迹,从而欺骗检测工具。同时,由于训练数据中存在潜在的差距,实现基于数据的方法的跨域鲁棒性提出了挑战,训练数据可能不包含来自所有相关领域的样本。因此,在本文中,我们介绍了一种跨域鲁棒偏置扩展网络 BENet 的解决方案,旨在增强人脸伪造检测。 BENet 采用自动编码器来重建输入人脸,保持真实人脸的不变性,同时有选择地增强重建的假人脸与其原始人脸之间的差异。这种增强的偏差形成了可靠的伪造检测的坚实基础。为了优化 BENet 中的重建结果,我们采用了注入对比概念的偏差扩展损失来实现上述目标。此外,为了进一步增强伪造线索的放大效果,BENet 还引入了 Latent Space Attention LSA 模块。该LSA模块有效地捕获自动编码器的编码器和解码器之间潜在特征的差异,重点关注不一致的伪造相关信息。此外,BENet 还结合了一个带有阈值的跨域检测器来确定样本是否属于已知分布。通过跨域检测器对分类结果进行修正,使 BENet 能够防御来自跨域的未知 Deepfake 攻击。 |

| Dynamic Multi-Domain Knowledge Networks for Chest X-ray Report Generation Authors Weihua Liu, Youyuan Xue, Chaochao Lin, Said Boumaraf 自动生成放射诊断报告,帮助放射科医生及时、准确地做出诊断决策,同时提高临床诊断效率。然而,正常样本和异常样本之间的数据分布存在显着不平衡,包括视觉和文本偏差,这给自动生成诊断放射学报告等数据驱动任务带来了重大挑战。因此,我们提出了一种用于生成放射学诊断报告的动态多领域知识 DMDK 网络。 DMDK网络由四个模块组成:胸部特征提取器CFE、动态知识提取器DKE、特定知识提取器SKE和多知识集成器MKI模块。具体来说,CFE模块主要负责提取图像的未处理的视觉医学特征。 DKE模块负责从检索到的放射诊断报告中提取动态疾病主题标签。然后,我们将动态疾病主题标签与图像的原始视觉特征融合,突出原始视觉特征中的异常区域,以缓解视觉数据偏差问题。 SKE 模块在传统的静态知识图的基础上进行了扩展,以减轻文本数据偏差,并通过特定领域的动态知识图增强模型的可解释能力。 MKI 提取所有知识并生成最终的诊断放射学报告。我们对两个广泛使用的数据集 IU X Ray 和 MIMIC CXR 进行了广泛的实验。 |

| Lightweight In-Context Tuning for Multimodal Unified Models Authors Yixin Chen, Shuai Zhang, Boran Han, Jiaya Jia 在上下文中学习 ICL 涉及根据给定的上下文示例进行推理。随着更多模式的出现,这个过程变得更具挑战性,因为交错的输入模式使理解过程变得复杂。多模态模型通常很难从上下文示例中有效推断以执行 ICL,这一观察结果就证明了这一点。为了应对这些挑战,我们引入了 MultiModal In conteXt Tuning M 2 IXT,这是一个轻量级模块,用于增强多模态统一模型的 ICL 功能。所提出的 M 2 IXT 模块感知可扩展的上下文窗口,以合并多种模态的各种标记示例,例如文本、图像和坐标。它可以预先添加到各种多模态统一模型中,例如不同架构的 OFA、Unival、LLaVA,并通过混合任务策略进行训练,以实现对多个任务和数据集的快速少数镜头适应。当调整至 50K 多模态数据时,M 2 IXT 可以显着提高少量 ICL 性能,例如 OFA 相对提高 18,并在一系列任务中获得最先进的结果,包括视觉问答、图像字幕、视觉 |

| Enhancing Representations through Heterogeneous Self-Supervised Learning Authors Zhong Yu Li, Bo Wen Yin, Shanghua Gao, Yongxiang Liu, Li Liu, Ming Ming Cheng 结合来自不同架构的异构表示促进了各种视觉任务,例如,一些混合网络结合了变压器和卷积。然而,这种异构架构之间的互补性在自监督学习中尚未得到很好的利用。因此,我们提出了异构自监督学习 HSSL,它强制基础模型从辅助头中学习,该辅助头的架构与基础模型是异构的。在此过程中,HSSL以表示学习的方式在不改变结构的情况下赋予基础模型新的特征。为了全面理解 HSSL,我们对包含基本模型和辅助头的各种异构对进行了实验。我们发现,随着架构差异的增大,基本模型的表示质量也会提高。这一观察促使我们提出一种搜索策略,快速确定最适合特定基础模型学习的辅助头,以及几种简单但有效的方法来扩大模型差异。 HSSL兼容各种自监督方法,在图像分类、语义分割、实例分割和对象检测等各种下游任务上实现了优异的性能。 |

| OV-PARTS: Towards Open-Vocabulary Part Segmentation Authors Meng Wei, Xiaoyu Yue, Wenwei Zhang, Shu Kong, Xihui Liu, Jiangmiao Pang 分割和识别不同的物体部分是跨越各种计算机视觉和机器人任务的应用程序的关键能力。虽然对象级开放词汇语义分割 OVSS(即用任意文本分割对象)取得了重大进展,但相应的部分级研究提出了额外的挑战。首先,零件分割本质上涉及复杂的边界,而有限的注释数据则加剧了挑战。其次,由于开放世界中零件的定义多种多样且常常含糊不清,零件分割引入了开放粒度挑战。此外,在开放词汇环境中发挥关键作用的大规模视觉和语言模型很难像识别物体一样有效地识别零件。为了全面调查和应对这些挑战,我们提出了开放词汇零件分割 OV PARTS 基准。 OV PARTS 包括两个公开可用的数据集 Pascal Part 116 和 ADE20K Part 234 的精炼版本。它涵盖了三个特定任务:广义零镜头部分分割、跨数据集部分分割和少镜头部分分割,提供了对类比推理、开放粒度和模型的镜头适应能力很少。此外,我们分析并调整了 OV 零件的现有对象级 OVSS 方法的两种流行范例。进行了广泛的实验分析,以激发未来利用 OV 零件基础模型的研究。 |

| Cross-head mutual Mean-Teaching for semi-supervised medical image segmentation Authors Wei Li, Ruifeng Bian, Wenyi Zhao, Huihua Yang 通过利用有限的标记数据和大量的未标记数据,半监督医学图像分割 SSMIS 取得了显着的进步。然而,现有的最先进方法在准确预测未标记数据的标签方面遇到了挑战,导致训练期间产生破坏性噪声,并且容易出现错误信息过度拟合。此外,对不准确的预测应用扰动进一步降低了一致性学习。为了解决这些问题,提出了一种新颖的文本交叉头文本相互文本均值文本教学网络 CMMT Net 来解决这些问题。 CMMT 网络由教师学生网络组成,并在共享编码器中纳入强弱数据增强,通过利用自我训练和一致学习来促进十字头协同训练。通过平均教师网络和相互虚拟对抗训练来增强一致的学习,从而产生确定性和更高质量的预测。通过使用 Cross Set CutMix 可以增强一致性训练样本的多样性,这也有助于缓解与分布不匹配相关的问题。值得注意的是,CMMT Net 同时实现了数据级、特征级和网络级扰动,提高了模型多样性和泛化性能。所提出的方法在各种半监督设置的三个公开数据集上始终优于现有的 SSMIS 方法。 |

| Video-CSR: Complex Video Digest Creation for Visual-Language Models Authors Tingkai Liu, Yunzhe Tao, Haogeng Liu, Qihang Fan, Ding Zhou, Huaibo Huang, Ran He, Hongxia Yang 我们提出了一个新颖的任务和人工注释数据集,用于评估视觉语言模型为现实世界视频剪辑生成字幕和摘要的能力,我们称之为视频 CSR 字幕、摘要和检索。该数据集包含 4.8K YouTube 视频剪辑,时长 20 60 秒,涵盖广泛的主题和兴趣。每个视频剪辑对应5个独立注释的字幕1句和摘要3 10句。给定从数据集中选择的任何视频及其相应的 ASR 信息,我们评估基于视频视觉和听觉内容的字幕或摘要生成的视觉语言模型。此外,还对基于标题和摘要的检索任务评估模型,其中基于摘要的检索任务需要在给定相应摘要摘录的情况下识别目标视频。鉴于段落长度视频摘要任务的新颖性,我们对不同的现有评估指标及其与人类偏好的一致性进行了广泛的比较分析。最后,我们提出了一个具有竞争性生成和检索能力的基础模型,作为视频 CSR 任务的基线。 |

| Learning Separable Hidden Unit Contributions for Speaker-Adaptive Lip-Reading Authors Songtao Luo, Shuang Yang, Shiguang Shan, Xilin Chen 在本文中,我们提出了一种在唇读中适应说话者的新方法,其动机是两个观察结果。首先,说话人的自身特征总是可以通过浅层网络的少数面部图像甚至单个图像来很好地刻画,而与说话人脸所表达的语音内容相关的细粒度动态特征总是需要深层序列网络来准确表示。因此,我们对说话者自适应唇读的浅层和深层进行不同的处理。其次,我们观察说话者的独特特征,例如突出的口腔和下颌骨对不同单词和发音的唇读性能有不同的影响,需要自适应增强或抑制这些特征以实现稳健的唇读。基于这两个观察,我们建议利用说话者自身的特征,分别自动学习浅层和深层不同目标的可分离隐藏单元贡献。对于与说话者特征相关的特征强于与语音内容相关的特征的浅层,我们引入说话者自适应特征来学习以增强语音内容特征。对于说话者特征和语音内容特征都得到良好表达的深层,我们引入了说话者自适应特征来学习,以抑制与语音内容无关的噪声,从而实现鲁棒的唇读。通过不同设置的综合分析和比较证实,我们的方法始终优于现有方法。除了对流行的LRW ID和GRID数据集进行评估之外,我们还发布了新的评估数据集CAS VSR S68h,以进一步评估在只有少数发言者但语音内容涵盖大量且多样化的极端环境下的性能 |

| Language-driven Open-Vocabulary Keypoint Detection for Animal Body and Face Authors Hao Zhang, Kaipeng Zhang, Lumin Xu, Shenqi Lai, Wenqi Shao, Naning Zheng, Ping Luo, Yu Qiao 目前基于图像的动物(包括人体和面部)关键点检测方法仅限于特定的关键点和物种。我们通过提出开放词汇关键点检测 OVKD 任务来解决这一限制。它的目的是使用文本提示来定位任何物种的任意关键点。为了实现这一目标,我们提出了具有语义特征匹配 KDSM 的开放词汇关键点检测,它利用视觉和语言模型来利用文本和视觉之间的关系,从而通过将文本提示与相关关键点特征相关联来实现关键点检测。此外,KDSM还集成了领域分布矩阵匹配和一些特殊的设计来强化语言和视觉之间的关系,从而提高模型的泛化性和性能。大量实验表明,我们提出的组件带来了显着的性能改进,并且我们的整体方法在 OVKD 中取得了令人印象深刻的结果。值得注意的是,我们的方法优于使用零样本方式的最先进的少数样本关键点检测方法。 |

| FairTune: Optimizing Parameter Efficient Fine Tuning for Fairness in Medical Image Analysis Authors Raman Dutt, Ondrej Bohdal, Sotirios A. Tsaftaris, Timothy Hospedales 具有强大的群体公平性的训练模型在医学诊断等道德敏感的应用领域至关重要。尽管越来越多的工作旨在最大限度地减少人工智能中的人口统计学偏见,但这个问题仍然具有挑战性。这一挑战的一个关键原因是公平性泛化差距高容量深度学习模型可以近乎完美地拟合所有训练数据,从而在训练过程中也表现出完美的公平性。在这种情况下,只有在测试过程中,当子组之间的泛化性能不同时,才会出现偏差。这促使我们对公平学习采取双层优化的视角,基于验证公平性优化学习策略。具体来说,我们考虑使用参数高效微调 PEFT 技术使预训练模型适应下游医学成像任务的高效工作流程。在更新更多参数(可以更好地适应感兴趣的任务)与更新更少参数(有可能缩小泛化差距)之间存在权衡。为了管理这种权衡,我们提出了 FairTune,一个在公平性方面优化 PEFT 参数选择的框架。 |

| Low-Resolution Self-Attention for Semantic Segmentation Authors Yu Huan Wu, Shi Chen Zhang, Yun Liu, Le Zhang, Xin Zhan, Daquan Zhou, Jiashi Feng, Ming Ming Cheng, Liangli Zhen 语义分割任务自然需要用于像素分割的高分辨率信息和用于类别预测的全局上下文信息。虽然现有的视觉转换器表现出良好的性能,但它们经常使用高分辨率上下文建模,从而导致计算瓶颈。在这项工作中,我们挑战传统观念,引入低分辨率自注意力 LRSA 机制,以显着降低计算成本来捕获全局上下文。我们的方法涉及在固定的低分辨率空间中计算自注意力,而不管输入图像的分辨率如何,并使用额外的 3x3 深度卷积来捕获高分辨率空间中的精细细节。我们通过构建 LRFormer(具有编码器解码器结构的视觉转换器)来展示 LRSA 方法的有效性。对 ADE20K、COCO Stuff 和 Cityscapes 数据集的大量实验表明 LRFormer 的性能优于最先进的模型。 |

| Single Stage Warped Cloth Learning and Semantic-Contextual Attention Feature Fusion for Virtual TryOn Authors Sanhita Pathak, Vinay Kaushik, Brejesh Lall 基于图像的虚拟试穿旨在将店内服装适配到穿着者图像上。服装变形将目标服装与人物图像中相应的身体部位对齐,是实现这一目标的关键一步。现有的方法通常使用多阶段框架来分别处理衣服变形、人体合成和试模生成,或者依赖于基于噪声的中间解析器的标签。我们提出了一种新颖的单阶段框架,可以隐式地学习相同的内容,而无需显式的多阶段学习。我们的方法利用新颖的语义上下文融合注意模块进行服装人物特征融合,从而实现从目标姿势关键点进行高效且逼真的布料变形和身体合成。通过引入关注服装区域并融合多个采样流场的轻量级线性注意框架,我们还解决了先前方法中存在的未对准和伪影问题。为了实现翘曲服装的同步学习和试穿效果,我们引入了翘曲布料学习模块。 WCLM 使用分段变形服装作为基本事实,在单阶段范例中运行。我们提出的方法显着提高了虚拟试穿方法的质量和效率,为用户提供了更可靠、更真实的虚拟试穿体验。 |

| Detecting Abnormal Health Conditions in Smart Home Using a Drone Authors Pronob Kumar Barman 如今,检测异常的健康问题是一个困难的过程。跌倒,尤其是老年人的跌倒,是世界范围内的一个严重问题。跌倒可能导致致命的后果,包括失去知觉、内出血,甚至死亡。目前,人们关注的是一种实用且最佳的智能跌倒检测方法。基于视觉的跌倒监测的使用在科学家中变得越来越普遍,因为它使老年人和患有其他健康问题的人能够独立生活。为了跟踪、监视和救援,无人机使用视频或图像分割和目标检测方法。 Tello 无人机配备了摄像头,通过该设备,我们确定了参与者的正常和异常行为。使用卷积神经网络 CNN 分类器对自主下落的物体进行分类。 |

| Building an Open-Vocabulary Video CLIP Model with Better Architectures, Optimization and Data Authors Zuxuan Wu, Zejia Weng, Wujian Peng, Xitong Yang, Ang Li, Larry S. Davis, Yu Gang Jiang 尽管对比语言图像预训练 CLIP 在零镜头图像识别方面取得了显着的成果,但探索其零镜头视频识别潜力的努力仍然有限。本文介绍了 Open VCLIP,这是一个简单而有效的框架,它使 CLIP 适应强大的零镜头视频分类器,能够在测试期间识别新的动作和事件。 Open VCLIP 对 CLIP 进行最小程度的修改,以捕获视频中的时空关系,从而创建专门的视频分类器,同时努力实现泛化。我们正式证明训练 Open VCLIP 相当于零历史数据的持续学习。为了解决这个问题,我们引入了插值权重优化,这是一种在训练和测试期间利用权重插值优势的技术。此外,我们基于大型语言模型来生成细粒度的视频描述。这些详细的描述进一步结合了视频特性,有利于CLIP更好地转移到视频领域。我们的方法在三个广泛使用的动作识别数据集上进行评估,遵循各种零样本评估协议。结果表明,我们的方法明显超越了现有的最先进技术。具体来说,我们在 UCF、HMDB 和 Kinetics 600 数据集上分别获得了 88.1、58.7 和 81.2 的零射击精度得分,比表现最佳的替代方法高出 8.5、8.2 和 12.3。我们还在 MSR VTT 视频文本检索数据集上评估了我们的方法,该方法提供了有竞争力的视频到文本和文本到视频检索性能,同时与其他方法相比,使用的微调数据要少得多。 |

| Symmetrical Linguistic Feature Distillation with CLIP for Scene Text Recognition Authors Zixiao Wang, Hongtao Xie, Yuxin Wang, Jianjun Xu, Boqiang Zhang 在本文中,我们探索了对比语言图像预训练 CLIP 模型在场景文本识别 STR 中的潜力,并建立了一种名为 CLIP OCR 的新型对称语言特征蒸馏框架,以利用 CLIP 中的视觉和语言知识。与之前主要考虑视觉编码特征泛化的基于 CLIP 的方法不同,我们提出了一种对称蒸馏策略 SDS,进一步捕获 CLIP 文本编码器中的语言知识。通过将 CLIP 图像编码器与反向 CLIP 文本编码器级联,使用图像到文本特征流构建了对称结构,该结构不仅涵盖视觉信息,还涵盖用于蒸馏的语言信息。受益于 CLIP 中的自然对齐,这种引导流提供了从视觉到语言的渐进优化目标,可以逐层监督STR特征转发过程。此外,提出了一种新的语言一致性损失LCL,通过在优化过程中考虑二阶统计量来增强语言能力。 |

| SemST: Semantically Consistent Multi-Scale Image Translation via Structure-Texture Alignment Authors Ganning Zhao, Wenhui Cui, Suya You, C. C. Jay Kuo 无监督图像到图像 I2I 翻译学习跨域图像映射,将源域的输入传输到目标域的输出,同时保留其语义。一项挑战是源域和目标域中不同的语义统计会导致内容差异,称为语义失真。为了解决这个问题,本文提出了一种保持翻译语义一致性的新型 I2I 方法,并将其命名为 SemST。 SemST 通过采用对比学习来减少语义失真,并通过最大化输入和输出的互信息来调整输入和输出的结构和纹理属性。此外,引入多尺度方法来增强翻译性能,从而使 SemST 能够应用于高分辨率图像中的域适应。实验表明 SemST 有效地减轻了语义失真并实现了最先进的性能。此外,还探讨了 SemST 在域适应 DA 中的应用。 |

| Video-Teller: Enhancing Cross-Modal Generation with Fusion and Decoupling Authors Haogeng Liu, Qihang Fan, Tingkai Liu, Linjie Yang, Yunzhe Tao, Huaibo Huang, Ran He, Hongxia Yang 本文提出了 Video Teller,这是一种视频语言基础模型,利用多模态融合和细粒度模态对齐来显着增强视频到文本生成任务。 Video Teller 利用冻结的预训练视觉和语言模块来提高训练效率。它利用大型语言模型强大的语言能力,能够生成简洁而详细的视频描述。为了有效地整合视觉和听觉信息,Video Teller 基于图像的 BLIP 2 模型构建,并引入了级联 Q Former,它融合了帧和 ASR 文本的信息。为了更好地指导视频摘要,我们引入了细粒度模态对齐目标,其中级联 Q Former 的输出嵌入经过训练,以与预训练文本自动编码器创建的标题摘要嵌入对齐。实验结果证明了我们提出的视频语言基础模型在准确理解视频和生成连贯且精确的语言描述方面的有效性。 |

| Compositional Semantics for Open Vocabulary Spatio-semantic Representations Authors Robin Karlsson, Francisco Lepe Salazar, Kazuya Takeda 通用移动机器人需要在没有精确人类指令的情况下完成任务。大型语言模型法学硕士是实现常识性世界知识和基于推理的规划的一个有前途的方向。视觉语言模型 VLM 将环境感知转换为 LLM 可解释的视觉语言语义。然而,完成复杂的任务通常需要对当前感知之外的信息进行推理。我们提出潜在组合语义嵌入 z 作为可查询空间语义记忆的基于原则学习的知识表示。我们在数学上证明 z 总是可以找到,并且最佳 z 是任何集合 Z 的质心。我们推导出用于估计相关和不相关语义的可分离性的概率界限。我们证明 z 可以通过视觉外观和奇异描述的梯度下降迭代优化来发现。我们通过实验验证了我们对四个嵌入空间的发现,包括。 CLIP 和 SBERT。我们的结果表明,z 最多可以表示 SBERT 编码的 10 个语义,对于理想的均匀分布的高维嵌入,最多可以表示 100 个语义。 |

| Learning Many-to-Many Mapping for Unpaired Real-World Image Super-resolution and Downscaling Authors Wanjie Sun, Zhenzhong Chen 由于缺乏配对的低分辨率 LR 和高分辨率 HR 训练图像,基于学习的现实世界图像的单图像超分辨率 SISR 一直是一个活跃的研究课题,但也是一项具有挑战性的任务。大多数现有的无监督现实世界 SISR 方法采用两阶段训练策略,首先从 HR 图像中合成真实的 LR 图像,然后以监督方式训练超分辨率 SR 模型。然而,该策略中图像退化和SR模型的训练是分开的,忽略了降尺度及其逆升尺度过程之间固有的相互依赖性。此外,没有充分考虑图像退化的不适定性质。在本文中,我们提出了一种称为 SDFlow 的图像缩小和 SR 模型,它同时无监督地学习现实世界 LR 和 HR 图像之间的双向多对多映射。 SDFlow的主要思想是在潜在空间中解耦图像内容和退化信息,其中LR和HR图像的内容信息分布在公共潜在空间中匹配。 LR图像的退化信息和HR图像的高频信息被拟合到易于采样的条件分布。 |

| DISCOVER: Making Vision Networks Interpretable via Competition and Dissection Authors Konstantinos P. Panousis, Sotirios Chatzis 现代深层网络非常复杂,其推理结果很难解释。这是它们在安全关键或偏见感知应用程序中透明部署的严重障碍。这项工作有助于事后解释,特别是网络剖析。我们的目标是提出一个框架,使人们更容易发现网络中每个神经元的单独功能,该网络经过视觉任务发现的训练,是根据文本描述生成来执行的。为了实现这一目标,我们利用多模态视觉文本模型的最新进展和基于线性单元之间随机局部竞争的新概念的网络层。在这种设置中,对于给定的输入,只有一小部分层神经元被激活,导致极高的激活稀疏度低至大约 4 。至关重要的是,我们提出的方法推断出稀疏神经元激活模式,使神经元能够激活专门针对具有特定特征的输入,从而使其个体功能多样化。我们方法的这种能力增强了解剖过程的潜力,仅针对极少数活跃神经元生成人类可理解的描述,从而促进对网络决策过程的直接研究。 |

| Analyzing Zero-Shot Abilities of Vision-Language Models on Video Understanding Tasks Authors Avinash Madasu, Anahita Bhiwandiwalla, Vasudev Lal 在大规模图像文本对或视频文本对或两者上预训练的基础多模态模型在下游任务上表现出强大的泛化能力。然而,与图像文本模型不同,预训练视频文本模型总是不可行,因为难以收集大规模干净且对齐的数据,并且预训练阶段涉及指数计算成本。因此,要问的相关问题是图像文本模型是否可以适应视频任务,以及使用这些模型比直接在视频上进行预训练有什么好处。在这项工作中,我们通过提出对泛化能力的详细研究来关注这个问题。在零镜头设置下对视频理解任务进行评估时的图像文本模型。我们在不同的视频任务中研究了 9 个基本图像文本模型,包括视频动作识别视频 AR、视频检索视频 RT、视频问答视频 QA、视频多项选择视频 MC 和视频字幕视频 CP。我们的实验表明,图像文本模型在视频 AR、视频 RT 和视频 MC 上表现出令人印象深刻的性能。此外,他们在视频字幕方面表现一般,在视频质量检查方面表现不佳。 |

| $H$-RANSAC, an algorithmic variant for Homography image transform from featureless point sets: application to video-based football analytics Authors George Nousias, Konstantinos Delibasis, Ilias Maglogiannis 估计两幅图像之间的单应矩阵具有多种应用,例如图像拼接或图像拼接以及从多个摄像机视图进行空间信息检索,但已被证明是一个复杂的问题,特别是在摄像机姿态和变焦系数完全不同的情况下。已经提出了许多相关方法,利用基于直接特征或深度学习的方法。在本文中,我们提出了一种广义 RANSAC 算法 H RANSAC,用于从点集中检索单应性图像变换,而无需描述性局部特征向量和点配对。我们允许将点选择性地标记为两类。我们提出了一个稳健的标准,根据随机点对选择凸或凹和非自相交形成的四边形的类型,在每次 RANSAC 迭代之前拒绝不合理的点选择。每次迭代结束时都包含一个类似的事后标准,拒绝不可信的单应性变换。根据每个图像和每个类的点数以及异常值的百分比,针对不同的成功概率导出 H RANSAC 的预期最大迭代次数。所提出的方法在真实足球比赛期间由 12 个摄像机采集的大型图像数据集上进行了测试,其中每个时间戳的完全不同的视图将被匹配。与 RANSAC 结合经典和深度学习图像显着点检测的最先进实现的比较表明,在平均重投影误差和成功处理的帧对数量方面,所提出的 H RANSAC 具有优越性,使其成为以下领域的首选方法图像单应性对齐有几十个点,而局部特征不可用或描述性不够的情况。 |

| WAIT: Feature Warping for Animation to Illustration video Translation using GANs Authors Samet Hicsonmez, Nermin Samet, Fidan Samet, Oguz Bakir, Emre Akbas, Pinar Duygulu 在本文中,我们探索了视频到视频翻译的新领域。受到儿童插画书中改编的动画电影的启发,我们的目标是用原始插图的风格来风格化这些视频。当前最先进的视频到视频翻译模型依赖于视频序列或单一风格图像来风格化输入视频。我们引入了一个新的视频风格化问题,其中使用了一组无序的图像。 |

| HowToCaption: Prompting LLMs to Transform Video Annotations at Scale Authors Nina Shvetsova, Anna Kukleva, Xudong Hong, Christian Rupprecht, Bernt Schiele, Hilde Kuehne 教学视频是通过利用自动语音识别系统 ASR 从视频中的音频信号中提取的视频字幕对来学习多模态表示的绝佳来源。然而,与人类注释的字幕相比,语音和字幕自然不同于视频的视觉内容,因此只为多模态学习提供噪声监督。因此,大规模无注释网络视频训练数据对于训练文本视频模型来说仍然是次优的。在这项工作中,我们建议利用大型语言模型法学硕士的能力来获得与视频一致的细粒度视频描述。具体来说,我们提示法学硕士根据视频的 ASR 叙述为大规模教学视频数据集创建合理的视频描述。为此,我们引入了一种提示方法,能够考虑较长的字幕文本,使我们能够捕获单个句子之外的上下文。为了在时间上将字幕与视频对齐,我们提示法学硕士根据字幕为每个生成的字幕生成时间戳。通过这种方式,我们可以在没有人工监督的情况下大规模获得人类风格的视频字幕。我们将我们的方法应用于 HowTo100M 数据集的字幕,创建一个新的大规模数据集 HowToCaption。 |

| Cell Tracking-by-detection using Elliptical Bounding Boxes Authors Lucas N. Kirten, Cl udio R. Jung 细胞检测和跟踪对于生物分析至关重要。最近的方法依赖于模型进化范式的跟踪,该范式通常包括训练端到端深度学习模型来检测和跟踪帧上的细胞,并产生有希望的结果。然而,此类方法需要大量注释数据,获取这些数据非常耗时,并且通常需要专门的注释器。这项工作提出了一种基于经典跟踪检测范式的新方法,可以减轻对注释数据的需求。更准确地说,它将细胞形状近似为定向椭圆,然后使用通用定向对象检测器来识别每个帧中的细胞。然后,我们依靠全局数据关联算法,考虑到椭圆与二维高斯分布相关,该算法使用概率距离度量来探索时间单元相似性。我们的结果表明,我们的方法可以实现与需要更广泛的数据注释的最先进技术竞争的检测和跟踪结果。 |

| End-to-End Lip Reading in Romanian with Cross-Lingual Domain Adaptation and Lateral Inhibition Authors Emilian Claudiu M nescu, R zvan Alexandru Sm du, Andrei Marius Avram, Dumitru Clementin Cercel, Florin Pop 近年来,唇读或视觉语音识别受到了广泛关注,特别是由于计算机视觉的硬件发展和创新。尽管已经取得了相当大的进展,但大多数模型仅在少数大型数据集上进行了测试。这项工作通过分析代表性不足的小规模罗马尼亚语言数据集 Wild LRRo 的几种架构和优化来解决这一缺点。最值得注意的是,我们比较了不同的后端模块,证明了添加充足的正则化方法的有效性。我们使用我们提出的方法获得了最先进的结果,即跨语言域适应和来自英语和德语数据集的未标记视频,以帮助模型学习语言不变特征。 |

| Exploiting Facial Relationships and Feature Aggregation for Multi-Face Forgery Detection Authors Chenhao Lin, Fangbin Yi, Hang Wang, Qian Li, Deng Jingyi, Chao Shen 人脸伪造技术已成为最受关注的问题,并且已经提出了许多检测方法来应对这一挑战。然而,现有的方法主要集中在单人脸操纵检测上,而相对而言,对于更复杂和更现实的多脸伪造领域还没有进行探索。本文提出了一种专门为多人脸伪造检测量身定制的新颖框架,填补了当前研究的关键空白。该框架主要涉及两个模块:一个是面部关系学习模块,它为图像中的每个人脸生成可区分的局部特征;另一个是全局特征聚合模块,它利用全局和局部信息之间的相互约束来提高伪造检测的准确性。我们在两个模块上的实验结果 |

| Federated Self-Supervised Learning of Monocular Depth Estimators for Autonomous Vehicles Authors Elton F. de S. Soares, Carlos Alberto V. Campos 基于图像的深度估计在智能交通系统中自动驾驶车辆的计算机视觉研究中引起了极大的关注。这种关注源于其成本效益和广泛的潜在应用。与需要两个固定摄像机的双目深度估计方法不同,单目深度估计方法仅依赖于单个摄像机,因此具有高度通用性。虽然此任务的最先进方法利用深度神经网络的自监督学习以及姿势估计和语义分割等任务,但没有一个方法探索联合学习和自监督的结合来使用捕获的未标记和私有数据来训练模型由自动驾驶车辆。联邦学习的利用带来了显着的好处,包括增强隐私保护、减少网络消耗以及提高对连接问题的恢复能力。为了解决这一差距,我们提出了 FedSCDepth,这是一种结合联邦学习和深度自监督的新颖方法,使单目深度估计器的学习与当前最先进的方法相比具有可比的有效性和卓越的效率。我们在 KITTI 数据集的 Eigen s Split 上进行的评估实验表明,我们提出的方法实现了接近最先进的性能,测试损失低于 0.13,平均只需要 1.5k 训练步骤和高达 0.415 GB 的权重数据 |

| How to effectively train an ensemble of Faster R-CNN object detectors to quantify uncertainty Authors Denis Mbey Akola, Gianni Franchi 本文提出了一种训练两阶段目标检测集成模型的新方法,更具体地说,是 Faster R CNN 模型来估计不确定性。 |

| Comparative study of multi-person tracking methods Authors Denis Mbey Akola |

| Hacking Generative Models with Differentiable Network Bending Authors Giacomo Aldegheri, Alina Rogalska, Ahmed Youssef, Eugenia Iofinova 在这项工作中,我们提出了一种破解生成模型的方法,将其输出从原始训练分布推向新目标。我们在模型的中间层之间注入一个小型可训练模块,并对其进行少量迭代训练,从而保持网络的其余部分冻结。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com

这篇关于【AI视野·今日CV 计算机视觉论文速览 第264期】Tue, 10 Oct 2023的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!