本文主要是介绍最新信息瓶颈理论,打开深度学习的万能黑匣子,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

更多深度文章,请关注云计算频道:https://yq.aliyun.com/cloud

只要你能想到的出,什么都可以交给万能的深度学习——聊天、开车、打游戏、战胜世界围棋冠军——但是,虽然人类创造了它,其内部机制却像个黑匣子,我们所知甚少,除了隐约知道这种学习系统的设计灵感正是我们自己的大脑。哦对了,如果你对脑科学有所了解的话,大脑也是一个我们所知甚少的黑匣子。

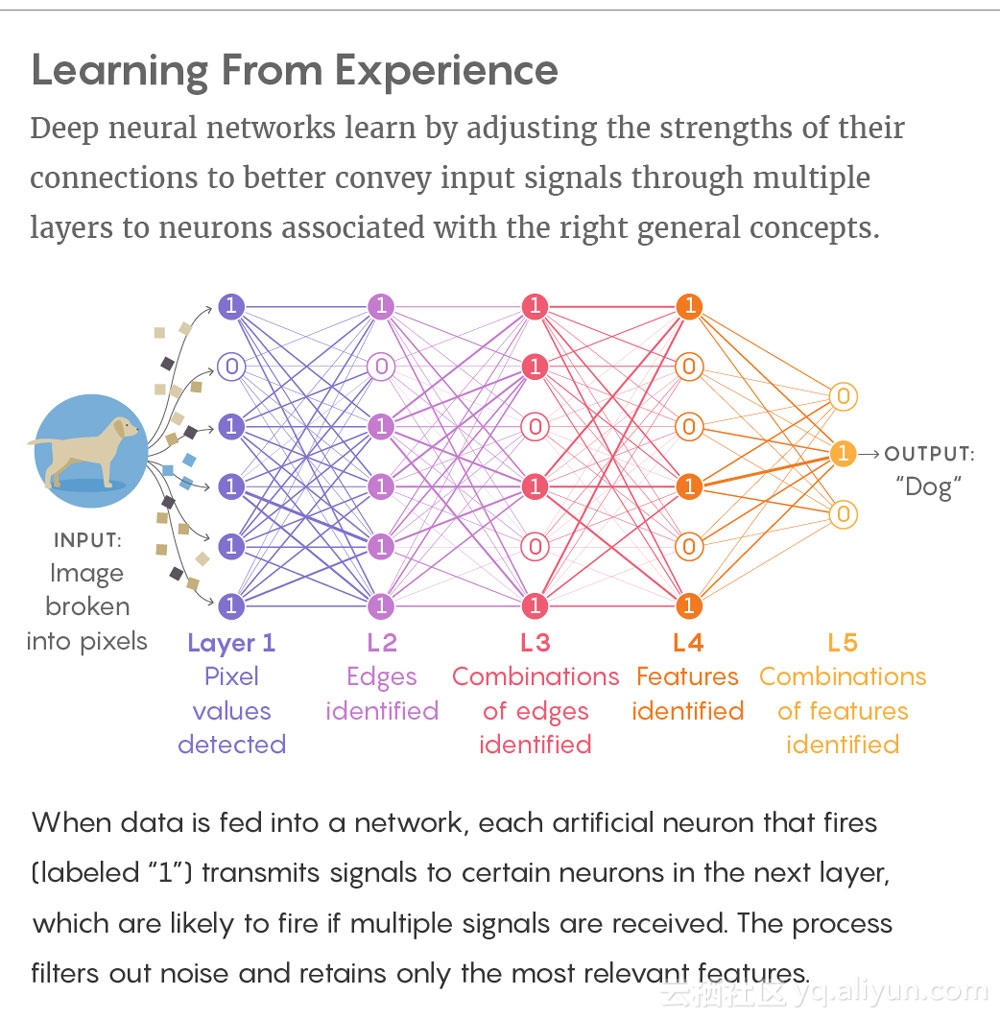

深度学习的机制也和大脑很像。大脑中,神经元激活后会给与其相联系的神经元发送信号。对深度学习来说,深度神经网络也有神经元,它们之间的联系会增强或减弱,让系统能更好地将具体的输入信号与更高层次的抽象概念结合起来。例如,如果系统“学习”了成千上万张小狗的照片,下一张小狗照片里的像素信息能让系统识别出,这是一种叫做小狗的动物。这种质的飞跃就是深度学习的魅力所在,也是所谓的人类“智能”的魅力所在。计算机专家们都想搞懂,是什么样的内在机制让深度学习具有这样的魅力,以及,这与人类大脑解读信息的机制有多大程度上是相同的。

**从经验中学习:

**

深度神经网络也具有很多层的“神经元”,一层层地传递信息,直至与相应的抽象概念所结合的神经元。当系统收到一个输入信息,每一个激活的人工神经元(图中标记数字1的神经元)会给下一层特定的神经元传递信息,最后得到输出:“小狗”。

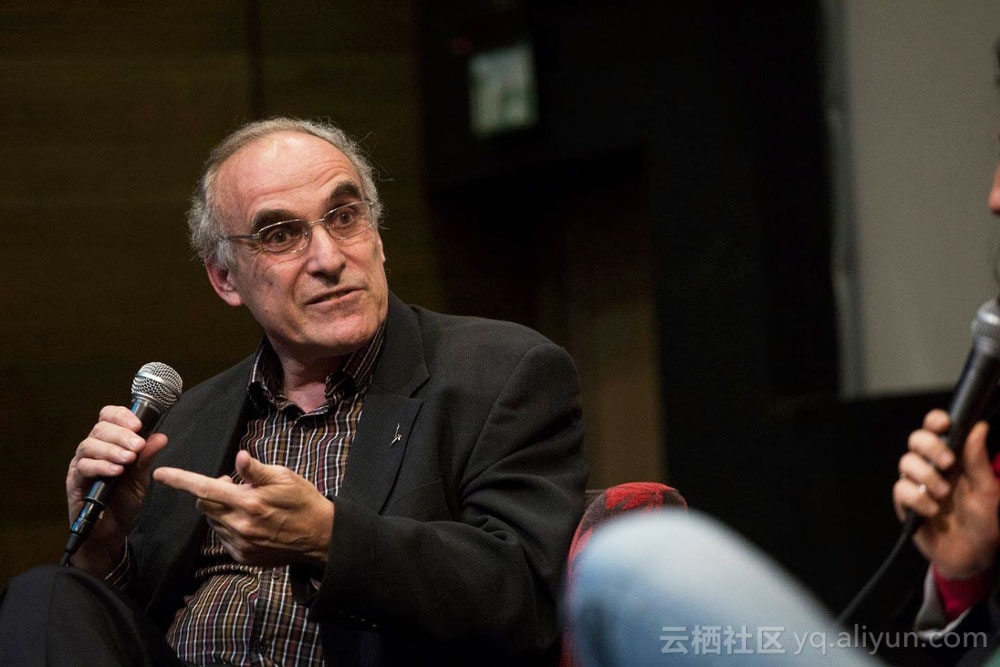

上个月,一个视频刷爆了人工智能专家的朋友圈,耶路撒冷希伯来大学的计算机科学家及神经科学家 Nafttali Tishby 提出了一种理论。他称,深度学习网络具有一种名为“信息瓶颈”的学习过程。早在1999年,他就与两位合作研究员提出过这个想法,不过当时是在纯理论层面,而现在则有了证明。这个概念的大意是:神经网络会把输入信息挤进一个“瓶颈”,过滤多余信息中的噪音,只保留与抽象概念最相关的特征信息。在 Tishby 和他学生的实验中,深度学习过程中的确发生了这种“过滤”过程。

这个概念震动了人工智能研究圈。谷歌研究的 Alex Alemi 也研发过一种方法,将信息瓶颈方法应用在大型深度神经网络上,他称 Tishby 的概念为“未来神经网络研究的重要一步”,不仅能够解释为什么神经网络能够如此强大,还是“未来打造新的网络架构的工具”。

虽然有些研究员怀疑一个概念能否解释深度学习的强大能力,很多人都表示了支持。例如在谷歌和多伦多大学工作的深度学习先锋 Geoffrey Hinton 看了 Tishby 的柏林会议视频后给他发了邮件:“我把视频看了一万遍才真的看懂了,不过,如今能听到有人讲一点真正创新的想法,解决一个真正重大的谜题,真的已经很难得。”

Tishby 认为,信息瓶颈不仅适用于算法,也适用于任何一种学习,无论你是机器、人类、还是一只蝴蝶,“学习中最重要的部分就是遗忘。”正如纽约大学的粒子物理学家 Kyle Cranmer 所说,信息瓶颈理论作为一种普遍的学习原则来说,“听起来很有道理”。这位粒子物理学家在大型强子对撞机上,使用机器学习分析粒子碰撞。

瓶颈

早在上世纪80年代,Tishby 就开始思考信息瓶颈的问题。当时 AI 所面临的大挑战是我们人类非常擅长的语音识别问题,Tishby 认为问题的关键是相关性:对于一个词语来说,最相关的特征是什么?人类在语音识别中面临着海量的信息,我们保留的是什么?我们如何排除不相关的噪音,例如口音、口吃、语调?

Tishby 说:“历史上很多人都考虑过相关性的问题,但是这么多年人们都认为信息科学与相关性无关,早在香农的年代就有这种误解。”上世纪40年代,香农被称为信息理论之父,以纯数学意义上的 1 和 0 将这门学科抽象化。香农认为“信息和语义是无关的”,而 Tishby 现在反对说:“信息理论中,你可以精确定义相关性。”

到90年代,Tishby 和两位合作者——现在在谷歌工作的 Fernando Pereira 和现在在普林斯顿大学的 William Bialek——将语音识别转化为了一个数学优化问题。设想一下:数据库 X 包含了一张小狗照片里的所有像素信息,而 Y 一个简化过的数据库,只包含“小狗”这个类别信息,也就是说,将 X 尽可能地压缩,但仍能让人识别出这是小狗。这是一个非常创新的想法,不过没用有热门的杀手级应用。“我照着这个思路再研究了30年,” Tishby 说,“幸运的是,如今深度神经网络变得如此重要。”

场景、人、脸、耳朵

2010年代,红火了几十年的深度学习概念随着训练框架和电脑处理器的改善,有了真正的突破。2014年,Tishby 读到了一篇由物理学家 David Schwab 和 Pankaj Mehta 写的论文,发现了由 Hinton 发明的深度学习算法,与重归一化一摸一样。这种方法可以应用在物理学中,对一个物理系统进行缩小,忽略其细节,来计算其总体状态。当这种方法应用到一个稳定点状态的模型时(稳定点意味着系统是分形的,也就是说,无论放大还是缩小,系统都是一摸一样的),网络自动使用了类似重归一化的过程,来计算模型的状态。

唯一的问题就是,现实世界不是分形的。Cranmer 说:“如果你一直放大,现实世界不会是一个耳朵里面还有一个耳朵、还有一个耳朵,而是一个场景里面有一个人、人有一个脸、脸上有一个耳朵。所以我不觉得深度学习的成功归功于重归一化。”而 Tishby 认为,深度学习和这种放大过程之外还有一个更大的概念。

Naftali Tishby 的研究生学生 Noga Zaslavsky(左)和 Ravid Schwartz-Ziv(右)帮助开发了深度学习的信息瓶颈理论。

2015年,Tishby 和学生提出了深度学习是一个信息瓶颈过程的假设,系统在保留信息所表征目标的同时,尽可能地压缩信息中的噪音。他们的实验也证明了信息瓶颈的实际过程。实验使用了小型的模型,能够将输入标记为 1 或 0(我们可以设想,1代表“是小狗”,0代表“不是小狗”)。

大部分深度学习过程所使用的基本算法被称为“随机梯度下降”:神经元的激活会在神经网络中一层层地上传,到顶层时,激活的模式会与正确的标签相比较,然后得出结论——“是小狗”或者“不是小狗”。随着训练的积累,常见的模式会反映在神经元连结的强度上,网络就此成为为数据贴标签的专家。

在 Tishby 的实验中,他们记录了深度神经网络的每一层能保留多少输入信息,并发现随着一层层深入,网络体现出了信息瓶颈理论:Tishby 与 Pereira、Bialek 曾在论文中推导过一个理论极限,代表系统在抽取相关信息时的绝对最佳值,此时系统在能够准确预测标签的前提下,尽可能地压缩输入信息。

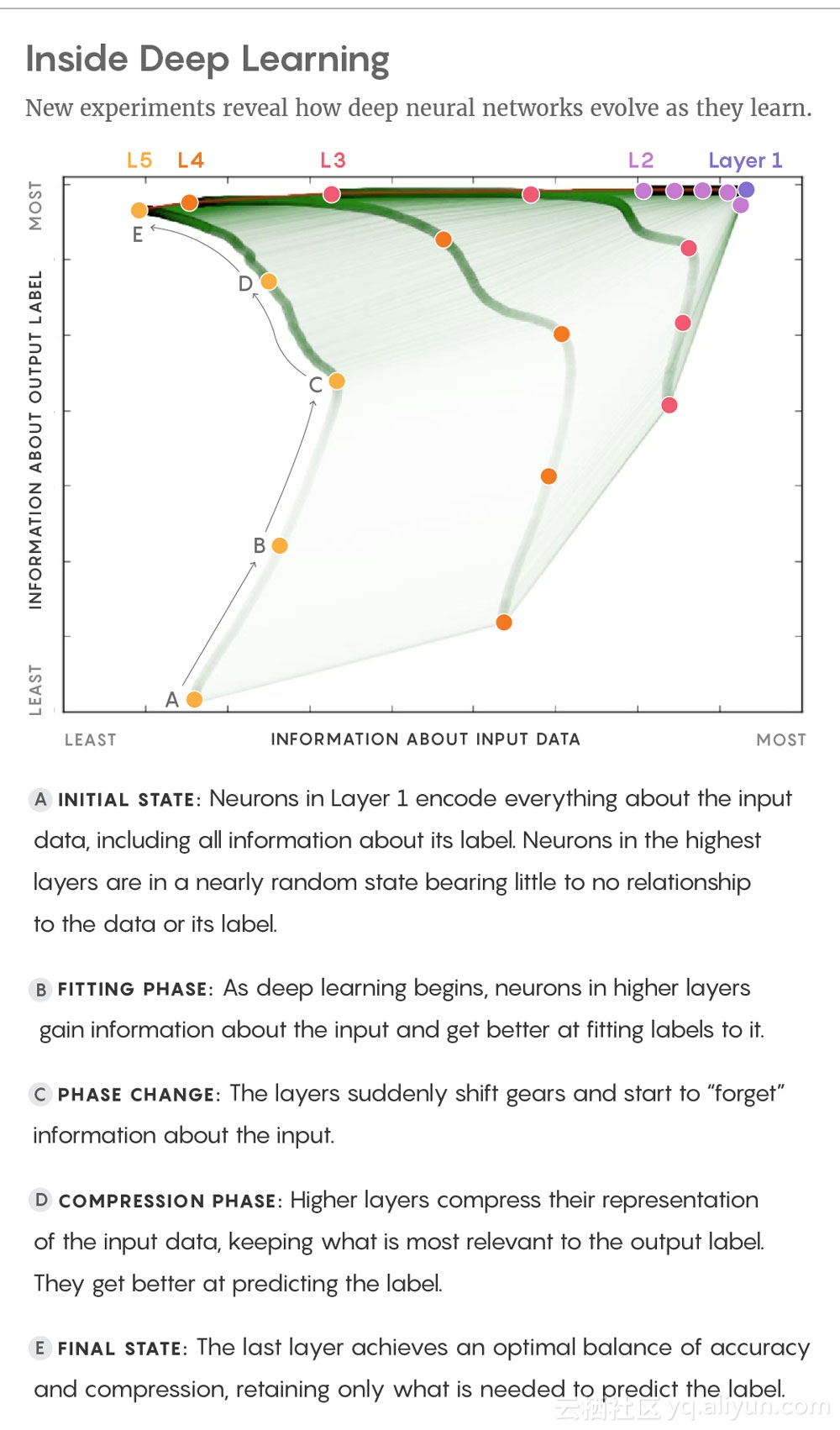

实验还有一个有趣的发现:深度学习过程包含两个阶段。先是一个短暂的“拟合”阶段,系统学会为训练数据贴标签;然后是较长的“压缩”阶段,系统学会抽象概括。

阶段A:初始状态。第一层的神经元将输入信息编码,在最高层的神经元处于一个近乎随机的状态。

阶段B:拟合阶段。随着深度学习的开始,高层的神经元获得了关于输入的信息,能更好地将适合的标签配给输入。

阶段C:阶段转换。各个层突然改变,开始“遗忘”关于输入的信息。

阶段D:压缩阶段。更高的各个层压缩对于输入信息的表征,变得更擅长预测标签。

阶段E:完成阶段。最后一层达到了精准与压缩之间的最佳平衡。

一开始,由于神经元连结学会自我调试、为输入信息中的模式进行编码和标签,系统存储的信息量会增加,就好像人类的记忆过程。然后,系统从学习过程转为压缩过程,开始减少信息量。这是因为在随机梯度下降的每一次迭代中,训练数据中的联系大致上比较随机,使得系统尝试不同方向,将神经连结进行强弱调整。例如,有些小狗的照片可能背景里有房子,有些背景里有草地,随着神经网络学习各种各样的照片,可能就会“遗忘”房子和狗的关联性,因为着另外的照片中并没有这种关联。Tishby 和学生们称,正是这种“遗忘”具体特征的能力,使得系统可以形成抽象概念。

现在还未证实,信息瓶颈理论是否能统领所有的深度学习领域,或者除了压缩以外是否还有其他的抽象概括方法。哈佛大学的人工智能研究员及理论神经科学家 Andrew Saxe 称,一些非常大的深度神经网络貌似不需要明确的压缩阶段,就能很好地抽象概括。不过,信息瓶颈理论所定义的边界还是优于其他方法。Tishby 和学生最近的实验调查了信息瓶颈是否适合更大的神经网络,在一个330,000 个连结的更大型的神经网络上,来识别6万个手写数字,这是测试深度学习算法的通用标准。实验中同样可以观察到理论瓶颈边界以及两个不同的深度学习阶段,并且比小型网络中的阶段转换更加明显。Tishby 说:“我完全相信,这是一个普遍现象。”

人与机器

早期的人工智能先驱们一直想揭开大脑学习的秘密,并进行逆向工程,应用至深度学习中。虽然后来大部分人都遗忘了这条道路,不过现在,随着机器能力的飞速提升,不少人甚至认为 AI 有可能带来人类的生存危机,学习与智能的内在机制又成为了人们渴望揭开的谜题。

“Tishby 的研究代表了一个重大前进,打开深度学习的黑匣子。”纽约大学的心理学与数据科学助理教授 Brenden Lake 说,他研究的方向是人类学习与机器学习的相似及差异。不过,他强调说,与机器学习相比,人类的大脑是一个更大、更黑的黑匣子。

成年人大脑的八百六十亿神经元之间,大约有几百万亿个连结,我们在婴儿时期就学会了比简单的图形和语音识别更难的抽象感念。Lake 研究人类儿童如何识别手写字,发现儿童不像机器一样必须看过几千个例子、然后再花时间去抽象概括,儿童实际上只要又一个例子就能学习,识别出新的手写字并自己书写。Lake 及其同事的模型说明,大脑可能将新的字母解构为一系列的笔划,而笔划是大脑已经理解的一种概念。“儿童不用把字母看作是某种像素的排列模式,不用以学习一系列特征的方式来学习概念。”

这么聪明的办法应该能为 AI 研究人员带来启发。Tishby 相信自己的信息瓶颈理论能为人类与机器的研究都做出贡献。例如,什么样的问题可以用人工神经网络而什么问题得用真的大脑网络。Tishby 说,有一些问题“我能消除输入里的噪音而不影响分类的能力,这是自然视觉、语音识别。这些也是我们大脑能处理的问题。”

本文由北邮@爱可可-爱生活 老师推荐,阿里云云栖社区组织翻译。

文章原标题《New Theory Cracks Open the Black Box of Deep Learning》。

译者:炫,审校:袁虎。

文章为简译,更详细的内容,请查看原文。

这篇关于最新信息瓶颈理论,打开深度学习的万能黑匣子的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!