本文主要是介绍论文阅读——DaST: Data-free Substitute Training for Adversarial Attacks,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

摘要

对于黑盒设置,当前的替代战术需要预先训练的模型来生成对抗样本。然而,在现实世界的任务中很难获得预先训练的模型。本文提出了一种无数据替代训练方法(DaST),在不需要任何真实数据的情况下获得对抗黑箱攻击的替代模型。作者针对generative moddel设计了一个multi-branch 结构和label-control loss来解决合成样本分布不均匀的问题

缺陷

替代模型仅针对与某一特定的目标模型

仍需访问目标模型的输出或输出概率分布

训练生成器查询量必定很大

相关性工作

攻击方法主要分为两类:黑盒攻击和白盒攻击。

黑盒攻击主又可分为基于分数的攻击和基于决策的攻击利用被攻击模型返回的类概率或硬标签直接攻击被攻击模型。这些攻击方法不需要预先训练的替代模型,但是作为代价,它们需要对被攻击模型进行大量查询来生成每次攻击。

方案

使用生成网络构造替代模型的数据集,因此可在训练替代模型时不需要数据

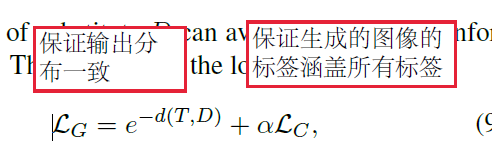

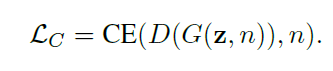

(1)生成器损失

其中,

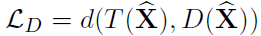

(2)替代模型损失

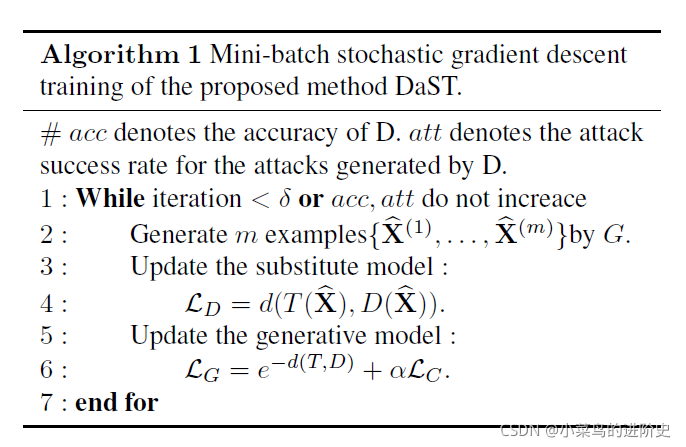

(3)生成网络训练算法

疑问:

z是什么?如何取值?

对比的模型为什么全是白盒攻击?

这篇关于论文阅读——DaST: Data-free Substitute Training for Adversarial Attacks的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!