本文主要是介绍笔记-Sparse Representationor Collaborative Representation: Which Helps Face Recognition,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

(之前写的笔记了,也是难得写这么多)

论文中心:

It is the CR, but not the l1-norm sparsity, that plays the essential role for classification in SRC。

首先:l1-norm与 l2-norm有差不多的作用

其次:发挥核心作用的是CR

论文的核心思路:

大致的思路:在样本充足的情况下解释稀疏表征的可能性,并且验证稀疏表征在解决 FR 问题上的优势——很好的降低了其他算法在 FR 上解决相似分类时的不稳定性。然 后打破假设,用 CR 弥补了实际的问题中字典不完备的问题,并用实验验证,是CR 在 算法中发挥了关键作用。

两个重要的验证实验:

1)

① 目的:解释 SRC 对比之前的算法的优势,重点是解释在区分相似的分类时的准确 程度

② 假设前提:样本的容量足够

③ 条件:图片的特征向量维度低

④ 对象:两个接近的分类

⑤ 变量:横向稀疏程度 纵向不同的字典

⑥ 结论:

i、 当表征的训练样本的数目过少时,结果的误差都很大。

ii、 当表征的训练样本的数目太多的时候,对于相似的结果,辨别 将变得不稳定。

iii、 当表征的训练样本的数目适当时,用来自正确的类别的图片表 征时结果要明显优于来 自错误的类别。

2)

① 目的:证实CR 的核心作用

② 条件:样本不足,字典每一个分类的列向量实际上是不完备的 不同分类的图片具有相似性,因此可以使用协同表示来弥补不完备的特征

③ 对象:完整的 FR 数据集

④ 变量:纵向不同的范数 横向不同的稀疏程度

⑤ 结论:

i、 l1-norm 与 l2-norm有着差不多的作用

ii、 发挥核心作用的是CR

SRC Algorithm & CRC_RLS Algorithm

文章的细节阅读:

①为什么可以使用稀疏表征

One particularly simple and effective approach models the samples from a single class as lying on a linear subspace. Subspace models are flexible enough to capture much of the variation in real data sets and are especially well motivated in the context of face recognition, where it has been observed that the images of faces under varying lighting and expression lie on a special low-dimensional subspace, often called a face subspace.

each class of face images often lies in a small subspace of ℜm ->the m-dimensional

face image x can be characterized by a feature vector of much lower dimensionality.-> Xi will be correlated.Assume that we have enough training samples->Xi is an over-complete

dictionary1->class i can be sparsely represented over dictionary Xi.

表情或者亮度不同的脸部图片属于一个维度很低的子空间,当训练集足够的时候,Xi

将是一个过完备的字典,于是,如果 y 属于某一类,y 就可以被稀疏的表示。(用相关性强 的矩阵表示远比用正交矩阵表示的结果选择的可能性多,且稀疏)

Class = k:

②为什么使用稀疏表征,SRC 对比之前的算法的优势——减小区分相似的分类时的不稳定

If y is from class i, it is more likely that we can use only a few samples (e.g., 5 or 6 samples) in Xi to represent y with a good accuracy. In contrast, we may need more samples in Xj to represent y with nearly thesame accuracy.

当两个不同的分类之间相关性高,差别小的时候,用传统的方法极易带来误差,而使 用 SRC 可以很好的减小这种误差。对于图像的分类,可以通过样本的数量反应,越接 近真实分类,所使用的样本越少。

实验验证:用两个相似程度高的分类验证,少量的同类别的图片的线性相加可以很好 的接近目标图片。

分别用两个分类集作为字典,在不同的可供引用的训练样本数目限制下进行实验,得 到残差。

we can see that when using only a few training samples (<3) to represent the query sample, both of the two classes have big error; when more and more training samples are involved, the representation error decreases. However, the discrimination ability of the representation error will also reduce if too many samples (>10) are used. we may have the following proposition for l0-norm sparsity: a query sample should be classified to the class which could faithfully represent it using less number of samples.

Unfortunately, FR is a typical small-sample-size problem, and Xi is under-complete in general. If we use Xi to represent y, the representation error can be big, even when y is from class i. Consequently, the classification will be unstable not matter the error ei or the sparsity ||αi||p or both of them are used for decision making.

结论:

i、 当表征的训练样本的数目过少时,结果的误差都很大。

ii、 当表征的训练样本的数目太多的时候,对于相似的结果,辨别 将变得不稳定。

iii、 当表征的训练样本的数目适当时,用来自正确的类别的图片表 征时结果要明显优于来自错误的类别。 前面的过程都基于样本集充足的前提,但在实际情况中这个假设很可能不成立,于是 每一个分类中的样本不够, Xi 其实是不完备的,于是仅仅是使用 SR 会带来很大的误差。

③为什么采用CR

Fortunately, one fact in FR is that face images of different classes share similarities. Some sample from class j may be very helpful to represent the testing sample with label i.

于是根据脸部的相似性,用其他分类的图像协同表征。

One interesting point here is that after the collaborative representation (CR) with all classes, SRC classifies y individually (i.e., check class by class).

④CR发挥着重要的作用

For the simplicity of analysis, let’s remove the l1-norm sparsity term in Eq. (1), and then the representation becomes a least square problem:

对于 ,它属于 Xi 的线性叠加,属于 Xi 的张成平面,且与 y 最接近,将其

展开,对于每个分类,y 与 ˆy 的距离都是一样的,于是可 以进一步简化。最后有:

就类似于正弦定理:

Such a “double checking” makes the classification more effective and robust

对于同类别的样本,两个向量之间的距离是最近的。

于是最小。同时引入两个正弦量,可以使得结果更加准确将距离的比较转换到角度上,越相似两者夹角越小,于此同时与由除该向量外 的其他向量的线性和向量越远。

One problem is that when the number of classes is too big, the least square solution

will become unstable

分类集太大后,即使不用同类的样本,依旧可以不错的表示,与之前的第一个实验有差不 多的意思,同时也是因为脸部图片的相似性。

此时就要加入对稀疏的限制了。

对稀疏的限制是为了使 CR 的表达更加稳定,防止在数量不加以限制的情况下,用其他的 类别也达到不错的表示,从而使结果不稳定。所以 CR 发挥更加关键的作用。

⑤用CRC_RLS验证CR的关键作用

拉格朗日约束方程有:

求解有:

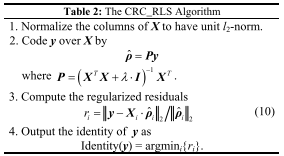

于是有CRC_RLS算法:

在实际的数据集上验证得到结果: 分别使用 l1-norm 与 l2-norm,在不同的λ下得到识别的正确率,最后比较。

We test the performance of SRC (l1-regulazied minimization) and CRC_RLS (l2-regulazied minimization) by increasing the value of regularization parameter λ

λ的值对应着稀疏矩阵的影响,也代表不同程度稀疏性。不同的范数代表了不同的算法 实验需要“否定”l1-norm sparsity 的关键作用。

First, with the increase of sparsity (>0.000001), no much benefit on recognition rate can be gained. Second, l2-regulazied minimization (i.e., CRC_RLS) could get higher recognition rates than l1-regulazied minimization (i.e., SRC) in a broad range of λ. This implies that l1-norm does not play the key role in face classification.

结论:

i、 l1-norm 与 l2-norm有着差不多的作用,甚至 l2 更好

ii、 在一定范围的λ中,辨别率很高且稳定,稀疏程度在一定范围影 响不大

iii、 发挥核心作用的是CR

⑥ 其他的实验进一步的验证

一, Gender classification

In this section, we validate our claim in Section 3.1 that when the samples in each class are enough, there is no need to code the testing sample over the whole dictionary.

One can see that L1R and L2R get the best results, which validates that coding on each class’ dictionary is more powerful than coding on the whole dictionary when the training samples of each class are enough, no matter l1- or l2 -regularized minimization is used. CRC_RLS gets the second best result, about 1.4% higher than SRC

当样本充足的假设成立时,采用每一类单独表征得结果比 CR 更好。

二, Face recognition

1) Extended Yale B Database——相对充足的训练集上实验(32)-> SRC,CRC 甚至NN, LRC, SVM也取得不错的结果

2) AR database——比较少的训练集上实验(7)-> SRC 和 CRC 总体上明显优于其他的,在维度不同的情况下,两者的结果不同。

3) Multi PIE database——表情,姿势,光照等不同的影响因素-> SRC 和 CRC 总体上明显优于其他的

4) FR with real face disguise——口罩等的遮挡-> SRC 和 CRC 总体上明显优于其他的,不同的遮蔽物下两者的准确度有一定的差异

In all the above FR experiments, both CRC_RLS and SRC are better than NN and LRC because of the benefit brought by CR. On the other hand, the result of CRC_RLS is comparable to SRC, showing that the l1-norm regularization does not bring more benefit than the simple l2-norm regularization in FR

这篇关于笔记-Sparse Representationor Collaborative Representation: Which Helps Face Recognition的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!