本文主要是介绍[论文笔记]Reinforcement learning helps slam: Learning to build maps,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Reinforcement learning helps slam: Learning to build maps

本文使用强化学习来探索未知环境以及重建地图。对比了三种不同的奖励函数,同时对比了三种不同的基于RL的路径规划器的性能。

INTRODUCTION

对于未知环境(没有任何现有地图)研究人员开始在这些机器人上开发更多的智能来探索环境,而不是遵循在已知环境中研究的预先定义的路径。以便导航未知环境并共同构建环境地图,当SLAM算法用于实时主动规划机器人路径,同时构建环境地图时,SLAM算法被命名为主动SLAM ,由Trivun等人在2015年提出。

到目前为止,最广泛使用的主动SLAM方法被称为基于边界的勘探(Yamauchi,1997),该方法通过简单地观察所选边界(即地图上已知和未知区域之间的区域)是否通向被占用的空间来产生控制信号。然而,这种方法也有局限性,例如不能搜索最优路径(即,用于从一种状态转换到另一种状态的最优控制函数序列),并且依赖贪婪标准来选择要访问的边界(例如,最小距离或信息增益)。此外,还需要一个路径规划器,用于在没有冲突的情况下导航到选定的边界

本文将SLAM的控制信号生成和状态转换视为解决一个RL问题,其中代理必须学习最佳的动作序列(控制信号的最佳序列),即使总累积回报最大化的序列。

目标是在最短的时间内探索并完成地图而不发生碰撞。为了选择最佳行动u,代理接收关于环境状态的信息和与之相关的奖励r。

对于RL 状态向量可以包括传感器读数、地图信息、机器人过去采取的动作等。即用于学习最优轨迹的所有重要信息。由于自由度较高,很难选择合适的状态向量,但一个信息丰富的状态向量对于学习算法的良好性能至关重要。

RELATED WORK

RL被用于学习解决未知环境下机器人自主导航的路径规划问题。通常,这些方法不构建和使用任何地图来在不同的环境中导航。但这些方法往往样本效率较低,并且需要较长的训练阶段。

还有一些方法结合了RL和SLAM来学习如何在未知环境中导航。通过利用存储在地图中的知识使导航具有更高的性能和效率。

RL用于导航已经有很多工作了,而且解决的比较好,但是使用RL来构建地图仍然需要研究。就比如 上次讲的那篇文章,RL代理被训练为使用RGB-D传感器构建3D地图,但是需要专家轨迹来初始化代理的策略。

SLAM 和 RL 相关理论

SLAM构建地图

构造环境地图使用Rao-Blackwellized particle filter(RBPF)

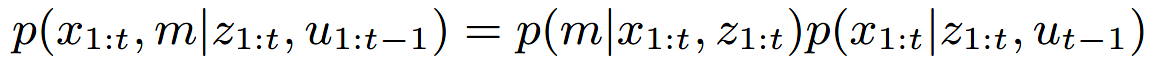

SLAM的核心思想是根据其观测值和其里程计测量信息去估计联合后验概率密度函数(代表地图中的点、代表机器人的轨迹)。可以看出,轨迹和地图需要同时计算出来,这样的计算很复杂而且计算的结果可能不收敛。机器人首先需要知道自身的位置去获得一个准确的地图,但是获取地图同样也需要一个准确的定位。

RBPF可以先估计机器人的轨迹而后再去根据已知的轨迹计算地图。由地图的概率密度函数可以看出,地图强烈依赖于机器人的位姿,所以这个方法是可行的。

x 1 : t x_{1:t} x1:t 为机器人的轨迹 , z 1 : t z_{1:t} z1:t 为传感器的数据, u 1 : t − 1 u_{1:t-1} u

这篇关于[论文笔记]Reinforcement learning helps slam: Learning to build maps的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!