本文主要是介绍不写代码、构建一个开源的 ChatGPT,总共需要几步?|Hugging News #1020,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」。本期 Hugging News 有哪些有趣的消息,快来看看吧!🎉

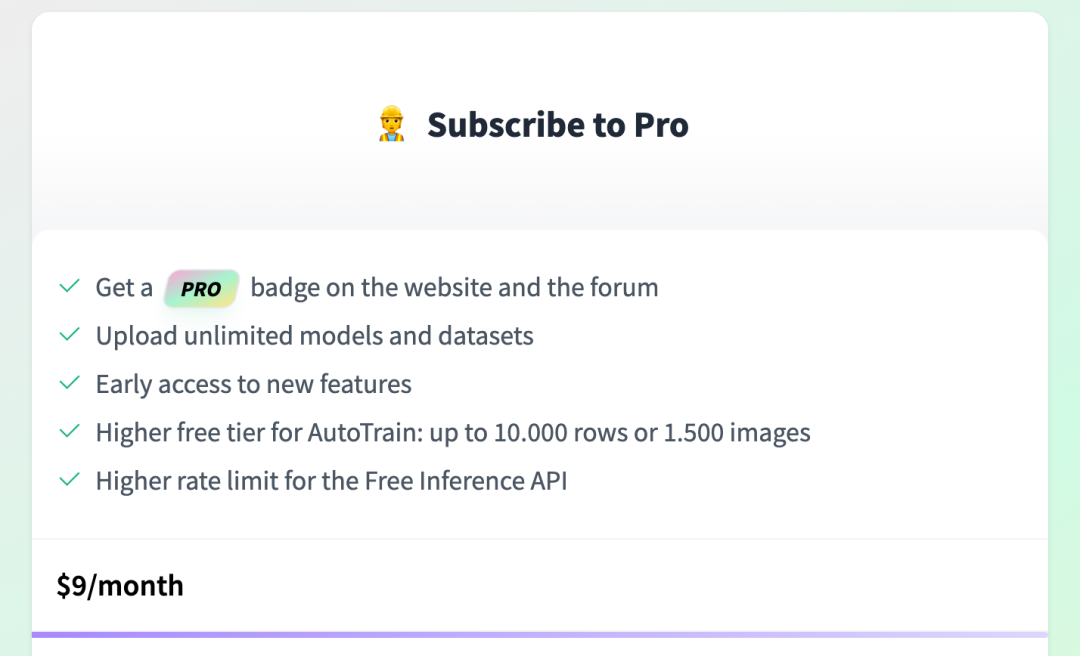

给 Pro 订阅账户加入的更高级的推理 API 功能

我们为 Hugging Face Pro 订阅用户加入了一些新的模型 API 访问权限包括 Llama 2 Chat、Code Llama Base 和 Stable Diffusion XL 等,同时也提高了对推理 API 的速率限制。开发者们可以更好地进行模型实验和原型开发,而无需部署模型到自己的基础设施上。

朋友们,升个级?https://hf.co/subscribe/pro

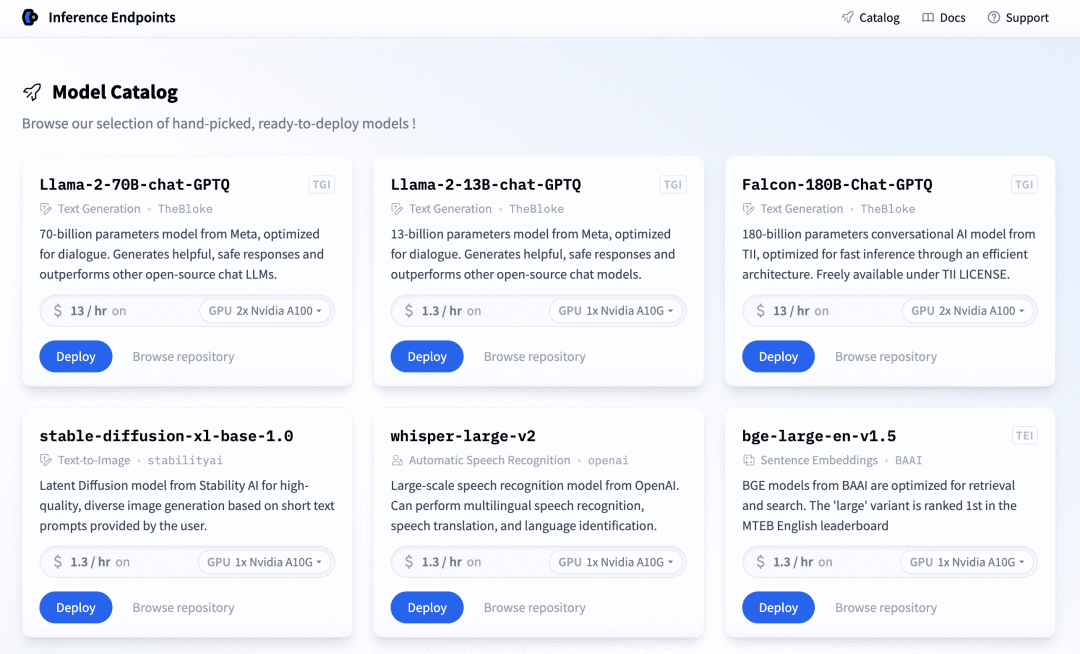

为推理 API 发布新的模型分类页面

我们发布了一个新的模型分类页面,展示了一系列精选、即时可部署的模型,包括如文本生成、文本到图像、自动语音识别和文本嵌入提取等多个模型分类。每个模型条目提供了模型的简要描述、优化目标、模型的参数大小、每小时的运行成本和运行所需的硬件配置,例如 GPU 型号等。

大家可以在这里查看:https://ui.endpoints.huggingface.co/catalog

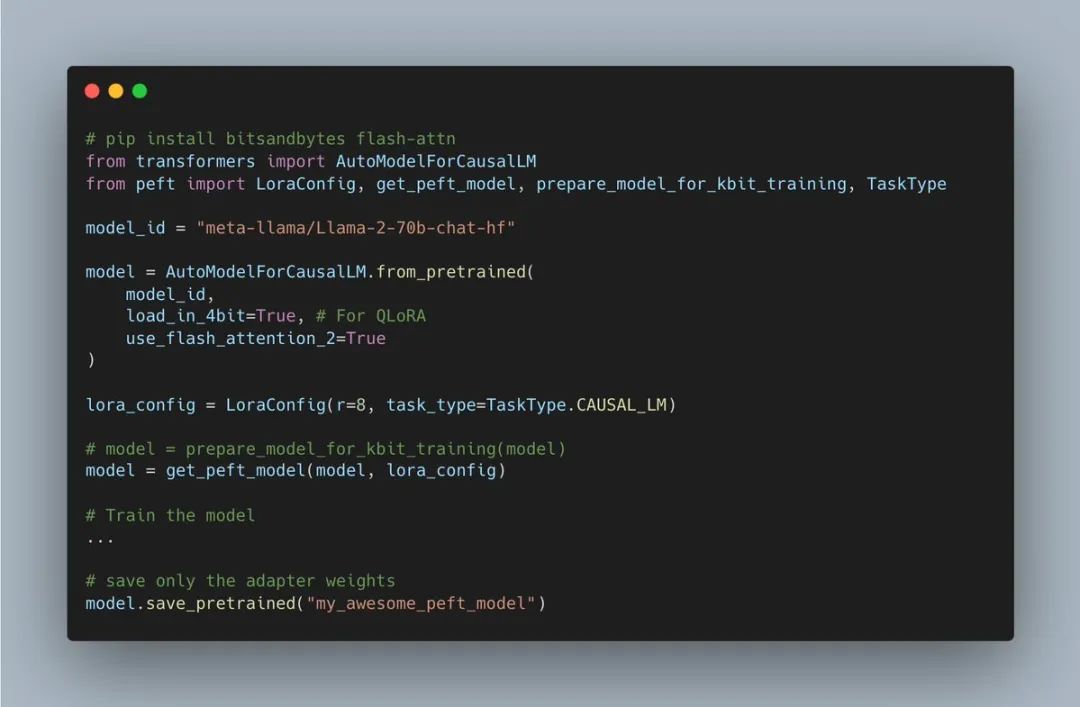

Flash Attention 2 现已在 🤗 Transformers 可用

Flash Attention 2 是一个优化的注意力机制算法,旨在改善基于 transformer 的模型的效率。通过改进并行处理和工作分区、减少内存使用、Flash 解码等策略,使得模型以更长的序列长度运行和训练,而不会遇到内存溢出问题,从而更好地处理大规模数据。

🤗 Transformers 现已原生支持 Flash Attention 2,支持 PEFT(预训练嵌入式微调)的训练和量化(GPTQ, QLoRA, LLM.int8)。

构建一个开源的 ChatGPT,总共需要几步(还不用写代码)

我们发表了一篇博客,介绍如何在不编写任何代码的情况下构建自己的开源 ChatGPT,它使用 LLaMA 2 基础模型,通过一个开源指令数据集对其进行微调,然后部署到一个聊天应用程序中,可以与朋友分享,使用 Hugging Face 平台的各种工具 ,如 Spaces、AutoTrain 和 ChatUI。

🔥https://hf.co/blog/Llama2-for-non-engineers

以上就是本期的 Hugging News,我的愿望是——(评论区说说?

这篇关于不写代码、构建一个开源的 ChatGPT,总共需要几步?|Hugging News #1020的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!