本文主要是介绍【Chain-of-Thought 专题】Chain-of-Thought Prompting Elicits Reasoning in Large Language Models,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

【Chain-of-Thought 专题】Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

ChatGPT 🔥🔥🔥🔥火了

GPT-4 🔥🔥🔥🔥🔥 已于2023年3月15日凌晨发布

作为NLP Researcher

不了解预训练语言模型、prompt-tuning、chain-of-thought

你一定会被OUT!

走向NLP最前沿,你只需阅读下面两篇博客!!!

-

快速学习预训练语言模型,进入专栏阅读:预训练语言模型

-

深入学习Prompt-Tuning:点击阅读:Prompt-Tuning——深度解读一种新的微调范式

Prompting——深度解读一种全新的微调范式

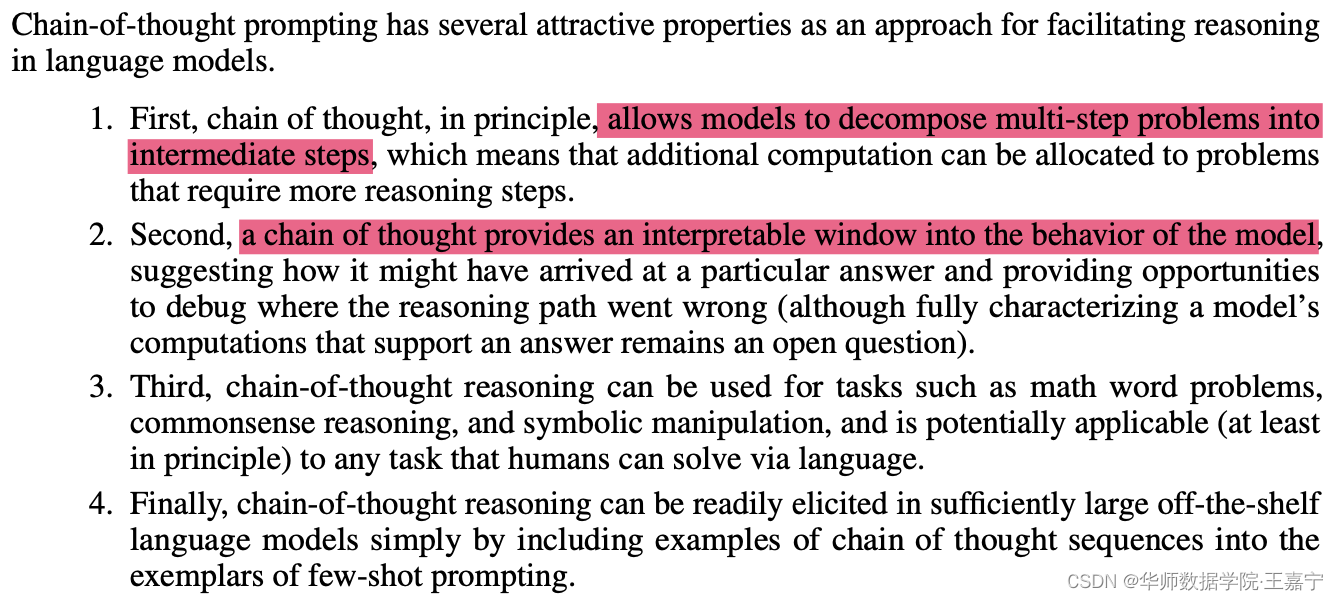

Chain of Thought(CoT)—— a series of intermediate reasoning steps—significantly improves the ability of large language models to perform complex reasoning.

一、介绍

增大模型参数规模对于一些具有挑战的任务(例如算术、常识推理和符号推理)的效果并未证明有效;

Scaling up model size alone has not proved sufficient for achieving high performance on challenging tasks such as arithmetic, commonsense, and symbolic reasoning.

因此我们期望探索如何对大模型进行推理的简单方法:

- 对于算术类推理任务,期望生成自然语言逻辑依据来指导并生成最终答案;但是获得逻辑依据是比较复杂昂贵的。

It is costly to create a large set of high quality rationales, which is much more complicated than simple input–output pairs used in normal machine learning.

- 对某个task,为大模型提供一些上下文in-context example作为prompt;简单的示例可能并非能够提升推理能力。

It works poorly on tasks that require reasoning abilities, and often does not improve substantially with increasing language model scale.

- 本文提出chain of thouth prompting:A chain of thought is a series of intermediate natural language reasoning steps that lead to the final output, and we refer to this approach as chain-of-thought prompting.

二、Chain-of-Thought

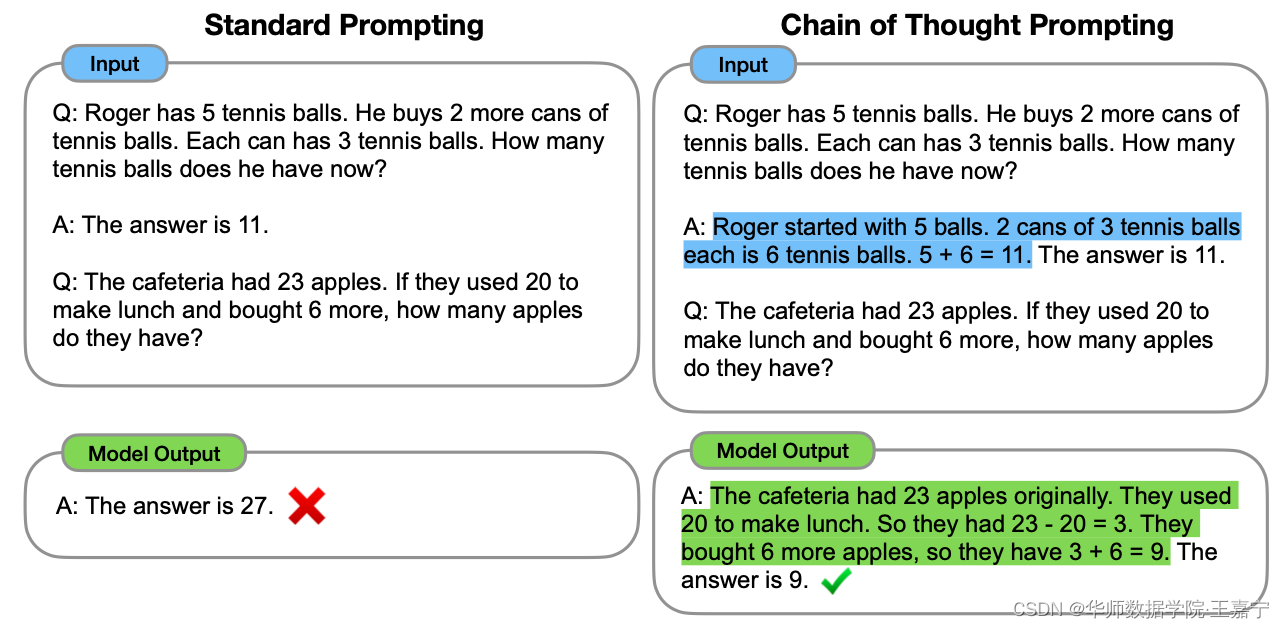

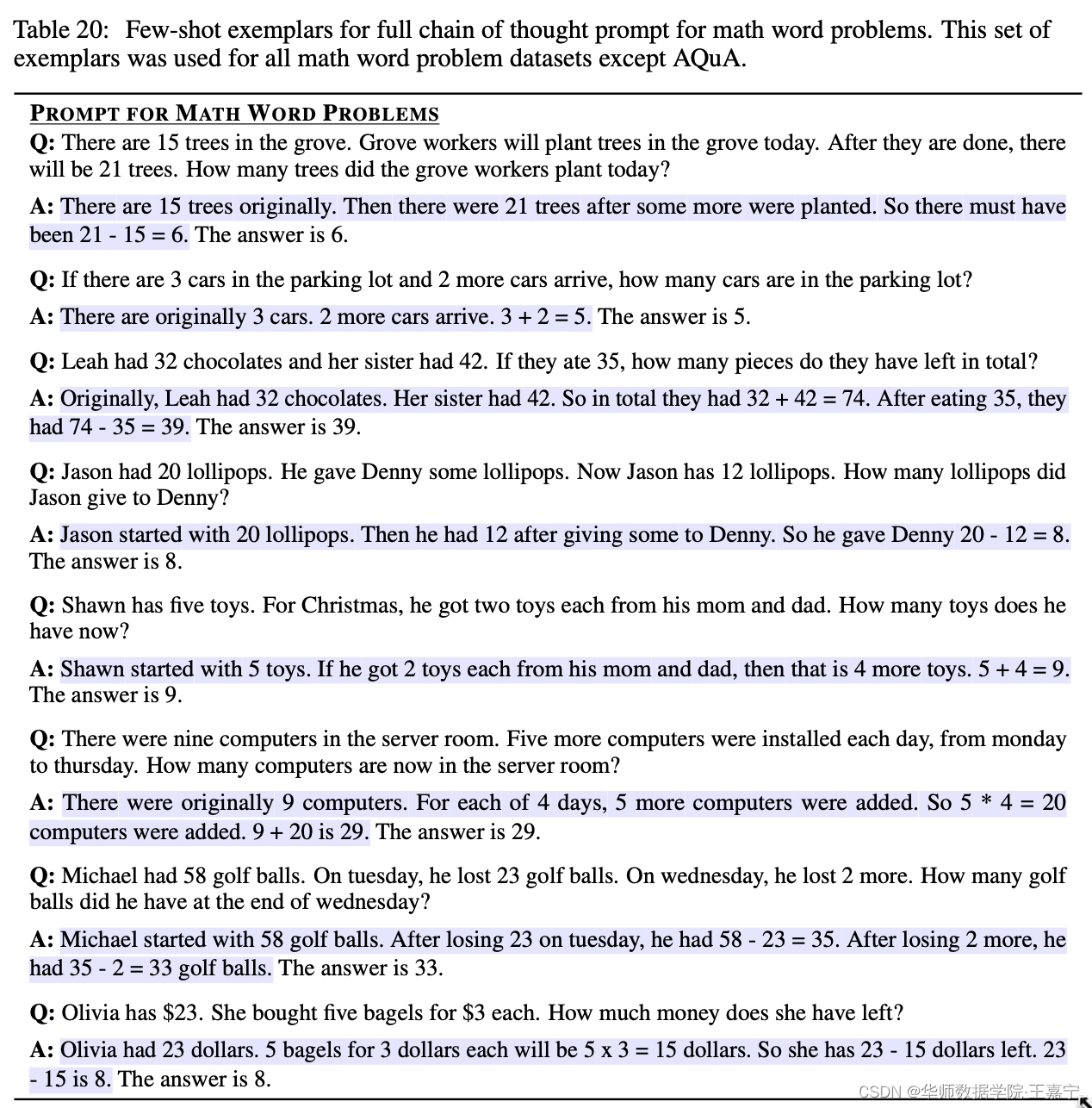

下面给出几个Chain-of-Thought样例:

传统的方法是,给定几个人工标注的Template,或者少量样本作为In-Context Example来提示大模型生成结果。但是这种方式无法保证生成结果的可靠性。为了进一步提高大模型对于一些较为复杂任务的表现。CoT旨在通过在In-Context Learning的基础上,对每个问题(Question)输出结果(Answer)的同时,提供解答的推理依据(Rationale),这种依据通常是一种推理路径(Reason Path)的形式呈现。通过展示对一个问题的解答,能够很好地激发出模型按照人类思考的模式生成合理的答案。

例如在数学计算问题上,只需要人工标注少量的chain-of-thought,即可以得到很惊艳的效果:

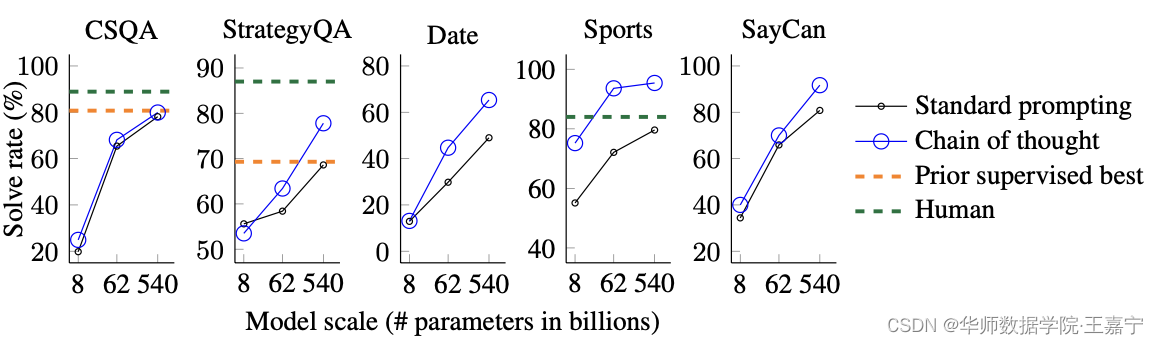

事实证明,Chain-of-Thought对超过1000亿参数量规模的模型所展现的性能提升效果是很明显的。

更多基于GPT-3的Chain-of-Thought的Benchmark详见:https://github.com/FranxYao/chain-of-thought-hub。

三、Chain of Thought的未来工作:

- 虽然Chain-of-Thought模拟了人类推理者的思维过程,但这并不能回答神经网络是否真的“推理”,我们将其作为一个悬而未决的问题。

- 尽管在少样本设置中手动增加具有思想链的样本的成本是最小的,但这样的注释成本对于微调来说可能是令人望而却步的(尽管这可能会被合成数据生成或零样本泛化所克服)。

- 不能保证正确的推理路径,这可能导致正确和错误的答案; 改进事实语言模型是未来工作的一个开放方向。

- 仅在大型模型尺度上出现的思维链推理使得在实际应用中服务的成本很高; 进一步的研究可以探索如何在较小的模型中进行推理。

这篇关于【Chain-of-Thought 专题】Chain-of-Thought Prompting Elicits Reasoning in Large Language Models的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!