2019独角兽企业重金招聘Python工程师标准>>>

一.出发点:

之前在知乎看到一位大牛(二胖)写的一篇文章:python爬取知乎最受欢迎的妹子(大概题目是这个,具体记不清了),但是这位二胖哥没有给出源码,而我也没用过python,正好顺便学一学,所以我决定自己动手搞一搞.

爬取已经完成,文末有 python的源码和妹子图片的百度云地址

二.准备:

爬虫还是要用python(之前用过一个国人大牛写的java爬虫框架 webmagic),所以花了点时间看了下网上python的教程,语法什么的(当然什么都没记住~),然后看了看scrapy这个爬虫框架,大概了解了其中各个组件的作用,每个组件的作用和爬取数据的几个步骤.

三.思路分析:

知乎二胖哥的思路大致如下:

- 1 手动找到部分宅男, 抓取他们关注的女性用户 和 部分问题的女性回答者

作为 "初始美女"群体 - 2 抓取 "初始美女" 所有的粉丝, 作为 "宅男群体"

- 3 再抓取 "宅男群体" 关注的人里面取top 1000, 得到知乎最受欢迎的美女.

我和二胖哥的目的有所不同,

二胖是要找到最受欢迎的妹子,

而我的目的是: - 1 学习使用python 的 scrapy框架

- 2 爬取精彩又性感的文章和图片.

所以我通过两个方面开始爬取: - 某些女生回答的多的问题, 比如: 拥有大长腿是怎样的感觉?

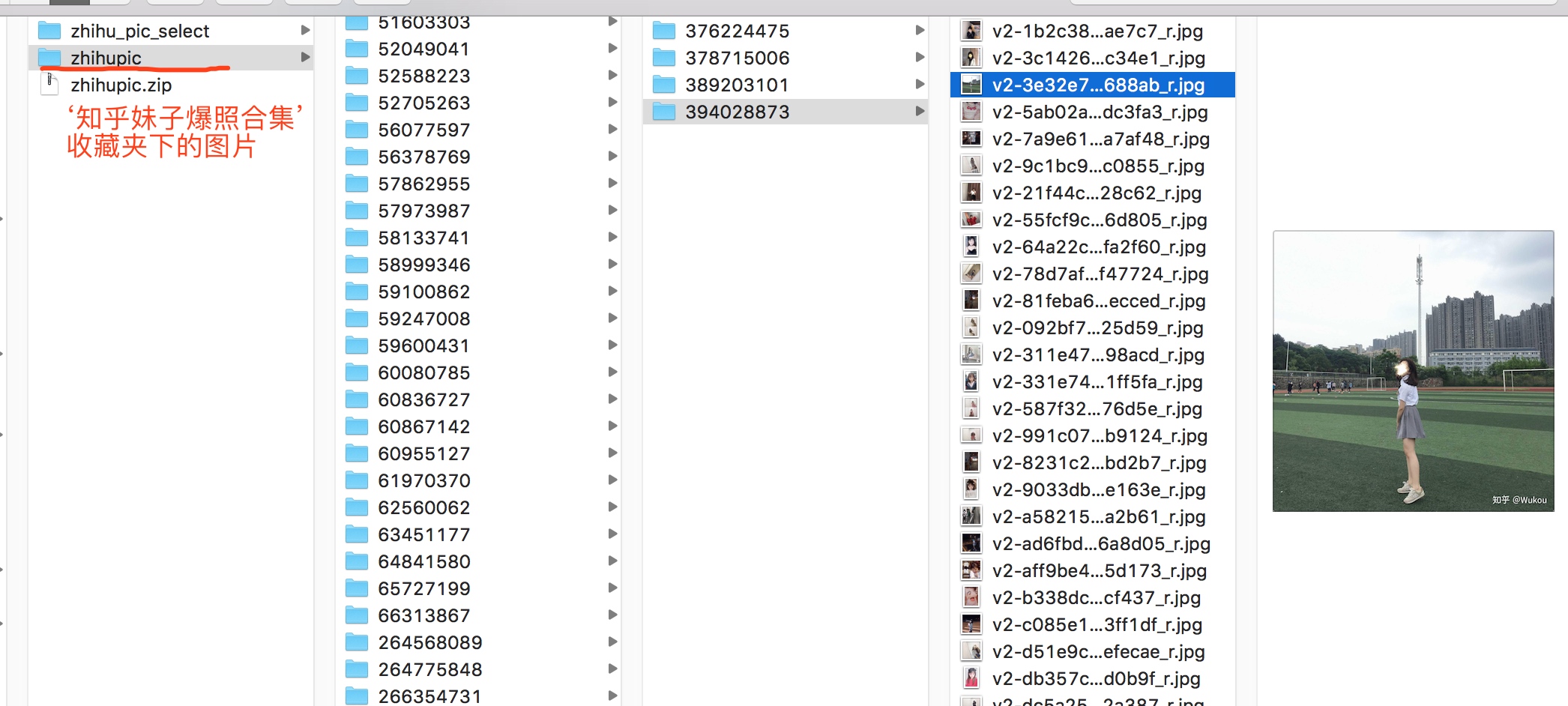

- 收藏夹. 知乎有收藏夹功能,把不同问题下的答案放到一个收藏加下.我关注了一个叫做

知乎妹子爆照合集的收藏夹

我大概爬取了12G的图片资源(因为我的服务器只有12G的剩余空间了...)

我存储图片的目录是按照 问题id/回答id的格式存放的.

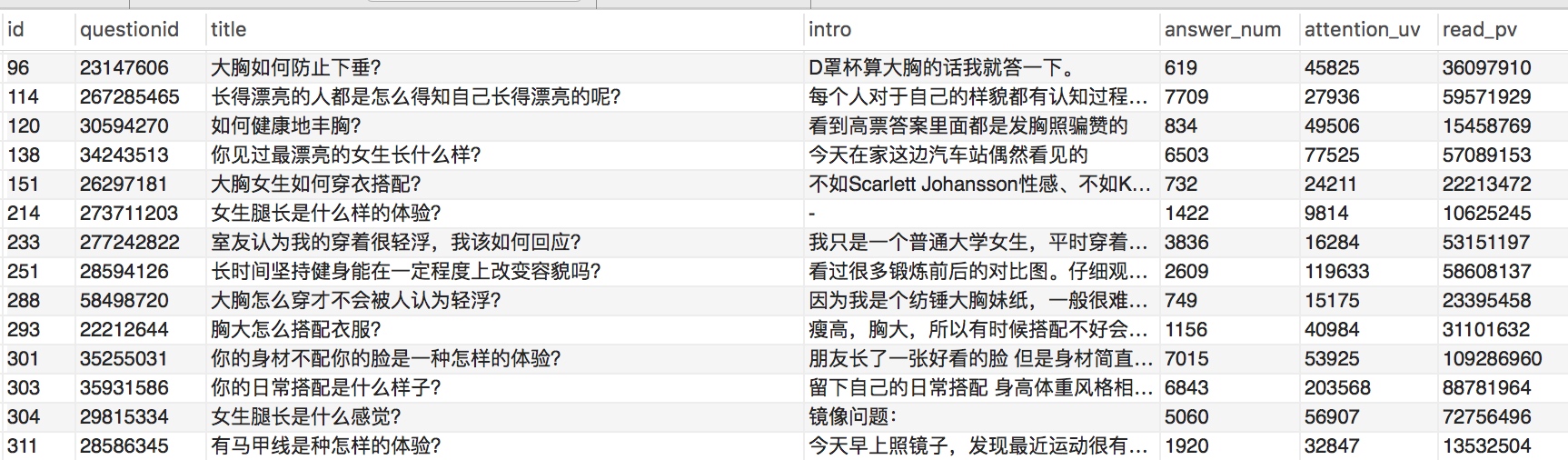

四.收藏夹里的问题很多,大致目录如下:

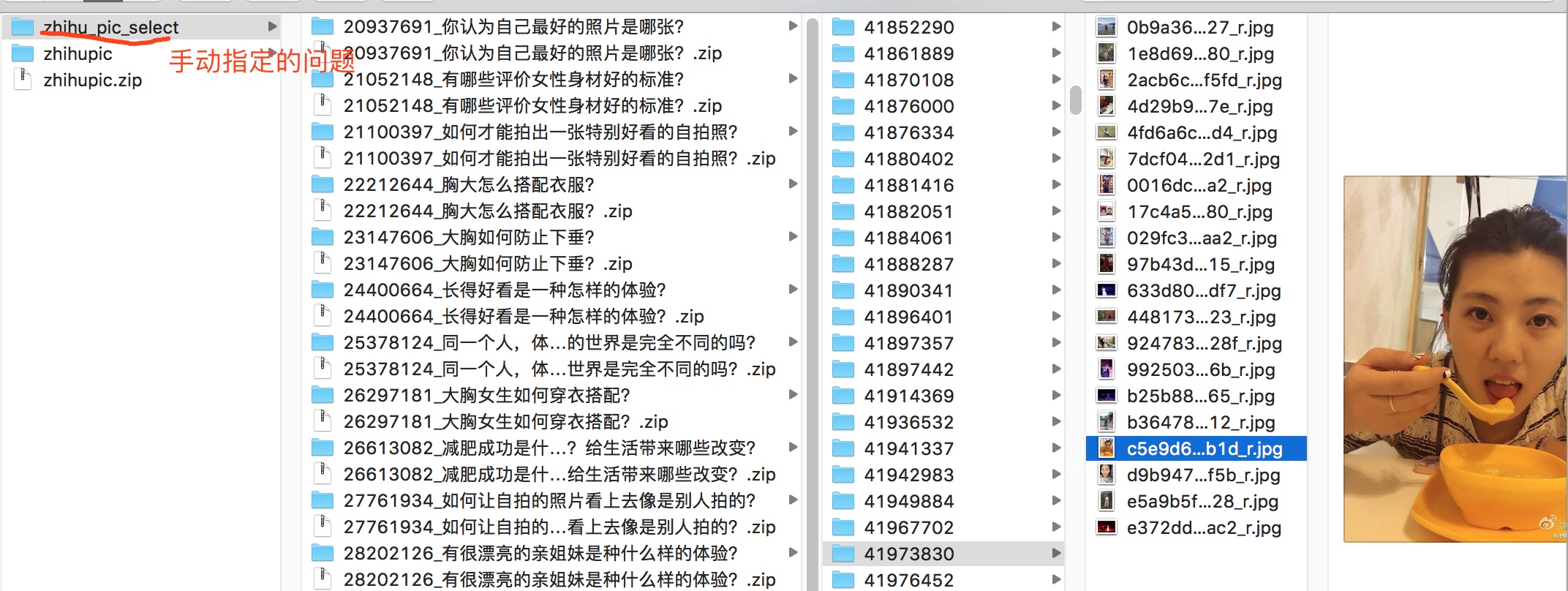

五.手动指定了几个问题如下:

指定的问题:

基本上这些问题都是妹子爆照多的话题,有不少妹子照片.

目录结构:

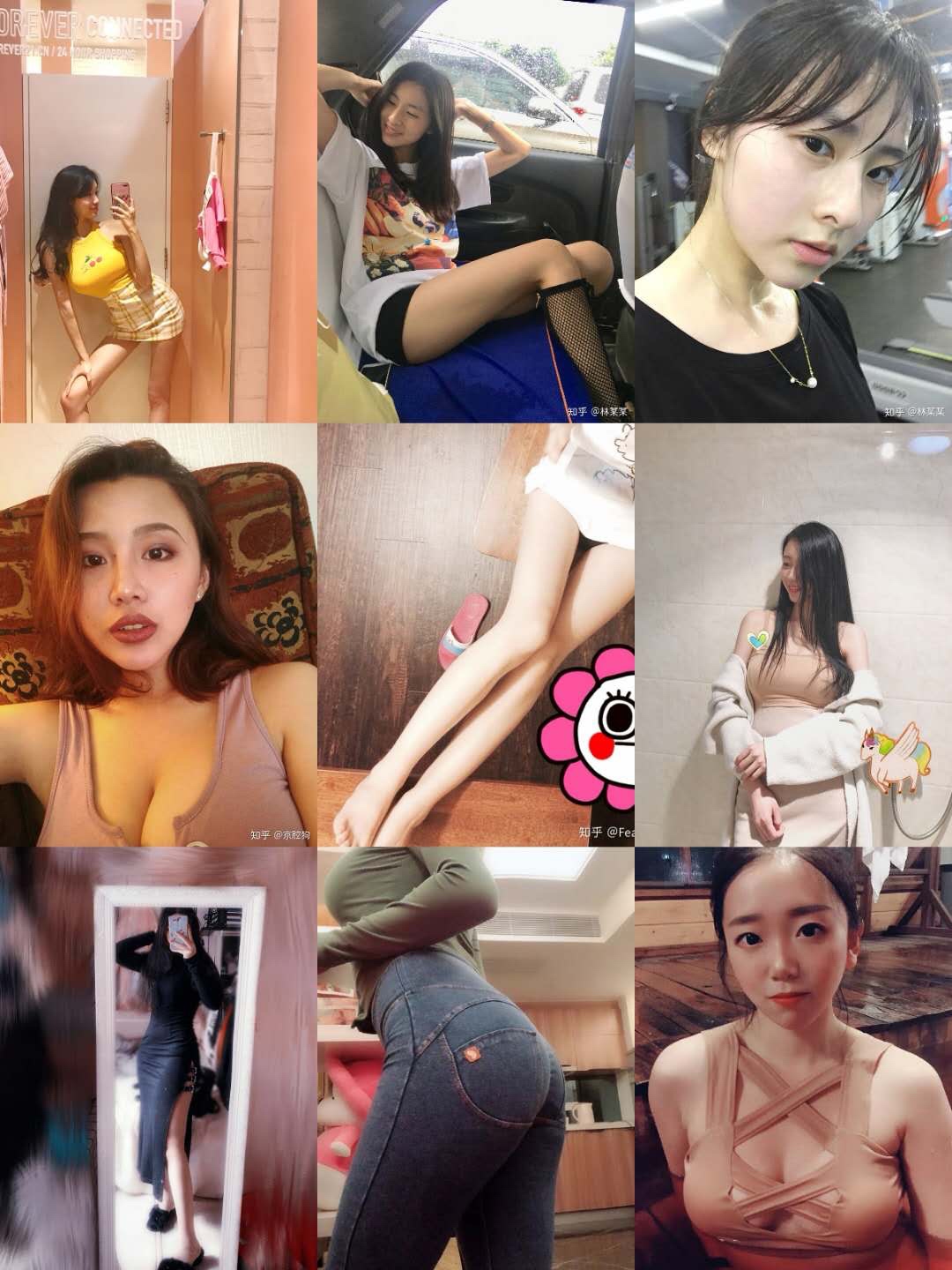

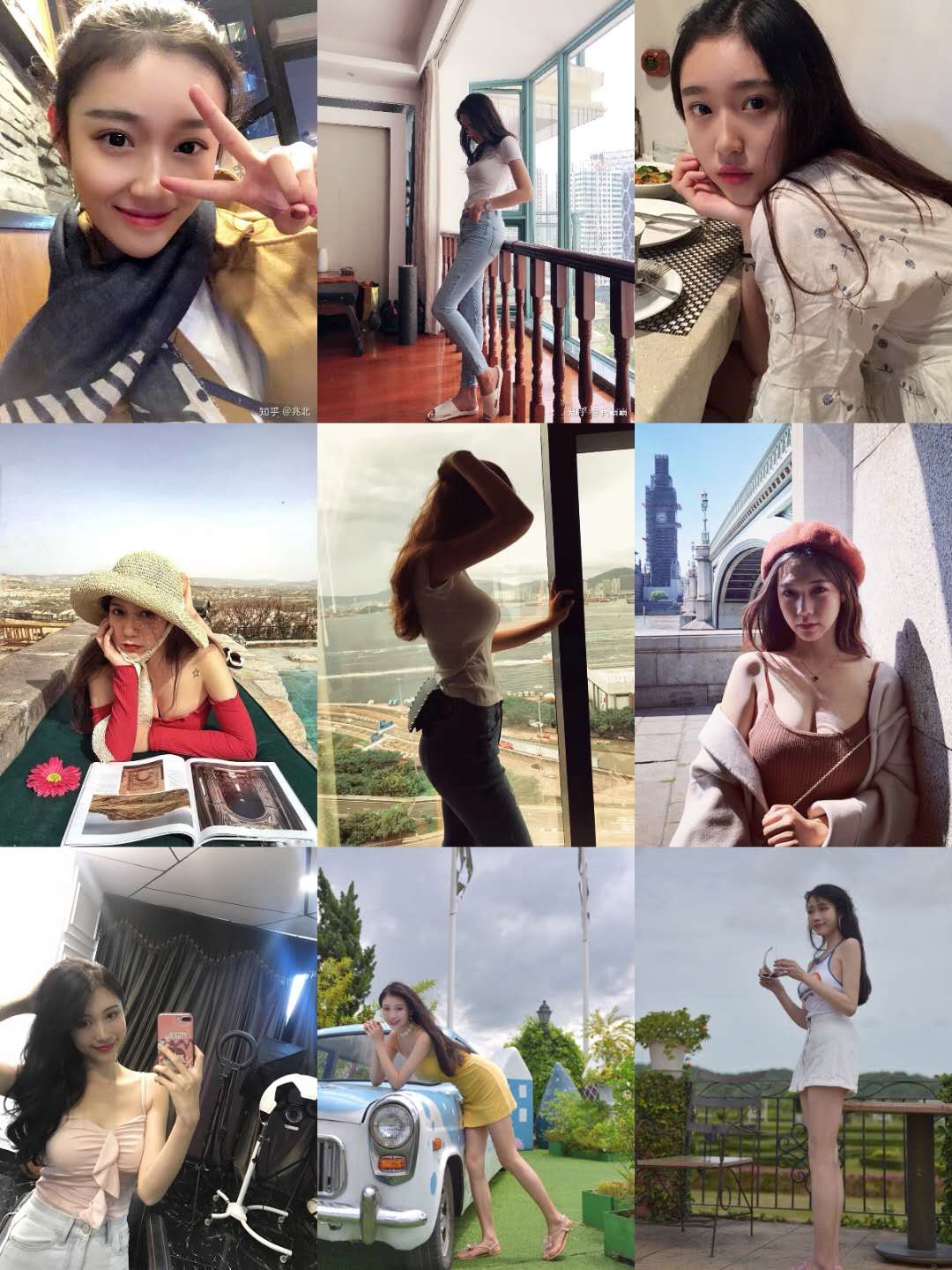

六.成果展示:

七.爬取方法介绍:

爬取网页(知乎)信息大概分为以下几个步骤:

- 确定爬取的初始页面(url地址)

- 确定要爬取哪些内容,使用xpath获取爬取内容的html文档路径获取内容.(或者能够从页面找到ajax调用后台的接口,去调接口拿到数据,一般返回的json格式,比使用xpath方便.)

- 爬取到内容的处理, 存数据库(mysql,mongo,等),落地到文件,等~

八.爬取教程分享

python scrapy爬虫框架概念介绍(个人理解总结为一张图)

python scrapy 登录知乎过程

使用python scrapy爬取知乎提问信息

python scrapy爬取知乎问题和收藏夹下所有答案的内容和图片

九.福利分享

如果有同学对python的爬虫代码和妹子图片感兴趣,

我已上传,关注微信公众号:程序员灯塔 (code12306)

回复 '知乎源码',获取python源码

回复 '知乎美女',获取12G图片资源的百度网盘地址.

程序员灯塔,关注互联网+大数据技术. 分享面试攻略+技术干货!