本文主要是介绍零成本部署秘籍:Llama 3本地使用全攻略,轻松实现高效模型运行!,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Meta公司的Llama 3大模型引领AI新篇章 各位朋友,我是袋鼠帝。

近日,真正的“OpenAI”——Meta公司,对“Close AI”进行了有力回应,推出了其开源大模型系列的最新力作——Llama 3。自Llama 1起,这个系列便以其卓越性能在开源大模型领域独占鳌头。在相同规模的参数量下,它无疑是最出色的选手之一。而Llama 3更是青出于蓝,不仅在技术层面实现了对Llama 2的重大突破,还在各种评估测试中展现出令人瞩目的表现。这标志着AI技术又迈出了坚实的一步。

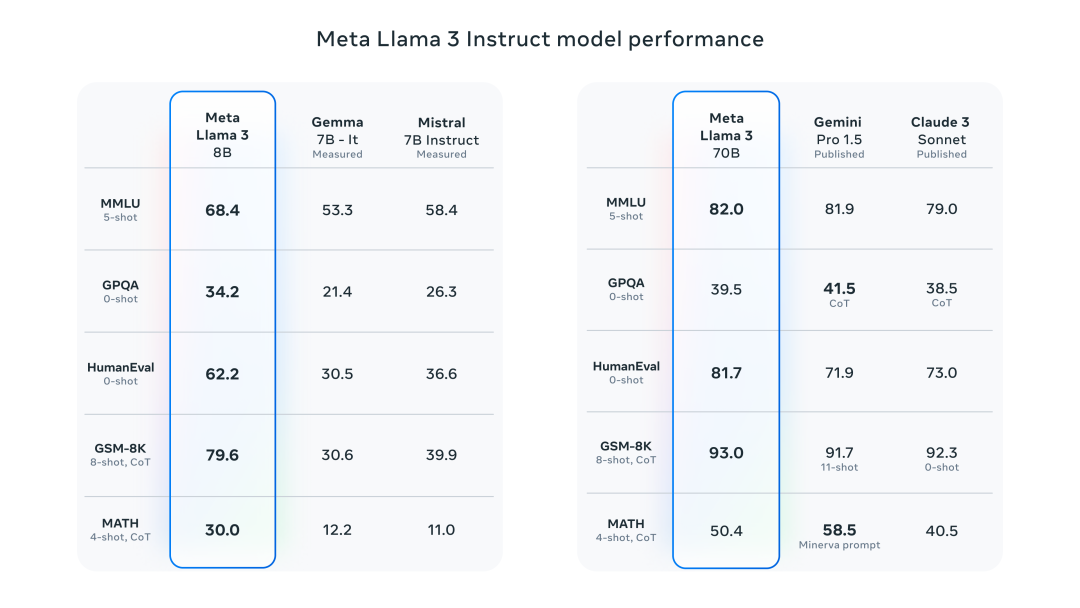

目前,推出了两个版本,分别是8B和70B。

目前,推出了两个版本,分别是8B和70B。

在与同等级别的Gemma和Mistral开源模型较量中,8B版本展现出了显著的优势。

至于70B版本,它在与Gemini Pro 1.5及Claude的Sonnet模型的比拼中,表现得旗鼓相当,难分伯仲。

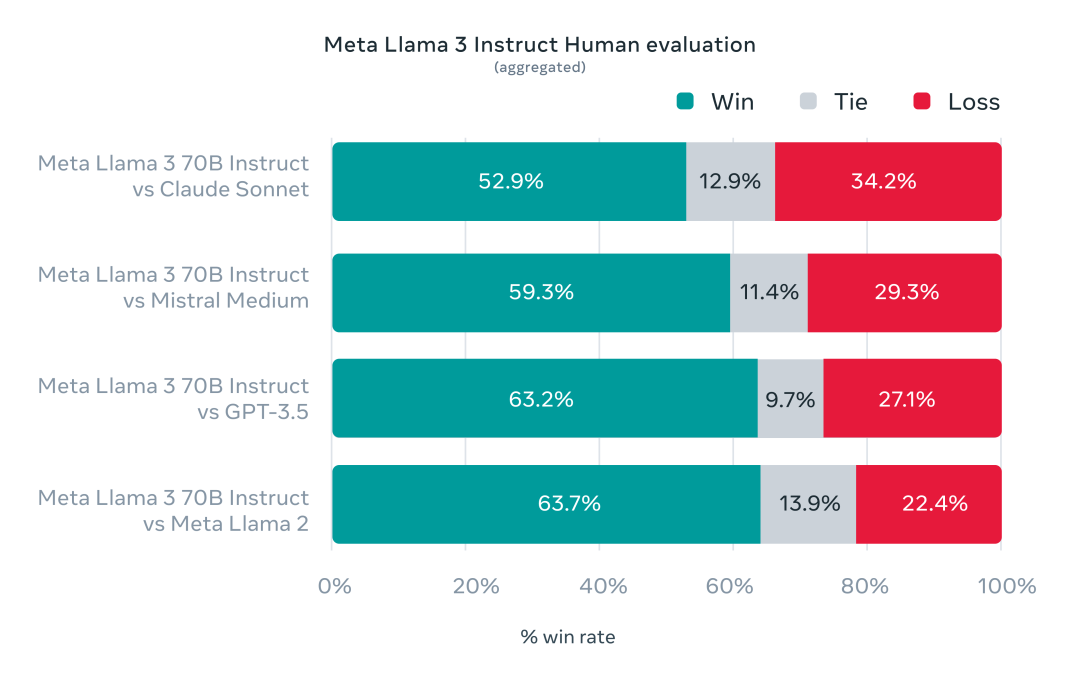

值得注意的是,70B版本在实际应用中的效能测评已清晰地超出了GPT 3.5的水平。

如今,有机会在个人计算机上本地安装并运行一个相当于GPT-3.5级别的人工智能模型,这标志着技术的一大进步。

如今,有机会在个人计算机上本地安装并运行一个相当于GPT-3.5级别的人工智能模型,这标志着技术的一大进步。

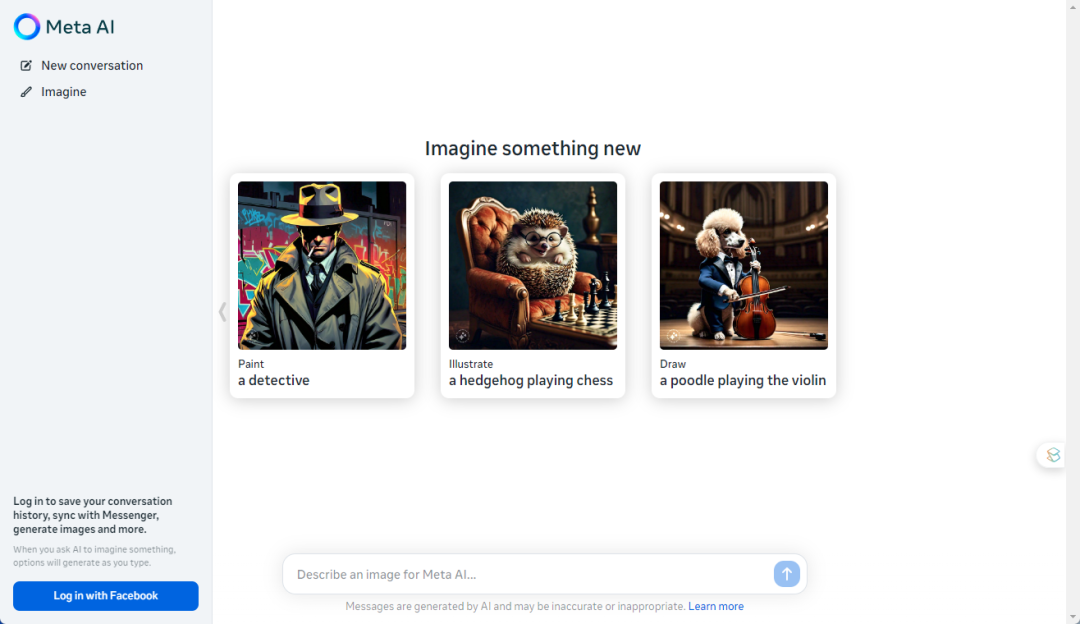

此次升级不仅显著提升了模型的运行效率,还引入了一项创新特性——文本生成图像功能。

用户现在可以访问Meta AI的官方网站,尝试这个功能的测试版本,亲身体验这一技术创新带来的惊喜。

在自己的电脑上部署GPT4All

轻松运行大型语言模型 由于Meta AI的限制,目前非美国用户很难在线体验特定服务。

不过不用担心,本文将指导你如何在个人电脑上部署并运行类似服务。

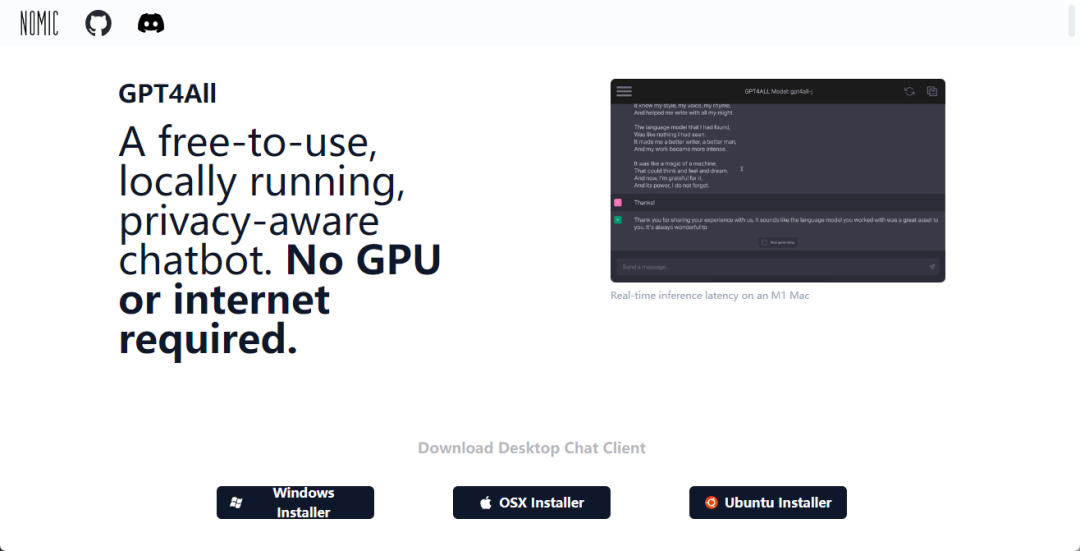

我们将使用GPT4All,一个强大的开源工具,让你无需复杂设置就能在普通设备上训练和运行大规模语言模型。

什么是GPT4All?

GPT4All是一个创新的软件生态系统,它的魅力在于,只需占用3GB至8GB的磁盘空间,你就能在笔记本或台式机上运行拥有数亿参数的大型语言模型,这在过去是难以想象的。

安装GPT4All客户端

要开始这个安装,首先访问GPT4All的官方网站。

网站提供了适用于不同操作系统的客户端安装包。

只需选择与你的电脑系统匹配的版本,下载并进行安装。

简单几步,你就能拥有自己的本地语言模型运行环境。

首先,访问官方网站:https://gpt4all.io

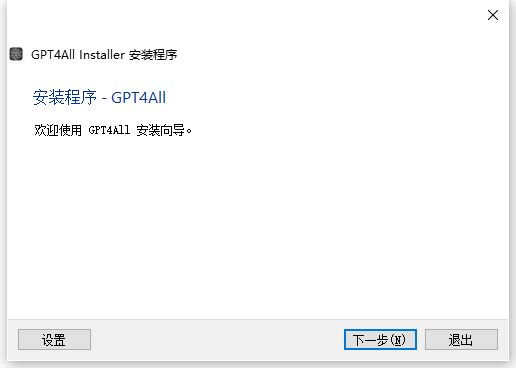

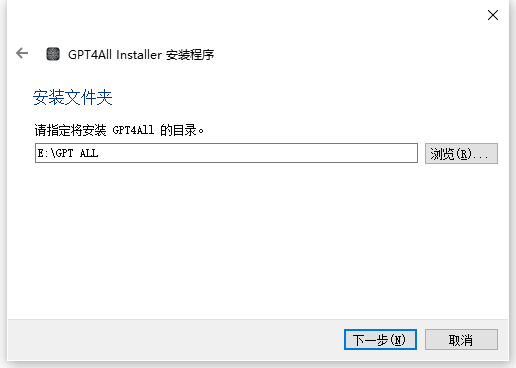

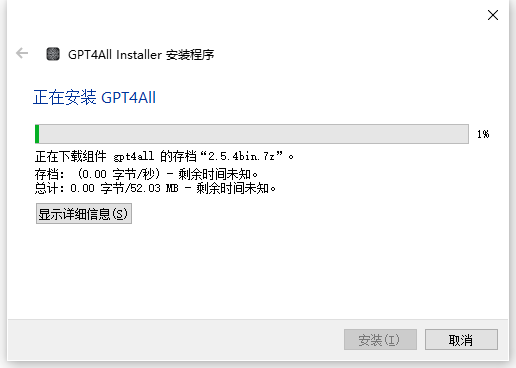

完成资源的下载。随后,我们将逐步进行安装流程,确保每个步骤都清晰无误:

该应用程序的内存占用约为200MB,算是较为轻量级的,因此用户可依据自身需求灵活选择将其安装在C盘或任何其他磁盘。不过,推荐避免将安装位置设在含有中文名称的文件夹路径下,以确保软件的正常运行。 按照指示,不断地选择“下一步”,直到整个安装过程顺利完成

按照指示,不断地选择“下一步”,直到整个安装过程顺利完成

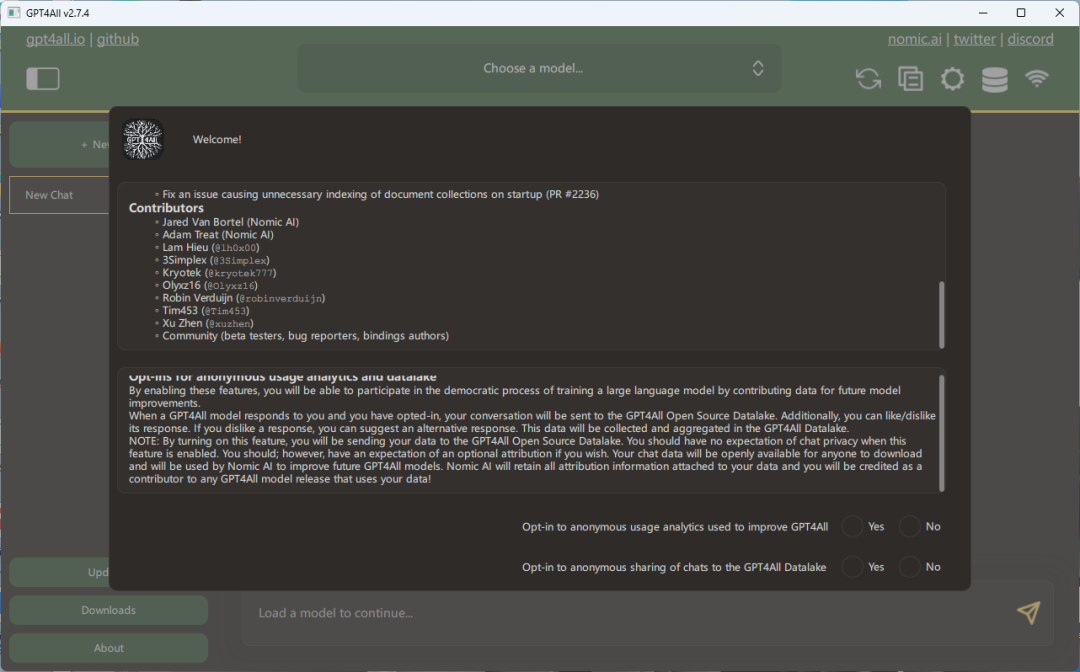

在初次安装并运行程序时,用户将会遇到一个特定的界面提示:

在初次安装并运行程序时,用户将会遇到一个特定的界面提示:

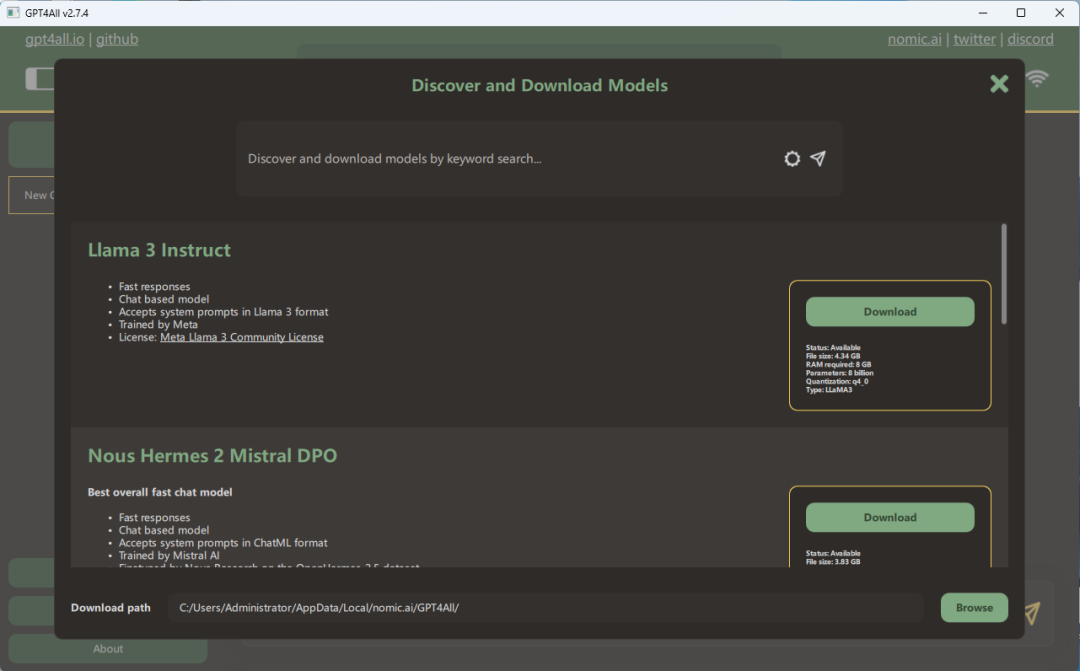

该规定旨在通过收集您的对话记录,以便对GPT4All系统进行优化升级。如您重视个人隐私,完全可以毫不犹豫地统一选择“不同意”。如此一来,网页将随即显示三个核心模型的下载选项界面。

该规定旨在通过收集您的对话记录,以便对GPT4All系统进行优化升级。如您重视个人隐私,完全可以毫不犹豫地统一选择“不同意”。如此一来,网页将随即显示三个核心模型的下载选项界面。

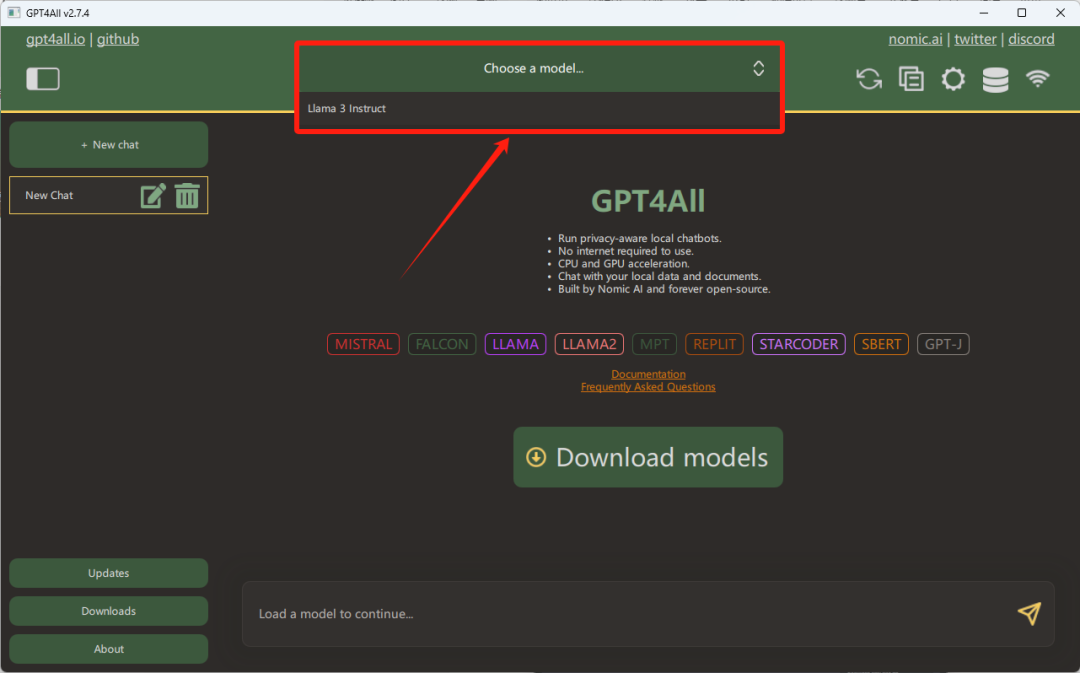

只需轻点“Download”按钮,即可启动下载过程。我们选择的是3系列的8B模型版本,对于70B的庞大模型,硬件要求相对苛刻一些。如果你的设备性能强劲,不妨尝试下载体验。不过,在此提醒,尽管8B版的参数规模不算过于庞大,但为了获得更佳的运行效果,建议至少拥有8GB显存的电脑环境。完成下载后,你会在主界面顶部看到3模型的选择选项

只需轻点“Download”按钮,即可启动下载过程。我们选择的是3系列的8B模型版本,对于70B的庞大模型,硬件要求相对苛刻一些。如果你的设备性能强劲,不妨尝试下载体验。不过,在此提醒,尽管8B版的参数规模不算过于庞大,但为了获得更佳的运行效果,建议至少拥有8GB显存的电脑环境。完成下载后,你会在主界面顶部看到3模型的选择选项

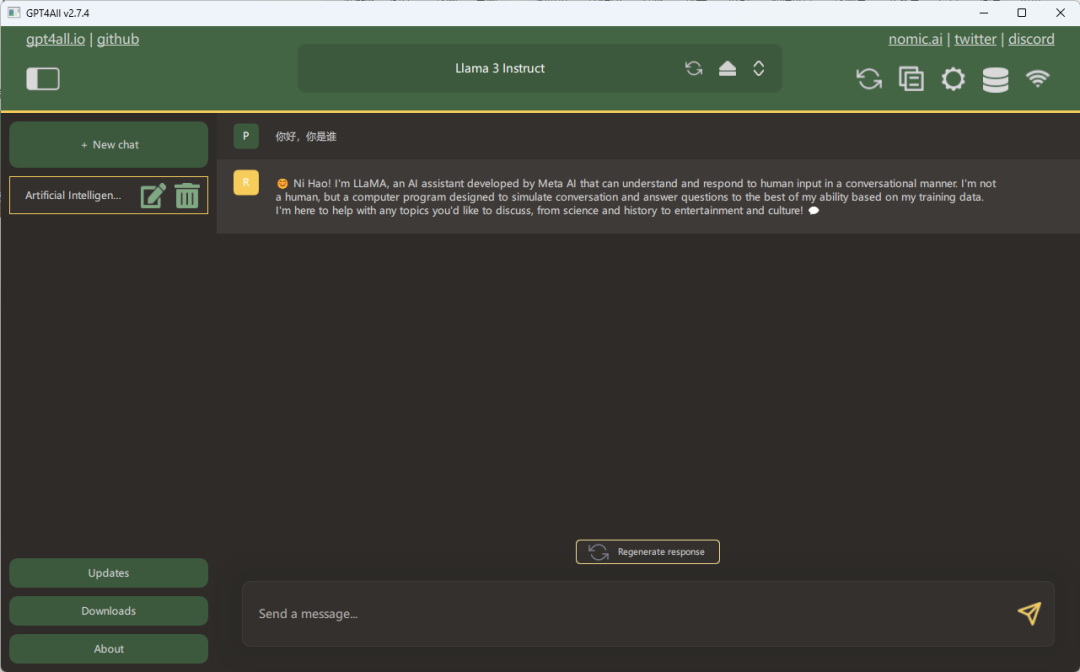

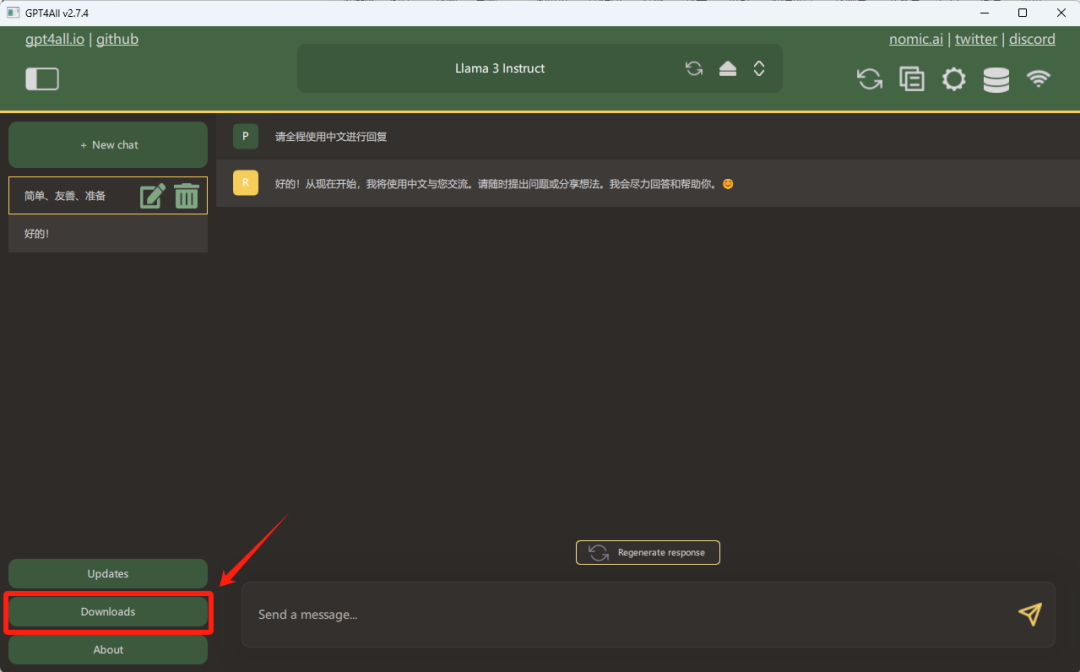

一旦GPT4All的大规模模型完成加载,我们便可以着手启动并充分利用其功能了:

一旦GPT4All的大规模模型完成加载,我们便可以着手启动并充分利用其功能了:

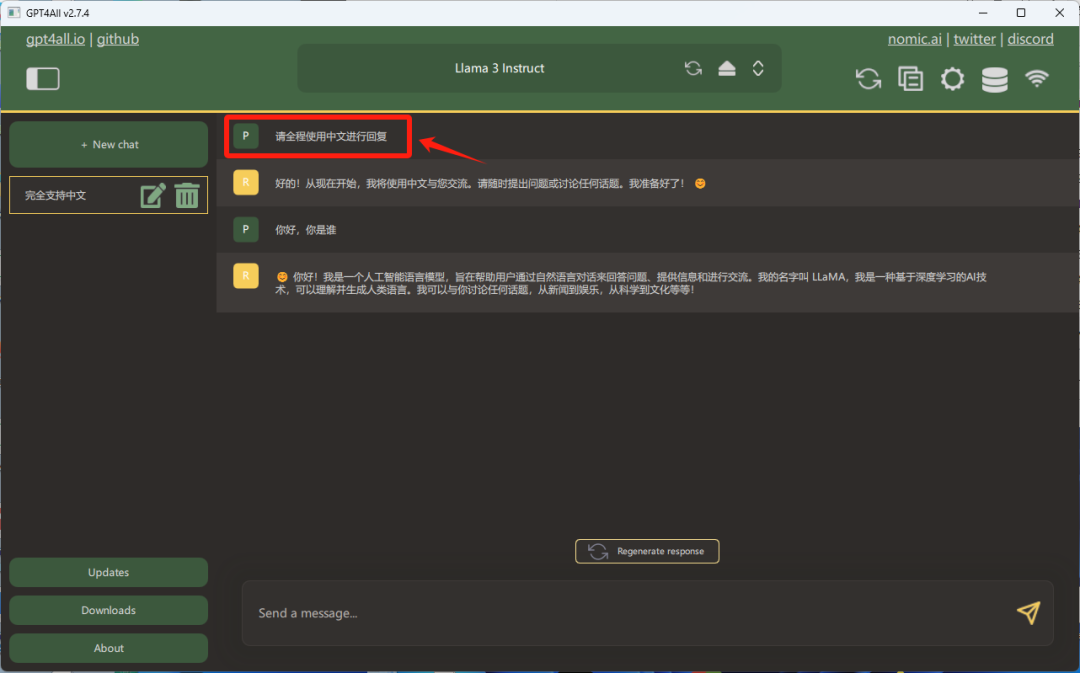

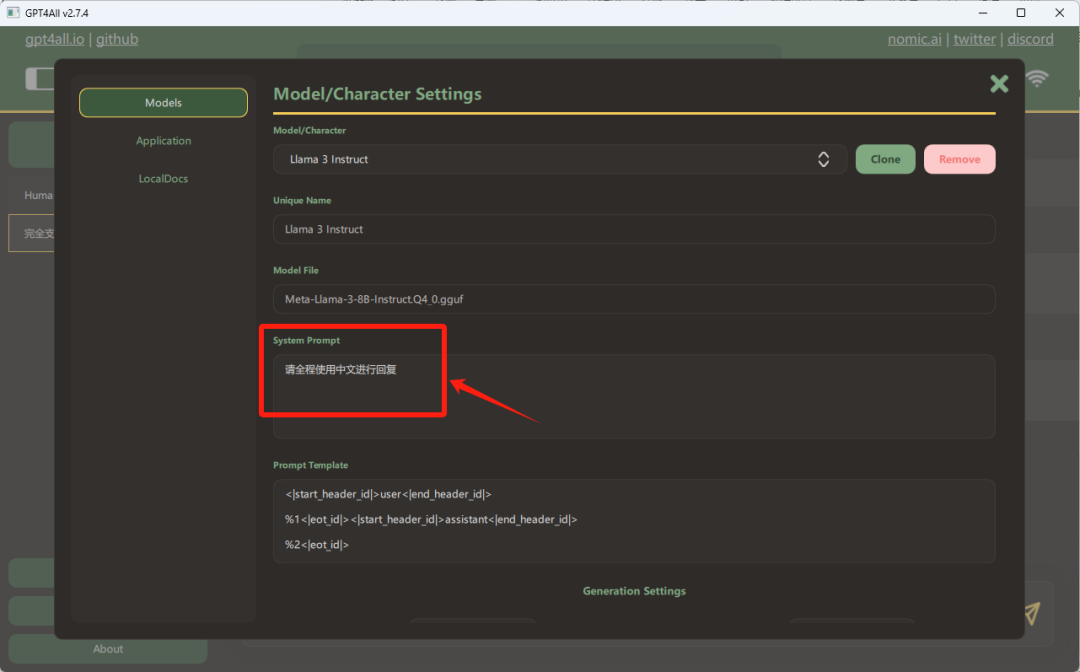

在新版布局中,您可以选择在右上角的设置选项中预先进行配置,这样一来,系统将会适时提供贴心的提示信息。这个功能旨在提升用户体验,确保您在操作过程中得到及时的指引,而不会错过任何重要步骤。请注意,个性化设置应当兼顾易用性和实用性,以满足不同用户的需求。在调整设置时,保留原有的直观性和便捷性是非常关键的,同时也要保证提示信息的清晰度,使之既符合常规操作习惯,又不失为一种独特的交互体验。

在新版布局中,您可以选择在右上角的设置选项中预先进行配置,这样一来,系统将会适时提供贴心的提示信息。这个功能旨在提升用户体验,确保您在操作过程中得到及时的指引,而不会错过任何重要步骤。请注意,个性化设置应当兼顾易用性和实用性,以满足不同用户的需求。在调整设置时,保留原有的直观性和便捷性是非常关键的,同时也要保证提示信息的清晰度,使之既符合常规操作习惯,又不失为一种独特的交互体验。

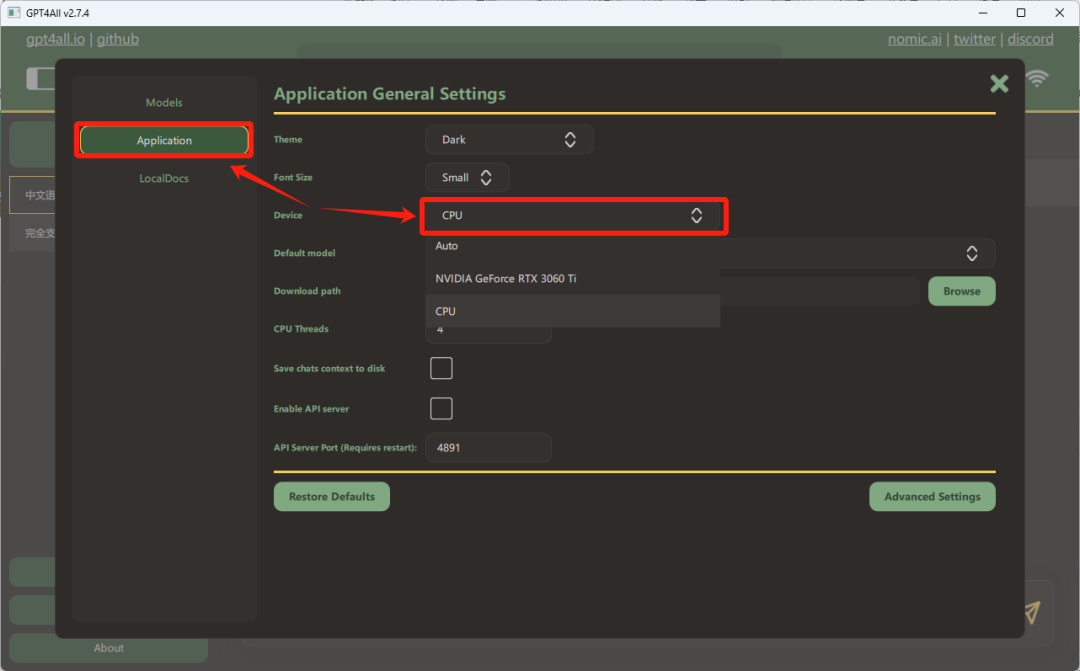

即使没有配备GPU,您也可以通过调整应用程序的设置,选择利用CPU来进行运算。请在相关选项中选择使用中央处理器(CPU),这样系统将自动适应并以CPU运行程序。虽然GPU通常能提供更快的计算速度,特别是在处理图形密集型任务时,但CPU仍然是一个可靠的替代方案,尽管其效率可能相对较低。确保在切换设置后,程序仍能稳定运行,不会影响整体性能。

即使没有配备GPU,您也可以通过调整应用程序的设置,选择利用CPU来进行运算。请在相关选项中选择使用中央处理器(CPU),这样系统将自动适应并以CPU运行程序。虽然GPU通常能提供更快的计算速度,特别是在处理图形密集型任务时,但CPU仍然是一个可靠的替代方案,尽管其效率可能相对较低。确保在切换设置后,程序仍能稳定运行,不会影响整体性能。

然而,这样的操作可能会导致速度有所下降:

然而,这样的操作可能会导致速度有所下降:

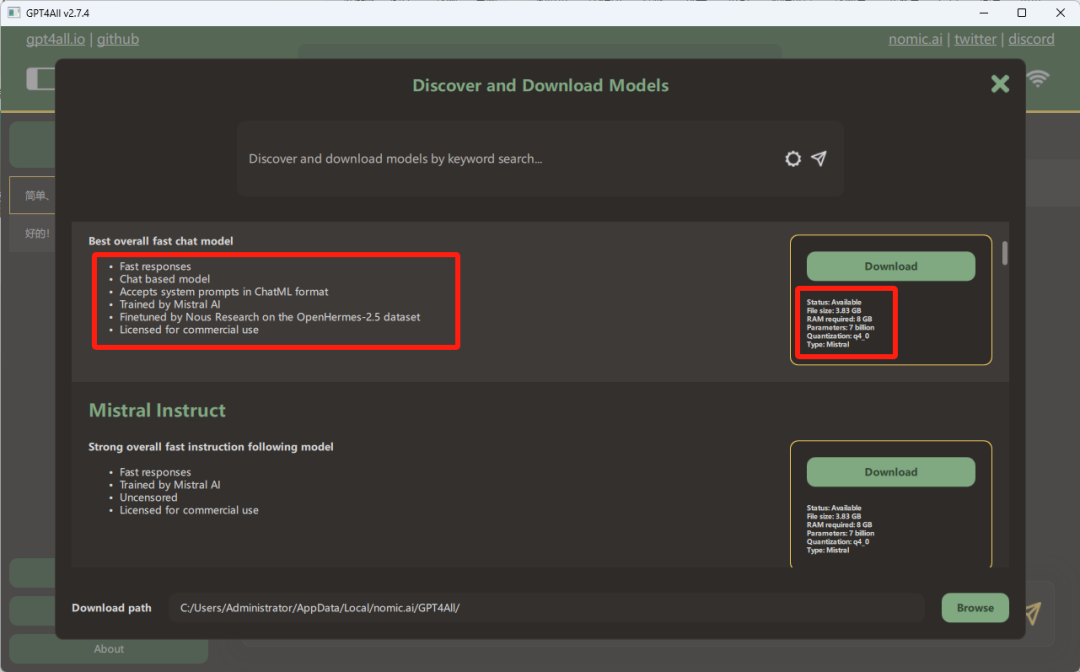

在当前的本地安装版本中,Llama 3 的一个显著局限是缺少文生图能力。然而,启用这一特性可能对计算机硬件配置提出更高的要求,这使得直接采用SD方案显得更为经济实惠。若你有兴趣尝试更多高级模型,只需在对话窗口的左侧面板点击“Download”,你就能访问模型下载页面,轻松探索各种强大的模型选择。

在当前的本地安装版本中,Llama 3 的一个显著局限是缺少文生图能力。然而,启用这一特性可能对计算机硬件配置提出更高的要求,这使得直接采用SD方案显得更为经济实惠。若你有兴趣尝试更多高级模型,只需在对话窗口的左侧面板点击“Download”,你就能访问模型下载页面,轻松探索各种强大的模型选择。

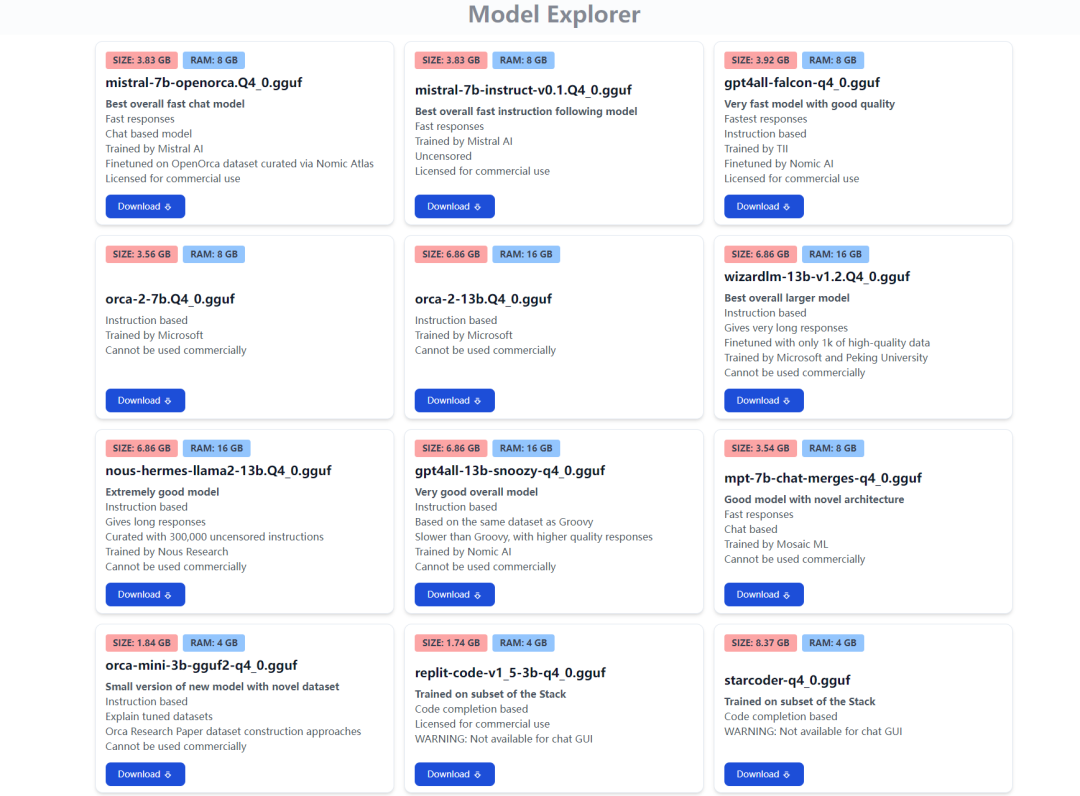

一系列大型语言模型可供下载,其文件尺寸从几十兆字节到8GB不等,相应的参数数量在4千万至惊人的130亿之间。值得注意的是,模型的参数越多,对计算机硬件配置的需求也随之增加。例如,一个拥有130亿参数的模型可能需要至少16GB的显存支持,这无疑设置了一道技术门槛,可能会让许多用户望而却步。然而,对于那些寻求妥协方案的用户,70亿参数量的模型是个不错的选择,它仅需4GB至8GB的显存,性价比显得尤为出色。每个模型都配有详细的介绍,用户可以根据自身需求选择最适合的模型进行下载。

一系列大型语言模型可供下载,其文件尺寸从几十兆字节到8GB不等,相应的参数数量在4千万至惊人的130亿之间。值得注意的是,模型的参数越多,对计算机硬件配置的需求也随之增加。例如,一个拥有130亿参数的模型可能需要至少16GB的显存支持,这无疑设置了一道技术门槛,可能会让许多用户望而却步。然而,对于那些寻求妥协方案的用户,70亿参数量的模型是个不错的选择,它仅需4GB至8GB的显存,性价比显得尤为出色。每个模型都配有详细的介绍,用户可以根据自身需求选择最适合的模型进行下载。

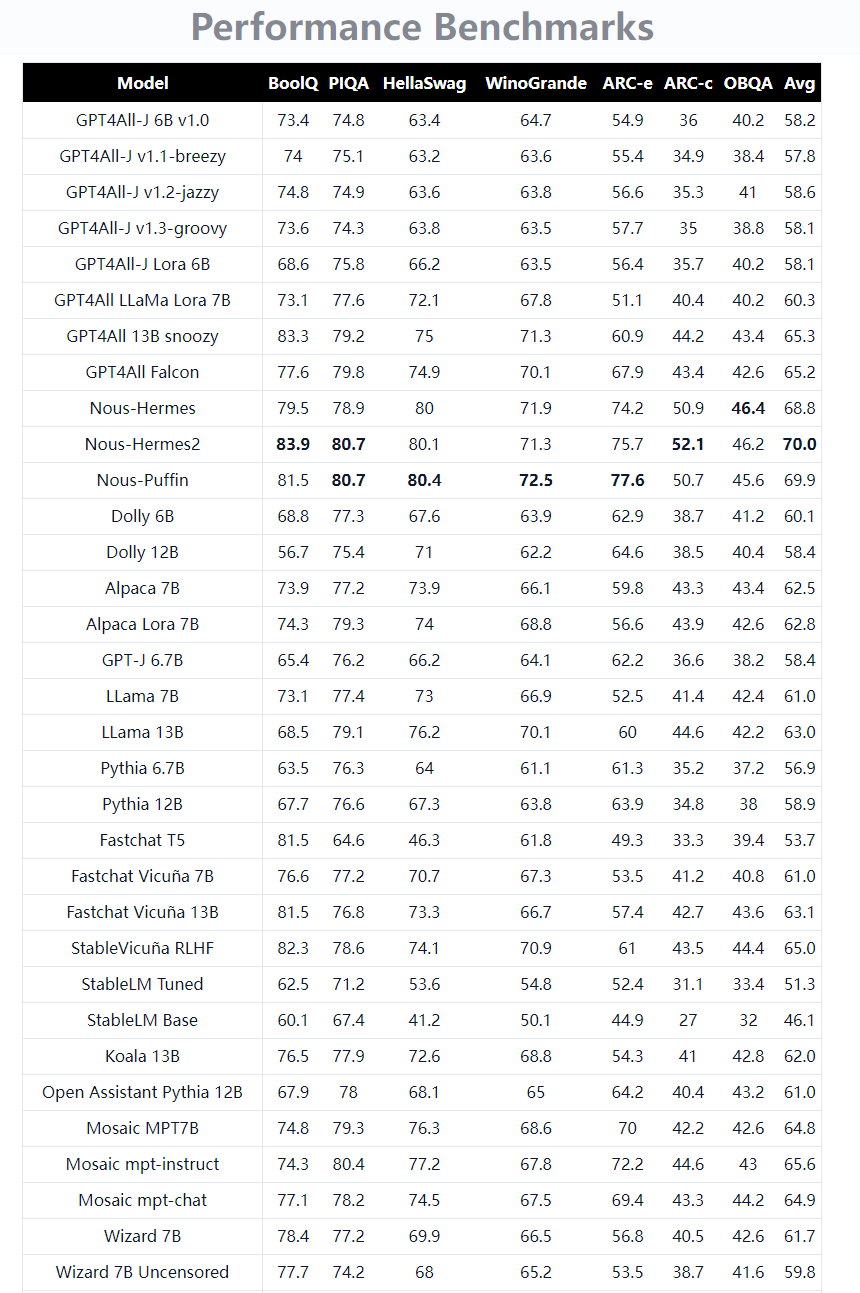

官方网站提供了更为详尽的模型测评,对每个模型都有深入的介绍和分析,可以满足你对更多细节的探索需求。

官方网站提供了更为详尽的模型测评,对每个模型都有深入的介绍和分析,可以满足你对更多细节的探索需求。

高性能的大模型通常与更高的分数直接相关,分数越出色,模型的效能表现越显著。为了便于用户获取这些优秀模型,官方提供了一个如同客户端般便捷的下载选项,只需轻轻一点,即可轻松完成下载过程。

高性能的大模型通常与更高的分数直接相关,分数越出色,模型的效能表现越显著。为了便于用户获取这些优秀模型,官方提供了一个如同客户端般便捷的下载选项,只需轻轻一点,即可轻松完成下载过程。

考虑到一些模型的体积可观,推荐将这些大型模型的存储位置设置在C盘以外的硬盘分区。这么做能有效防止在运行模型时过度占用C盘空间,避免出现系统运行缓慢或崩溃的情况。

考虑到一些模型的体积可观,推荐将这些大型模型的存储位置设置在C盘以外的硬盘分区。这么做能有效防止在运行模型时过度占用C盘空间,避免出现系统运行缓慢或崩溃的情况。

AI时代的职场新潮流

听说AI要来抢工作了?别担心,新岗位可比旧岗位有趣多了!想象一下,你从搬砖工升级成了机器人操作员,从算盘小能手变成了大数据分析师,这不是美滋滋吗?所以,社会生产效率提升了,我们也能更轻松地工作。不过,想成为AI界的佼佼者?那就得赶紧学起来,不然就会被同行们甩得连AI的尾巴都摸不着了!

零基础如何学习大模型 AI

领取方式在文末

为什么要学习大模型?

学习大模型课程的重要性在于它能够极大地促进个人在人工智能领域的专业发展。大模型技术,如自然语言处理和图像识别,正在推动着人工智能的新发展阶段。通过学习大模型课程,可以掌握设计和实现基于大模型的应用系统所需的基本原理和技术,从而提升自己在数据处理、分析和决策制定方面的能力。此外,大模型技术在多个行业中的应用日益增加,掌握这一技术将有助于提高就业竞争力,并为未来的创新创业提供坚实的基础。

大模型实际应用案例分享

①智能客服:某科技公司员工在学习了大模型课程后,成功开发了一套基于自然语言处理的大模型智能客服系统。该系统不仅提高了客户服务效率,还显著降低了人工成本。

②医疗影像分析:一位医学研究人员通过学习大模型课程,掌握了深度学习技术在医疗影像分析中的应用。他开发的算法能够准确识别肿瘤等病变,为医生提供了有力的诊断辅助。

③金融风险管理:一位金融分析师利用大模型课程中学到的知识,开发了一套信用评分模型。该模型帮助银行更准确地评估贷款申请者的信用风险,降低了不良贷款率。

④智能推荐系统:一位电商平台的工程师在学习大模型课程后,优化了平台的商品推荐算法。新算法提高了用户满意度和购买转化率,为公司带来了显著的增长。

…

这些案例表明,学习大模型课程不仅能够提升个人技能,还能为企业带来实际效益,推动行业创新发展。

学习资料领取

如果你对大模型感兴趣,可以看看我整合并且整理成了一份AI大模型资料包,需要的小伙伴文末免费领取哦,无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

部分资料展示

一、 AI大模型学习路线图

整个学习分为7个阶段

二、AI大模型实战案例

涵盖AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,皆可用。

三、视频和书籍PDF合集

从入门到进阶这里都有,跟着老师学习事半功倍。

如果二维码失效,可以点击下方链接,一样的哦

【CSDN大礼包】最新AI大模型资源包,这里全都有!无偿分享!!!

😝朋友们如果有需要的话,可以V扫描下方二维码联系领取~

这篇关于零成本部署秘籍:Llama 3本地使用全攻略,轻松实现高效模型运行!的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!