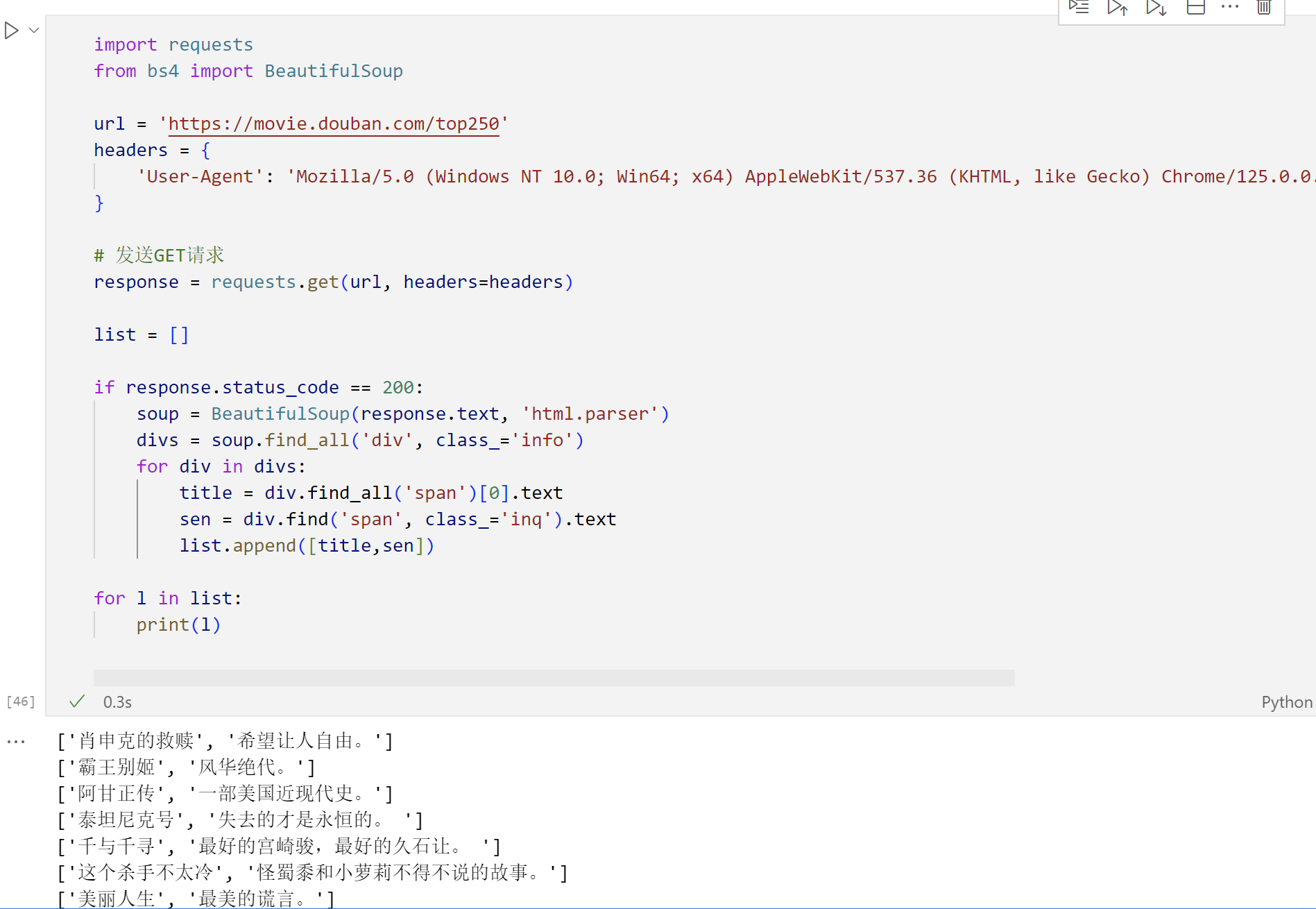

本文主要是介绍BeautifulSoup,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

BeautifulSoup是一个用于解析HTML和XML文档的python库。

查找一般使用find函数,find函数可以接受多种参数,包括标签名、属性名和值、子标签等。它返回的是第一个匹配的元素,如果没有找到匹配的元素,它将返回None。

例子如下

from bs4 import BeautifulSoup

# 查找第一个<div>标签

first_div = soup.find('div')

# 查找第一个class属性包含'example'的<div>标签

first_div_with_class = soup.find('div', {'class': 'example'})

# 查找第一个id属性为'example'的<div>标签

first_div_with_id = soup.find('div', {'id': 'example'})

这篇关于BeautifulSoup的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!