本文主要是介绍使用Flink接受kafka中的数据并对数据进行ETL,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

做这个开发是因为:在实际开发操作中,你的kafka主题中会有大量的数据但是需求并不需要所有数据,所有我们要对数据进行清洗,把需要的数据保存在flink流中,为下流的开发做好数据保障!

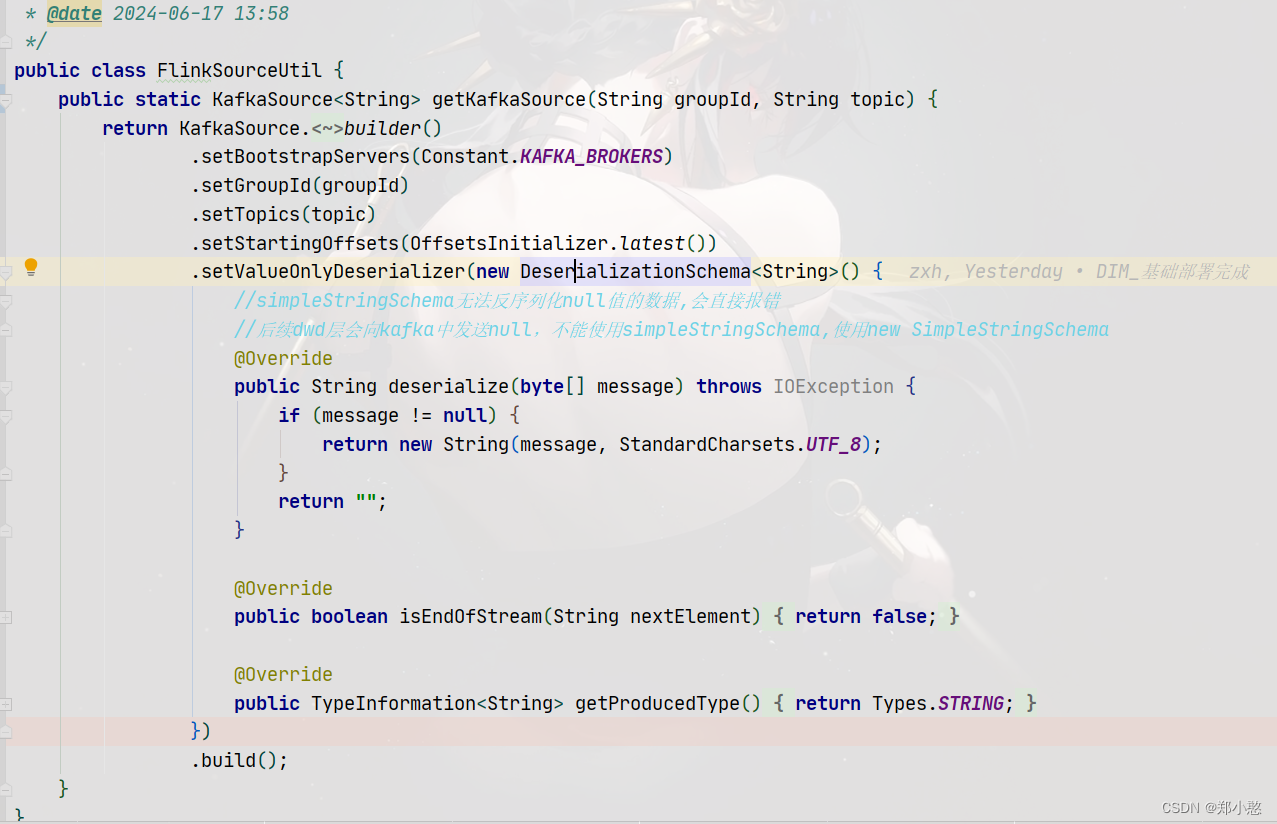

首先创建工具类

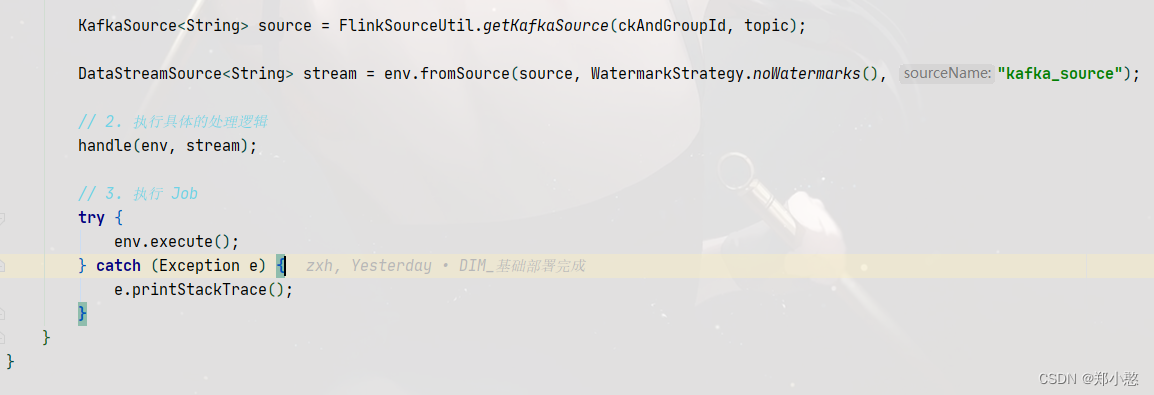

再写一个抽象类,测试阶段可以把状态后端和检查点给注释掉,可以提高效率

再写一个抽象类,测试阶段可以把状态后端和检查点给注释掉,可以提高效率

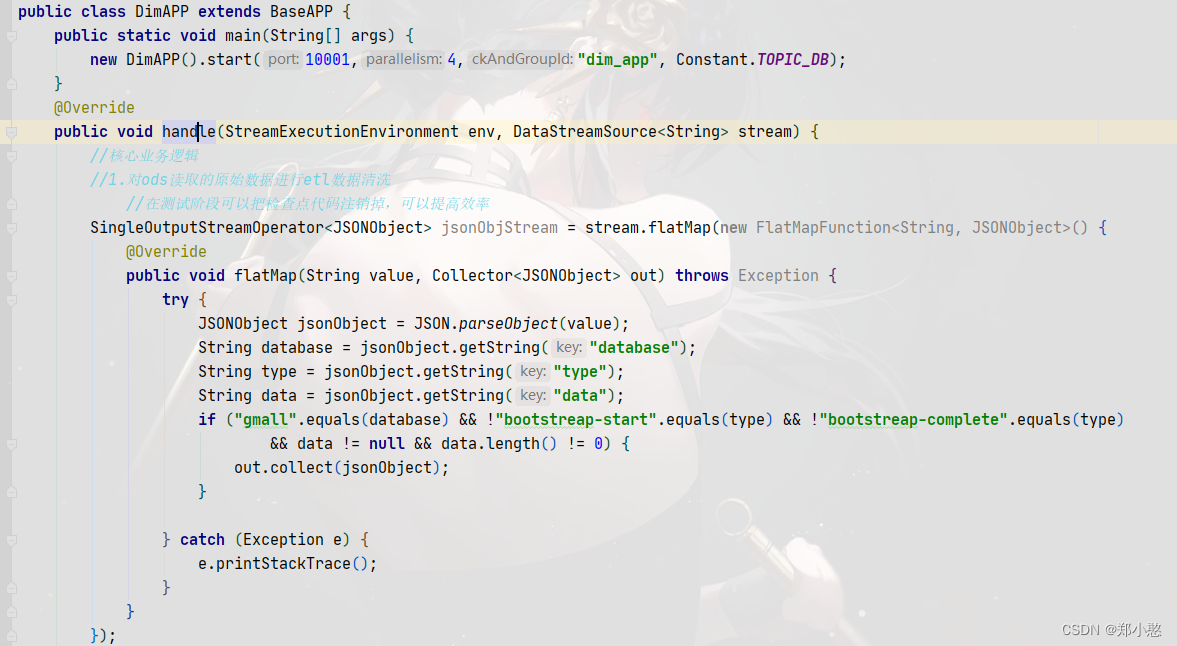

再写一个主程序继承抽象类中的方法,并在程序中对数据进行etl

这篇关于使用Flink接受kafka中的数据并对数据进行ETL的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!