本文主要是介绍一个简单、快速用于训练和微调中等规模GPT模型的开源项目,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

大家好,今天给大家分享的是一个简单、快速用于训练和微调中等规模GPT模型的开源项目,该项目旨在拓宽深度学习领域的应用,特别是为深度学习的入门者提供便利。

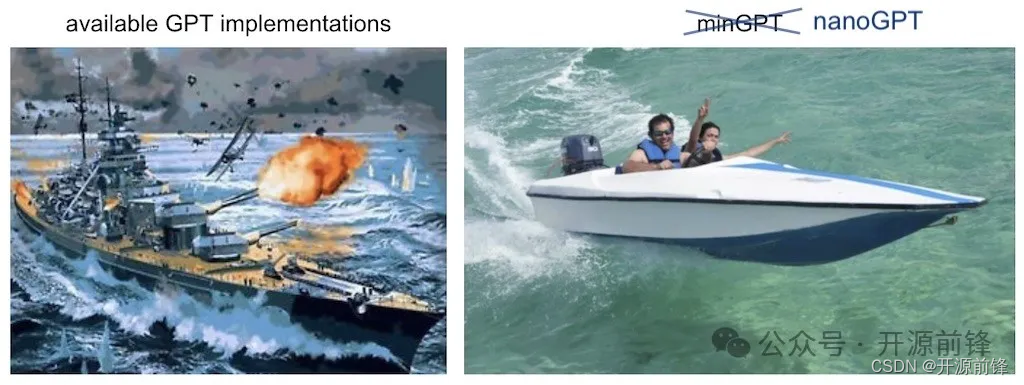

Nano GPT是一个基于PyTorch的开源项目,由前特斯拉AI负责人Andrej Karpathy开发。它是对minGPT的简化和重写,旨在提供一个更简单、更快速的工具,用于训练和微调中等规模的GPT模型。该项目在GitHub上有超过26.4k Star,是深度学习领域中的一个热门项目。

应用场景

Nano GPT 是一个了解 GPT 工作原理的绝佳项目。它是 GPT-2 的最小复制品,在 OpenWebText 上进行训练。对于任何想要学习如何训练 GPT 模型的人来说,这都是一个很好的起点。

-

训练自定义数据集的GPT模型:你可以快速开始训练一个基于特定数据集的GPT模型,例如使用莎士比亚作品进行训练。根据你的硬件配置,可以在几分钟内得到一个初步训练好的模型。这适用于拥有GPU的用户。对于只有CPU的用户,Nano GPT也提供了相应的配置选项,允许在资源较少的环境中进行训练。

-

复现GPT-2结果:对于更有经验的深度学习研究人员,Nano GPT提供了复现GPT-2模型的能力。你可以重现使用OpenWebText数据集训练的GPT-2 (124M)模型。

-

微调预训练模型:NanoGPT也支持在特定数据集上微调预训练好的GPT模型。例如,你可以在小莎士比亚数据集上微调GPT-2模型。

-

文本生成和推理:训练或微调完成的模型可以用于生成文本或进行其他推理任务。Nano GPT提供了简单的脚本来执行这些任务。

NanoGPT的优劣势

| 优势 | 劣势 |

|---|---|

| Nano GPT拥有轻量级、易使用、效果优良的特点,可以快速训练得到一个表现出色的预训练语言模型。 | Nano GPT的参数数量较少,因此其在某些大规模NLP任务上的表现可能不如一些巨型语言模型。、 |

| Nano GPT的学习和使用都非常简单,即便是初学者也能够轻松上手,同时也具有良好的可扩展性和可定制化性。 | Nano GPT的轻量级优势可能会在某些复杂NLP任务上表现不佳。 |

| Nano GPT所需的计算资源和存储空间较少,训练和部署都非常方便。 | Nano GPT的轻量级可能意味着其表现不如巨型语言模型在某些复杂NLP任务上的表现。 |

不过总的来说,Nano GPT在NLP领域整体表现良好,它为语言模型训练提供了一种轻量级、高效、易用的方案,为各种NLP任务提供了有力的支持。

因此,如果你需要进行语言模型训练,Nano GPT是一个很好的选择,它可以帮助你快速获得一个优秀的预训练模型,并能够适应各种NLP任务。

使用

Nano GPT是一个基于OpenWebText重现GPT-2 (124M)的库,被誉为纳米武器级别的生成性模型,它可以用于文本生成和聊天机器人等应用场景。下面将详细介绍Nano GPT的使用方法。

步骤一:准备工作

下载和安装必要的软件和库:在使用nano GPT之前,需要安装Python、PyTorch和Transformers等软件和库。

pip install torch numpy transformers datasets tiktoken wandb tqdm

选择并准备合适的语料库:语料库的选择和准备直接影响模型的训练效果。可以选择已有的语料库,如维基百科、新闻网站等,也可以自行收集。

如果你不是深度学习专业人士,只是想感受一下它的魔力并尝试一下,那么最快的入门方式就是用莎士比亚的作品训练一个字符级的 GPT。首先,我们将其下载为单个 (1MB) 文件,并将其从原始文本转换为一大整数流:

python data/shakespeare_char/prepare.py

步骤二:模型训练

使用Nano GPT进行模型训练的详细流程和方法:通过命令行参数配置指定数据集、模型、训练参数等进行模型训练。

如何根据训练效果对模型进行调整和优化:可以通过调整学习率、增加Epoch次数等方法对模型进行优化。

如果你有一台GPU机器,你可以使用默认配置进行训练:

python train.py config/train_shakespeare_char.py

步骤三:生成文本

在一台 A100 GPU 上,这个训练运行大约需要 3 分钟,最佳验证损失为 1.4697。根据配置,模型检查点被写入目录–out_dir。out-shakespeare-char因此,一旦训练完成,我们就可以通过将采样脚本指向此目录来从最佳模型中采样:

python sample.py --out_dir=out-shakespeare-char

这将生成一些样本,例如:

ANGELO:

And cowards it be strawn to my bed,

And thrust the gates of my threats,

Because he that ale away, and hang'd

An one with him.DUKE VINCENTIO:

I thank your eyes against it.DUKE VINCENTIO:

Then will answer him to save the malm:

And what have you tyrannous shall do this?DUKE VINCENTIO:

If you have done evils of all disposition

To end his power, the day of thrust for a common men

That I leave, to fight with over-liking

Hasting in a roseman.

项目地址

https://github.com/karpathy/nanoGPT

文章来源

一个简单、快速用于训练和微调中等规模GPT模型的开源项目

这篇关于一个简单、快速用于训练和微调中等规模GPT模型的开源项目的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!