本文主要是介绍Apple Intelligence:苹果大模型部署方案,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

摘要:

- 设备端LLM:iOS18版本将包含一个本地小型、低延迟的LLM模型(30亿参数),它能够理解用户命令、当前屏幕并在应用程序上执行操作。该模型不仅能处理总结等简单任务,还可以为Siri的“AI智能体”功能提供支持,例如处理需要打开和使用多个应用程序的用户命令——比如“嘿Siri,叫一辆Uber到最近的Costco”,该模型运行在Apple Silicon芯片(如M系列芯片)上。

- 云端LLM:设备端的LLM可能会将某些复杂任务给到Apple数据中心托管的更强大模型(称为“私有云计算”)。这些数据中心也将完全运行在Apple的M系列芯片上,传输的数据将完全加密和保护。服务器由Apple自主制造,Apple已经垂直整合了在设备端和数据中心内运行AI所需的一切。

- 第三方LLM:用户还可以通过Siri或某些iOS应用直接使用OpenAI的ChatGPT。请注意,这并不是用ChatGPT替代Siri——这是许多人对OpenAI合作的误解。实际上,ChatGPT在特定情况下作为Apple模型的替代方案提供。例如,当用户即将修订电子邮件时,可以选择ChatGPT的响应。

在WWDC24全球开发者大会上,苹果推出了Apple Intelligence,这是一个深度集成到iOS18、iPadOS18和macOS Sequoia中的个人智能系统。

Apple Intelligence由多个高度能力的生成模型组成,这些模型专门针对用户的日常任务,并且能够根据当前活动即时适应。Apple Intelligence中内置的基础模型针对用户体验进行了微调,例如编写和精炼文本、对通知进行优先级排序和总结、为与家人和朋友的对话创建有趣的图像,以及采取应用内操作来简化应用之间的交互。

以下是这两个模型的简介,这些模型被构建和适应以高效、准确、负责任地执行专门任务。

- 一个约30亿参数(3B)的设备上LLM小模型,它可以在用户的设备上运行,不需要依赖云端计算。

- 一个更大的基于服务器的语言模型(具体参数规模未知),它通过Private Cloud Compute提供,运行在苹果芯片服务器上。

1、负责任的AI原则

Apple Intelligence的设计每一步都体现了苹果的核心价值观,即以保护用户隐私为宗旨。此外,苹果还创建了一套负责任的AI原则来指导他们开发产品:

- 为用户提供智能工具:苹果致力于识别AI可以负责任地使用来解决特定用户需求的领域,并尊重用户选择如何使用这些工具来实现他们的目标。

- 代表用户:苹果旨在构建深度个性化的产品,真实地代表全球用户。公司持续努力避免在其AI工具和模型中延续刻板印象和系统性偏见。

- 谨慎设计:在设计、模型训练、功能开发和质量评估的每个阶段,苹果都会采取预防措施,以识别AI工具可能被滥用或导致潜在伤害的方式。公司将借助用户反馈,持续主动改进AI工具。

- 保护隐私:苹果通过强大的设备端处理能力和像Private Cloud Compute这样的基础设施创新来保护用户的隐私。在训练基础模型时,苹果不会使用用户的私人个人数据或用户交互数据。

2、预训练(Pre-Training)

苹果使用了一个名为AXLearn的开源框架进行模型训练,该框架在2023年发布。AXLearn基于JAX和XLA,允许苹果在各种训练硬件和云平台上高效、可扩展地训练模型,包括TPU以及云端和本地的GPU。苹果采用了数据并行、张量并行、序列并行以及完全分片数据并行(Fully Sharded Data Parallel,FSDP)等技术来扩展训练,这些技术可以在数据、模型和序列长度等多个维度上进行扩展。

苹果的训练数据包括授权数据和公开可用的数据,后者由苹果的网络爬虫AppleBot收集。网站发布者可以选择退出,不将其网络内容用于苹果智能训练的数据使用控制。

苹果明确表示,在训练基础模型时,不会使用用户的私人个人数据或用户交互数据。同时,苹果会对数据进行过滤,以去除可能公开在互联网上的个人信息,如社会安全号码和信用卡号码。此外,还会过滤掉脏话和其他低质量内容,以防止它们被包含在训练语料库中。除了过滤,苹果还进行数据提取、去重,并应用基于模型的分类器来识别高质量的文档。

3、后训练(Post-Training)

苹果认为数据质量对于模型的成功至关重要。因此,他们在训练流程中采用了混合数据策略,结合了人工标注数据和合成数据。混合数据策略意味着苹果不仅仅依赖于人工标注的数据,也利用了合成数据。人工标注数据通常更加准确和可靠,而合成数据可以提供更大规模的数据集,有助于模型学习。

苹果进行了彻底的数据管理和过滤程序,以确保数据的质量和相关性。这可能包括去除错误标注的数据、过滤掉不相关或低质量的数据等。

苹果开发了两种新的算法来进一步提高模型的性能:

- 拒绝采样微调算法:这种算法使用了一个教师委员会(teacher committee)来进行拒绝采样微调。教师委员会可能由多个模型或专家组成,它们共同决定哪些样本应该被用于进一步的训练。

- 基于人类反馈的强化学习算法(RLHF):这种算法结合了镜像下降(mirror descent)策略优化和一个留一法(leave-one-out)优势估计器。这种方法允许模型通过人类反馈来学习,从而提高其遵循指令的能力。

苹果发现这两种算法显著提高了模型遵循指令的质量。这意味着模型在理解和执行用户指令方面变得更加准确和有效。

4、优化(Optimization)

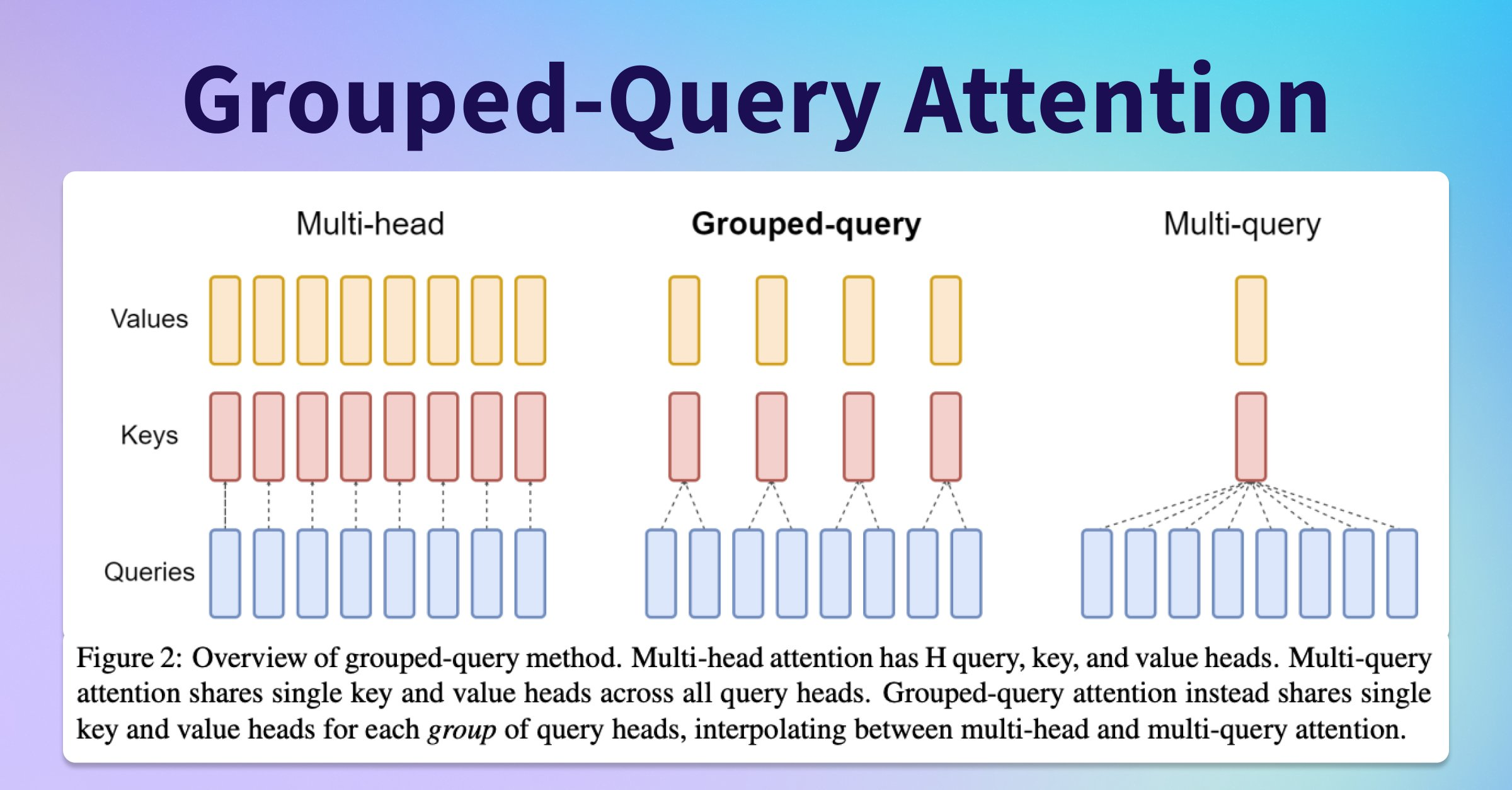

除了确保生成模型具有高度能力外,苹果还使用了一系列创新技术来优化它们,以提高速度和效率。无论是在设备上还是在服务器上,苹果都应用了分组查询注意力(grouped-query-attention)技术。这有助于提高模型的效率。苹果使用共享的输入和输出词汇嵌入表来减少内存需求和推理成本。这些共享的嵌入张量在映射时没有重复。设备上的模型使用49K的词汇量,而服务器模型使用100K的词汇量,后者包括了额外的语言和技术标记。

为了满足必要的内存、功耗和性能要求,苹果在设备上推理时使用了低比特调色板化(low-bitpalletization),这是一种关键的优化技术。

同时,为了保持模型质量,苹果开发了一种新的框架,使用LoRA(Low-RankAdaptation)适配器,结合了2位和4位配置策略,平均达到3.5位每权重,以实现与未压缩模型相同的准确性。

此外,苹果使用交互式模型延迟和功耗分析工具Talaria,以更好地指导每个操作的比特率选择。苹果还利用了激活量化和嵌入量化技术,并开发了一种方法,以在神经引擎上高效更新键值(Key-Value,KV)缓存。

通过这一系列的优化,苹果在iPhone15 Pro上能够实现每个提示标记大约0.6毫秒的时间到第一个标记的延迟,以及每秒30个标记的生成速率。值得注意的是,这种性能是在没有使用标记猜测技术之前实现的,而使用这些技术后,标记生成速率会进一步提高。

5、模型适配(Model Adaptation)

苹果的基础模型针对用户的日常生活活动进行了微调,意味着模型能够更好地理解和响应用户在日常生活中的需求。模型能够即时(on-the-fly)针对当前任务进行自我专业化,模型能够根据当前任务的需求快速调整自己的行为和响应。

苹果使用适配器(adapters),这是一种小型的神经网络模块,可以插入到预训练模型的不同层中,用于针对特定任务进行微调。适配器技术允许苹果只对注意力矩阵、注意力投影矩阵以及变换器架构解码层的逐点前馈网络中的全连接层进行微调。通过仅微调适配器层,原始的预训练模型参数保持不变。这样做的好处是保留了模型的通用知识,同时通过适配器层来支持特定任务。这种方法提供了灵活性和效率,因为它允许模型在不重新训练整个网络的情况下,快速适应新任务。这减少了计算资源的需求,并加快了模型适应新任务的速度。

适配器的参数值使用16位(16bits)来表示,这种表示方法有助于在保持参数精度的同时减少所需的存储空间。对于大约有30亿参数的设备上模型,一个秩为16的适配器的参数通常需要几十兆字节(10s of megabytes)的存储空间。

适配器模型可以被动态加载到内存中,临时缓存,并在需要时进行交换。这种机制使得基础模型能够即时针对当前任务进行专业化,同时高效地管理内存。通过这种方式,苹果确保了操作系统的响应性,即使在模型进行自我专业化的过程中,用户界面和系统操作也能保持流畅。

为了便于适配器的训练,苹果创建了一个高效的基础设施,允许他们快速地重新训练、测试和部署适配器,无论是基础模型更新还是训练数据更新。适配器的参数使用在“优化”部分介绍的准确度恢复适配器(accuracy-recovery adapter)进行初始化。这有助于在适配器训练过程中快速恢复模型的准确性。通过这种基础设施,苹果能够快速迭代适配器,以适应不断变化的任务需求和数据环境。

Apple Intelligence:LLM Model Adaptation

6、效果评估

苹果专注于提供能够让用户在苹果产品上进行沟通、工作、表达自己和完成任务的生成模型。在模型的基准测试中,他们侧重于人类评估,因为他们发现这些结果与产品中的用户体验高度相关。为了评估产品特定的摘要功能,苹果使用了针对每种用例精心采样的750个response。这些评估数据集强调了产品功能在生产中可能遇到的多样化输入,并包括了不同内容类型和长度的单一和堆叠文档的分层混合。苹果发现,在超过99%的目标对抗性示例中,摘要适配器并没有放大敏感内容。

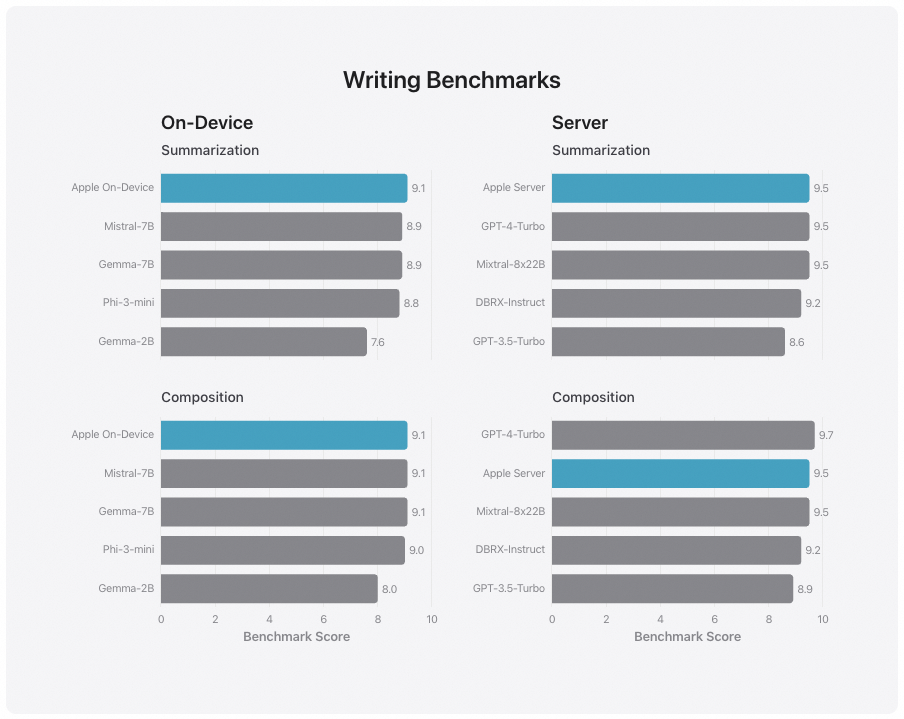

除了评估由基础模型和适配器驱动的特性特定性能外,苹果还评估了设备端和服务器端模型的通用能力。苹果使用了一套全面的、针对真实世界提示的评估集来测试模型的通用能力。这些提示在难度上各不相同,并涵盖了多个主要类别,包括头脑风暴、分类、封闭式问题回答、编码、提取、数学推理、开放式问题回答、重写、安全性、摘要和写作。

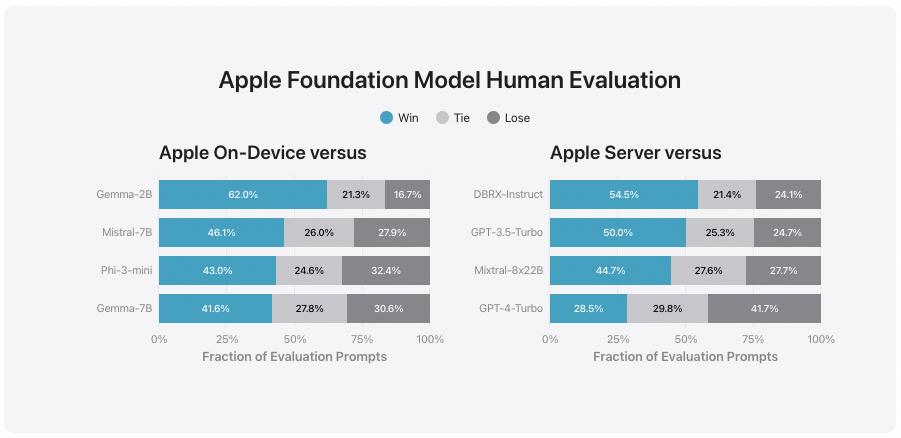

苹果将其模型与开源模型(如Phi-3、Gemma、Mistral、DBRX)以及大小相当的商业模型(如GPT-3.5-Turbo、GPT-4-Turbo)进行了比较。在这些比较中,苹果发现其模型在大多数情况下比竞争对手的模型更受人类评估者的偏好。在基准测试中,苹果的设备端模型(约有30亿参数)的表现超过了更大的模型,包括Phi-3-mini、Mistral-7B和Gemma-7B。苹果的服务器模型在效率上与DBRX-Instruct、Mixtral-8x22B和GPT-3.5-Turbo相比具有优势,同时在性能上也表现良好。

苹果强调了效率的重要性,即使在服务器模型中,也追求高效率,苹果的模型能够在保持较小规模的同时,提供与更大模型相媲美或更好的性能。

苹果使用了一系列多样化的对抗性提示(adversarial prompts)来测试模型。这些提示旨在挑战模型,以检测其在面对可能的恶意输入或边缘情况时的性能,这些测试的目的是评估模型在处理有害内容、敏感话题和确保输出的事实性方面的能力。

苹果通过人类评估者来衡量每个模型在这些对抗性提示上的违规率(violationrates),评估结果中违规率较低的模型被认为是更优的。

苹果的设备端和服务器端模型在面对对抗性提示时表现出了鲁棒性(robustness),即它们能够有效地抵抗这些挑战,保持较低的违规率。苹果的模型在这些测试中的表现优于开源和商业模型。

苹果的模型在人类评估者中被认为比竞争对手的模型更安全、更有帮助。尽管苹果的模型在安全性方面得到了人类评估者的青睐,但苹果也认识到,对于大型语言模型的广泛能力来说,目前的安全基准测试存在局限性。为了克服这些限制,苹果正在积极地进行手动和自动的红队测试(red-teaming)。红队测试是一种模拟攻击者行为的安全测试方法,旨在发现和评估系统的潜在弱点。

苹果采用了一种名为指令遵循评估(Instruction-Following Eval,简称IFEval)的基准测试方法来进一步评估其模型。IFEval的目的是评估模型遵循详细指令的能力,这是衡量模型理解和执行复杂任务指令的关键指标。评估结果显示,无论是设备端模型还是服务器端模型,苹果的模型在遵循详细指令方面都优于相似大小的开源和商业模型。

苹果使用内部的摘要和写作基准测试来评估其模型的写作能力。这些基准测试包含了多种写作指令,以全面评估模型在不同写作任务上的表现。

原文:Introducing Apple’s On-Device and Server Foundation Models - Apple Machine Learning Research

【推广时间】

有做模型推理、微调、AI绘画出图,需要GPU资源的朋友们,可以试试UCloud云计算旗下的Compshare这家GPU算力云平台,4090性价比高,单卡按时2.6元,免费200G磁盘。单卡一个月价格在1250元,还是很香的。现在通过链接注册联系客服可以获得20元代金券,同时现在还有个内容激励活动,发布分享一些AI绘画。模型微调、推理,大模型相关的文章带上他们平台,还可以拿500元代金券,可以白嫖好久的算力了,大家可以试试。

高性价比4090算力租用,注册就送20元代金券,更有内容激励活动:GPU算力平台 | 面向AI场景的高性价比GPU租用平台

GPU云服务器租用,P40、4090、V100S多种显卡可选:GPU云服务器租用_GPU云主机限时特惠-UCloud中立云计算服务商

这篇关于Apple Intelligence:苹果大模型部署方案的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!