本文主要是介绍【数学与算法】协方差矩阵 与 w*w^T 的关系,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

下面的二维向量 W ⃗ \vec W W只是一个样本,对于多个样本才能谈论协方差,因为协方差和方差是求一系列样本的协方差和方差,单个样本并没有协方差这一说。

下面公式中的求 w 1 w1 w1的期望和方差,是求所有样本的 w 1 \displaystyle\color{blue}w1 w1特征的期望和方差。

不过下面的 W ⃗ W ⃗ T \displaystyle\color{blue}\vec{W}\vec{W}^T WWT不叫协方差矩阵,因为各个特征(例如 w 1 \displaystyle\color{blue}w1 w1)没有减去平均值(又叫期望),只有减去平均值(期望)的之后才能叫协方差矩阵,除非期望为0,最后还得除以样本数目,才是协方差矩阵。

W ⃗ = [ w 1 w 2 ] \vec W = \begin{bmatrix} w1\\ w2\\ \end{bmatrix} W=[w1w2]

那么对于 w 1 和 w 2 w1和w2 w1和w2期望为0的 W ⃗ \displaystyle\color{blue}\vec{W} W协方差矩阵为:

P = E ( W ⃗ W ⃗ T ) \displaystyle\color{blue}P = E(\vec{W}\vec{W}^T) P=E(WWT)

注意,上面的协方差是对 W ⃗ W ⃗ T \displaystyle\color{blue}\vec{W}\vec{W}^T WWT求期望,并非 协 方 差 = W ⃗ W ⃗ T \displaystyle\color{blue}协方差=\vec{W}\vec{W}^T 协方差=WWT。

W ⃗ W ⃗ T = [ w 1 w 2 ] [ w 1 w 2 ] = [ w 1 2 w 1 ∗ w 2 w 1 ∗ w 2 w 2 2 ] \vec{W}\vec{W}^T= \begin{bmatrix} w1\\w2\\ \end{bmatrix} \begin{bmatrix} w1\ w2\\ \end{bmatrix} =\begin{bmatrix} w1^2&w1*w2\\\quad\\ w1*w2&w2^2\end{bmatrix} WWT=[w1w2][w1 w2]=⎣⎡w12w1∗w2w1∗w2w22⎦⎤

对上面等式求期望:

E [ w 1 2 w 1 ∗ w 2 w 1 ∗ w 2 w 2 2 ] = [ E ( w 1 2 ) E ( w 1 ∗ w 2 ) E ( w 1 ∗ w 2 ) E ( w 2 2 ) ] E\begin{bmatrix} w1^2&w1*w2\\ w1*w2&w2^2\end{bmatrix} =\begin{bmatrix} E(w1^2)&E(w1*w2)\\\quad\\ E(w1*w2)&E(w2^2)\end{bmatrix} E[w12w1∗w2w1∗w2w22]=⎣⎡E(w12)E(w1∗w2)E(w1∗w2)E(w22)⎦⎤

协方差的完整求法:

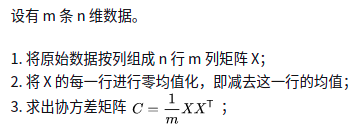

下面是n维特征,有m个样本:

方差的性质:

V a r ( x ) = E ( x 2 ) − E 2 ( x ) (1) \displaystyle\color{blue}Var(x) = E(x^2) - E^2(x) \tag{1} Var(x)=E(x2)−E2(x)(1)

如果 W ⃗ \displaystyle\color{blue}\vec W W的两个特征 w 1 , w 2 \displaystyle\color{blue}w1,w2 w1,w2都服从正态分布,那么:

期望为0,即:

{ E ( w 1 ) = 0 E ( w 2 ) = 0 \color{blue} \begin{cases} E(w1) = 0\\\\ E(w2) = 0 \end{cases} ⎩⎪⎨⎪⎧E(w1)=0E(w2)=0

那么,可以得到:

{ V a r ( w 1 ) = E ( w 1 2 ) V a r ( w 2 ) = E ( w 2 2 ) \color{blue} \begin{cases} Var(w1) = E(w1^2)\\\\ Var(w2) = E(w2^2) \end{cases} ⎩⎪⎨⎪⎧Var(w1)=E(w12)Var(w2)=E(w22)

我们还可以求出 w 1 , w 2 \displaystyle\color{blue}w1,w2 w1,w2的协方差:

C o v ( w 1 , w 2 ) = E ( w 1 ∗ w 2 ) \displaystyle\color{blue}Cov(w1,w2) = E(w1*w2) Cov(w1,w2)=E(w1∗w2)

因此:

E ( W ⃗ W ⃗ T ) = [ V a r ( w 1 ) C o v ( w 1 , w 2 ) C o v ( w 1 , w 2 ) V a r ( w 2 ) ] (2) E(\vec{W}\vec{W}^T)=\begin{bmatrix} Var(w1)&Cov(w1,w2)\\\quad\\Cov(w1,w2)&Var(w2)\end{bmatrix} \tag{2} E(WWT)=⎣⎡Var(w1)Cov(w1,w2)Cov(w1,w2)Var(w2)⎦⎤(2)

上面对等式求期望的那一步,其实就是求期望,只不过 E ( w 1 2 ) \displaystyle\color{blue}E(w1^2) E(w12)其实是对很多样本的 w 1 \displaystyle\color{blue}w1 w1求期望,也就是除以样本数量。

证明过程:

下面是以三个样本为例求 W ⃗ W ⃗ T \displaystyle\color{blue}\vec{W}\vec{W}^T WWT,右上角标表示样本编号:

左边矩阵每列是一个样本,用左上角小括号标注,下面是3个样本。

W ⃗ W ⃗ T = [ w 1 ( 1 ) w 1 ( 2 ) w 1 ( 3 ) w 2 ( 1 ) w 2 ( 2 ) w 2 ( 3 ) ] ∗ [ w 1 ( 1 ) w 2 ( 1 ) w 1 ( 2 ) w 2 ( 2 ) w 1 ( 3 ) w 2 ( 3 ) ] = [ ( w 1 ( 1 ) ) 2 + ( w 1 ( 2 ) ) 2 + ( w 1 ( 3 ) ) 2 w 1 ( 1 ) ∗ w 2 ( 1 ) + w 1 ( 2 ) ∗ w 2 ( 2 ) + w 1 ( 3 ) ∗ w 2 ( 3 ) w 1 ( 1 ) ∗ w 2 ( 1 ) + w 1 ( 2 ) ∗ w 2 ( 2 ) + w 1 ( 3 ) ∗ w 2 ( 3 ) ( w 2 ( 1 ) ) 2 + ( w 2 ( 2 ) ) 2 + ( w 2 ( 3 ) ) 2 ] \vec{W}\vec{W}^T=\begin{bmatrix} w_1^{(1)}&w_1^{(2)}&w_1^{(3)}\\ w_2^{(1)}&w_2^{(2)}&w_2^{(3)}\\ \end{bmatrix} *\begin{bmatrix} w_1^{(1)}&w_2^{(1)}\\ w_1^{(2)}&w_2^{(2)}\\ w_1^{(3)}&w_2^{(3)}\end{bmatrix}=\\ \\\quad\\ \begin{bmatrix} (w_1^{(1)})^2+(w_1^{(2)})^2+(w_1^{(3)})^2 && w_1^{(1)}*w_2^{(1)}+w_1^{(2)}*w_2^{(2)}+w_1^{(3)}*w_2^{(3)}\\ \\\quad w_1^{(1)}*w_2^{(1)}+w_1^{(2)}*w_2^{(2)}+w_1^{(3)}*w_2^{(3)} && (w_2^{(1)})^2+(w_2^{(2)})^2+(w_2^{(3)})^2\end{bmatrix} WWT=[w1(1)w2(1)w1(2)w2(2)w1(3)w2(3)]∗⎣⎢⎡w1(1)w1(2)w1(3)w2(1)w2(2)w2(3)⎦⎥⎤=⎣⎢⎡(w1(1))2+(w1(2))2+(w1(3))2w1(1)∗w2(1)+w1(2)∗w2(2)+w1(3)∗w2(3)w1(1)∗w2(1)+w1(2)∗w2(2)+w1(3)∗w2(3)(w2(1))2+(w2(2))2+(w2(3))2⎦⎥⎤

上面式子的 w 1 w1 w1和 w 2 w2 w2虽然期望为0,所以例如 w 1 ( 1 ) w_1^{(1)} w1(1)这样的每个样本的每个特征都可以说已经做过减去均值的运算,但并没有除以样本数量3。矩阵中每项只有再除以样本数量之后,才是协方差矩阵。

下面对它的矩阵中每项除以样本数量3后:

- 左上角元素就是 w 1 w1 w1的方差 V a r ( w 1 ) Var(w1) Var(w1);

- 右上角元素就是 w 1 , w 2 w1,w2 w1,w2的协方差 C o v ( w 1 , w 2 ) Cov(w1,w2) Cov(w1,w2);

- 左下角元素就是 w 1 , w 2 w1,w2 w1,w2的协方差 C o v ( w 1 , w 2 ) Cov(w1,w2) Cov(w1,w2);

- 右下角元素就是 w 2 w2 w2的方差 V a r ( w 2 ) Var(w2) Var(w2);

就得到了下面的式子:

E ( W ⃗ W ⃗ T ) = [ V a r ( w 1 ) C o v ( w 1 , w 2 ) C o v ( w 1 , w 2 ) V a r ( w 2 ) ] E(\vec{W}\vec{W}^T)=\begin{bmatrix} Var(w1)&Cov(w1,w2) \\\quad\\ Cov(w1,w2)&Var(w2)\end{bmatrix} E(WWT)=⎣⎡Var(w1)Cov(w1,w2)Cov(w1,w2)Var(w2)⎦⎤

上面的式子只针对期望为0的特征。

总结:

二维向量 W ⃗ = [ w 1 w 2 ] \vec W = \begin{bmatrix} w1\\ w2\\ \end{bmatrix} W=[w1w2]的协方差矩阵 与 W ⃗ W ⃗ T \vec{W}\vec{W}^T WWT之间可以经过转化得到,只差两步:

- 1.减去均值(期望);

- 2.除以样本数量。

这篇关于【数学与算法】协方差矩阵 与 w*w^T 的关系的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!