本文主要是介绍配置 human_pose_estimation_demo 的开发环境,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

配置 human_pose_estimation 的开发环境

- 主要讲述如何在 VS2017 IDE 里面配置 OpenIVNO 的演示案例 human_pose_estimation_demo 开发环境。

1. 开发环境说明

- 系统版本:windows 10

- OpenVINO 版本:2020 1

- IDE :VS2017

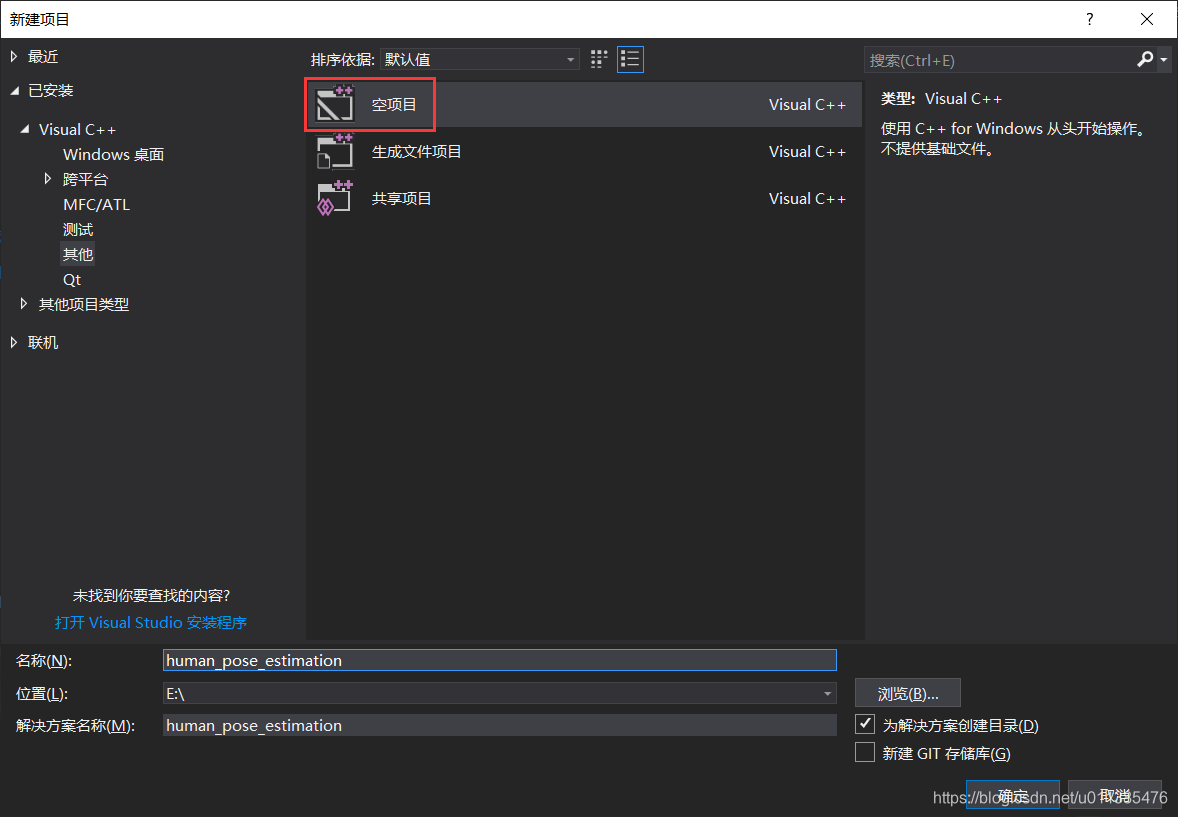

2. 创建项目

- 打开 VS017 ,新建项目,在新建项目时选择空项目

- 然后将 OpenVINO human_pose_estimation_demo 文件夹下面的 include 和 src 文件夹以及 main.cpp 复制到新建项目目录下

- 然后将复制过来的文件分别添加到项目的头文件和源文件

- 此时运行 main.cpp 文件,会发现存在许多错误,下一步我们就是需要进行一系列的配置来消除这些错误。

3. VS2017 配置

- 这里主要在 VS2017 里面配置 包含目录 ,库目录 以及链接器 输入 。

3.1 配置包含目录

- 单击视图,点击其他窗口,在点击属性管理器

- 完成之后,我们就可以看到属性管理器了,然后在属性管理器里面点击 Debug | x64 ,另外将调试也设置为 Debug x64 。

- 接下来我们就在 VC++ 包含目录添加一下内容(具体还是要看自己的电脑文件夹,此仅供参考):

C:\Users\LWL\Documents\Intel\OpenVINO\omz_demos_build\thirdparty C:\IntelSWTools\openvino_2020.1.033\deployment_tools\open_model_zoo\demos\common C:\IntelSWTools\openvino_2020.1.033\deployment_tools\inference_engine\samples\cpp\common E:\human_pose_estimation\human_pose_estimation\include C:\IntelSWTools\openvino_2020.1.033\deployment_tools\inference_engine\include C:\Users\LWL\Documents\Intel\OpenVINO\omz_demos_build\thirdparty\gflags\include C:\IntelSWTools\openvino_2020.1.033\opencv\include

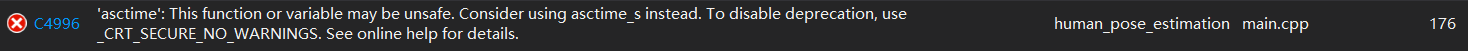

- 如果出现这个错误

- 请在属性页面,点击 C/C++ ,再点击 命令行,然后在里面添加 /D _CRT_SECURE_NO_WARNINGS ,最后点击确定即可。

- 到此为止,我们的包含目录配置完成。

3.2 配置库目录

- 在 VC++ 库目录添加以下内容:

C:\Users\LWL\Documents\Intel\OpenVINO\omz_demos_build\intel64\Debug C:\IntelSWTools\openvino_2020.1.033\deployment_tools\inference_engine\lib\intel64\Debug C:\IntelSWTools\openvino_2020.1.033\opencv\lib

3.3 配置链接器输入

- 在 链接器->输入 里面添加以下内容

opencv_calib3d420d.lib opencv_core420d.lib opencv_dnn420d.lib opencv_features2d420d.lib opencv_flann420d.lib opencv_gapi420d.lib opencv_highgui420d.lib opencv_imgcodecs420d.lib opencv_imgproc420d.lib opencv_ml420d.lib opencv_objdetect420d.lib opencv_photo420d.lib opencv_stitching420d.lib opencv_video420d.lib opencv_videoio420d.lib inference_engine_c_apid.lib inference_engine_nn_builderd.lib inference_engined.lib monitors.lib gflags_nothreads_static.lib pdh.lib shlwapi.lib kernel32.lib user32.lib gdi32.lib winspool.lib shell32.lib ole32.lib oleaut32.lib uuid.lib comdlg32.lib advapi32.lib

4 配置环境变量

- 最后一步就是添加环境变量了。我们需要在环境变量添加以下内容:

C:\IntelSWTools\openvino_2020.1.033\opencv\bin C:\Users\LWL\Documents\Intel\OpenVINO\omz_demos_build\intel64\Debug C:\Users\LWL\Documents\Intel\OpenVINO\omz_demos_build\intel64\Release C:\IntelSWTools\openvino_2020.1.033\deployment_tools\inference_engine\bin\intel64\Debug C:\IntelSWTools\openvino_2020.1.033\deployment_tools\inference_engine\bin\intel64\Release C:\IntelSWTools\openvino_2020.1.033\deployment_tools\inference_engine\external\tbb\bin C:\IntelSWTools\openvino_2020.1.033\deployment_tools\ngraph\lib

- 环境变量配置完成之后,我们就可以去运行程序了。

5.运行 human_pose_estimation

- 由于在运行 human_pose_estimation 需要输入参数,所以我们需要添加命令行参数

- 在 Debug 属性页面,点击调试,点击命令参数

- 在里面添加

-i C:\Users\LWL\Desktop\sample-videos-master\classroom.mp4 -m C:\Users\LWL\Desktop\human-pose-estimation-0001.xml -d CPU - 其中 -i 参数默认为 cam,使用摄像头作为输入。也可以在 -i 后面加视频文件路径,使用视频输入。

-m 参数为模型文件下的 xml 文件。

-d 参数为使用执行的设备,这里使用 CPU 来执行。 - 如果不知道怎么下载模型,请参考文章:OpenVINO 学习笔记(3):执行 OpenVINO Demos

- 运行结果(注意要以管理员身份运行)

6. 结语

- 由于本人也是刚学习 OpenVINO ,如果其中有不对的地方或是需要改进的地方,请指正。

- 联系方式 email:lwl510ll@163.om

- 本文到这就结束了,谢谢大家观看。

这篇关于配置 human_pose_estimation_demo 的开发环境的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!