accelerator专题

AWS 专题学习 P6 (CloudFront、Global Accelerator、Snow Family)

文章目录 专题总览1. Amazon CloudFrontCloudFront – OriginsCloudFront 处于高水平CloudFront – S3 作为源CloudFront 与 S3 跨区域复制CloudFront – ALB or EC2 as originCloudFront 地理限制CloudFront - PricingCloudFront – Price Class

coherent性_使用Coherent Accelerator Processor Interface(CAPI)在IBM AIX上实现高性能

什么是CAPI? IBM®POWER8®和更高版本的体系结构支持Coherent Accelerator处理器接口(CAPI),IBMPower®系统中的某些PCIe插槽可以使用该接口。 可以将CAPI视为通过PCIe的特殊隧道协议,它使PCIe适配器看起来像专用的协处理器或加速器,可以读取/写入应用程序内存并生成页面错误。 结果,以CAPI模式运行的适配器的主机接口既不需要将数据缓冲区作

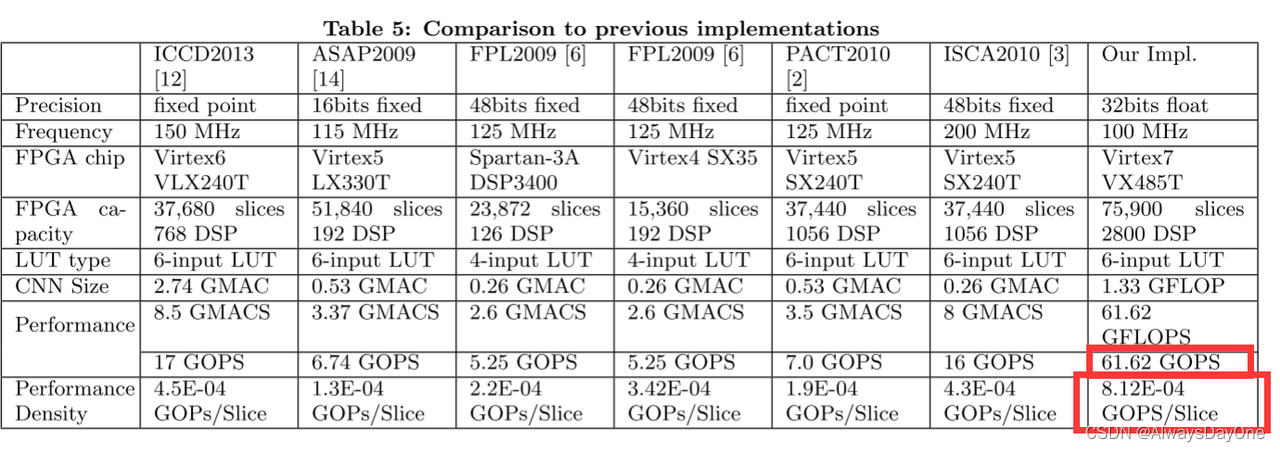

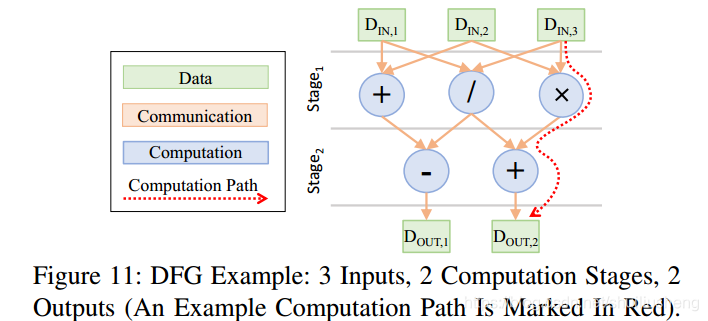

Optimizing FPGA-based Accelerator Design for Deep Convolutional Neural Networks ,2015 论文阅读笔记

简述:这篇文章的贡献在于 对CNN FPGA加速器的技术 (例如循环平铺和转换) 优化,同时进行了定量分析计算吞吐量和片内外I/0带宽和建模 通过roof-line模型搜索加速器硬件参数设计空间中最优的方案, 最后通过此建模方案设计了一个加速器,获得当时最优性能密度的CNN加速器。 背景与动机 回答Paper 背景和解决什么问题? 背景 卷积神经网络 (CNN) 已被广泛

谷歌Coral USB Accelerator最新安装使用指南

谷歌Coral USB加速器是一种USB设备,提供Edge TPU作为计算机的协处理器。 当连接到Linux,Mac或Windows主机时,它可以加快机器学习模型的推理速度。 你需要做的就是在连接USB Accelerator的计算机上下载Edge TPU运行时和TensorFlow Lite库。 然后,使用示例应用程序执行图像分类。 系统要求: 具有以下操作系统之一的计算机:

The Accelerator Wall: Limits of Chip Specialization

The Accelerator Wall: Limits of Chip Specialization 摘要: 加速器墙:芯片上可用晶体管数量的停滞将限制加速器的设计优化空间,导致专有化硬件回报的减少,最终将会遇到加速器墙论文工作:探讨了在未来加速器和定制化芯片的限制将会有哪些 论文使用数千个芯片的数据表(datasheet)构建的模型工具,论文描述了当前加速器如何依赖于CMOS缩放(scal

Coral Accelerator 初探

Coral Accelerator 初探 Coral Accelerator 介绍环境配置Requirements安装 Edge TPU runtime安装TFlite 使用TensorFlow Lite API运行model Coral Accelerator 介绍 Coral Accelerator全名叫:Edge TPU Accelerator(边缘TPU加速器),是Goo

[RPI.CM4] Coral TPU Accelerator

官网链接:https://coral.ai/products/accelerator/ 1. Edge TPU runtime A. Add Debian package repository to system: echo "deb https://packages.cloud.google.com/apt coral-edgetpu-stable main" | sudo tee /

树莓派使用Google Edge TPU加速模型推理(Coral USB Accelerator)

树莓派使用Google Edge TPU加速模型推理(Coral USB Accelerator) 第一部分 树莓派网络环境配置 略 第二部分 安装Edge TPU 库 2.1 安装Edge TPU runtime 增加Debian包仓库 echo "deb https://packages.cloud.google.com/apt coral-edgetpu-stable mai

北京峰会系列五|New File Accelerator and Recovery Feature in SPDK Vhost

今天给大家带来的是新的文件加速器和在线恢复功能在SPDK虚拟化上的应用,分享的内容有以下几点: 1)关于SPDK vhost-fs 方案的背景需求以及面向虚拟机使用的适配场景。 2)Container对存储的一些基本需求,以及SPDK在这方面的探索,并讲解了SPDK vhost-fs在kata container上潜在的应用价值。 3)SPDK vhost模块中对vhost-blk在线恢复功能的

Modeling Deep Learning Accelerator Enabled GPUs

Modeling Deep Learning Accelerator Enabled GPUs 发表在 ISPASS 2019 上。文章研究了 NVIDIA 的 Volta 和 Turing 架构中张量核的设计,并提出了 Volta 中张量核的架构模型。 基于 GPGPU-Sim 实现该模型,并且支持 CUTLASS 运行。发现其性能与硬件非常吻合,与 Titan V GPU 相比,获得了99.6

Modeling Deep Learning Accelerator Enabled GPUs

Modeling Deep Learning Accelerator Enabled GPUs 发表在 ISPASS 2019 上。文章研究了 NVIDIA 的 Volta 和 Turing 架构中张量核的设计,并提出了 Volta 中张量核的架构模型。 基于 GPGPU-Sim 实现该模型,并且支持 CUTLASS 运行。发现其性能与硬件非常吻合,与 Titan V GPU 相比,获得了99.6

Modeling Deep Learning Accelerator Enabled GPUs

Modeling Deep Learning Accelerator Enabled GPUs 发表在 ISPASS 2019 上。文章研究了 NVIDIA 的 Volta 和 Turing 架构中张量核的设计,并提出了 Volta 中张量核的架构模型。 基于 GPGPU-Sim 实现该模型,并且支持 CUTLASS 运行。发现其性能与硬件非常吻合,与 Titan V GPU 相比,获得了99.6

![[RPI.CM4] Coral TPU Accelerator](https://img-blog.csdnimg.cn/2c92753c99de4869bdbfd742a1881144.png?x-oss-process=image/watermark,type_d3F5LXplbmhlaQ,shadow_50,text_Q1NETiBA6bud6buR55qE54Gr5pif5Lq6,size_18,color_FFFFFF,t_70,g_se,x_16)