2b专题

【高中数学/基本不等式】若正数a,b满足a>b,且1/(a+b)+1/(a-b)=1,则3a+2b的最小值是?

【问题】 若正数a,b满足a>b,且1/(a+b)+1/(a-b)=1,则3a+2b的最小值是? 【来源】 《解题卡壳怎么办 高中数学解题智慧点剖析》P38 余继光 苏德矿合著 浙江大学出版社出版 【如何破题】 1/(a+b)+1/(a-b)=1这个关系式挺复杂,展开后更乱(用三角函数也帮不上忙),而3a+2b这个表达式相对简单; 如果想让两者相乘,可以用配方的手段,得出的结果一部分能

240831-Qwen2-VL-7B/2B部署测试

A. 运行效果 B. 配置部署 如果可以执行下面就执行下面: pip install git+https://github.com/huggingface/transformers accelerate 否则分开执行 git clone https://github.com/huggingface/transformerscd transformerspip install .

结合ollama gemma2:2b大模型来实现数据分析系统的智能交互

在最近的人员风险行为分析系统开发过程中,需要解决一个问题:在缺乏GPU资源的情况下,如何提升智能交互能力。我们探索并研究了集成gemma2:2b模型的可行性,这一举措旨在在有限的硬件条件下,为我们的系统注入更高级别的智能性,从而增强用户体验并提高数据分析效率。 具体可分为如下几个步骤: 定义用户可能提出的问题类型结合大模型设计接口,以便根据用户的问题提取实体信息实现数据检索机制以提取相关信息返

【Datawhale AI 夏令营】第四期 基于2B源大模型 微调

定位:代码复现贴 教程:https://datawhaler.feishu.cn/wiki/PLCHwQ8pai12rEkPzDqcufWKnDd 模型加载 model = AutoModelForCausalLM.from_pretrained(path, device_map="auto", torch_dtype=torch.bfloat16, trust_remote_code=

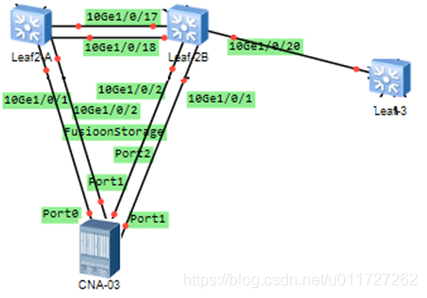

Lab2 leaf2A/2B M-LAG

Lab2 leaf2A/2B M-LAG Leaf2A、leaf2B和spine使用M-LAG 1、 CNA管理VLAN4005,存储VLAN 4011,CNA管理地址已预配。 2、 Leaf2A/2B下计算网络与存储网络隔离,计算网络接口是10GE1/0/1,fusion storage接口是10GE1/0/2 3、 Leaf2A/2B要求使用DFS主系统MAC地址作为桥MAC,仅接入计算网

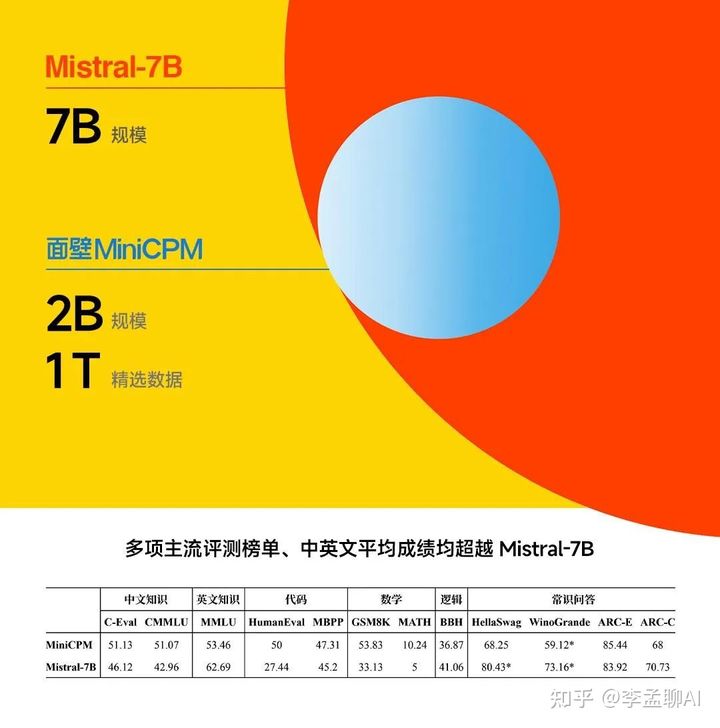

[大模型]MiniCPM-2B-chat Lora Full 微调

MiniCPM-2B-chat 介绍 MiniCPM 是面壁智能与清华大学自然语言处理实验室共同开源的系列端侧大模型,主体语言模型 MiniCPM-2B 仅有 24亿(2.4B)的非词嵌入参数量。 经过 SFT 后,MiniCPM 在公开综合性评测集上,MiniCPM 与 Mistral-7B相近(中文、数学、代码能力更优),整体性能超越 Llama2-13B、MPT-30B、Falcon-4

重磅消息! Stable Diffusion 3将于6月12日开源 2B 版本的模型,文中附候补注册链接。

在OpenAI发布Sora后,Stability AI也发布了其最新的模型Stabled Diffusion3, 之前的文章中已经和大家介绍过,感兴趣的小伙伴可以点击以下链接阅读。Sora是音视频方向,Stabled Diffusion3是图像生成方向,那么两者没有必然的联系,此外二者的核心部分都是采用了Difusion Transformer的方式。 从Stability AI 在 X

【记录】初次本地搭建的模型-MiniCPM 2B

前言 查阅众多开源大模型后,打算动手尝试搭建端侧模型,看看效果。选中MiniCPM主要是因为参数小,同时中文支持相对较好。 首先对按照官网提供的demo进行了尝试,然后在colab中完成了一个webui程序并测试,最后通过docker环境在本地搭建并测试成功。 Colab Demo测试 from transformers import A

Codefoeces 2B. The least round way

B. The least round way time limit per test 5 seconds memory limit per test 64 megabytes input standard input output standard output There is a square matrix n × n, consisting of n

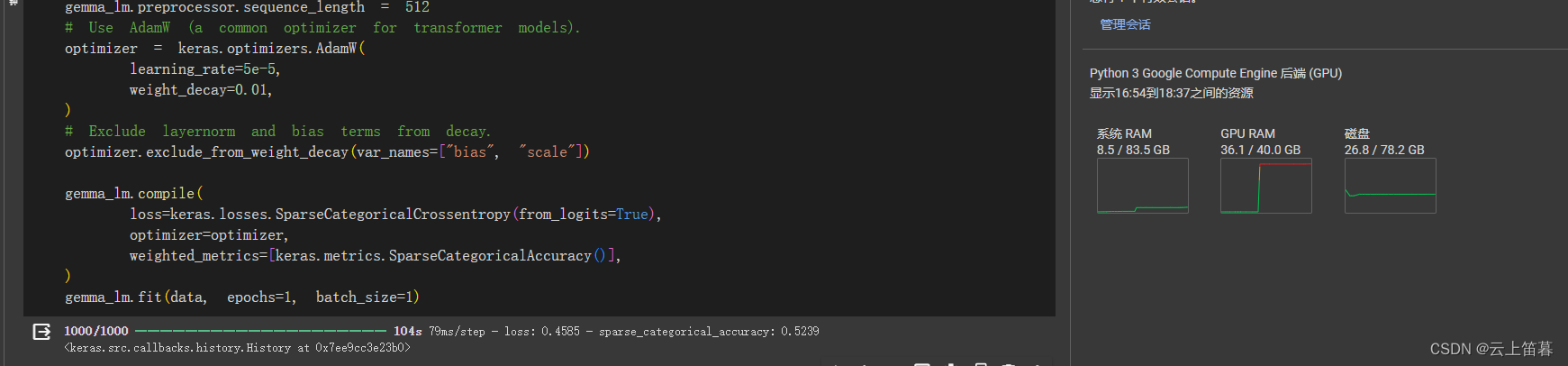

Google Gemma 2B 微调实战(IT科技新闻标题生成)

本文我将使用 Google 的 Gemma-2b 模型来微调一个基于IT科技新闻正文来生成对应标题的模型。并且我将介绍如何使用高度集成的训练框架来进行快速微调。 开始前 为了尽可能简化整个流程,我将使用 linux-cn 数据集[1]作为本次训练任务的训练数据。 模型选择使用 Gemma-2b[2],在目前这个任务中 2b 级别的参数模型已经完全能满足当前的需求,当然你也可以尝试使

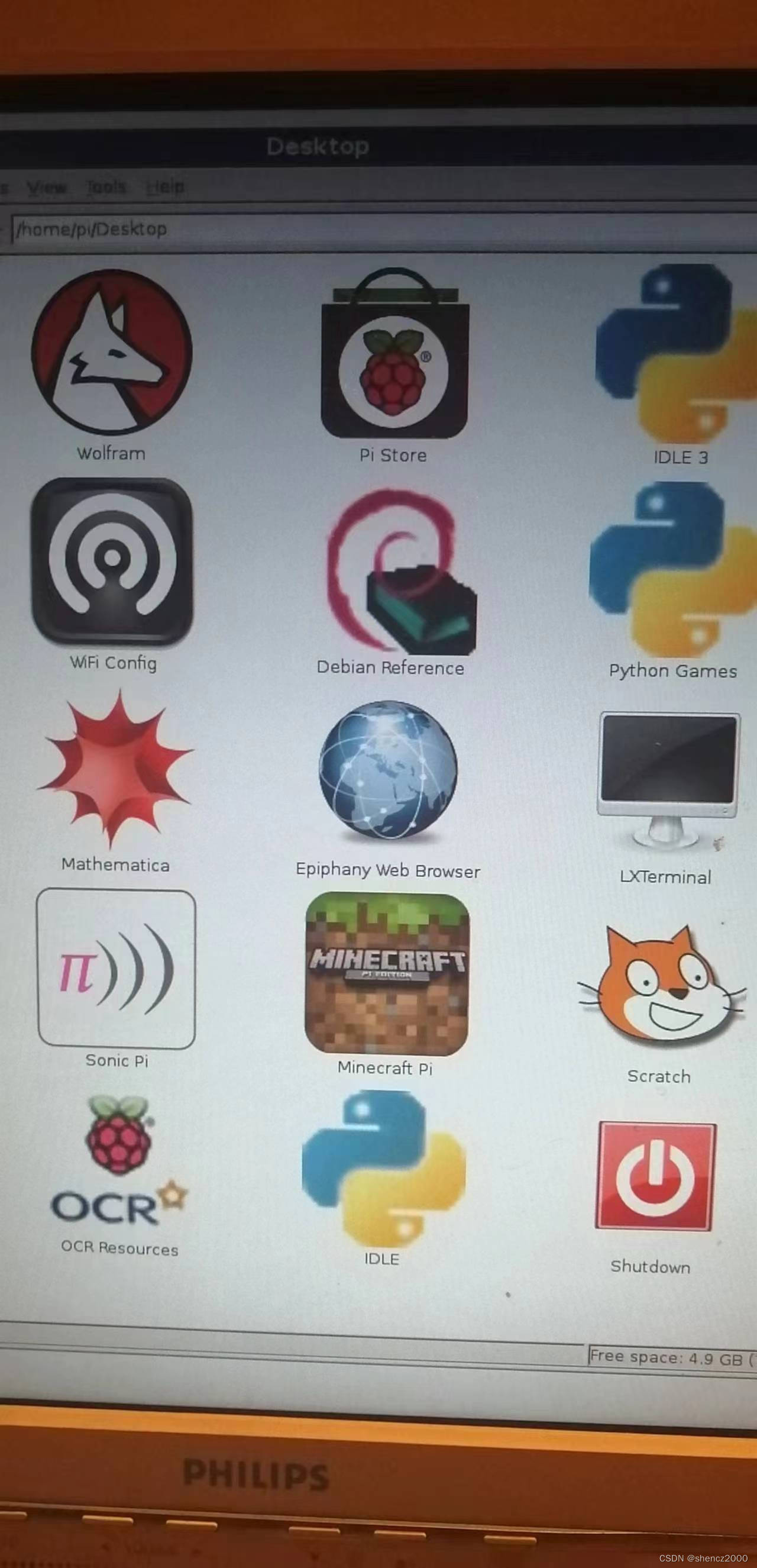

用树莓派2B当web服务器

树莓派2,卡片大小,arm 32位cpu,512G内存。我找了一下购买记录,2013年12月15日买的。带网线接头。属于树莓派2B。以前下载的操作系统还在。是2014年的操作系统,文件名是:2014-09-09-wheezy-raspbian_shumeipai.net.zip,该zip文件需要解压缩以后才能得到img文件,img文件很大。zip文件900多M,解压以后的img文件是3.2G。使用

[大模型]MiniCPM-2B-chat transformers 部署调用

MiniCPM-2B-chat transformers 部署调用 MiniCPM-2B-chat 介绍 MiniCPM 是面壁智能与清华大学自然语言处理实验室共同开源的系列端侧大模型,主体语言模型 MiniCPM-2B 仅有 24亿(2.4B)的非词嵌入参数量。 经过 SFT 后,MiniCPM 在公开综合性评测集上,MiniCPM 与 Mistral-7B相近(中文、数学、代码能力更优)

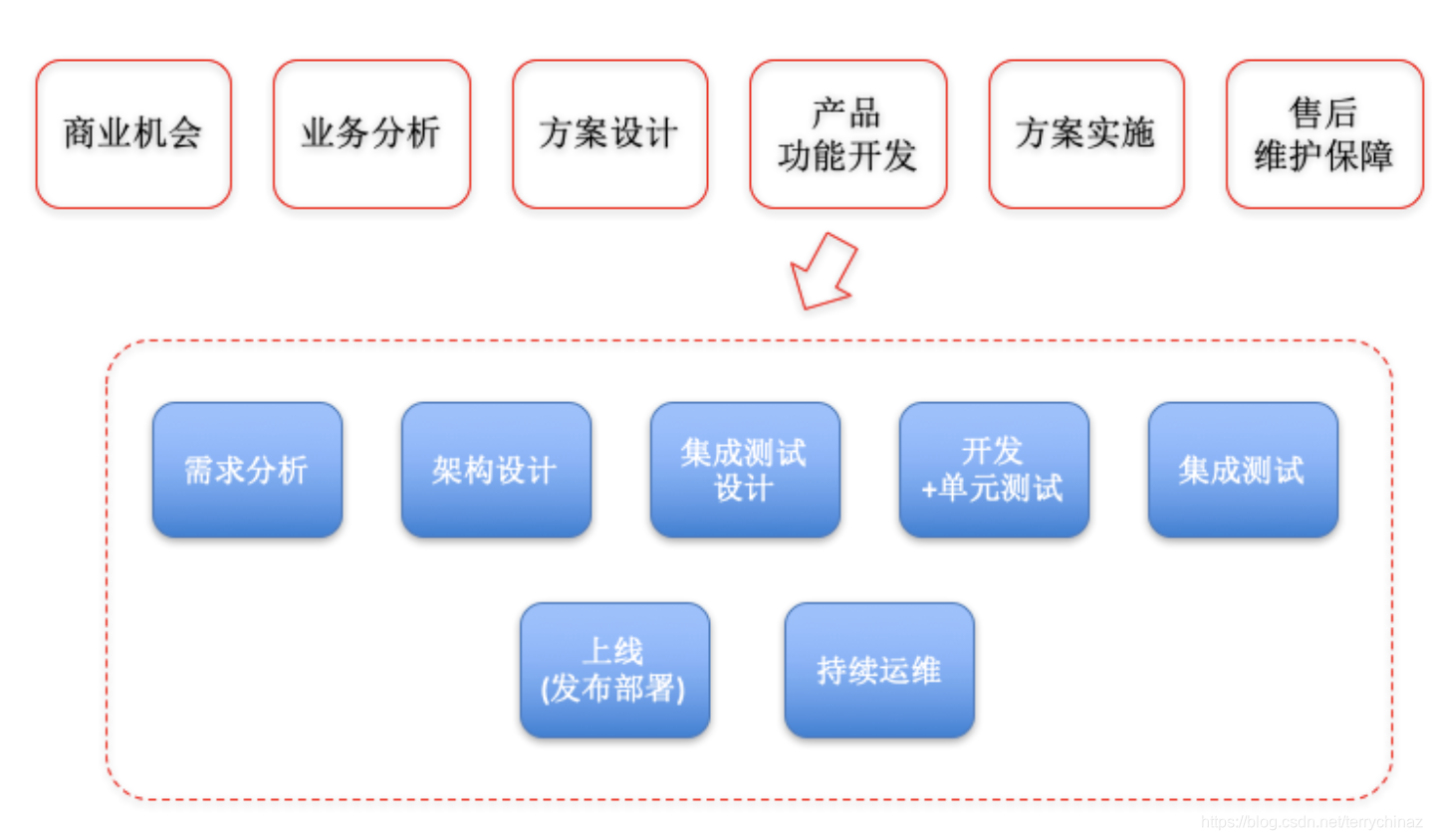

产品之 2B、2C与2G

文章目录 TL;DR1 相同之处2 不同之处3 G 端产品的特点4 政府领导型客户频繁变更需求怎么办?三个步骤解决! TL;DR B2B(business to business,企业对企业)、B2C(business to customer,企业对消费者)、B2H(business to home,企业直接针对社区家庭营销的一种模式)、B2G(business to gover

基于lora技术微调Gemma(2B)代码实践

一、前置条件 获得模型访问权,选择Colab运行时,配置训练环境。 先在Kaggle上注册,然后获得Gemma 2B 的访问权; 然后在Google colab 配置环境,主要是GPU的选择,免费的是T4,建议采用付费的A100(为了节省时间,微调训练耗时T4需要30分钟左右,A100只需要2分钟左右) 最后 在Kaggle 上的account上生成令牌文件(主要是usename 和 AP

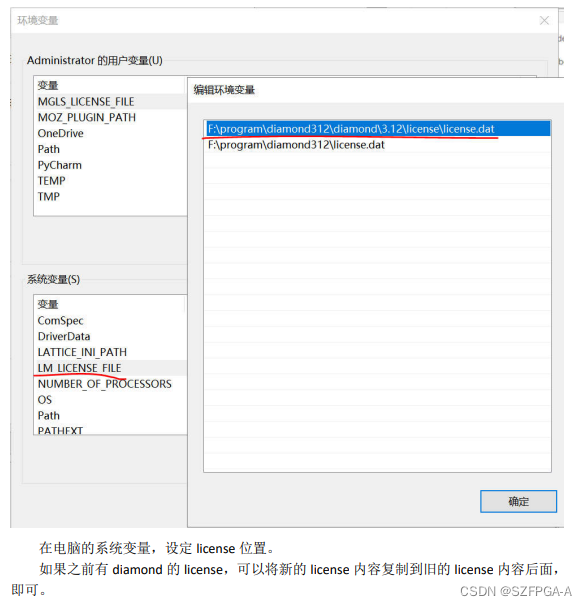

Lattice高速下载器高HW-USBN-2B如何申请 license

如果用的芯片不是停产老旧芯片,Diamond programmer 是不需要 license 绑定支持的。 但是有些需要编程老旧的芯片。需要安装 Diamond programmer stand-alone 版本。另外需要 单独的免费 license,这样才能启用老旧芯片烧录功能。 如果没有网站账户,请在 https://www.latticesemi.com/Accounts/Ac

Gemma谷歌(google)开源大模型微调实战(fintune gemma-2b)

Gemma-SFT Gemma-SFT(谷歌, Google), gemma-2b/gemma-7b微调(transformers)/LORA(peft)/推理 项目地址 https://github.com/yongzhuo/gemma-sft全部weights要用fp32/tf32, 使用fp16微调十几或几十的步数后大概率loss=nan;(即便layer-norm是fp32也不行,

落地端侧,2B模型如何以小搏大?|对话面壁CEO李大海

文|郝 鑫 “AGI是一场马拉松”,面壁智能联合创始人、CEO,知乎CTO李大海道。 作为一个马拉松的爱好者,李大海深知在大模型的竞争中,一时的“快”只是暂时的,更重要的是把赛程中的每一步都跑下来,跑踏实。 回顾面壁智能的发展历程也确实如此,2018年脱胎于清华NLP实验室,发布了全球首个知识指导的预训练模型ERNIE;2020年成为悟道大模型的首发主力阵容;2022年成立

清华系2B模型杀出,性能吊打LLaMA-13B,170万tokens仅需1块钱

清华系面壁智能开始卷小模型了:14 天实现用 2B 模型超越 7B、13B,170 万 tokens 仅花 1 块钱 2 月 1 日,面壁智能与清华大学自然语言处理实验室共同开源了系列端侧语言大模型 MiniCPM,主体语言模型 MiniCPM-2B 仅有 24 亿(2.4B)的非词嵌入参数量。 在综合性榜单上与 Mistral-7B 相近,在中文、数学、代码能力表现更优,整体性能超越

1元竟能驱动170万次AI推理?面壁智能MiniCPM 2B大模型,部署教程 移动端 安卓 苹果 ios android

在科技日新月异的今天,我们似乎习惯了“更新换代”的节奏。但你有没有想过,那些陪伴我们多年的老手机,也能摇身一变成为AI神器?面壁智能的MiniCPM 2B大模型,就给我们带来了这样的惊喜。 你可能不知道,这个仅有20亿参数的大模型,却拥有“越级打怪”的实力。与业内知名的大模型相比,它在多项主流评测中都展现出了优越的性能。更令人振奋的是,它的成本极低,仅需1元就能驱动170万次AI推理!

关于2C与2B的产品经理,这可能是最真诚的一篇分享了

知乎、各种PM社区中,大家给产品经理下了各种各样的定义,但就像描述“桔子是什么?”将桔子和苹果在颜色、口感、形状等多个维度上做一比较,才能知道桔子是什么滋味。对比不同类型产品经理的区别,也会对这个岗位的本质和边界有更深入的认识。 笔者在YY语音做过2年多的客户端和APP产品经理,后来去了一家手机公司,做了一段时间的后台系统。虽然无论之前还是现在看两种产品都有太多不同——比如一个被认为用来

2B or 2C,菜鸟不成问题的问题

尽管没有一个快递员,但是菜鸟在末端不断布局,留给快递公司的那部分正是最有可能在未来被机器人替代的,比如快递员的机器换人,干线物流未来的无人化和自动化。 届时,快递公司将何以自立? 作者 / 方 文 编辑 / 邱 韵 2B or 2C,对菜鸟来说是一个不成问题的问题。 不成问题,是因为菜鸟有足够的能力去触达末端消费者并提供服务。为了消除快递企业的这方面的顾虑,早在2013年成立之初

【Codeforces Beta Round 2B】【贪心 DP】The least round way 从(1,1)走到(n,n)乘积尾数0尽可能少

B. The least round way time limit per test 5 seconds memory limit per test 64 megabytes input standard input output standard output There is a square matrix n × n, consisting of n

教育赛道2G、2B、2C产品矩阵成型,2022科大讯飞进入发展收获期

押对了「AI+教育」风口的科大讯飞,开始进入发展收获期。 2021年,受到双减政策打击的教育培训行业陷入到了旷日持久的乌云之中,大量的企业纷纷倒闭,但是多年以来深耕 AI 教育领域的科大讯飞,反而实现了逆市增长。 在这其中,科大讯飞的 B 端、C 端教育产品都为集团的营收做出了极大的贡献,也受到了教育主管部门、学校、老师和家长们的认可,随着未来在线教育愈发普及,多年来坚持在教育领域投入的科大讯

Q4财报再次显示,百度在2B市场的竞争中已占据领先地位

文|魏启扬 来源|智能相对论(aixdlun) 2月28日凌晨(美国东部时间2月27日),百度盘后如期发布2019年Q4及全年财报。 财报显示,百度第四季度实现营收289亿元人民币,归属百度的净利润达到92亿元人民币 (非美国通用会计准则),同比增长95%。2019年年营收为1074亿元人民币。全年来看,百度实现营业收入同比增长5%,至1074亿元。 在经历了2019年第一季

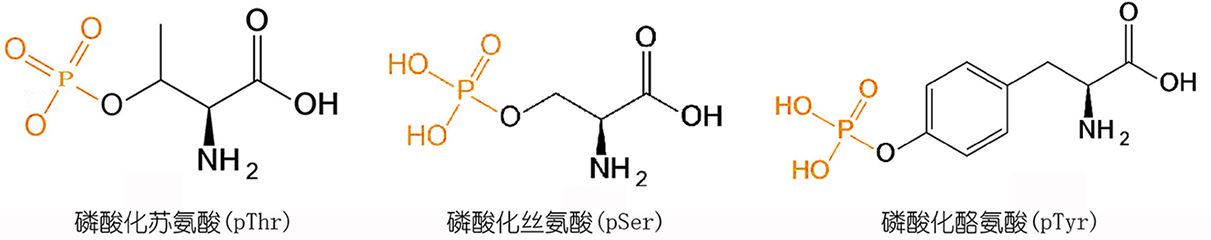

糖原合成酶激酶-3 (GSK-3) 底物:2B-(SP)

2B-(SP) TFA 是基于 eIF2B 的糖原合成酶激酶-3 (GSK-3) 底物。2B-(SP) TFA 容易被 GSK-3α 的 GSK-3β 磷酸化。2B-(SP) TFA is a eIF2B-based substrate for glycogen synthase kinase-3 (GSK-3). 2B-(SP) TFA is readily phosphorylated b

![[大模型]MiniCPM-2B-chat Lora Full 微调](https://img-blog.csdnimg.cn/direct/1b9775b35ecf41d0b84e94ae4974da3d.png#pic_center)

![[大模型]MiniCPM-2B-chat transformers 部署调用](https://img-blog.csdnimg.cn/direct/7db98dc1d80543bfa68e1c7333f2b514.png#pic_center)