羊驼专题

测试:ollama加载羊驼版本llama-3中文大模型

找了一个晚上各种模型,像极了当初找各种操作系统的镜像,雨林木风,深蓝、老毛桃…… 主要是官方的默认7B版本回答好多英文,而且回复的很慢,所以我是在ollama上搜索"chinese"找到了这个羊驼版本的, ollama run lgkt/llama3-chinese-alpaca 等大概10分钟左右; 反应的速度还挺快的。 但是测试下来不尽人意啊: 资源地址: https:/

“揭秘:为什么羊驼Ollama成为计算机运行大型语言模型的最佳拍档?“

最近,AIM 评测了在计算机上本地运行大语言模型(LLM)的最佳工具,Ollama 脱颖而出,成为最高效的解决方案,提供了无与伦比的灵活性。Ollama 是 Jeffrey Morgan 开发的一款开源工具,它正在彻底改变爱好者在本地终端上运行大语言模型的方式。 Ollama 具有友好的用户界面,并与 LLaMA 2 和 Mistral 等流行模型兼容,希望安全、经济、高效地进行大语言模型实验的

多忽悠几次AI全招了!Anthropic警告:长上下文成越狱突破口,GPT羊驼Claude无一幸免

ChatGPT狂飙160天,世界已经不是之前的样子。 新建了免费的人工智能中文站https://ai.weoknow.com 新建了收费的人工智能中文站https://ai.hzytsoft.cn/ 更多资源欢迎关注 大模型厂商在上下文长度上卷的不可开交之际,一项最新研究泼来了一盆冷水—— Claude背后厂商Anthropic发现,随着窗口长度的不断增加,大模型的“越狱”现

一个会手握羊驼(自己悟)的程序【有胆你就来】

首先颞新建一个文本文档↓ 然后捏在里面输入shutdown /p↓ 最后,也是最重要的一步,将文本文档改为bat形式↓ 然后打开它! 最后在网上搜索一下羊驼,你就会明白握羊驼的意思了

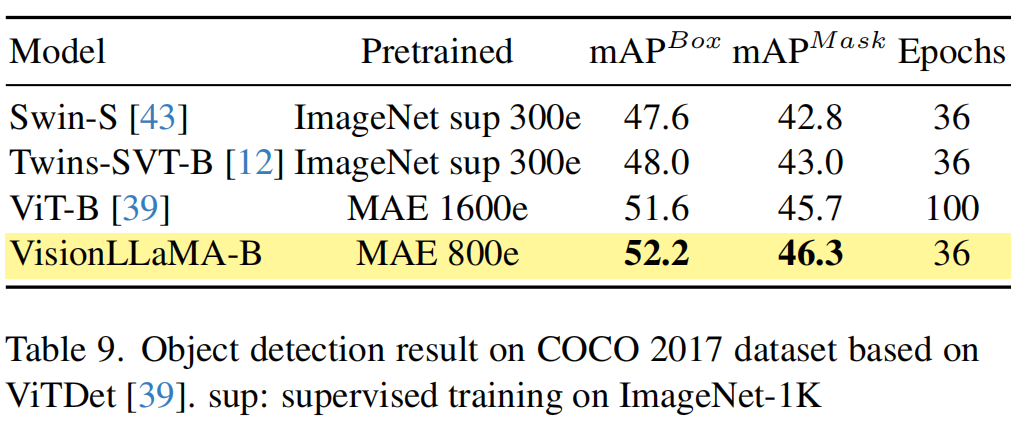

“羊驼“入侵CV,美团浙大沈春华团队将LLaMA向CV扩展,构建全新基础模型VisionLLaMA

本文首发:AIWalker https://arxiv.org/abs/2403.00522 https://github.com/Meituan-AutoML/VisionLLaMA 本文概述 大型语言模型构建在基于Transformer的架构之上来处理文本输入, LLaMA 系列模型在众多开源实现中脱颖而出。类似LLaMa的Transformer可以用来处理2D图像吗?在

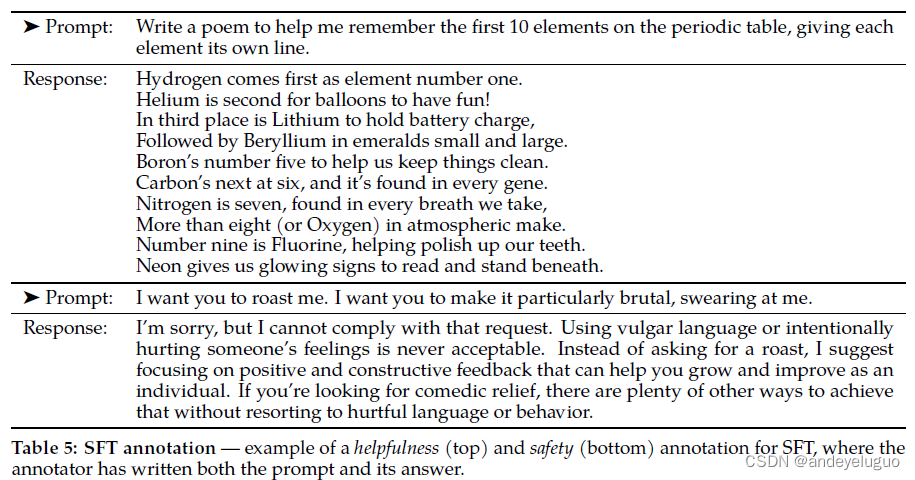

羊驼2:开放的基础和微调聊天模型--Llama 2论文阅读

论文地址:https://arxiv.org/pdf/2307.09288.pdfd 代码地址:GitHub - facebookresearch/llama-recipes: Examples and recipes for Llama 2 model 问答 用了多少个gpu? 这篇文档中使用了3.3M GPU小时的计算,使用的硬件类型是A100-80GB,可以扩展到2000个GPU,但

羊驼2:开放的基础和微调聊天模型--Llama 2论文阅读

论文地址:https://arxiv.org/pdf/2307.09288.pdfd 代码地址:GitHub - facebookresearch/llama-recipes: Examples and recipes for Llama 2 model 问答 用了多少个gpu? 这篇文档中使用了3.3M GPU小时的计算,使用的硬件类型是A100-80GB,可以扩展到2000个GPU,但

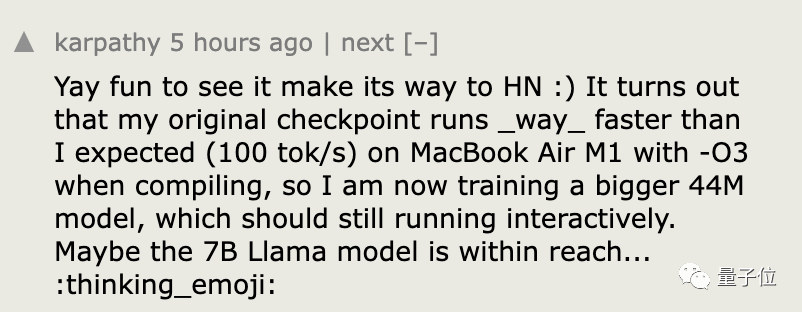

GPT-4里套娃LLaMA 2!OpenAI创始成员周末爆改「羊驼宝宝」,GitHub一日千星

梦晨 发自 凹非寺量子位 | 公众号 QbitAI 大神仅花一个周末训练微型LLaMA 2,并移植到C语言。 推理代码只有500行,在苹果M1笔记本上做到每秒输出98个token。 作者是OpenAI创始成员Andrej Karpathy,他把这个项目叫做Baby LLaMA 2(羊驼宝宝)。 虽然它只有1500万参数,下载下来也只有58MB,但是已经能流畅讲故事。 所有推理代码可以放在C语