灾难性专题

大模型全量微调和LoRA微调详细说明,如何避免灾难性遗忘

在使用大模型进行微调时,特别是在语音识别、自然语言处理等任务中经常会遇到两个主要方法:全量微调和LoRA微调。全量微调涉及更新模型的所有参数,而LoRA(Low-Rank Adaptation)则专注于更新少量的参数来适应新的任务。这两种方法各有优缺点,并有不同的应用场景。 全量微调 1. 什么是全量微调? 全量微调是指在微调阶段,更新模型中所有参数。这个过程通常在大规模数据集上进行,以适应

电影制作中的版本控制:Perforce Helix Core帮助某电影短片避免灾难性文件损坏,简化艺术资产管理

Zubaida Nila是来自马来西亚的一名视觉特效师和虚拟制作研究员,她参加了Epic Games的一个为期六周的虚拟培训和指导项目——女性创作者计划。该计划提供了虚幻引擎工作流程的实践经验以及其他课程。Zubaida希望从中获得更多关于虚幻引擎的灯光、后期处理和特效技能方面的培训,这对于她在虚拟制作工作中担任全职特效师是非常有价值的。 作为该计划的一部分,Zubaida将自己的专业经验与

大模型增量预训练新技巧:解决灾难性遗忘

大家好,目前不少开源模型在通用领域具有不错的效果,但由于缺乏领域数据,往往在一些垂直领域中表现不理想,这时就需要增量预训练和微调等方法来提高模型的领域能力。 但在领域数据增量预训练或微调时,很容易出现灾难性遗忘现象,也就是学会了垂直领域知识,但忘记了通用领域知识,之前介绍过增量预训练以及领域大模型训练技巧。 今天给大家带来一篇增量预训练方法-Llama-Pro,对LLMs进行Transform

java survivor rato_VOA常速英语:尼泊尔村庄遭遇地震灾难性冲击

00:00 00:00 微信扫码登陆,畅听全站所有音频! (20秒后自动关闭) X 关注后,点此关闭 https://online2.tingclass.net/lesson/shi0529/0009/9376/20150502_1.mp3 https://image.tingclass.net/statics/js/2012 SINDHUPOLCHAK, NEPAL— Nepal is st

增量预训练,在所属领域数据上继续预训练,主要问题是灾难性遗忘

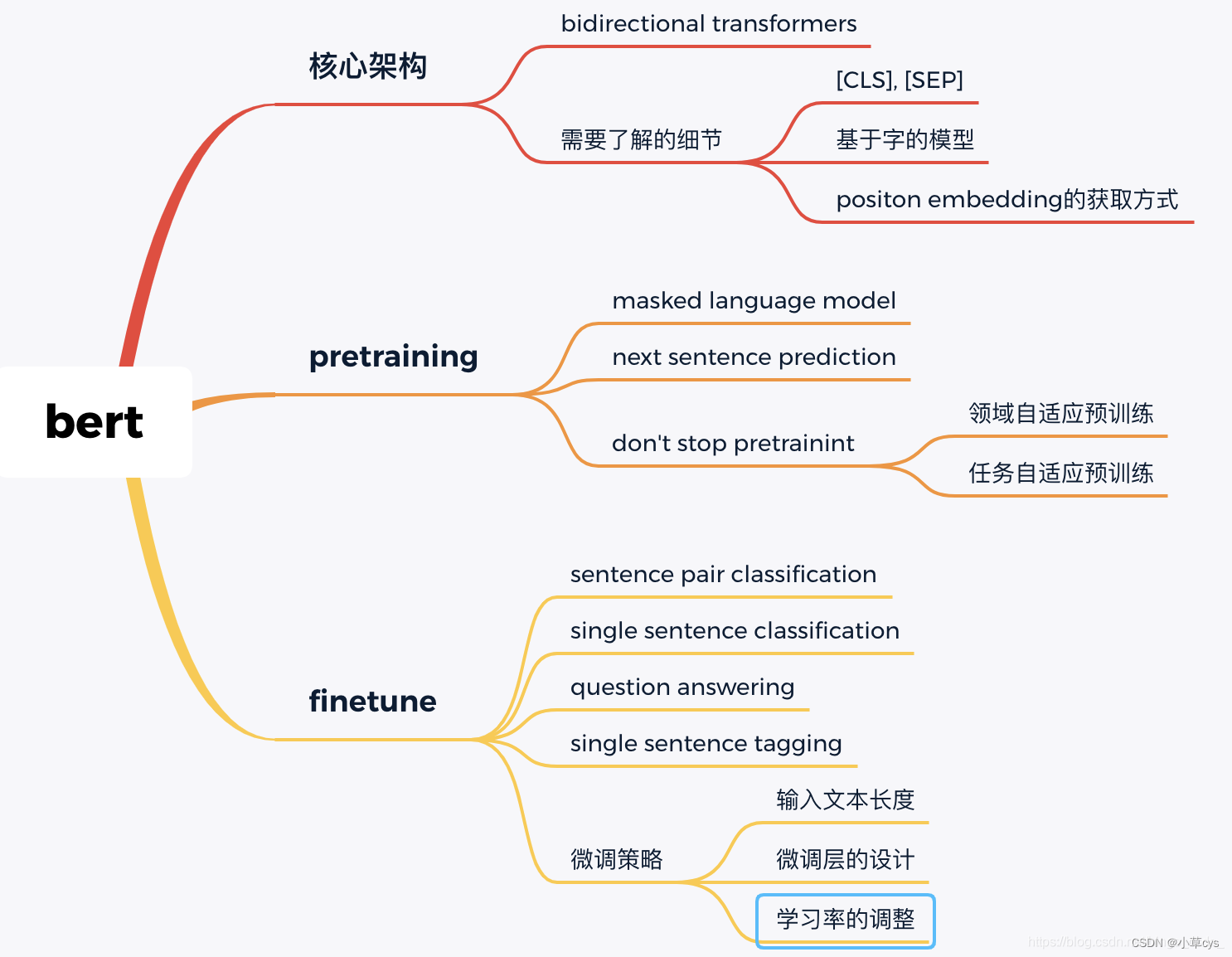

增量预训练也叫领域自适应预训练(domain-adapter pretraining),即在所属领域数据上继续预训练。 主要问题是在增量预训练后可能发生灾难性遗忘。 避免灾难性遗忘主要从以下几个方面入手: 1 领域相关性 增量数据与所选基座模型的原始训练数据尽量一定的相关性。 2 新数据分布与原始数据尽量相似 领域数据和通用数据的比率,结合具体数据:10%,15%,20%的都有。

LLM微调过程中灾难性遗忘问题解决方法

灾难性遗忘是LLM微调过程中最常见的问题,下面是一些解决办法: 将重要的权重冻结:像Lora就是采用的这种方案,只学习部分网络权重。但这里Lora的配置其实是要注意一下,如果你是用Lora做预训练,lora训练模块可以配上 q_proj,v_proj,k_proj,o_proj 如果是微调则只需要训练q_proj,v_proj。lora_rank的设置也有讲究,初始设lora_ran为8,训练存在

【论文极速读】EMT——评估多模态LLM中的灾难性遗忘问题

【论文极速读】EMT——评估多模态LLM中的灾难性遗忘问题 FesianXu 20231001 at Baidu Search Team 前言 论文[1]报告了多模态LLM中遇到的灾难性遗忘问题,并且提出了一种评估其程度的方法EMT,本文简要介绍,希望对读者有所帮助。如有谬误请见谅并联系指出,本文遵守CC 4.0 BY-SA版权协议,转载请联系作者并注明出处,谢谢。 ∇ \nab

谷歌释放改造蚊子 会带来意外的灾难性后果吗?

每次一到夏天,就神烦蚊子,尤其是招蚊子的体质。但是从没想过蚊子还能抑制病毒。 谷歌释放改造蚊子 会带来意外的灾难性后果吗? 据外媒报道,谷歌母公司Alphabet旗下生命科学子公司Verily已经酝酿了一个大计划,即向美国加州弗雷斯诺地区释放大约2000万只改造蚊子。这些蚊子都在实验室中被细菌感染,可以帮助消除寨卡病毒感染。 在弗雷斯诺地区,携带寨卡病毒的伊蚊(Aedesaegypti)十分