更少专题

ICML24麻省理工提出使用更少的条件独立性测试来发现因果关系新方法

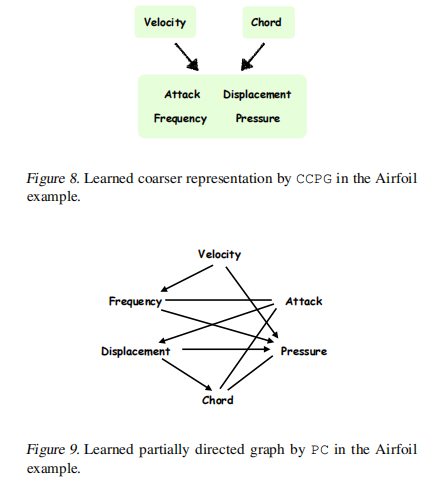

【摘要】众多科学领域的核心问题围绕着理解因果关系这一基本问题。然而,大多数基于约束的因果发现算法,包括广受欢迎的PC算法,通常会进行指数级数量的条件独立性(CI)测试,在各种应用中造成局限。为解决这一问题,我们的工作重点是表征在减少CI测试数量的情况下,可以了解潜在因果图的哪些信息。我们证明,学习一个隐藏因果图的更粗糙表示只需多项式数量的测试。该更粗糙表示,称为因果一致分区图(CCPG),包括

作为开发人员,你需要做的更少,考虑的更多,学会优雅的拒绝

No, no, no, no, and no. And no. A big NO. Clear as that. All you have to do is to bring those two letters together and say the word. Now, let’s say it together. NOOOOOOO! Good start. But wait a m

LLMs之PEFT之Llama-2:《LoRA Learns Less and Forgets LessLoRA学得更少但遗忘得也更少》翻译与解读

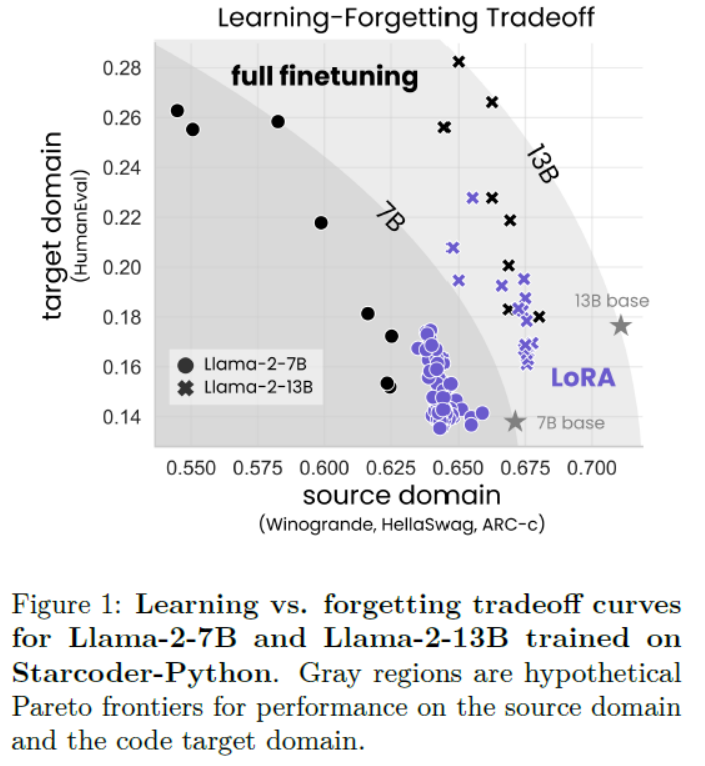

LLMs之PEFT之Llama-2:《LoRA Learns Less and Forgets LessLoRA学得更少但遗忘得也更少》翻译与解读 导读:该论文比较了LoRA与完全微调在代码与数学两个领域的表现。 背景问题:微调大规模语言模型需要非常大的GPU内存。LoRA这一参数高效微调方法通过仅微调选择性权重矩阵的低秩扰动来节省内存。 解决方案:LoRA假设微调后的权重矩阵的变化可以近

厉害的程序员相对于普通程序员,对于完成一个需求来说,除了更少的 bug,还有什么优势?

转自知乎,自己努力的方向! 厉害的程序员从不说『这不当初你让我做的吗?』 厉害的程序员从一开始就能识别出那些不靠谱的需求并说服对方放弃或修改。 如果不能说服对方,厉害的程序员就会在设计中留下变更的接口,不把代码写死。等老板客户产品经理过来需求变更的时候,他们也会面露难色,表示变更需要至少X天时间,等产品经理面带愧色离开后,化X分钟把问题搞定然后花时间去做更有意义的事。所以厉害的程序员

更多的资本更少的初创企业 以色列网络安全行业走向成熟

http://mp.weixin.qq.com/s/qJkc9MgEIu8YiSweo5jKNQ 对于黑客而言,过去的2017年可谓是忙碌异常的一年——从NSA“Vault 7”文档泄漏到WannaCry、NotPetya恶意软件再到Equifax大规模数据泄漏,频发的网络安全事件再次说明了创新网络安全解决方案对于打击网络威胁的重要意义。 就网络安全投资而言,2017年以色列网络安

如何让udhcpc占用更少的内存?

这个问题的表面现象是用system调用的方式执行udhcpc会失败。解释:由于system是通过fork实现的,而子进程会复制父进程的VM空间,当父进程占用较多VM空间,很容易导致system调用失败。其本质是子进程分配VM空间失败导致的。 解决方法:执行:echo 1 > /proc/sys/vm/overcommit_memory即可。 更好的解决办法是不使用system调用方法,而是使用

CSS代码缩写,占用更少的带宽

目录 盒模型代码简写 颜色值缩写 字体缩写 盒模型代码简写 还记得在讲盒模型时外边距(margin)、内边距(padding)和边框(border)设置上下左右四个方向的边距是按照顺时针方向设置的:上右下左。具体应用在margin和padding的例子如下: margin:10px 15px 12px 14px;/*上设置为10px、右设置为15px、下设置为12px、左设置为14

导师的肺腑之言:研究生搞科研一周40小时或更少,拿什么去竞争?

点击上方“视学算法”,选择加"星标"或“置顶” 重磅干货,第一时间送达 本文来源:社科学术圈、量化研究方法 供处于硕博阶段的朋友们参考! 作为你们的老师,我现在每周工作60小时,踏踏实实的60小时。阅读,实践,思考,讨论和请教,周而复始。其实这还不够用,因为我既要独立做这边自己的课题,还要协助各位完成你们的课题。那么对你们的要求降低一些,每周50小时吧。希望是真实而有效率的50小时,思维和四肢都

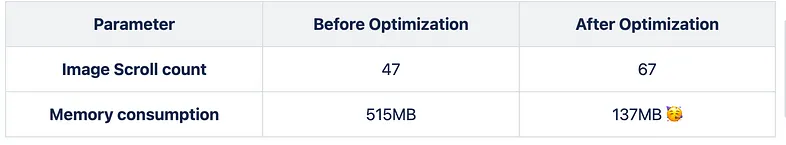

65%更小的APK和70%更少的内存:如何优化我的Android App的内存

65%更小的APK和70%更少的内存:如何优化我的Android App的内存 (Note: This is a translation of the provided title) 为什么应用程序内存很重要? 使用最少的内存的高效应用程序可以提升性能,节省设备资源并延长电池寿命。它们提供流畅的用户体验,并且在应用商店中更受欢迎。这样的应用程序与各种设备兼容。 跟踪内存的方法 我们可

【Android实战】EventBus 更少的代码 更好的体验

简介优点项目实战 需求背景步骤 相关介绍 线程模型订阅优先级以及事件取消粘性事件 总结 简介 事件总线库,极大地简化了 Activities, Fragments, Threads, Services等各组件之间的通信。更少的代码,更好的体检 EventBus的github地址 优点 简化组件之间的通信,对事件的发送者和接收者进行解耦;在Activity、Fr