数据量专题

C#使用SQLite进行大数据量高效处理的代码示例

《C#使用SQLite进行大数据量高效处理的代码示例》在软件开发中,高效处理大数据量是一个常见且具有挑战性的任务,SQLite因其零配置、嵌入式、跨平台的特性,成为许多开发者的首选数据库,本文将深入探... 目录前言准备工作数据实体核心技术批量插入:从乌龟到猎豹的蜕变分页查询:加载百万数据异步处理:拒绝界面

面对Redis数据量庞大时的应对策略

面对Redis数据量庞大时的应对策略,我们可以从多个维度出发,包括数据分片、内存优化、持久化策略、使用集群、硬件升级、数据淘汰策略、以及数据结构选择等。以下是对这些策略的详细探讨: 一、数据分片(Sharding) 当Redis数据量持续增长,单个实例的处理能力可能达到瓶颈。此时,可以通过数据分片将数据分散存储到多个Redis实例中,以实现水平扩展。分片的主要策略包括: 一致性哈希:使用一

【redis】数据量庞大时的应对策略

文章目录 为什么数据量多了主机会崩分布式系统应用数据分离架构应用服务集群架构负载均衡器数据库读写分离 引入缓存冷热分离架构 分库分表微服务是什么代价优势 为什么数据量多了主机会崩 一台主机的硬件资源是有上限的,包括但不限于一下几种: CPU内存硬盘网络… 服务器每次收到一个请求,都是需要消耗上述的一些资源的~~ 如果同一时刻处理的请求多了,此时就可能会导致某个硬件资源不够用了

分库分表:应对大数据量挑战的数据库扩展策略

随着互联网技术的发展,数据量的爆炸性增长给数据库系统带来了前所未有的挑战。为了有效管理大规模数据并保持高性能,分库分表成为了一种常见的数据库扩展策略。本文将探讨分库分表的概念、动机、实施策略以及潜在的挑战和解决方案。 什么是分库分表? 分库分表是一种数据库架构设计策略,它将数据分散存储在多个数据库(分库)和多个表(分表)中。这种方法可以提高数据库的可伸缩性、可用性和性能。 为什么需要分库分表

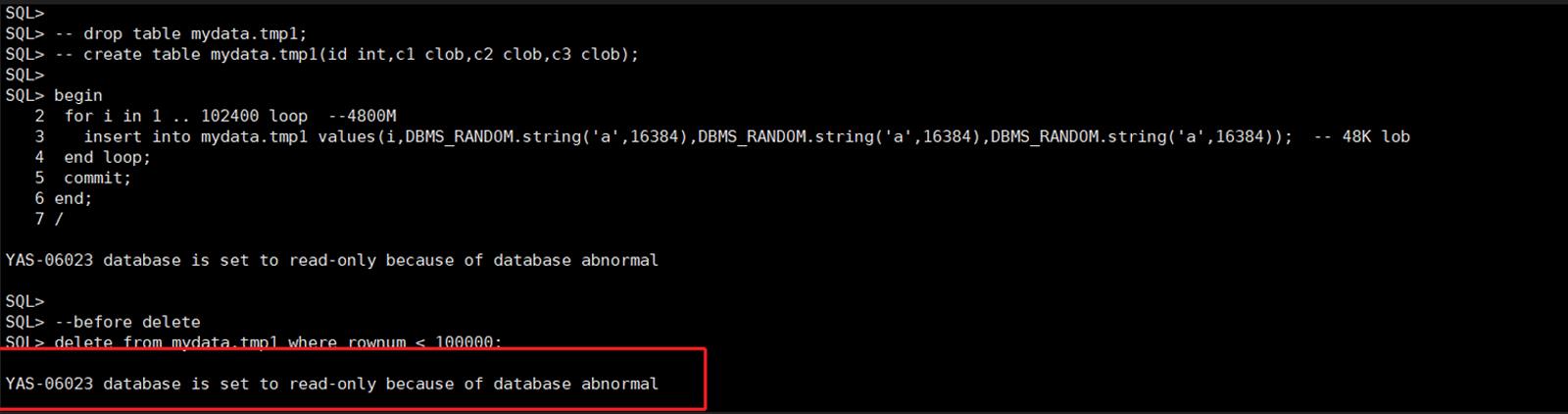

【YashanDB知识库】表数据量不多,lob数据段有大量空间,插入数据报错

问题现象 clob段异常增长,导致磁盘空间满,应用无法使用数据库。 问题风险及影响 lob段空间未复用,lob段空间扩张很大,影响磁盘占用合理分配。 空间不够,插入报错,影响业务。 问题影响的版本 所有版本 问题发生原因 lob类型删除后,空间不会立即复用,需要等待UNDO_RETENTION时间后,空间才会复用。 普通的数据类型表空间段,普通数据被删后插入到undo空间,删除后

Mysql 千万级数据量插入和查询应该怎么优化

关于插入: 宏观上:建二个表,其中一个表不建主键,不键索引。只记录,到了晚上,在把这个表的记录导入 有主键有索引的表里。方法的目的,二表,一表为插入最优化,另一表为查询最优化。 微观上:以下是涉及到插入表格的查询的5种改进方法: 一、使用LOAD DATA INFILE从文本下载数据这将比使用插入语句快20倍。 二、使用多个值表的 INSERT 语句 ,可以大大缩减客户端与

EasyExcel导出数据量大导致内存溢出

一次性读入过多数据,如果内存不够大就会导致内存溢出,所以将数据分批处理,最后在EasyExcel导出的时候再汇总导出。至于接口耗时问题,就需要根据实际调整批次的最大数量。 /*** 全量导出工艺工时* @param response 请求信息*/@Overridepublic void exportEngineeringStandardWorkTime(HttpServletResponse

自然语言处理(NLP)-第三方库(工具包):Faiss【向量最邻近检索工具】【为稠密向量提供高效相似度搜索】【多种索引构建方式,可根据硬件资源、数据量选择合适方式】【支持十亿级别向量的搜索】

一、Faiss介绍 Faiss是Facebook AI团队开源的针对聚类和相似性搜索库,为稠密向量提供高效相似度搜索和聚类,支持十亿级别向量的搜索,是目前最为成熟的近似近邻搜索库。它包含多种搜索任意大小向量集(备注:向量集大小由RAM内存决定)的算法,以及用于算法评估和参数调整的支持代码。Faiss用C++编写,并提供与Numpy完美衔接的Python接口。除此以外,对一些核心算法提供了GPU实

为什么说Volley适合数据量小,通信频繁的网络操作

前言 网络编程对于客户端来说是一块及其重要的地方,使用高效的网络请求框架将为你的系统产生很大的影响。而Volley作为谷歌的一个开源项目,炙手可热。有很多中小型公司的安卓移动客户端的网络程序都是基于volley的。 Volley的优点很多,光可扩展性这一条优点就值得我们称赞。但是我想针对的是在 Google I/O 2013 大会上发布Volley的时候的一句话:a burst or emis

Mysql进行大数据量查询的性能优化

数据库设计方面: 1、对查询进行优化,应尽量避免全表扫描,首先应考虑在 where 及 order by 涉及的列上建立索引。 2、应尽量避免在 where 子句中对字段进行 null 值判断,否则将导致引擎放弃使用索引而进行全表扫描。 如: select id from t where num is null 可以在num上设置默认值0

HDMI的数据量和版本对应

当前2K、4K、8K火热,但是不同的K,有着不同的HDMI版本匹配,不然拿着大炮打蚊子就有些亏了,如下是HDMI的不同K系列数据量和版本对应 参考:https://zhuanlan.zhihu.com/p/116527392

Laravel 大数据量分块处理

User::where(‘status’, 0)->select(array(‘fild1’,‘fild2’)) ->chunkById(100, function ($reslut) { var_dum($reslut); },‘查询排序id’);

Java-使用HashMap压缩重复数据量以减少堆内存溢出的概率

使用 HashMap 压缩重复数据量以减少堆内存溢出的概率 为了减少堆内存溢出的概率,可以通过使用 HashMap 来压缩重复的数据量。这里我们可以通过以 下步骤实现: 创建一个 HashMap:用于存储数据及其出现次数。 遍历原始数据:将数据放入 HashMap 中,并统计每个数据出现的次数。 构建压缩后的数据结构:基于 HashMap 的键值对构建一个新的数据结构,例如 List 或

基于SparkGraphX实现大数据量的Louvain算法(附Scala代码)

基于SparkGraphX实现大数据量的Louvain算法(附Scala代码) 之前针对社群发现类算法有写过一篇用Python实现的面向小数据集的文章,其中也有涉及到Louvain算法的原理,今天这篇将主要专注于借助SparkGraphX实现Louvain算法的实现方案,该方案将更适用于大数据量,并且扩展性较好,集群资源给够就可以支持更大的数据量。不过需要注意的是,图计算框架SparkGraph

oracle 行转列数据量太大报错

wmsys.wm_concat 这个函数存在缺陷,数据量大的时候,容易报ora-22813 没办法只能通过重新定义一个行转列函数,copy了一下 http://www.savedba.com/?p=955 这个人写的函数 有点问题,自己又改了下。 drop type t_dj_concat; drop function dj_concat; create or replace

多维表格/业务库表格大数据量性能瓶颈

先说最终结论:Angular 组件创建性能损耗是当下主要的性能瓶颈 理由: 基于以往编辑器性能优化的经验,编辑器在动态渲染内容时会创建很多壳子组件(也就是Angular 组件),排查的时候就发现如果略这些壳子组件性能可以有一倍的提升,所以有了对编辑器的一次大的性能优化 #TECHW-20 编辑器性能优化:使用 ListRender 渲染列表 ,核心就是自己写列表的渲染去掉中间的壳子组件。 排查业

大数据量列表渲染优化:前端实战经验让性能飙升50%,页面速度提升95%

引言:在处理大规模数据集渲染时,前端性能常常面临巨大的挑战。本文将探讨 react-virtualized-list 库如何通过虚拟化技术和 Intersection Observer,实现前端渲染性能飙升 50% 的突破,页面渲染速度提升 95% !🔥🚀 背景 最近,公司监控系统出现了加载卡顿和白屏问题,需要一个能够处理大规模数据渲染的方案。由于核心需求是列表项数据需要动态更新和自动

高并发大数据量的数据库的设计与优化

1.可以使用静态页面的地方,使用静态页面,减少页面解析时间。 2.尽量使用缓存技术来做。用户缓存、页面缓存等一切缓存,使用特定的机制进行刷新。利用消耗内存空间来换取用户的效率。同时减少数据库的访问次数。 3.使用集群的方式来解决,单台服务器性能的问题 4.使用负载均衡模式,来让每一个服务器资源进行合理的利用 5.资源隔离(springcloud中有两种资源隔离方式–线程池和信号量) 6.

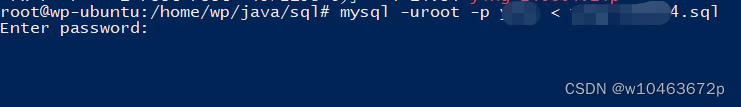

linux部署运维3——centos7下导入导出mysql数据库的sql文件以及查询数据量最大的表信息

在实际项目开发或者项目运维过程中,数据库的导入导出操作比较频繁,如果可以借助第三方工具那当然算喜事一桩;但是如果不允许外部访问,那么就只能使用数据库自带的命令,也是相当方便的。 一.导入sql文件 1.在linux命令下,通过以下命令直接导入(保证mysql的全局命令使用正常) 首先确定导入文件.sql的完整路径,然后替换如下命令相关信息 需要注意的是:命令回车之后需要输入密码即可开始导入

Java架构-亿级网站大数据量下的高并发同步讲解

【原创】 陌霖Java架构 2019-05-06 12:10:00 对于我们开发的网站,如果网站的访问量非常大的话,那么我们就需要考虑相关的并发访问问题了。而并发问题是绝大部分的程序员头疼的问题, 但话又说回来了,既然逃避不掉,那我们就坦然面对吧~今天就让我们一起来研究一下常见的并发和同步吧。 为了更好的理解并发和同步,我们需要先明白两个重要的概念:同步和异步 ** 1、同步和异步的区别和

JDBC postgresql大数据量流式读取

前言: 最近做数据同步,需要从PostgreSql获取数据,发现一旦数据比较多,那么读取的速度非常慢,并且内存占用特别多&GC不掉。 代码样例: 为了方便讲解,下面写了事例代码,从b2c_order获取数据,这个数据表6G左右。 package com.synchro;import java.sql.*;/*** Created by qiu.li on 2015/10/16.

java mybatis处理大数据量,开启和配置二级缓存,及注意事项,已解决

注意事项: 尽量避免使用下面方式写sql否则会降低服务器性能: mybatis二级缓存开启后,避免使用事务注解(加上事务注解后二级缓存数据会导致两次访问不一致问题): 3. 返回的对象实体类,要实现Serializable接口 开始二级缓存配置: 1.配置文件,开启mybatis二级缓存: 3. mapper.xml中编写sql,给指定sql文件配置使用二级缓存,没有cache标签则不

如何使用Redis解决大并发和百万数据量(一)

最近老七开发的一个项目比较频繁的用到了redis,于是抽时间写一个关于redis的系列文章,希望能够帮助到刚入门或者遇到项目出现性能及并发问题的朋友们。 老七是一个不擅长用专业数据表述问题的人,如果文章中出现一些错误啥的,看到文章的朋友们可以给老七提出指正和宝贵的意见。最近老七做的短视频项目由于关注数据激增,单表数据达到了几百万,用户在使用过程中

思源:秒级体验百亿级数据量监控钻取

编者荐语: 当业务量快速增长的时候,业务保障平台就要应运而生,预判问题发出告警,越快越好,从宏观到微观一路下钻响应越快越好,尤其是交易量暴涨的高峰时段。怎么做到?看思源的现身说法: 以下文章来源于云纵达摩院 ,作者刘勤红 ——业务保障平台性能提升走过的那些路 禧云信息/研发中心/刘勤红(思源) 2019年11月 业务保障平台需从多维度去监控业务的可靠性,快速定位问题

PanguSync大数据量初始化脚本

由于数据库增量同步软件PanguSync初始化最大超时时间为600s,如果初始数据量很大,第一次部署时可能会超时,可以先停止任务,使用以下Sql语句进行初始化,以下语句可以分步执行,初始化完成后,后续无需再执行耗时的初始化。 Sqlserver 源操作:1.创建字段alter table 表名 Add C_PanguSyncSourceTimestamp datetime2(6) not n