回归系数专题

python梯度下降法求解三元线性回归系数,并绘制结果

import numpy as np import matplotlib.pyplot as plt # 生成随机数据 np.random.seed(0) X1 = 2 * np.random.rand(100, 1) X2 = 3 * np.random.rand(100, 1) X3 = 4 * np.random.rand(100, 1) y = 4 + 3 * X1 + 5 * X2 +

风控建模 数据对照篇:WOE IV 回归系数 P值 相关系数 共线性指标 膨胀因子 KS AUC GINI PSI

最重要的事情开始都会讲:建模是始终服务于业务的,没有业务的评分卡就没有灵魂 每一个指标段对应的评价如下,就当做各位的参考表数据吧。希望可以对大家有帮助 第一部分 指标图表以及英文简介 第二部分 指标对应参考数据 需要说明的是,由于对应的目标客群不同,可能各个指标所提供标准不同,可能银行和小贷公司对于KS的标准不相同,银行相对严格,小贷公司可能包含其余的策略性规则,因此可能KS相对比较小

sklearn LinearRegression输出线性回归系数,得到回归方程

多元线性回归模型: (训练的时候设μ=0) model.fit(X,y) 训练出一个模型后,sklearn分了两部分存模型系数 model.coef_ # 得到[] model.intercept_ # ,截距,默认有截距 这样就可以写出完整模型啦~

矩阵形式回归系数W推导

前段时间看机器学习实战回归这个章节的内容,在矩阵形式的平方误差推导出回归系数W的的地方,作者直接给出了W 的表达式,当时并没有亲自推导。乍一看很好理解就过去了。后来看论文的过程中,又遇到了类似的推导,在打算自己推导的时候,发现并不容易,主要是并没有学习过矩阵求导的知识。后来在网上看到了矩阵求导的知识,贴在这里: x is a column vector, A is a matrix

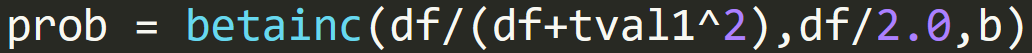

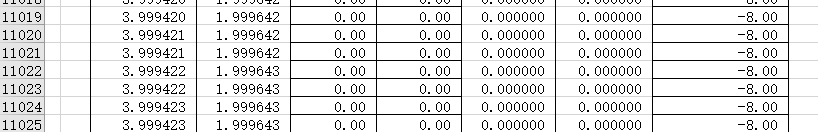

NCL回归系数及显著性检验打点

之前做回归以后,再做显著性检验的时候出现诸多问题,最主要的问题是显著性检验后的区域明显错误。实际上,(我做的是一元回归)应该在回归系数大的地方容易通过检验,回归系数小的地方通不过检验,且我认为通过检验的区域应该不会与回归系数等值线交叉。 经过排查,我发现regCoef给的tval(也就是t参数)并不准确,与我自己构建的t参数并不相同,这就是我一直画不对的原因,因此我用自己的回归系数r,构建了t参

梯度下降算法和牛顿算法原理以及使用python用梯度下降和最小二乘算法求回归系数

梯度下降算法 以下内容参考 微信公众号 AI学习与实践平台 SIGAI 导度和梯度的问题 因为我们做的是多元函数的极值求解问题,所以我们直接讨论多元函数。多元函数的梯度定义为: 其中称为梯度算子,它作用于一个多元函数,得到一个向量。下面是计算函数梯度的一个例子 可导函数在某一点处取得极值的必要条件是梯度为0,梯度为0的点称为函数的驻点,这是疑似极值点。需要注意的是,梯度为0只是函数