历史数据专题

风控系统之指标回溯,历史数据重跑

个人博客:无奈何杨(wnhyang) 个人语雀:wnhyang 共享语雀:在线知识共享 Github:wnhyang - Overview 回顾 默认你已经看过之前那篇风控系统指标计算/特征提取分析与实现01,Redis、Zset、模版方法。 其中已经介绍了如何利用redis的zset结构完成指标计算,为了方便这篇文章的介绍,还是在正式开始本篇之前回顾一下。 时间窗口 zset

StarRocks分区表历史数据删除与管理

一、背景介绍 在使用 StarRocks 时,可能会遇到需要删除大批量数据的情况。然而,StarRocks 对 DELETE 操作的支持并不理想,主要存在以下问题: 不建议执行高频的 DELETE 操作:删除的数据会标记为“Deleted”,暂时保留在 Segment 中,不会立即进行物理删除。Compaction(数据版本合并)完成之后会被回收。查询效率可能降低:执行 DELETE 语句后,

Java如何根据历史数据预测下个月的数据?

现在在 AI 的大环境当中,有很多人解除到关于预测模型,而且现在的客户接触到了 AI 这块的内容之后,也不管现在的项目是什么样子的,就开始让我们开发去做关于预测的的相关内容,今天了不起就来带大家看看如何使用 Java 代码来做预测。 线性回归 线性回归是一种用于建模和分析变量之间关系的统计方法,特别是当一个变量(称为因变量或响应变量)被认为是另一个或多个变量(称为自变量或解释变量)的线性函数时

【迅投qmt系列】2、历史数据获取

1、基本思想 在 xtquant 中,历史数据要先下载(download_history_data)到本地的缓存文件中,之后才能获取(get_market_data)使用。 如果确认之前已经下载过,且数据完整,那么后续使用前可以不用再次下载。 2、常用函数 xtdata.download_history_data() # 下载单个资产的历史数据xtdata.download_histor

初始化大量历史数据时踩过的坑

1.当数据量特别大的时候要注意不要再任务的总方法上加事务,这样会导致整个任务只是用同一个数据库连接,当任务执行时间过长时,连接可能会达到最大可用时长,这个时长的配置在druid连接池表现为下面这几个属性。当连接达到最大可用时长而事务仍然没有提交时,连接池会删除这个连接,从而导致任务执行失败。 <!-- 打开removeAbandoned功能 --><property name="rem

Flink cdc如何只进行增量同步,不同步历史数据(只读取binlog)

环境 flink: 1.15.3 flink-connector-mysql-cdc: 2.4.0 场景: mysql cdc到starrocks, 目前线上环境以及有老的任务在同步,现在升级了任务(旧checkpoints无法使用)旧表里面数据特别大,不方便重新同步 方案 思考:表里面的旧数据放着不动,只从binlog同步最新的数据。 解决 https://nightlies.ap

数据治理 - 数据仓库历史数据存储 - 拉链表

什么是拉链表 拉链表是针对数据仓库设计中表存储数据的方式而定义的,顾名思义,所谓拉链,就是记录历史。记录一个事物从开始,一直到当前状态的所有变化的信息。 我们先看一个示例,这就是一张拉链表,存储的是用户的最基本信息以及每条记录的生命周期。我们可以使用这张表拿到最新的当天的最新数据以及之前的历史数据。 注册日期用户编号手机号码t_start_datet_end_date2017-01-0

sentry磁盘占用过大如何清理历史数据

参考:https://www.phpmianshi.com/?id=182 1、SENTRY数据软清理 (清理完不会释放磁盘,如果很长时间没有运行,清理时间会很长) #登录worker容器docker exec -it sentry_onpremise_worker_1 /bin/bash #保留多少天的数据,cleanup使用delete命令删除postgresql数据,但对于delet

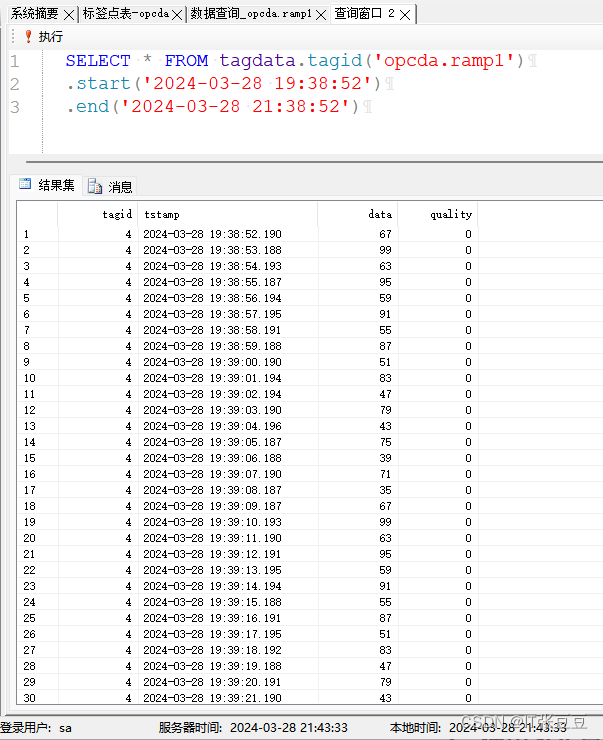

正弦实时数据库(SinRTDB)的使用(5)-历史数据查询

前文已经将正弦实时数据库的使用进行了介绍,需要了解的可以先看下面的博客: 正弦实时数据库(SinRTDB)的安装 正弦实时数据库(SinRTDB)的使用(1)-使用数据发生器写入数据 正弦实时数据库(SinRTDB)的使用(2)-接入OPC DA的数据 正弦实时数据库(SinRTDB)的使用(3)-用户管理 正弦实时数据库(SinRTDB)的试用(4)-快照查询 若需要试用正弦实时数据

正弦实时数据库(SinRTDB)的使用(5)-历史数据查询(一)

前文已经将正弦实时数据库的使用进行了介绍,需要了解的可以先看下面的博客: 正弦实时数据库(SinRTDB)的安装 正弦实时数据库(SinRTDB)的使用(1)-使用数据发生器写入数据 正弦实时数据库(SinRTDB)的使用(2)-接入OPC DA的数据 正弦实时数据库(SinRTDB)的使用(3)-用户管理 正弦实时数据库(SinRTDB)的试用(4)-快照查询 若需要试用正弦实时数据

量化交易入门(十八)回测历史数据获取方法

前文提到的stock.csv 文件通常包含股票的历史价格数据,每行代表一个交易日的数据。典型的数据格式如下: 日期,开盘价,最高价,最低价,收盘价,成交量2021-01-01,100.00,105.00,99.00,103.00,10000002021-01-02,103.50,107.00,102.00,105.50,12000002021-01-03,106.00,110.00,105

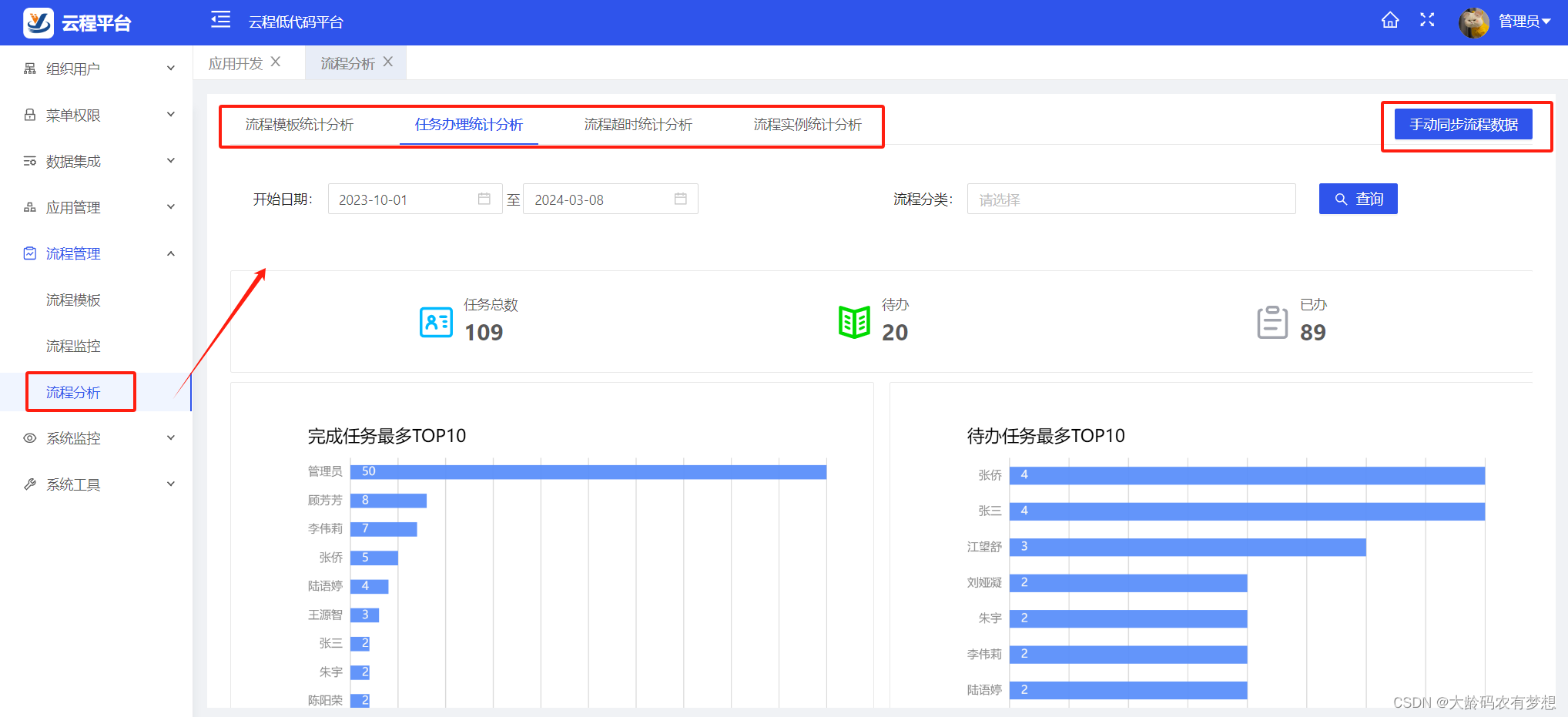

Camunda7历史记录级别配置和历史数据清理

camunda工作流引擎中有好多以ACT_HI_*开始的数据库表,HI代表历史。这些表包含历史数据,如过去的流程实例、变量、任务等。camunda详细数据库表结构介绍见:https://blog.csdn.net/wxz258/article/details/136442339。 camunda流程引擎内部有历史记录事件流的机制,在流程执行过程中,会产生大量的历史数据,这些历史数据可以通过历史记

最新最全双色球历史数据【2013001至2024022】

上一篇文章,给大家分享了福彩历史数据采集器和体彩历史数据采集器的详细安装使用步骤。 文章链接地址:关于福彩历史数据采集器和体彩历史数据采集器的下载安装说明-CSDN博客 很多彩友看到后,给我发了很多私信,有的是让我指导安装插件后如何下载历史数据,有的彩友是直接让我把采集好的历史数据发给他们,这样就省去安装插件的环节了。鉴于有很多彩友有这样的需求,本人特

Python获取股票历史数据和收盘数据的代码实现

http://casey.blog.51cto.com/9994043/1707905 各种股票软件,例如通达信、同花顺、大智慧,都可以实时查看股票价格和走势,做一些简单的选股和定量分析,但是如果你想做更复杂的分析,例如回归分析、关联分析等就有点捉襟见肘,所以最好能够获取股票历史及实时数据并存储到数据库,然后再通过其他工具,例如SPSS、SAS、EXCEL或者其他高级编程语言连接数据库获取

期货指数接口 php,新浪期货数据接口 API 实时数据/历史数据

新浪期货数据接口 返回值如下: var hq_str_M0="豆粕连续,145958,3170,3190,3145,3178,3153,3154,3154,3162,3169,1325,223,1371608,1611074,连,豆粕,2013-06-28"; ---------------------------------------------------------- 查看 http:/

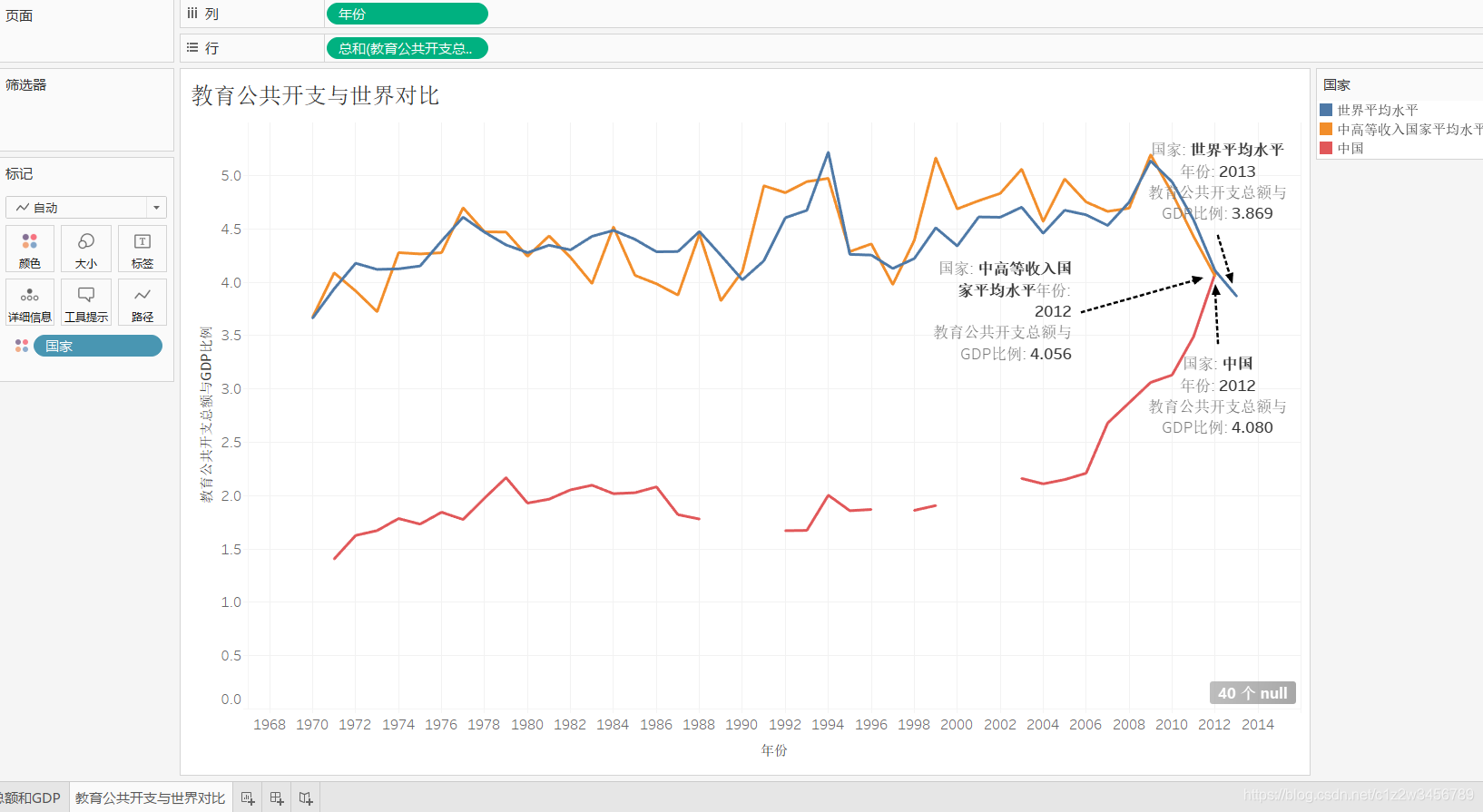

Tableau 中国教育水平发展指标历史数据(二)教育公共开支与世界对比

关注微信公共号:小程在线 关注CSDN博客:程志伟的博客 数据集见微信公共号链接 导入数据集 中国教育水平发展指标历史数据统计 a.在Tableau中,新建第二张工作表; 将年份放入列中,将教育公共开支总额与GDP比例字段放入行中; 将国家字段拖入颜色中,将中国设置为红色、世界平均水平设置为蓝色、中高等收入国家平均水平为黄色。

历史数据入库,共80G,都是文件怎么办?通过命令提取目录或文件路径

1:在提取文件根目录放一个list.bat 内容是dir/b/on >list.txt 保存后双击,等命令窗口自己关闭就结束了 这个方法提取的文件是逐级存放的,会有好多文件目录 2:想直接获取文件全路径,不带无用的目录,用下面的命令,记住里面不能有中文 使用命令行的findstr命令 例如要得到d:\a1目录下的所有文件的路径及其名称,并将结果放入c:\1.txt文件。启动CMD命令行,

MT5客户端CTP接入 国内期货之二 自定义交易品种 历史数据导入

方法1: 界面插入历史数据 1. 选中产品与数据周期 2 选择历史数据文件 将数据插入 3. 查看导入历史数据情况 切换1小时周期 数据自然推算出来 good! 4. K线效果图 手工导入成功 此方法适合品种比较少的数据导入,而且历史数据源历史足够长的情况, 如果1分数据短,无法生成足够的其他周期数据,需要各个周期分别导入 方法二: 程序化导

【大数据开发运维解决方案】Ogg For Bigdata 同步Oracle数据到KAFKA(包括初始化历史数据)

OGG同步Oracle数据到KAFKA:OGG初始化进程初始化历史数据 在前面曾写过几篇关于OGG同步Oracle等库数据到kafka的文章: OGG实时同步Oracle数据到Kafka实施文档(供flink流式计算) OGG For Bigdata 12按操作类型同步Oracle数据到kafka不同topic 但是那都是做测试,没有说实际工作情况下如何将Oracle等库表的历史数据初始化到ka

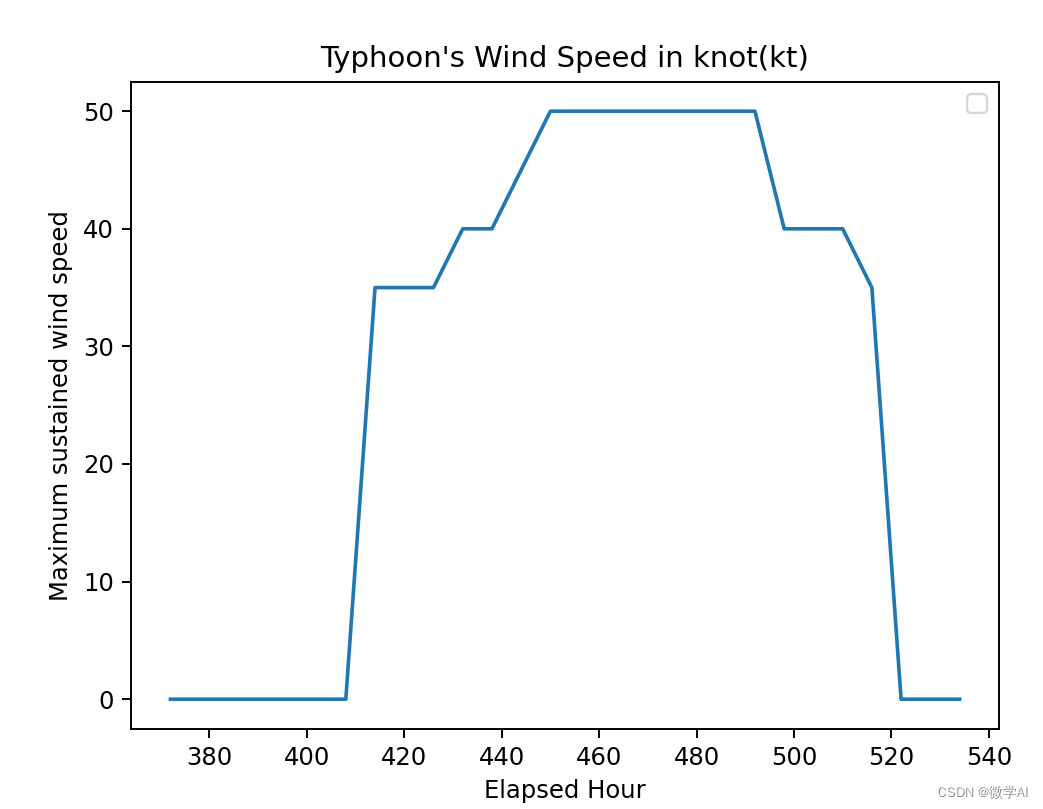

机器学习实战12-基于历史数据的台风的预测与分析(2023年第5号台风杜苏芮将登陆福建)

大家好,我是微学AI,今天给大家介绍一下机器学习实战12-基于历史数据的台风的预测与分析,台风预测与分析是一项重要的气象研究项目,旨在提前预测、跟踪和分析台风的路径、强度和可能对地区造成的影响。台风是一种强大而具有破坏性的气象灾害,经常给沿海地区带来巨大的风暴潮、暴雨和强风,并导致洪涝、山体滑坡等次生灾害。 2023年7月21日上午8时,今年第5号台风“杜苏芮”在菲律宾以东洋面生成。当天下午5时

两步实现清理VOS客户端中历史数据

1.登录VOS3000客户端 在VOS系统实际使用过程中,会产生各种数据,什么每日话单、各种数据报表、缴费记录、系统日志、告警信息等等,久而久之数据越来越多,会特别占磁盘空间,那么在VOS客户端中怎么清理呢?接下来我们一起来看看。 2.打开“系统管理 > 数据维护” 登录上VOS系统之后,在导航栏点击“系统管理”,选择“数据维护”,点击进去之后可以看到有很多数据选项,左边导航栏处有数

清理 zabbix 历史数据, 缩减 mysql 空间

zabbix 由于历史数据过大, 因此导致磁盘空间暴涨, 下面是结局方法步骤 1. 停止 ZABBIX SERER 操作 [root@gd02-qa-plxt2-nodomain-web-95 ~]# killall zabbix_server[root@gd02-qa-plxt2-nodomain-web-95 ~]# lsof -i:10051 2

ifix历史数据(H04/H08/H24)转换为CSV文件导出

在最近的一次环保数据维护中,由于自己疏忽导致数据库中TP值并未有效记录,还好历史趋势有相关记录,问题是我该如何将.H24文件记录导出?在逛论坛后,无意发现一款工具解决了我的燃眉之急-HTD2CSV.exe,一款大牛写的工具。特此使用,供大家参考。 1.使用要点 该工具有两种使用方法: 1.使用HTD2CSV.grf 2.使用cmd命令。 亲测使用第一种方法成功导出。 2.使用过

python量化分析系列(第一篇)_金融量化分析-python量化分析系列之---使用python的tushare包获取股票历史数据和实时分笔数据...

财经数据接口包tushare的使用(一) Tushare是一款开源免费的金融数据接口包,可以用于获取股票的历史数据、年度季度报表数据、实时分笔数据、历史分笔数据,本文对tushare的用法,已经存在的一些问题做一些介绍。 一:安装tushare 为避免由于依赖包缺失导致安装失败,请先安装anaconda,百度网盘地址: 链接:http://pan.baidu.com/s/1qYDQUGs

超简单C++ 获取股票历史数据自动缓存本地二进制加速访问,省心 更新至2021-07-09

目前全网没有一个专门提供C++访问股票接口并专门提供给仅仅使用历史数据的人的资源 本资源付费获取源码,有需要的联系我本人(首页微信)。 2021-07-09最新版本上传到百度云可下载2019-08-03 增加当日数据获取: 市盈率、市净率 2019-07-21自动缓存本地 2019-09-01 2019-09-04 2019-09-05 2019-09-08(去掉了map) 支持全部历史