刘知远专题

【清华大学】《自然语言处理》(刘知远)课程笔记

自然语言处理基础(Natural Language Processing Basics, NLP Basics) 自然语言处理( Natural Language Processing, NLP)是计算机科学领域与人工智能领域中的一个重要方向。它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法。自然语言处理是一门融语言学、计算机科学、数学于一体的科学。因此,这一领域的研究将涉及自然

刘知远团队大模型技术与交叉应用L6-基于大模型文本理解和生成介绍

介绍 NLP的下游运用可以分为:NLU(理解)和NLG(生成) 信息检索:NLU 文本生成:NLG 机器问答:NLU+NLG 大模型在信息检索 大模型在机器问答 大模型在文本生成 信息检索-Information Retrieval (IR) 背景 谷歌搜索引擎目前同时集成了文档排序和问答系统。 定义和评测 如何定义IR任务 IR系统分为两个阶段: Retr

[学习笔记]刘知远团队大模型技术与交叉应用L4-Prompt-learning Delta-learning

Prompt-Learning and Delta-Tunning 背景和概览 但是从T5开始,大模型越来越大了。 微调很难了。 模型的趋势 Model Scaling:模型越来越大 Difficult Tuning:微调越来越难 Prompt-Learning 基本组成与流程介绍 预训练和fine-tuning有一定的gap。毕竟是不同的任务。 通过额外增加模版。 映射到标签

刘知远LLM入门到实战——自然语言基础

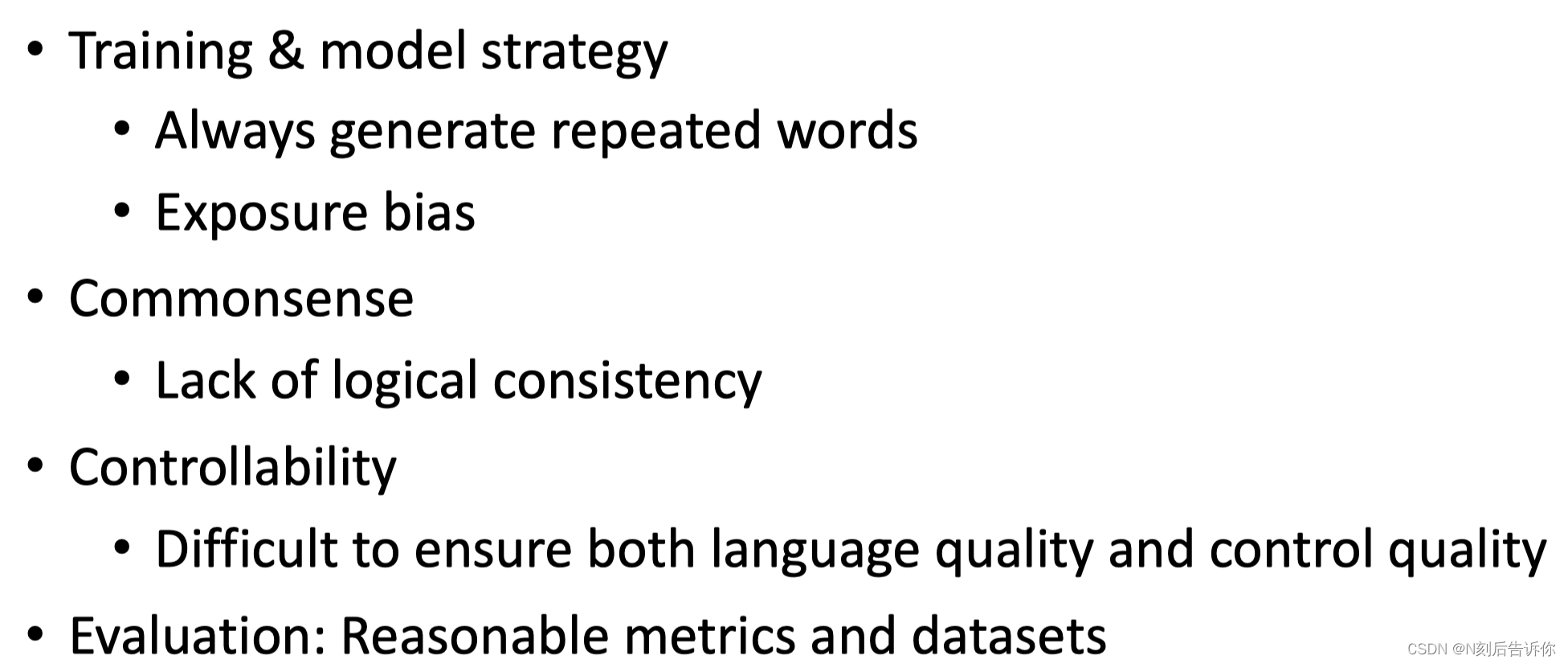

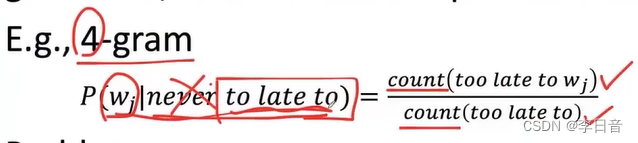

文章目录 自然语言处理基础词表示语言模型N-gram ModelNeural Language Model: 为什么NLP等领域的模型越来越大? 大模型会带来哪些新的范式和挑战? 自然语言处理基础 让计算机理解人类语言,图灵测试就是基于对话的方式。 研究历史:2011年IBM Watson DeepQA在线问答节目战胜所有人类基本任务:词性标注(动词、名词、形容词)

[学习笔记]刘知远团队大模型技术与交叉应用L2-Neural Network Basics

本节首先介绍神经网络的一些基本构成部分。然后简要介绍神经网络的训练方式。介绍一种基于神经网络的形成词汇的向量表示的方法。接下来继续介绍常见的神经网络结构:RNN和CNN。最后使用PyTorch演示一个NLP任务的一个完整训练的Pipeline。 神经网络的基本组成 单个神经元 (人工)神经元接受n个输入,1个输出。由参数w、b以及激活函数f来构成。 单层神经网络 多个单个神经元组成单层

[学习笔记]刘知远团队大模型技术与交叉应用L1-NLPBig Model Basics

本节主要介绍NLP和大模型的基础知识。提及了词表示如何从one-hot发展到Word Embedding。语言模型如何从N-gram发展成预训练语言模型PLMs。然后介绍了大模型在NLP任务上的表现,以及它遵循的基本范式。最后介绍了本课程需要用到的编程环境和GPU服务器。 一篇NLP方向的综述推荐 Advances in Natural Language Processing - Julia

![[学习笔记]刘知远团队大模型技术与交叉应用L4-Prompt-learning Delta-learning](https://img-blog.csdnimg.cn/direct/8bf42d97867c4bad9d98d9d38293c26a.png)

![[学习笔记]刘知远团队大模型技术与交叉应用L2-Neural Network Basics](https://img-blog.csdnimg.cn/direct/fe9ee01785324ed2be6756d2567b4289.png)

![[学习笔记]刘知远团队大模型技术与交叉应用L1-NLPBig Model Basics](https://img-blog.csdnimg.cn/direct/8cda58fa1f5a435babaf16db33637321.png)