withcolumn专题

PySpark withColumn更新或添加列

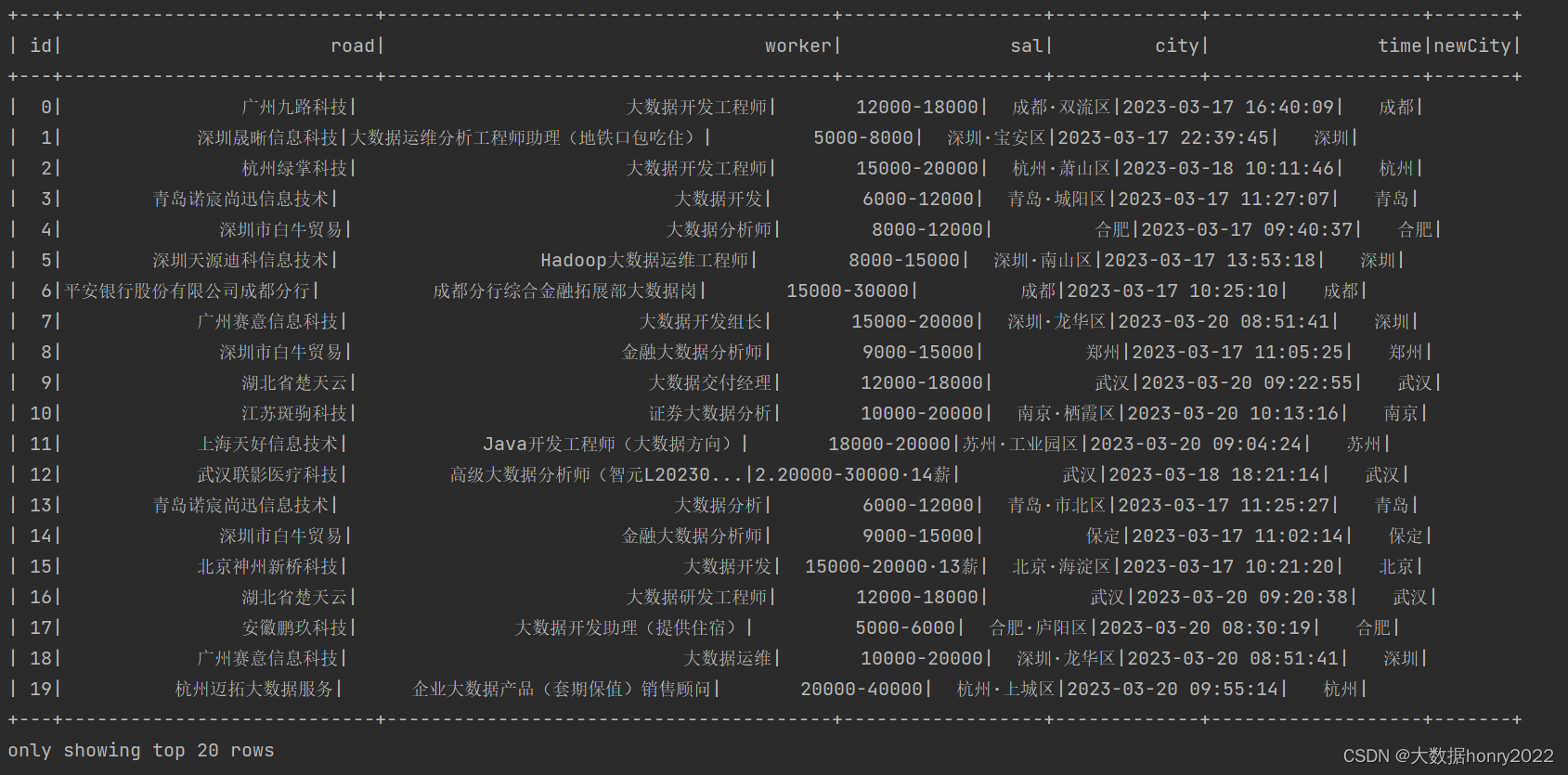

原文:https://sparkbyexamples.com/pyspark/pyspark-withcolumn/ PySparkwithColumn()是DataFrame的转换函数,用于更改或更新值,转换现有DataFrame列的数据类型,添加/创建新列以及多核。在本文中,我将使用withColumn()示例向您介绍常用的PySpark DataFrame列操作。 PySpark wit

spark Scala中dataframe的常用关键字:withColumn

withColumn关键字: 用于操作dataframe原表某一列的数据,将操作完的每一行数据形成一列,用来替换一个表原有的列或者在原表后面追加新的列! 语法如下: def withColumn(colName: String, col: Column): DataFrame withColumn传入两个参数: 先说第二个参数: 该参数传入的是操作d

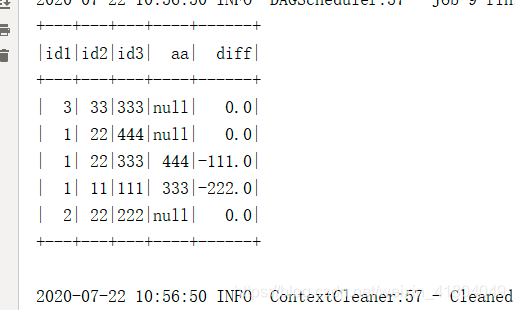

用spark获取前一行数据,DF.withColumn(colName,lag(colName,offset).over(Window.partitionBy().orderBy(desc())))

数据: 1,11,1112,22,2223,33,3331,22,3331,22,444 代码: package com.emg.etp.analysis.preproces.nullphotoimport com.emg.etp.analysis.preproces.nullphoto.pojo.EcarDataimport org.apache.spark.{SparkConf