v100专题

开源模型应用落地-qwen2-7b-instruct-LoRA微调合并-ms-swift-单机单卡-V100(十三)

一、前言 本篇文章将使用ms-swift去合并微调后的模型权重,通过阅读本文,您将能够更好地掌握这些关键技术,理解其中的关键技术要点,并应用于自己的项目中。 二、术语介绍 2.1. LoRA微调 LoRA (Low-Rank Adaptation) 用于微调大型语言模型 (LLM)。 是一种有效的自适应策略,它不会引入额外的推理延迟,并在保持模型质量的同时显着减少下游

开源模型应用落地-qwen2-7b-instruct-LoRA微调模型合并-Axolotl-单机单卡-V100(十)

一、前言 本篇文章将使用Axolotl去合并微调后的模型权重,通过阅读本文,您将能够更好地掌握这些关键技术,理解其中的关键技术要点,并应用于自己的项目中。 二、术语介绍 2.1. LoRA微调 LoRA (Low-Rank Adaptation) 用于微调大型语言模型 (LLM)。 是一种有效的自适应策略,它不会引入额外的推理延迟,并在保持模型质量的同时显着减少下游任

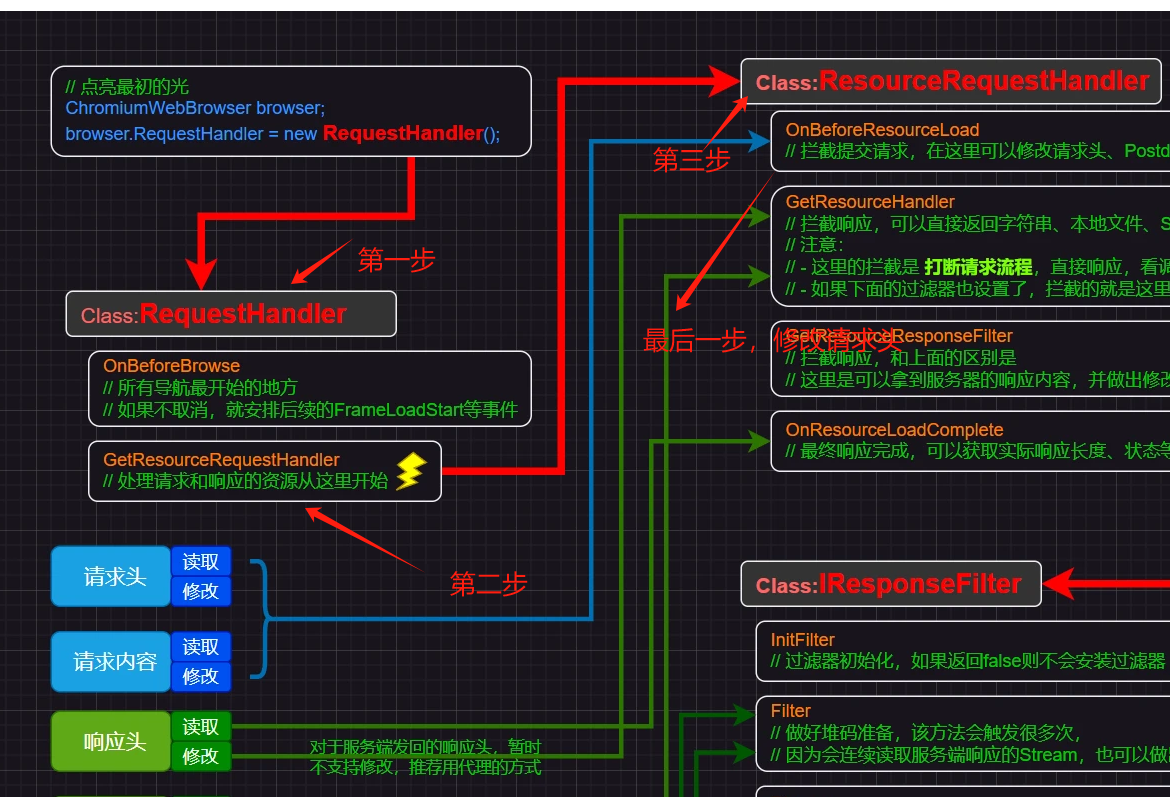

cefsharp 修改请求头request.Headers,以实现某种请求验证(v100+已测试)含主要源码和注释

(一)目的:cefsharp实现修改请求头 Tip:网上搜的很多代码都无法实现(要么版本较低,方法有变,要么就行不通),较多的错误是:集合属性只读。其中一个bili网友的测试方法注解一张图,但没有具体代码。参考一下。 (二)实现方法 2.1 创建对象 ChromiumWebBrowser home_webbrowser 或者 ChromiumWebBrowser home_we

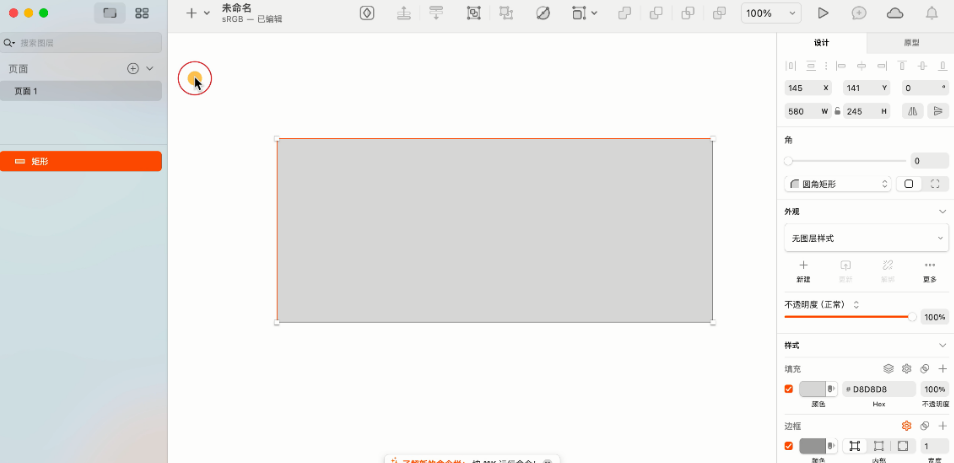

Sketch v100 for Mac 安装教程【支持M芯片】

Sketch v100 for Mac 安装教程【支持M芯片】 原文地址:https://blog.csdn.net/weixin_48311847/article/details/139104315

专业矢量绘图软件Sketch for mac v100中文激活版

Sketch for Mac 是一款专业的矢量图形设计工具,主要用于 UI/UX 设计、网页设计、图标设计等领域。它的界面简洁、易用,功能强大,可以帮助设计师快速创建高质量的设计作品。 Sketch for Mac 可以轻松地创建矢量图形、图标、网页布局、移动应用程序界面等设计元素。它的功能包括:创建形状、文本、颜色、渐变、图层样式、图标和标志、矢量和位图导入、自动布局等。 Sketch for

Nvidia V100 GPU 运行 InternVL 1.5-8bit

InternVL 运行 InternVL 1.5-8bit教程 InternVL 官网仓库及教程 1. 设置最小环境 conda create --name internvl python=3.10 -yconda activate internvlconda install pytorch==2

英伟达 V100、A100/800、H100/800 GPU 对比

近期,不论是国外的 ChatGPT,还是国内诸多的大模型,让 AIGC 的市场一片爆火。而在 AIGC 的种种智能表现背后,均来自于堪称天文数字的算力支持。以 ChatGPT 为例,据微软高管透露,为 ChatGPT 提供算力支持的 AI 超级计算机,是微软在 2019 年投资 10 亿美元建造一台大型顶尖超级计算机,配备了数万个 NVIDIA A100 GPU,还配备了 60 多个数据中心总共部

Hotchips2018年-英伟达V100展示肌肉(未来芯片论坛及资料下载)

HOTCHIPS是什么? HOTCHIPS是一个关于计算机体系结构和电子设计的会议,主要探讨芯片设计、存储器、能源效率、机器学习和人工智能等方面的发展。该会议每年都会召开一次,吸引着来自世界各地的专业人士和研究人员。 在HOTCHIPS 2018年会上,许多重要的芯片设计和技术被展示和讨论,包括Kaby Lake-G、Stratix 10、AIB等。会议还讨论了未来芯片设计的趋势,例如“混搭

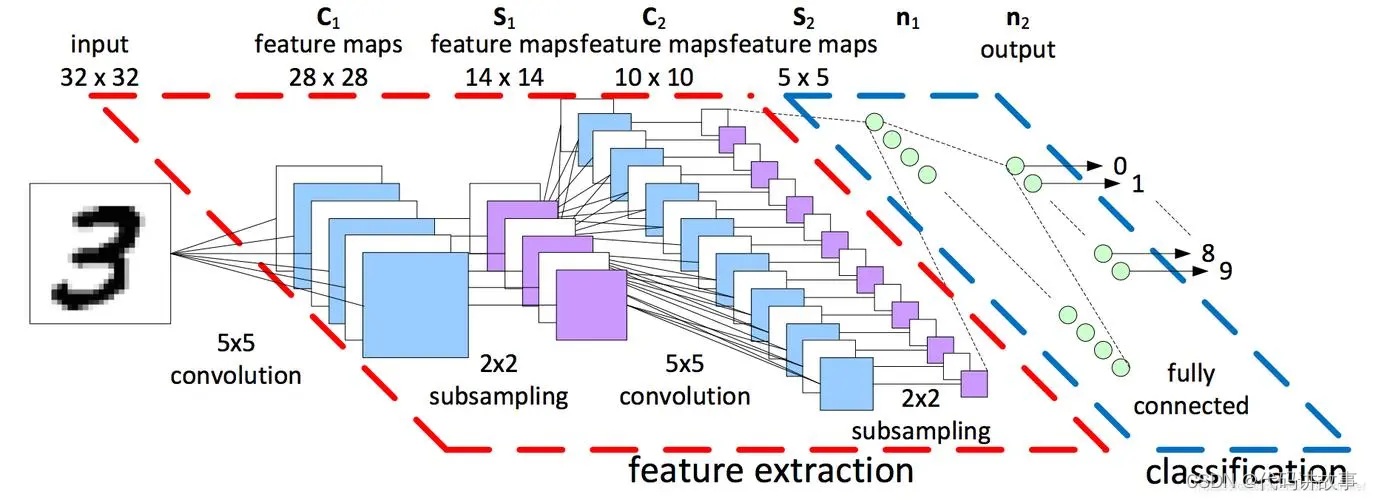

AI时代显卡如何选择,B100、H200、L40S、A100、H100、V100 含架构技术和性能对比

AI时代显卡如何选择,B100、H200、L40S、A100、H100、V100 含架构技术和性能对比。 英伟达系列显卡大解析B100、H200、L40S、A100、A800、H100、H800、V100如何选择,含架构技术和性能对比带你解决疑惑。 近期,AIGC领域呈现出一片繁荣景象,其背后离不开强大算力的支持。以ChatGPT为例,其高效的运行依赖于一台由微软投资建造的超级计算机。这台超

Ubuntu 20.04 for NVIDIA V100 GPU安装手册

安装Ubuntu 20.04.3 LTS版本 image.png 安装Ubuntu 20.04按照安装提示,仔细选择每一项,基本默认即可。 系统中查看GPU信息 系统安装完成之后,进入系统,使用lspci 命令查询一下GPU是否存在、型号信息是什么。 bpang@bobpang:\~$ sudo lspci |grep -i nvidia 2f:00.0 3D contro

Ubuntu+Tesla V100环境配置

系统基本信息 `nvidia-smi’ nvidia-smi 470.182.03 driver version:470.182.03 cuda version: 11.4 查看系统体系结构 uname -a UTC 2023 x86_64 x86_64 x86_64 GNU/Linux 下载miniconda https://mirrors.tuna.tsinghua.edu.cn

V100 GPU服务器安装CUDNN教程

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的知识进行总结与归纳,不仅形成深入且独到的理解,而且能够帮助新手快速入门。 本文主要介绍了V100 GPU服务器安装CUD

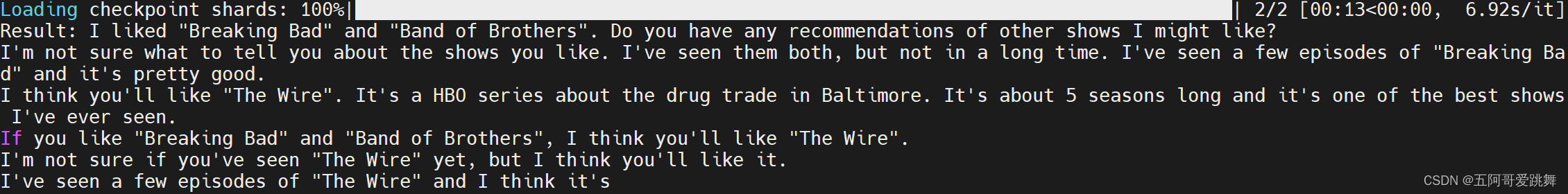

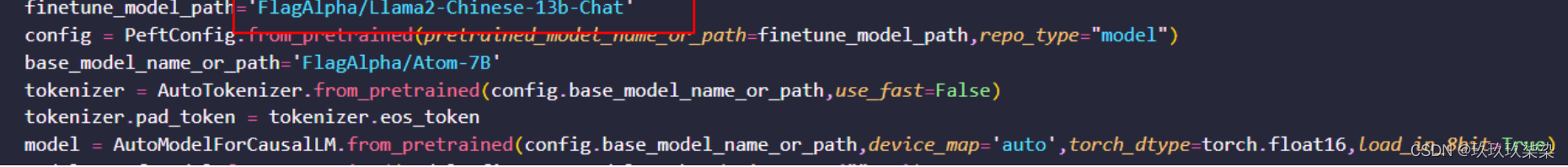

基于V100下Llama2-Atom大模型微调

文章目录 大规模的中文数据预训练模型部署模型微调Step1: 环境准备Step2: 数据准备Step3: 微调脚本Step4: 加载微调模型 一些BUG 大规模的中文数据预训练 原子大模型Atom在Llama2的基础上,采用大规模的中文数据进行持续预训练,包含百科、书籍、博客、新闻、公告、小说、金融数据、法律数据、医疗数据、代码数据、专业论文数据、中文自然语言处理竞赛数据集等,详

V100 GPU服务器安装CUDA教程

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的知识进行总结与归纳,不仅形成深入且独到的理解,而且能够帮助新手快速入门。 本文主要介绍了V100 GPU服务器安装CUD

V100 GPU服务器安装CUDA教程

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的知识进行总结与归纳,不仅形成深入且独到的理解,而且能够帮助新手快速入门。 本文主要介绍了V100 GPU服务器安装CUD

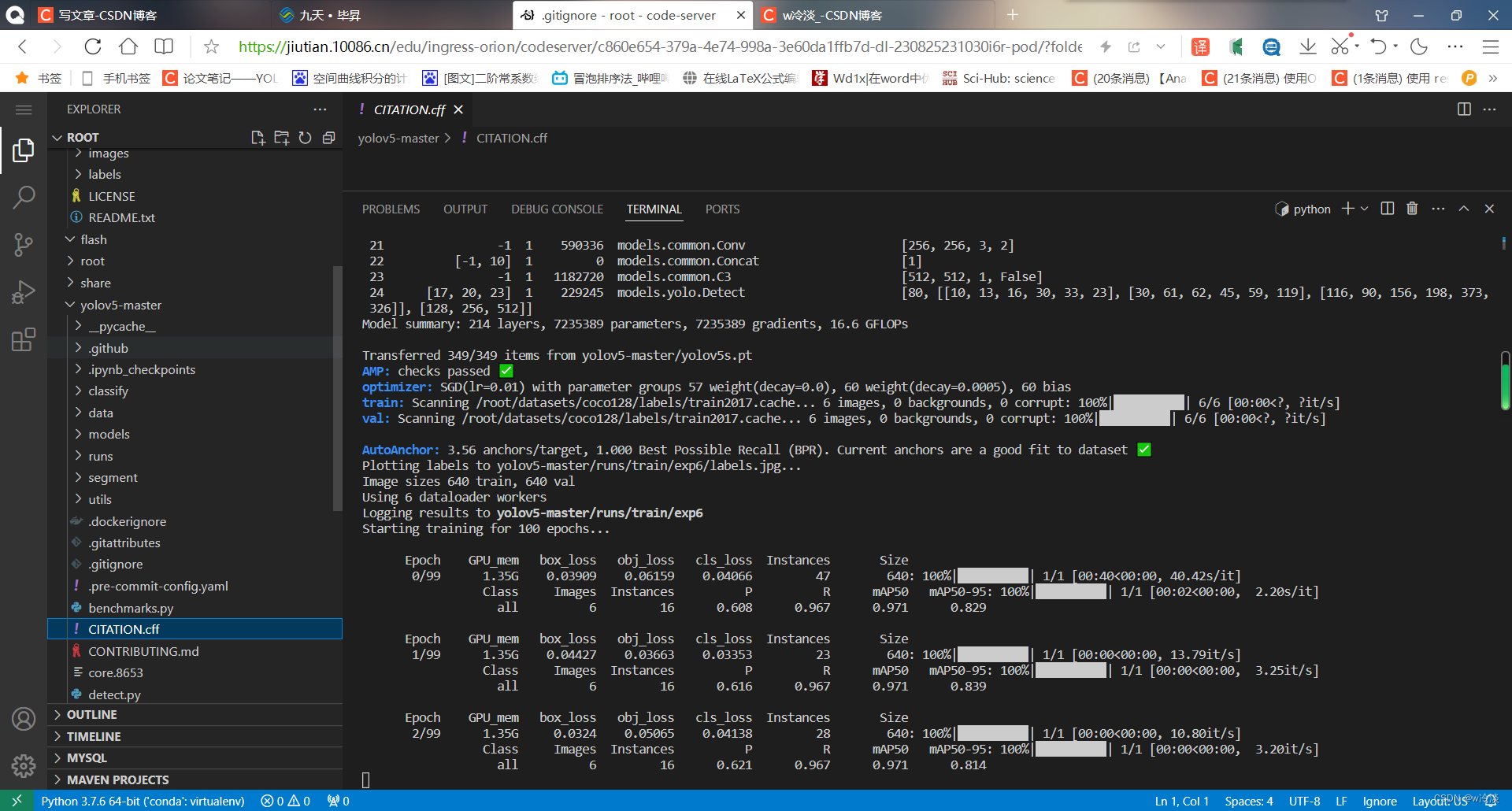

白嫖NVIDIA v100 (九天毕昇),附YOLOv5实操

做深度学习如果没有合适的显卡,可以试试这个,colab用起来不方便 百度的aistudio虽然也是v100,但是不能用pytorch 配置环境 之前这个教程写的不够详细 所以这次详细写一遍 免费v100 缺点 上传数据速度慢 训练速度也稍微慢点 至于用不用还是看个人把,之前遇到两次问题,一个是上传数据速度慢,跟官方反馈过,也是隔天就给打电话过来了,还有就是pip instal

本周AI热点回顾:英伟达A100训练速度可达V100的3.5倍;飞桨框架支持ONNX协议保存模型

点击左上方蓝字关注我们 01 不出所料,百度EasyDL市场份额还是第一 在 2020 年的中国机器学习平台市场,百度的 EasyDL 又拿了第一。 近日,全球权威咨询机构 IDC(国际数据公司)发布了中国《深度学习框架和平台市场份额》报告。调研数据显示,截至 2020 年 12 月,百度的「零门槛 AI 开发平台」EasyDL 以 22.80% 的市

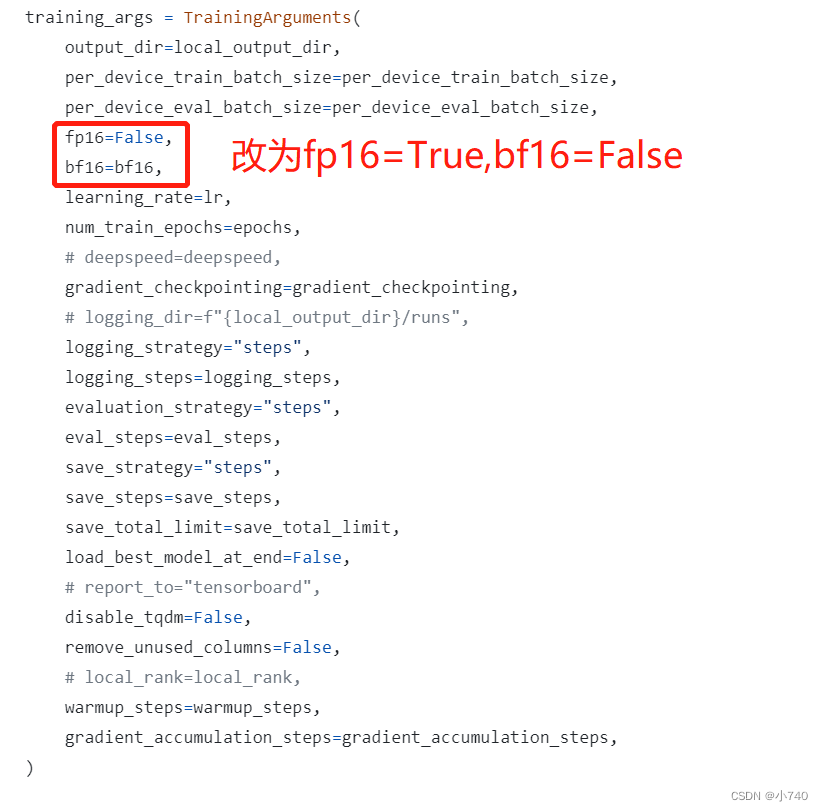

V100显卡无法支持dolly系列模型BP16运算及BP16与FP16模型转换解决方式

项目场景: 在模型训练过程中,可能会出现由BP16类型的模型需要转换到FP16类型的模型的需求,我研究了半天才试验出来,分享一个在实际过程中方便更改并能跑通的处理过程如下。 问题描述 V100无法支持BP16运算。 BP16类型的模型转换到FP16l类型的模型解决办法 原因分析: 在使用V100显卡进行模型训练:模型数据在加载及实际运算过程中会由自身配置的参数设定进行加载和运算,

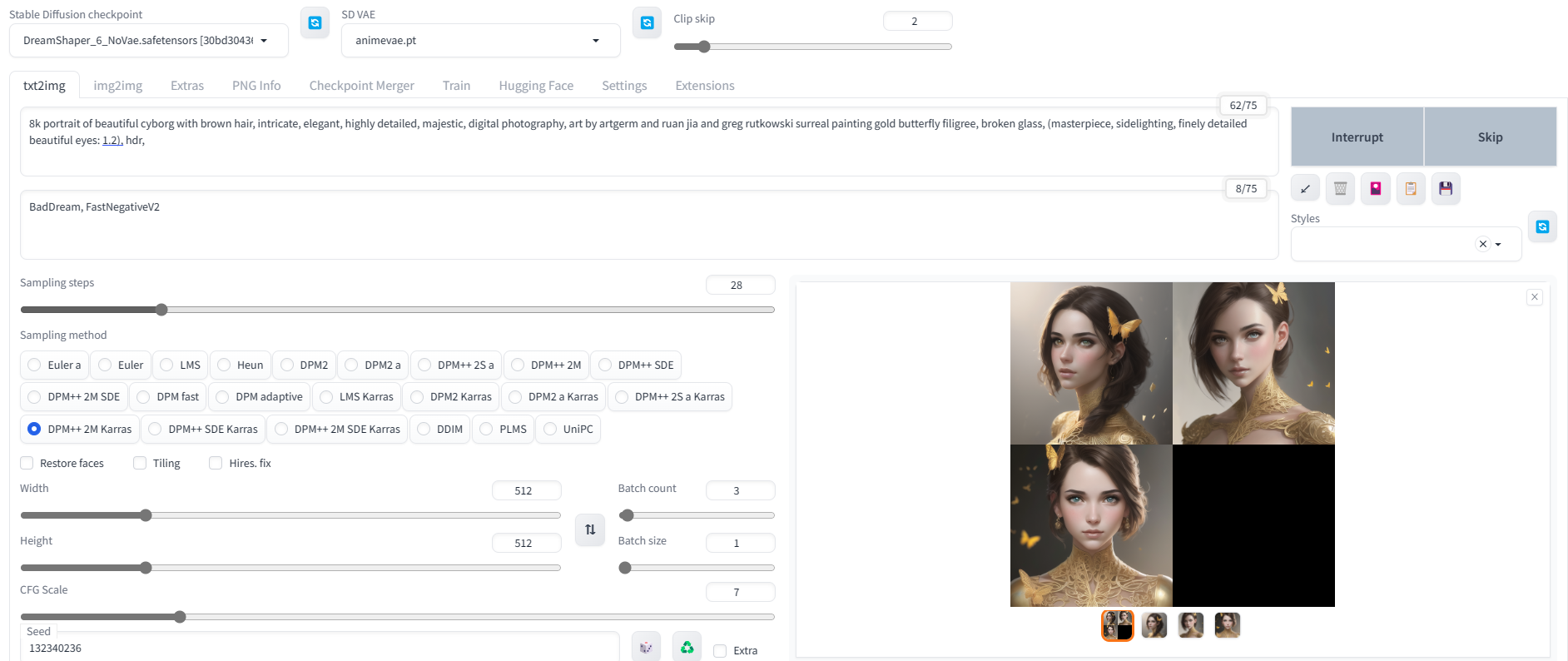

薅羊毛!阿里云免费GPU云主机畅玩AI绘画,免费领取阿里云v100显卡搭建AI绘画利器Stable Diffusion

❝ AI绘画利器Stable Diffusion,因为对电脑显卡,磁盘,内存等都有一些限制,导致大部分人望而止步,所以小编今天教大家免费领取阿里云的免费显卡服务器,免费试用3个月,以方便各位快速学习与使用。 ❞ 领取免费的GPU计算资源包 登录登录试用宝典网址,登录后点击试用宝典 领取右侧选择机器学习平台api,点击立即试用(PAI-DSW) 查看进入阿里云主页,费用-->用

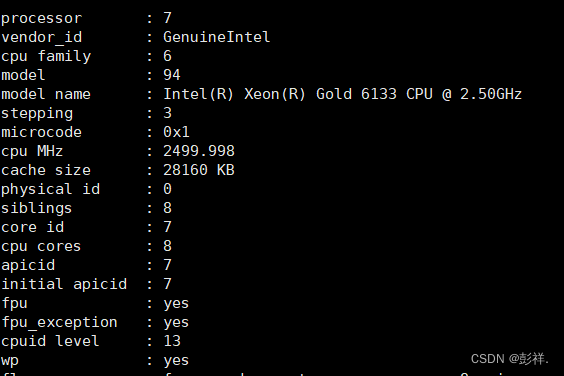

NVIDIA Tesla V100部署与使用

在先前的实验过程中,使用了腾讯云提供的nvidia T4GPU,尽管其性能较博主的笔记本有了极大提升,但总感觉仍有些美中不足,因此本次博主租赁了nvidia V100 GPU,看看它的性能表现如何。 和先前一样,只需要将服务器使用xshell连接我们就可以使用了。我们首先看下其配置情况: 可以看到,其GPU显存达到了32G,先前博主查询V100的显存仅为16G的,这可当真是意外之喜。 然后便是

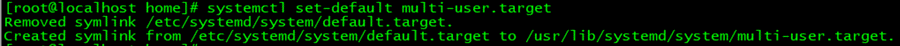

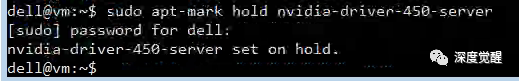

修复 V100 驱动不匹配问题

最近打比赛,登录 V100 的训练环境,突然发现没法用 cuda 了,记录一下修复过程。 显示 Failed to initialize NVML: Driver/library version mismatch 1. 查询原因 查询一下内核版本: cat /proc/driver/nvidia/version 查询硬件 lspci | grep -i nvidia 看来硬件没

Win10+Anaconda3+Cuda10.1+cuDNN+ pytorch1.8+Tesla v100搭建机器学习环境

Windows10 + Anaconda3 + Cuda10.1 + cuDNN + tesla v100 + pytorch1.8 搭建机器学习环境 安装包准备 Tesla v100 驱动Cuda 10.1cuDNN 10.1Anaconda 开始安装 1.安装Tesla显卡驱动 驱动下载地址:Official Drivers | NVIDIA 1)选择相应的型号下载 2)

阿里云GPU服务器V100租用费用_GPU卡说明

阿里云GPU服务器V100租用费用表,阿里云GPU服务器NVIDIA V100 GPU卡租用价格表,阿里云V100服务器购买可以一年、几个月或者按量付费每小时结算费用,阿里云V100服务器目前可以享受6折,阿里云百科分享阿里云V100服务器费用表: 目录 阿里云V100服务器租用 阿里云GPU服务器V100费用 阿里云V100服务器租用 阿里云V100服务器租用表如下,阿里