units专题

通用图形处理单元GPGPU计算管线(General Purpose computation on Graphics Processing Units)介绍

文章目录 GPGPU计算管线一、引言二、GPGPU计算模型2.1 数据并行性2.2 计算密集型 三、GPGPU计算管线3.1 管线(Pipeline)概述3.2 计算管线结构输入阶段执行阶段输出阶段 3.3 计算管线优化内存优化计算优化 四、代码示例五、结论 GPGPU计算管线 一、引言 通用图形处理单元(General Purpose computation on Gra

【CryptoZombies - 2 Solidity 进阶】002 Gas Time Units

目录 一、前言 二、Gas - 驱动以太坊DApps的能源 1、讲解 1.以太币 2.Gas是啥 3.Gas能干嘛? 4.如何节省Gas 2、实战 1.要求 2.代码 三、Time Units 1、讲解 2、实战1 1.要求 2.代码 3、实战2——僵尸冷却 1.要求 2.代码 一、前言 看了一些区块链的教程,论文,在网上刚刚找到了一个项目实战,Cry

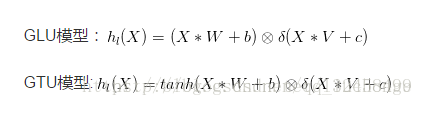

【算法】门控线性单元 GLU(Gated Linear Units)

https://blog.csdn.net/liuchonge/article/details/70238350 门控线性单元Gated linear units是在Language model with gated convolutional network中提出的。 首先我们可以通过堆叠CNN来标识长文本,提取更高层、更抽象的特征,而且相比LSTM而言,我们需要的op更少(CNN需要O(N

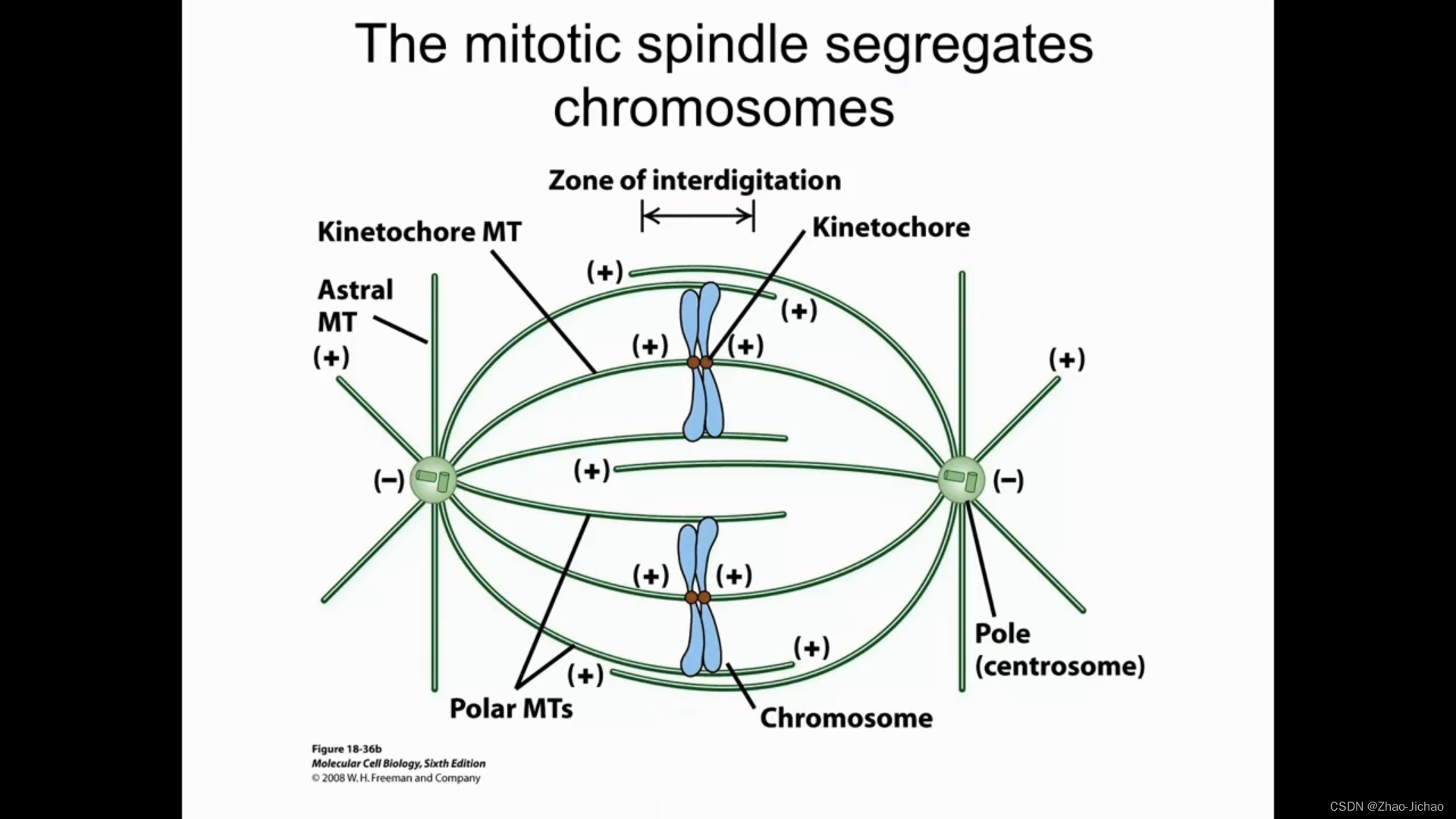

【Introductory Biology】Lecture 11 - Cells, the Simplest Functional Units 细胞,最简单的功能单元

Lecture 10 - TranslationContentsLecture 12 文章目录 SlidesRef Slides You can see often the egg cells are the biggest of all cells. The biggest cell is an ostrich egg. It’s about 15 centimet

论文分享 -- NLP -- Neural machine Translation of Rare Words with Subword Units

博客内容将首发在微信公众号"跟我一起读论文啦啦",上面会定期分享机器学习、深度学习、数据挖掘、自然语言处理等高质量论文,欢迎关注! 本次总结的是一篇16年的关于NLP中分词操作的论文,论文链接Subword,参考的实现代码subword-nmt,许多论文方法(例如BERT等)都将该方法应用到分词处理上,相对于word-level和character-level,该方法取得了不错的效果。 动机

[ THUNLP-MT(9/10) ] Neural Machine Translation of Rare Words with Subword Units | Byte Pair Encoding

Sennrich在ACL’2016发表的论文,主要研究神经机器翻译模型中的未登录词问题,提出了Byte Pair Encoding方法,同时该方法也解决了词表过大的问题。本文在介绍Sennrich的研究工作的基础上,也介绍了中文对于未登录词的相关方法。 论文传送门 引用次数:944 文章目录 论文内容》问题》目标:不需要 back-off model 来解决未登录词问题》相关工作介绍及论点

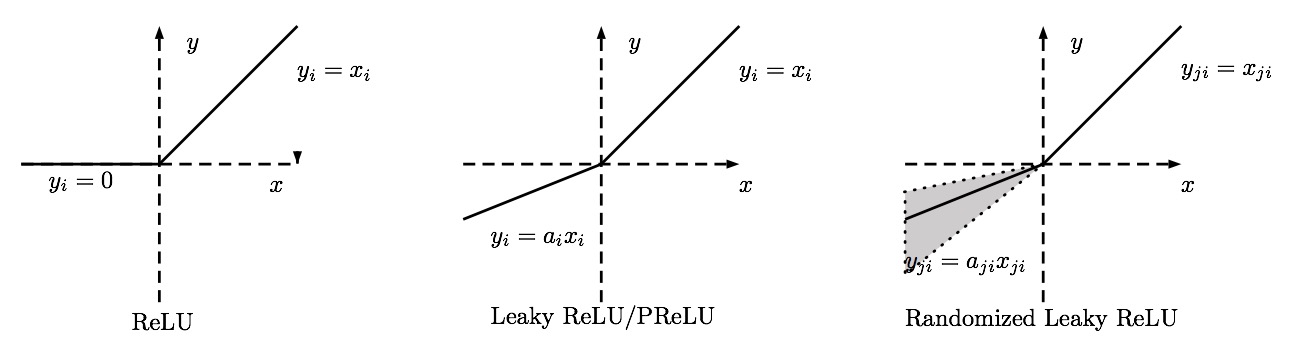

Rectified Linear Units, 线性修正单元激活函数

ReLU 在神经网络中,常用到的激活函数有sigmoid函数: f(x)=11+e−xf(x)=11+e−x 双曲正切函数: f(x)=tanh(x)f(x)=tanh(x) 而本文要介绍的是另外一种激活函数,Rectified Linear Unit Function(ReLU, 线性激活函数) ReLU函数可以表示为 f(x)=max(0,x)f(x)=max(0,x) 显然

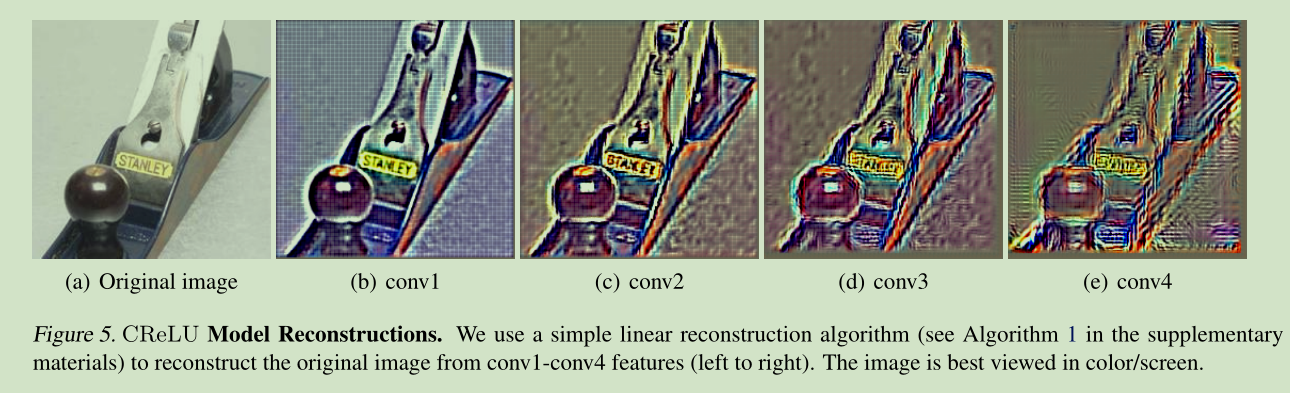

激活函数-Concatenated Rectified Linear Units

ICML2016 Understanding and Improving Convolutional Neural Networks via Concatenated Rectified Linear Units 本文在深入分析CNN网络内部结构,发现在CNN网络的前几层学习到的滤波器中存在负相关。 they appear surprisingly opposite to each oth

nn.Linear(d, num_units, bias=True)设置bias和不设置bias有什么区别?

nn.Linear(d, num_units, bias=True)是PyTorch中定义的一个全连接线性层。其中,d是输入特征的数量,num_units是输出特征的数量,而bias参数决定是否在这个线性变换中添加一个偏置项。 设置bias=True与bias=False的区别如下: 数学表示: 有偏置: y = W x + b y = Wx+b y=Wx+b无偏置: y = W x y

![[ THUNLP-MT(9/10) ] Neural Machine Translation of Rare Words with Subword Units | Byte Pair Encoding](https://img-blog.csdnimg.cn/20190515142357523.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly90enV3cGt1LmJsb2cuY3Nkbi5uZXQ=,size_16,color_FFFFFF,t_70#pic_center)