transferable专题

[CLIP] Learning Transferable Visual Models From Natural Language Supervision

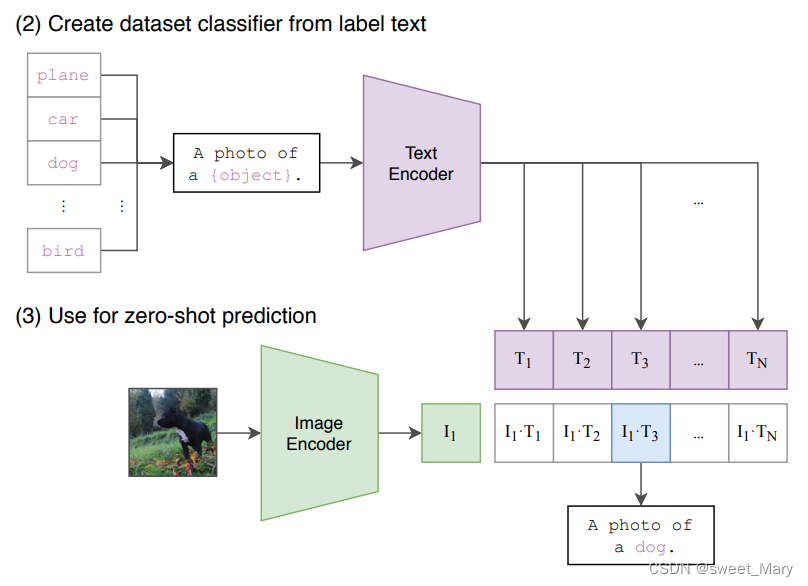

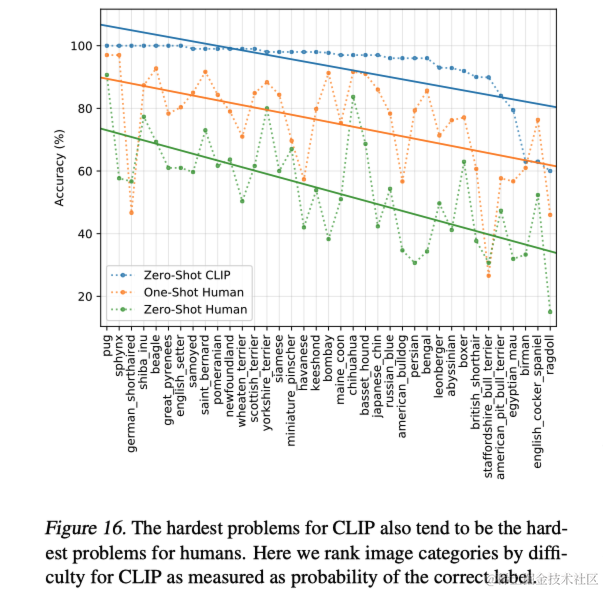

通过在4亿图像/文本对上训练文字和图片的匹配关系来预训练网络,可以学习到SOTA的图像特征。预训练模型可以用于下游任务的零样本学习 1、网络结构 1)simplified version of ConVIRT 2)linear projectio

CLIP--Learning Transferable Visual Models From Natural Language Supervision

参考:CLIP论文笔记--《Learning Transferable Visual Models From Natural Language Supervision》_visual n-grams模型-CSDN博客 openAI,2021,将图片和文字联系在一起,----->得到一个能非常好表达图片和文字的模型主题:多模态理解任务 任务:计算图片和文本的相似度 训练:有监督的对比学习 背景

CLIP论文笔记:Learning Transferable Visual Models From Natural Language Supervision

导语 会议:ICML 2021链接:https://proceedings.mlr.press/v139/radford21a/radford21a.pdf 当前的计算机视觉系统通常只能识别预先设定的对象类别,这限制了它们的广泛应用。为了突破这一局限,本文探索了一种新的学习方法,即直接从图像相关的原始文本中学习。本文开发了一种简单的预训练任务,通过预测图片与其对应标题的匹配关系,从而有效地从一

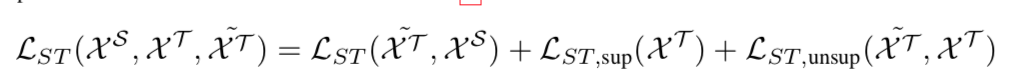

论文笔记:Label Efficient Learning of Transferable Representations across Domains and Tasks

一个使用了对抗网络和semantic transfer的迁移学习网络,用于图片分类任务。 整个网络的目标函数: 1 . 数据分为源域S的标签数据;目标域T的无标签数据;目标域T的有标签数据。 2. 蓝色的网络是基本的分类学习网络,使用S数据学习得到; 3. 绿色网络是针对域T域数据学习网络,初始化为S网络的参数; 4. 对抗网络:使用Multi-layer domain adversarial

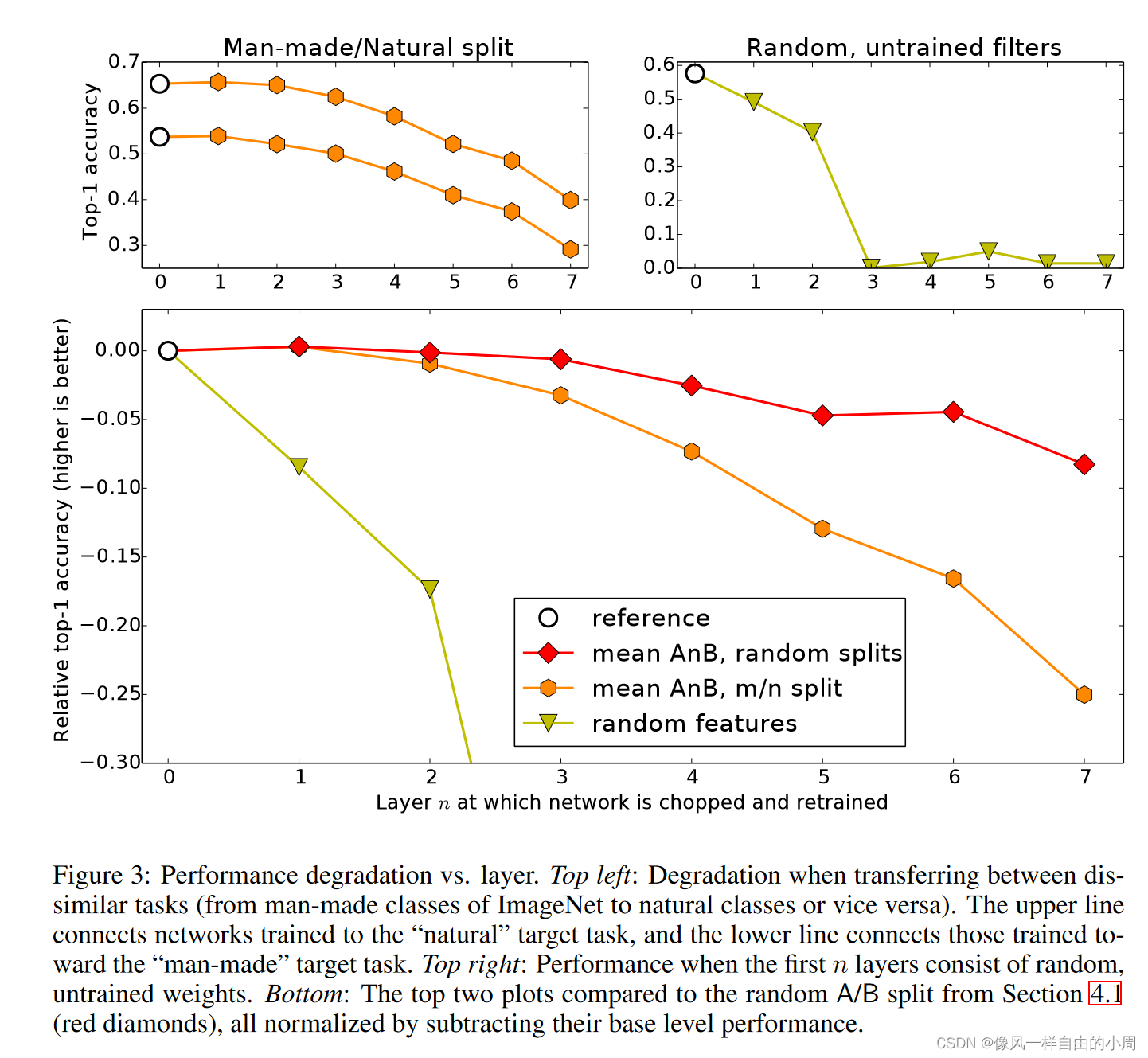

论文笔记:How transferable are features in deep neural networks?

https://blog.csdn.net/weixin_37904412/article/details/80984405 典型的神经网络:第一层通用,最后一层具体 对于神经网络中层的表示,有以下问题: 我们可以量化模型的某一层的特征到底是通用的还是具体的吗?转换是在某一层上突然发生,还是在几层上展开?这种转换发生在网络的什么地方:网络顶端,网络中间,还是网络底端? 如果网络中的特征是通用的

论文笔记:Learning Transferable Features with Deep Adaptation Networks

一个翻译: https://wenku.baidu.com/view/401fea41a55177232f60ddccda38376baf1fe00c.html https://blog.csdn.net/wei_guo_xd/article/details/74059110 这篇论文是使用mapping实现了DTL abstract 在深度网络中,特征的可迁移性在高层中随着域的差异增加而显

论文笔记:How transferable are features in deep neural networks? 2014年NIP文章

文章目录 一、背景介绍二、方法介绍三、实验论证四、结论五、感想参考文献 一、背景介绍 1.问题介绍: 许多在自然图像上训练的深度神经网络都表现出一个奇怪的共同现象:在第一层,它们学习类似于Gabor过滤器和color blobs的特征。这样的第一层特征似乎并不特定于特定的数据集或任务,而是通用的(论文中简称general),因为它们适用于许多数据集和任务。而最后一层提取到的特