tgi专题

TGI模型- 同期群-评论文本

用户偏好分析 TGI 1.1 用户偏好分析介绍 要分析的目标,在目标群体中的均值 和 全部群体里的均值进行比较, 差的越多说明 目标群体偏好越明显 TGI(Target Group Index,目标群体指数)用于反映目标群体在特定研究范围内强势或者弱势的程度 案例的需求, 高利润的产品投放市场, 找到合适的城市进行投放, 统计不同城市高客单价用户占比的TGI ,找到TGI比较大的城市,

LLM推理部署(六):TogetherAI推出世界上LLM最快推理引擎,性能超过vLLM和TGI三倍

LLM能有多快?答案在于LLM推理的最新突破。 TogetherAI声称,他们在CUDA上构建了世界上最快的LLM推理引擎,该引擎运行在NVIDIA Tensor Core GPU上。Together推理引擎可以支持100多个开源大模型,比如Llama-2,并在Llama-2–70B-Chat上每秒生成117个tokens,在Llama2–13B-Chat中每秒生成171个toke

text-generation-inference(TGI)项目加速推理的量化实现与使用GPTQ量化实现的对比

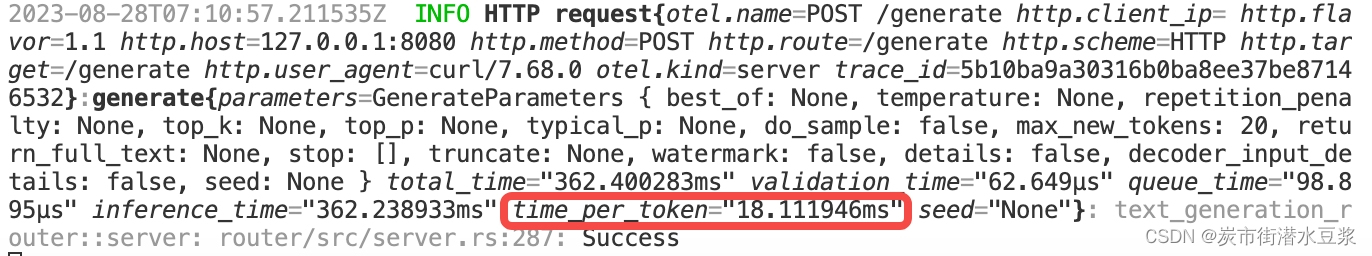

0背景 🌟实验的机器是4张T4的显卡,推理时使用参数--gpus all用4张卡同时计算; 🌟加载的模型是vicuna-7b-v1.5-16k; 🌟工程的地址在https://github.com/huggingface/text-generation-inference 🌟下面的计算速度默认是四张卡同时工作的速度; 1 不量化 docker run --gpus all --