storm专题

游戏闪退弹窗提示找不到storm.dll文件怎么办? Stormdll文件损坏修复技巧

《游戏闪退弹窗提示找不到storm.dll文件怎么办?Stormdll文件损坏修复技巧》DLL文件丢失或损坏会导致软件无法正常运行,例如我们在电脑上运行软件或游戏时会得到以下提示:storm.dll... 很多玩家在打开游戏时,突然弹出“找不到storm.dll文件”的提示框,随后游戏直接闪退,这通常是由于

storm安装、运行

环境:centos6.4 软件: jzmq-master-----java与c++通讯的桥梁,有了它,就可以使用zeromp了(提供了接口,把数据放入到zeromq中) storm-0.8.2 zeromq-2.1.7-----号称史上最牛逼的消息队列(用c++写的) zookeeper-3.4.5 1.编译安装ZMQ: tar -xzf zeromq-2.1.7.tar.gz cd ze

一、storm基础概念

1、什么是storm Storm是一个分布式的、高容错的实时计算系统。 Storm对于实时计算的的意义相当于Hadoop对于批处理的意义。Hadoop为我们提供了Map和Reduce原语,使我们对数据进行批处理变的非常的简单和优美。同样,Storm也对数据的实时计算提供了简单Spout和Bolt原语。 Storm适用的场景: (1)、流数据处理:Storm可以用来用来处理源源不断的

Storm AI : 最佳长文写作工具

作者:老余捞鱼 原创不易,转载请标明出处及原作者。 写在前面的话: 正如Storm其名,这场风暴已经在欧美学术圈开始刮起来了。想象一下,当你准备写一篇论文或者一部长篇报告时,只需要告诉Storm你的写作主题是什么,它就能自动帮你全网深挖资料和收集多维度的参考信息,创建好大纲。接下来Storm还会扮演专家与你来上几轮对话问答,并在随后的几秒钟内将你的主题转换为长

Apache Storm:入门了解

前言 Storm 是一个开源的分布式实时计算系统,它能够处理无边界的数据流,类似于 Hadoop 对于批量数据处理的作用,但是 Storm 更侧重于实时数据流的处理。以下是关于 Storm 的一些关键特性及其应用场景的详细介绍: 特性 实时处理: Storm 能够实时处理数据流,而不是像 Hadoop 那样需要先收集一批数据再进行处理。它可以持续不断地处理数据,这意味着一旦数据到达,就

Storm在Zookeeper中的目录结构

Posted by WeYo. 转载请注明出处:http://weyo.me/pages/techs/storm-with-zookeeper/ 本文主要参考自 xumingming 的博文 Twitter Storm源代码分析之ZooKeeper中的目录结构。由于新版本的 Storm 在架构上有了较大的变化,相应的目录结构也有了一些改变。本文主要针对 0.9.x 版本的 Storm

Storm中遇到的日志多次重写问题(一)

原文: http://www.cnblogs.com/zpfbuaa/p/5974000.html 业务描述: 统计从kafka spout中读取的数据条数,以及写入redis的数据的条数,写入hdfs的数据条数,写入kafaka的数据条数。并且每过5秒将数据按照json文件的形式写入日志。其中保存为json数据的格式为:时间戳 + 进程名称 + 读kafka数据条数 + 写入

Storm的Spout和Bolt中的方法

一、Spout中的方法 1.open 当一个Task被初始化的时候会调用此open方法。一般都会在此方法中对发送Tuple的对象SpoutOutputCollector和配置对象TopologyContext初始化。 2.declareOutputFields 此方法用于声明当前Spout的Tuple发送流。Stream流的定义是通过OutputFieldsDecl

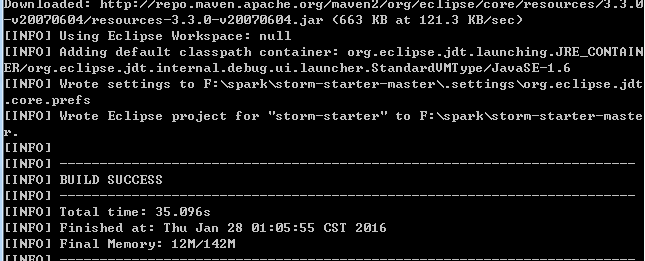

Apache Storm 简单实践

Apache Storm 简单实践 前两篇文章介绍了Apache Storm的一些基础知识以及核心架构。 Apache Storm 集群安装配置\Apache Strom 实时计算系统 本篇文章介绍一些Storm的简单实践场景。 创建一个Storm项目 实践场景为,基于Storm开发出一个实时统计句子中的单词个数的拓扑,实时数据我们通过随机发射句子,在实际应用场景中,实时数据可能来自MQ

Apache Storm 集群安装配置

Apache Storm 集群安装配置 在上一篇文章:Apache Storm 实时计算系统中对Storm进行了简要的介绍,本篇文章主要介绍Storm的集群部署。 安装环境 要安装部署Storm,有以下几个步骤: 安装 Java 1.7+安装 Zookeeper 集群 安装 Apache Storm 由于本人机器环境已经安装了Java和Zookeeper,所以对这两方面不做介绍。 集群

用C/C++实现对STORM的运行信息查看和控制

最近公司有个需求,需要在后端应用服务器上实时获取STORM集群的运行信息和topology相关的提交和控制,经过几天对STORM UI和CMD源码的分析,得出可以通过其thrift接口调用实现这些功能。先下载一个thrift库进行编码和安装。关于thrift可以参见这个地方。安装完成后,从STORM源码中将storm.thrift拷贝到thrift目录下。输入: hrift -gen cpp s

实时流Streaming大数据:Storm,Spark和Samza

当前有许多分布式计算系统能够实时处理大数据,这篇文章是对Apache的三个框架进行比较,试图提供一个快速的高屋建瓴地异同性总结。 Apache Storm 在Storm中,你设计的实时计算图称为toplogy,将其以集群方式运行,其主节点会在工作节点之间分发代码并执行,在一个topology中,数据是在spout之间传递,它发射数据流作为不可变的key-value匹配集合,这种key-v

看这里!Storm【单机版】环境搭建

Storm单机版本环境搭建 1. 安装环境要求 you need to install Storm’s dependencies on Nimbus and the worker machines. These are: Java 7+ (Apache Storm 1.x is tested through travis ci against both java 7 and java 8 J

一篇搞定 storm 【集群版】环境搭建,建议收藏

Storm集群环境搭建 一、集群规划 二、前置条件 三、集群搭建 下载并解压配置环境变量集群配置安装包分发 四. 启动集群 启动ZooKeeper集群启动Storm集群查看集群 五、高可用验证 一、集群规划 这里搭建一个 3 节点的 Storm 集群:三台主机上均部署 Supervisor 和 LogViewer 服务。同时为了保证高可用,除了在 hadoop001 上部署主 N

14.6 Storm事物

Storm 事务 只有用事务的概念才能完成Exactly-once 要保证事务,就要强有序! 事务如果对应这批数据如果出错了,必须要重新计算正确才能去下面的事务 ,所以就得保证事务ID所对应的数据得是一样的!就得保证再次取得时候还能从数据源取到数据! Storm是单条处理,那这样的话 Design 1 为了去做到事务的代价: 每条Tuple对应一个Txid事务ID,为了去确

14.2 Storm部署搭建

单机版: 1,上传apache-storm-0.9.5.tar.gz (前提需要有java环境) 2,解压 tar -zxvf apache-storm-0.9.5.tar.gz 3,cd apache-storm-0.9.5 进入解压目录 4,mkdir logs 在目录当中创建一个logs文件夹 5,./bin/storm dev-zookeeper >> ./logs/zk.out

14.1 Storm简介

http://storm.apache.org/releases/0.9.6/Guaranteeing-message-processing.html Storm是非常优秀的开源的分布式实时流式计算系统,满足了很多实时流式计算的需求 纯的实时流式计算框架,一条一条来处理,所有延时可以做到很低,ms毫秒级别 Storm架构: Nimbus 分配task任务,分配资源,主节点 zookeep

storm-0.8.2集群模式安装部署

标签(空格分隔): storm hadoop,spark,kafka交流群:224209501 集群: 一台主机用来运行nimbus,另外两台运行superior。 安装及测试: 1,安装ZeroMQ 2,安装jzmq 3,安装Python 4,安装storm 5,配置storm 6,启动storm 7,测试storm 1,安装依赖 sudo yum install

storm消费kafka数据

http://blog.csdn.net/tonylee0329/article/details/43016385 使用storm-kafka模块读取kafka中的数据,按照以下两步进行构建(我使用的版本是0.9.3) 1. 使用BrokerHosts接口来配置kafka broker host与partition的mapping信息; 2. 使用KafkaConfig来配置一些与kafka

大数据晋级之路(7)Storm安装及使用

一、Apache Storm简介 Apache Storm简介 Storm是一个分布式的,可靠的,容错的数据流处理系统。Storm集群的输入流由一个被称作spout的组件管理,spout把数据传递给bolt, bolt要么把数据保存到某种存储器,要么把数据传递给其它的bolt。一个Storm集群就是在一连串的bolt之间转换spout传过来的数据。 Storm组件 在Storm集群中

大数据晋级之路(5)Hadoop,Spark,Storm综合比较

大数据框架:Spark vs Hadoop vs Storm 目录 HadoopSparkStorm 大数据时代,TB级甚至PB级数据已经超过单机尺度的数据处理,分布式处理系统应运而生。 知识预热 「专治不明觉厉」之“大数据”;大数据生态圈及其技术栈; 关于大数据的四大特征(4V) 海量的数据规模(Volume):Quantifiable(可量化)高速的数据流转和动态的数据

构建数据中台常用三把武器区别在哪?(Hadoop、Spark、Storm)

通过收集互联网相关资料,进行总结归纳,整理如下:一. Storm的适用场景: 1)流数据处理 Storm可以用来处理源源不断流进来的消息,处理之后将结果写入到某个存储中去。 2)分布式RPC。由于Storm的处理组件是分布式的,而且处理延迟极低,所以可以作为一个通用的分布式RPC框架来使用。 3)Storm优势就在于Storm是实时的连续性的分布式的计算框架,一旦运行起来,除非你将它杀掉,否则