spacy专题

spacy 模型下载失败解决方法

改host ip 也没用 就是不让你访问 用conda 吧 别自己瞎折腾 毫无意义 conda install -c conda-forge spacy-model-en_core_web_sm 这是地址 https://github.com/explosion/spacy-models

构建一个简单的情感分析器:使用Python和spaCy

构建一个简单的情感分析器:使用Python和spaCy 引言 情感分析是自然语言处理(NLP)中的一项重要技术,它可以帮助企业和研究人员理解公众对特定主题或产品的看法。 在本篇文章中,我们将使用Python编程语言和 spaCy 库来构建一个简单的情感分析器。 环境准备在开始之前,请确保你已经安装了Python和 spaCy 库。 此外,我们还将使用 pandas 库来处理数据,以及 scikit

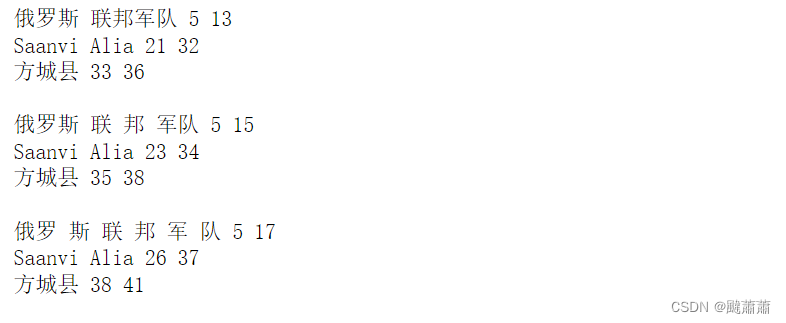

spacy NER 位置信息不考虑空格!!!

texts = ["疫情期间,俄罗斯 联邦军队医疗机构的负责人Saanvi Alia在方城县启动了远程医疗服务。","疫情期间,俄罗斯 联 邦 军队医疗机构的负责人Saanvi Alia在方城县启动了远程医疗服务。","疫情期间,俄罗 斯 联 邦 军 队医疗 机构的负责人Saanvi Alia在方城县启动了远程医疗服务。",]for text in texts:doc = nlp(text)fo

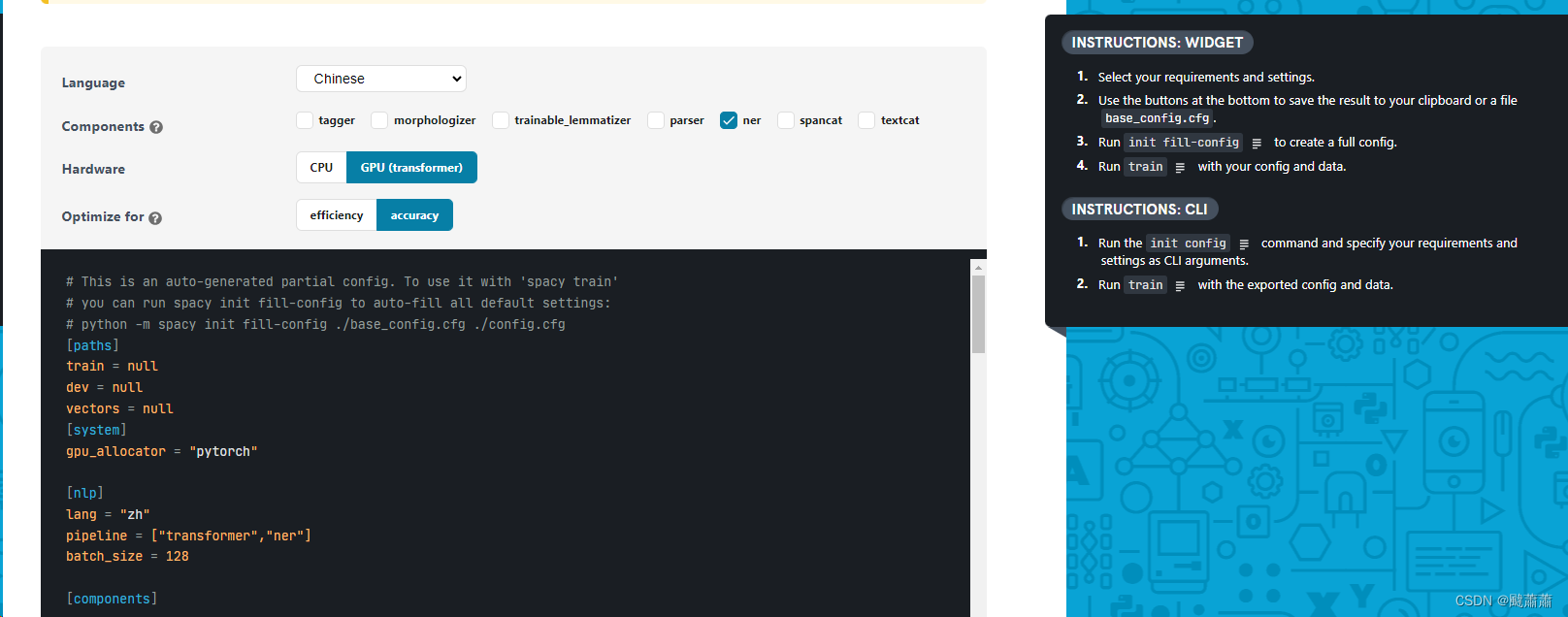

spacy微调BERT-NER模型

数据准备 加载数据集 from tqdm.notebook import tqdmimport osdataset = []with open(train_file, 'r') as file:for line in tqdm(file.readlines()):data = json.loads(line.strip())dataset.append(data) 你可以按照 CLUE

spacy POS 和 Syntactic Dependency Parsing 的标记

https://spacy.io/api/annotation#dependency-parsing

下载spacy——工业级别的自然语言处理工具包

前后下载了两遍,太艰难了。具体安装流程如下,其实很简单, 就是有一些需要注意的点。 环境:win10 安装window系统对应的工具,如下图所示 翻墙,亲测不翻墙没法下载语言包。使用管理员身份打开命令提示符conda install -c conda-forge spacy 我是用的是anaconda里面创建的python3.6环境。(这一步也可以不翻墙)python -m spacy do

使用Python进行自然语言处理(NLP):NLTK与Spacy的比较【第133篇—NLTK与Spacy】

👽发现宝藏 前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。【点击进入巨牛的人工智能学习网站】。 使用Python进行自然语言处理(NLP):NLTK与Spacy的比较 自然语言处理(NLP)是人工智能领域的一个重要分支,它涉及到计算机如何理解、解释和生成人类语言。在Python中,有许多库可以用于NLP任务,其中NLTK(Natural Langu

spacy进行简单的自然语言处理的学习

自然语言处理基本概念 概念:自然语言处理,是让机器理解人的语言的过程。 作用:通过使用自然语言处理,机器可以理解人的语言,从而进行语义分析,例如:从一句话中判断喜怒哀乐;从一段文字中判断是否存在存在诈骗…等等 语义分析和单纯的关键词简单检索有什么区别: 比如:对于a.你吃饭了吗? b.你?饭?吃?了?吗,语义分析可以明白这两句话意思大致相同,但是关键词检索大概率无法识别。 原理:基于多层神经网络

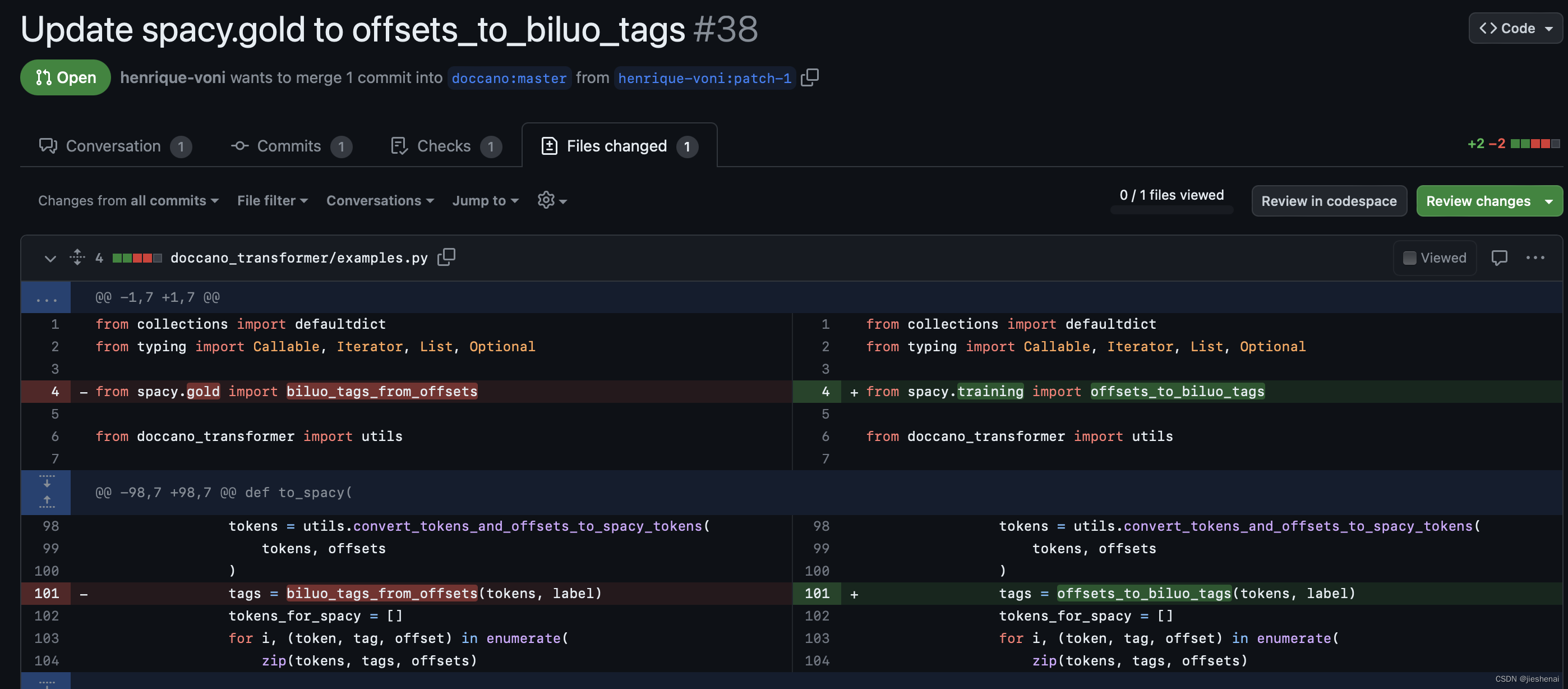

Doccano 修复 spacy.gold 的bug

引言 最初只是想把Doccano标注的数据集转换成BIO(类似conll2003数据集)的标注格式; 按照PR的修改意见实现了修改,但是本人不建议这么做; 应该随着Doccano的升级,Doccano的导出格式发生了变化,而原来的doccano-transformer还停留在2022年 摘要 可先阅读一下教程:【已解决】关于如何将Doccano标注的文本转换成NER模型可以直接处理的

spacy和neuralcoref的安装步骤

安装包兼容版本: spacy 2.1.0 + neuralcoref 4.0 + en_core_web_sm-2.1.0 一:安装 1.spacy2.1.0安装方式: 利用命令行输入:pip install spacy==2.1.0(默认pip工具已安装) 2.neuralcoref4.0安装步骤: 下载地址:https://github.com/huggingface/neura

使用Spacy做中文词频和词性分析

使用Spacy python库做中文词性和词频分析,读取word并给出其中每个词的词频和词性,写入excel表。 1、为什么选择Spacy库 相比与NLTK这个库更快和更准 2、模型比较 zh_core_web_trf模型,模型大,准确性高。 需要确保你的Spacy版本是最新的,因为zh_core_web_trf是一个基于transformer的模型,因为它包含了整个transformer模型。

手动下载spacy的en_core_web_sm模型

手动下载 首先,用下面连接下载模型。我下载了 .tar.gz 格式。 然后提取它并通过指定所需子文件夹的路径将其加载到代码中。为了确保路径正确,您应该进入包含 config.cfg 文件的文件夹。 https://github.com/explosion/spacy-models/releases 例子代码 import spacynlp = spacy.load("your/base

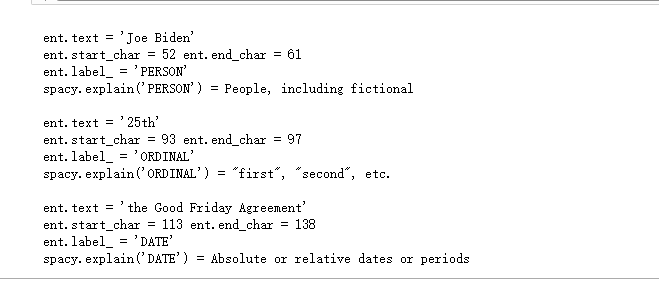

【自然语言处理-工具篇】spaCy<2>--模型的使用

前言 之前已经介绍了spaCy的安装,接下来我们要通过下载和加载模型去开始使用spaCy。 下载模型 经过训练的 spaCy 管道可以作为 Python 包安装。这意味着它们是应用程序的一个组件,就像任何其他模块一样。可以使用 spaCy download的命令安装模型,也可以通过将 pip 指向路径或 URL 来手动安装模型。 文档可用管道 详细的管道

【自然语言处理-工具篇】spaCy<1>--介绍及安装指南

目录 前言 安装指南 pip conda spaCy升级 总结 前言 spaCy是一个开源的自然语言处理库,用于处理和分析文本数据。它提供了许多功能,包括分词、词性标注

【自然语言处理】P3 spaCy 与 NLTK(分词、词形还原与词干提取)以及 Porter 和 Snowball

目录 准备工作spaCyNLTK 文本分词spaCyNLTK 词形还原spaCyNLTK 词干提取PorterSnowball stemmers 在自然语言处理(NLP)中,文本分词是将文本拆分为单词或词组的过程,这是理解文本含义和结构的基础。Python中两个流行库——spaCy和NLTK(Natural Language Toolkit),都提供了分词功能。下面将详细介绍如何

spacy分词工具下载指南

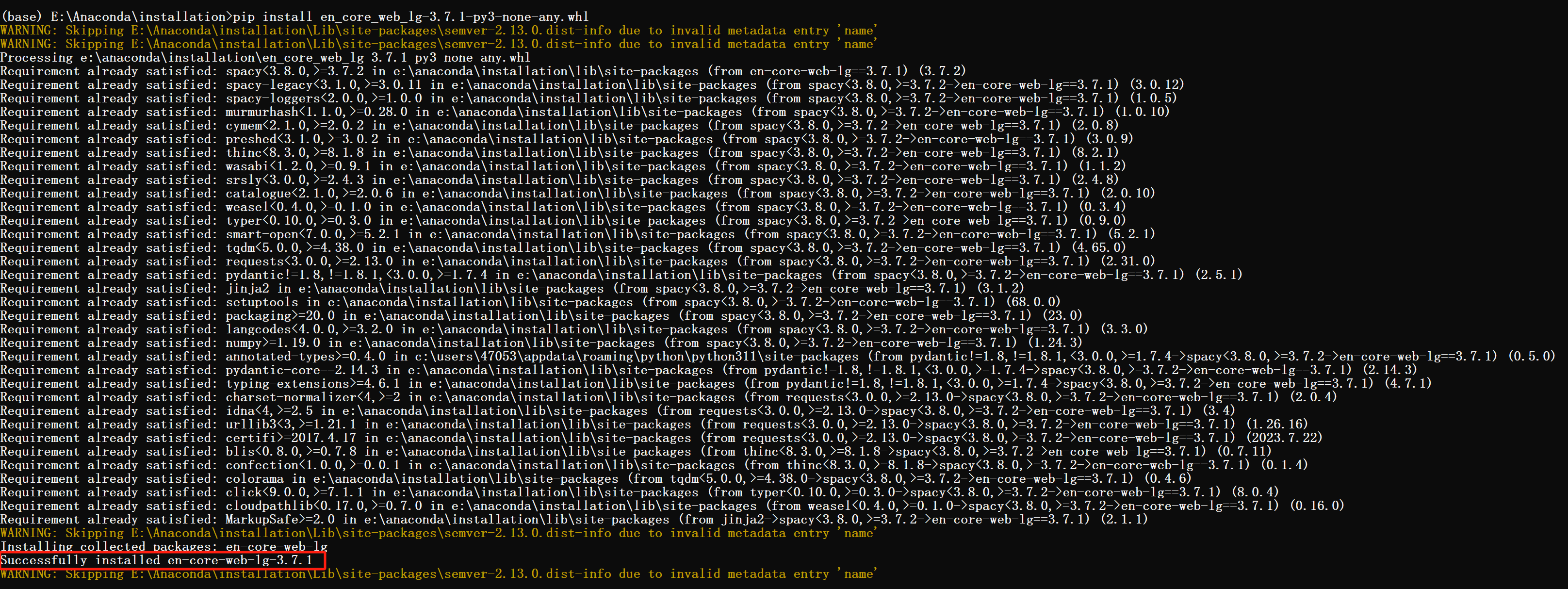

分享一下spacy分词工具的下载流程,直接在命令行下载速度慢而且一般都成功不了,所以需要像nltk工具一样离线下载,这里记录一下流程。让有需要的同学少走一些坑。 一、下载spacy 这里下载记得使用国内源哟,速度会快很多,详细信息参考点击【国内源】查看。 下面以使用清华源为例 pip install spacy -i https://pypi.tuna.tsinghua.edu.c

spacy.load(‘en‘) or spacy.load(‘de‘)出现的OpenSSL SSl SysCallError(10054)解决方案

大家好,我是爱编程的喵喵。双985硕士毕业,现担任全栈工程师一职,热衷于将数据思维应用到工作与生活中。从事机器学习以及相关的前后端开发工作。曾在阿里云、科大讯飞、CCF等比赛获得多次Top名次。现为CSDN博客专家、人工智能领域优质创作者。喜欢通过博客创作的方式对所学的知识进行总结与归纳,不仅形成深入且独到的理解,而且能够帮助新手快速入门。 本文主要介绍了spacy.load(‘en‘)

spaCy:No module named ‘en’ || Can‘t find model ‘en’

前言 了解到 ChatterBot 后,打算上手试试,安装好库包、敲好入门代码,一运行报错:1️⃣ ModuleNotFoundError: No module named 'en' ,亦或是 2️⃣ OSError: [E050] Can't find model 'en'. It doesn't seem to be a shortcut link, a Python package

spacy en_core_web_md下载安装及使用

spacy安装:pip install -U spacy #en库安装python -m spacy download en#en_core_web_md库安装python -m spacy download en_core_web_md# 链接安装pip install /Users/you/en_core_web_md-1.2.0.tar.gzpip install https://

P with Spacy:自定义文本分类管道

一、说明 Spacy 是一个功能强大的 NLP 库,其中许多 NLP 任务(如标记化、词干提取、词性标记和命名实体解析)均通过预训练模型提供开箱即用的功能。所有这些任务都由管道对象以及逐步应用于给定文本的不同函数的内部抽象来包装。该管道可以通过自编写的函数进行定制和扩展。 在本文中,您将了解如何将文本分类添加到 Spacy 管道。给定带有文档和

机器学习笔记 - 深入研究spaCy库及其使用技巧

一、简述 spaCy 是一个用于 Python 中高级自然语言处理的开源库。它专为生产用途而设计,这意味着它不仅功能强大,而且快速高效。spaCy 在学术界和工业界广泛用于各种 NLP 任务,例如标记化、词性标注、命名实体识别等。 安装,这里使用阿里的源。 pip install spacy -i https://mirrors.aliyun.com/py