rocm专题

使用ROCm和AMD GPU进行机器学习基准测试:复现我们的MLPerf推理提交

Benchmarking Machine Learning using ROCm and AMD GPUs: Reproducing Our MLPerf Inference Submission — ROCm Blogs 简介 衡量新技术的性能是自古以来的一种实验,常常引人入胜(例如,我们仍然用马力来比较新电动汽车电机的性能)。在迅速发展的机器学习(ML)领域,MLPerf在2018年5月2

加速 PyTorch 模型:使用 ROCm 在 AMD GPU 上应用 torch.compile

Accelerate PyTorch Models using torch.compile on AMD GPUs with ROCm — ROCm Blogs 介绍 PyTorch 2.0 引入了一个名为*torch.compile()*的工具,可以极大地加速 PyTorch 代码和模型。通过将 PyTorch 代码转换为高度优化的内核,`torch.compile` 在现有代码库上进行

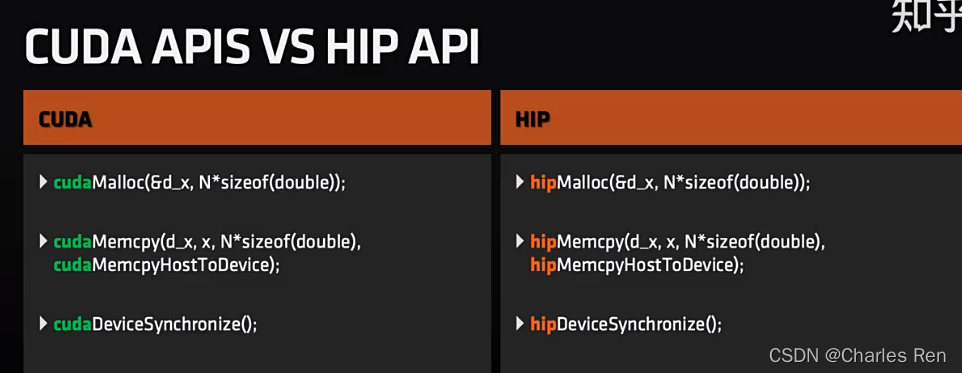

Rocm-HIP kernel language

HIP的内核启动语法hipLaunchKernelGGL是一个宏,可以作为启动内核的替代方式,它接受启动配置的参数(网格维度、分组维度、流、动态共享大小)以及任意数量的内核参数。这个宏可以替代CUDA中的三连字符(<<< >>>)启动语法。 HIP-Clang作为ROCm平台的一部分,是用于编译HIP程序的新编译器,它使用与GCC兼容的API,允许由不同GCC兼容编译器生成的代码相互链接。 一

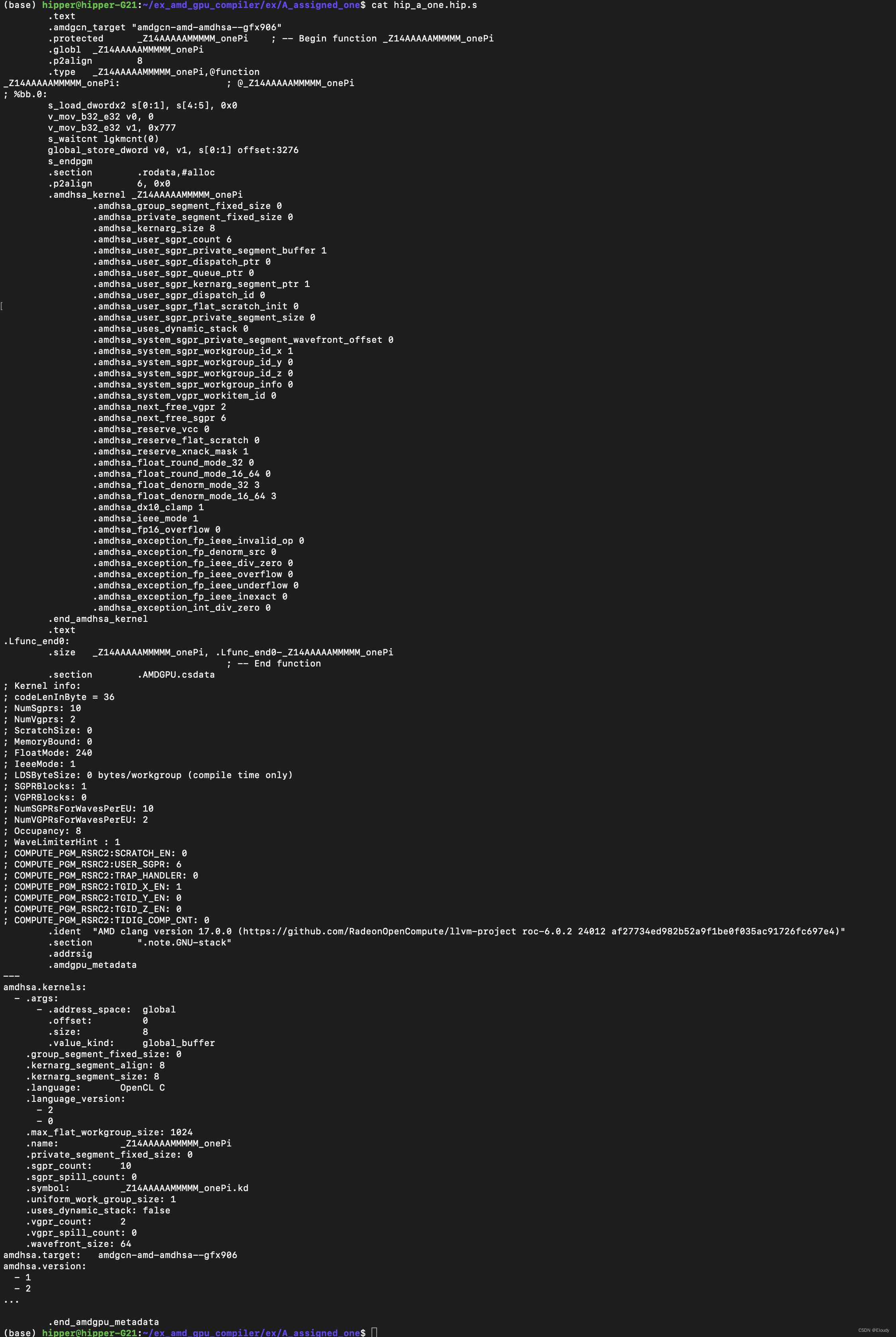

将 cuda kernel 编译成 ptx 和 rocm的hip asm

1,cuda 源码编译 cuda_a_one.cu __global__ void NNNNNVVVVV_one(int *A){A[333] = 777;} 编译命令: %.ptx: %.cu nvcc -arch=sm_70 -ptx $< -o $@ 生成的结果: 2, hip 源码编译 hip_a_one.hip__global__ void AAAA

ROCm上来自Transformers的双向编码器表示(BERT)

14.8. 来自Transformers的双向编码器表示(BERT) — 动手学深度学习 2.0.0 documentation (d2l.ai) 代码 import torchfrom torch import nnfrom d2l import torch as d2l#@savedef get_tokens_and_segments(tokens_a, tokens_b=None)

ROCm上情感分析:使用循环神经网络

15.2. 情感分析:使用循环神经网络 — 动手学深度学习 2.0.0 documentation (d2l.ai) 代码 import torchfrom torch import nnfrom d2l import torch as d2lbatch_size = 64train_iter, test_iter, vocab = d2l.load_data_imdb(batch_

AMD ROCm软件栈组件介绍

AMD ROCm™ Platform 1.1 ROCm简介 参考:https://github.com/RadeonOpenCompute/ROCm ROCm(Radeon Open Compute)开源软件栈。 在NVIDIA GPU上,术语“CUDA”通常是指GPU编程编译器、API和运行时库,但ROCm不那么单一,通常根据其组件进行描述。 图1显示了ROCm中涉及的主要组件堆栈。